OpenAI ICLR 2018论文汇总:主要兴趣为强化学习

OpenAI在ICLR 2018上共提交了7篇论文,其中,1篇被评为最佳论文,2篇将作口头报告。另外,值得注意的是,7篇论文有4篇都属于强化学习领域。

Variance Reduction for Policy Gradient with Action-Dependent Factorized Baselines

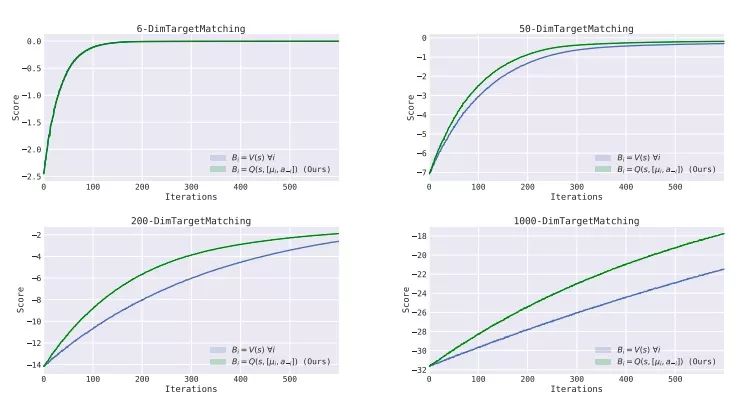

策略梯度方法在深度强化学习领域取得了巨大成功,但饱受梯度估计高方差之苦,特别是在高维大型的行动空间上。这篇论文提出了一种无偏置的、依赖于行动的基线以降低方差。

不同维度下行动依赖基线(绿线)的表现

本文将在ICLR 2018作口头报告。

5月3日 10-10:15am;Exhibition Hall A

arXiv:1803.07246

Continuous Adaptation via Meta-Learning in Nonstationary and Competitive Environments

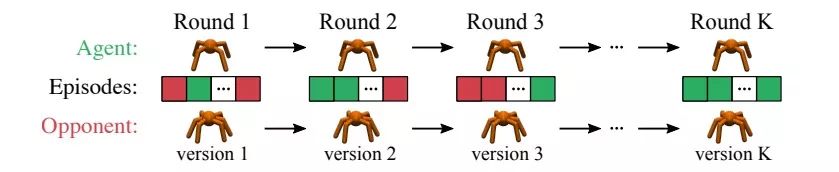

本文将持续适应(continuous adaptation)问题纳入learning-to-learn框架,提出了一种简单的基于梯度的元学习算法,该算法适用于动态变化的对抗性情境。另外还设计了一个新的多智能体竞争环境RoboSumo。

RoboSumo

本文将在ICLR 2018作口头报告,同时也被选为最佳论文。

5月3日 10:15-10:30am;Exhibition Hall A

arXiv:1710.03641

Learning Sparse Neural Networks through L0 Regularization

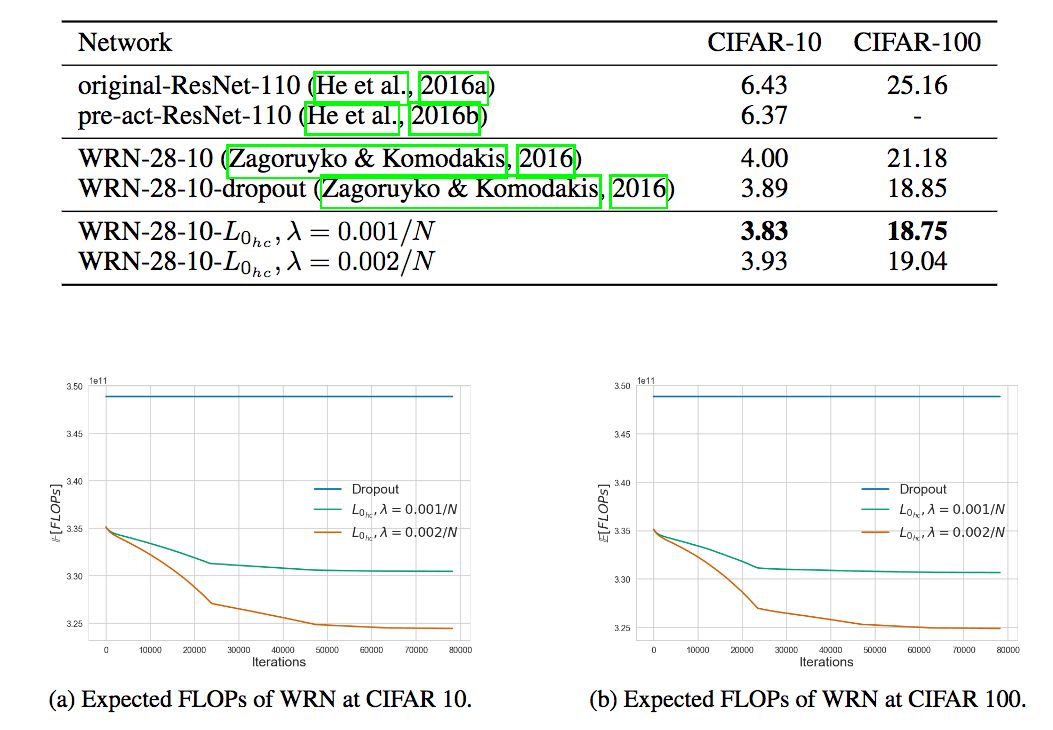

我们都很熟悉L1和L2正则化,而本文提出了一种L0正则化方法:通过鼓励权重变为零,在训练阶段剪枝网络。

在CIFAR-10和CIFAR-100上的表现

5月2日 11am-1pm;East Meeting level: 1,2,3 #32

arXiv:1712.01312

Emergent Complexity via Multi-Agent Competition

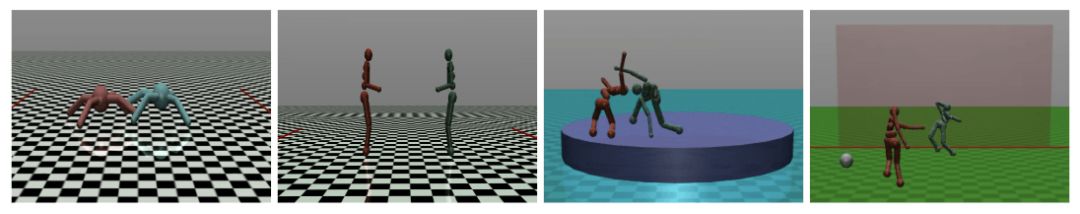

传统上,强化学习问题的复杂度取决于环境的复杂度。本文展示了,即使在一个简单的环境下,通过智能体之间的竞争,也能学习到多样、复杂、有趣的技能(基于模拟物理的3D环境)。

5月3日 11am-1pm;East Meeting level: 1,2,3 #19

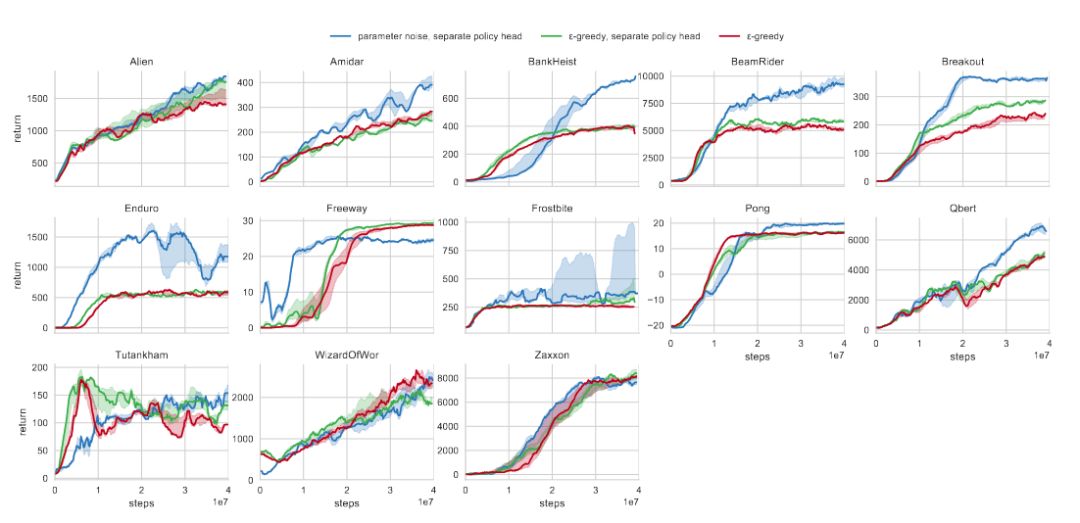

Parameter Space Noise for Exploration

深度强化学习方法常常在行动空间中加入噪声,以鼓励探索行为。本文尝试直接在智能体的参数中加入噪声。

蓝线为参数加噪的学习曲线,可以看到,总体而言表现更好

5月3日 11am-1pm;East Meeting level: 1,2,3 #7

arXiv:1706.01905

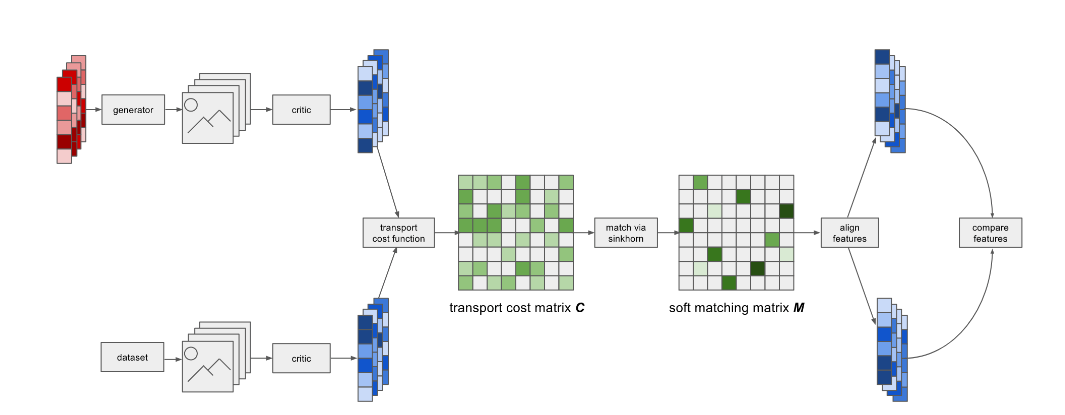

Improving GANs Using Optimal Transport

本文提出了一个新的GAN变体,OT-GAN,基于最优传输距离测量生成数据分布与真实数据分布间的距离。

5月3日 4:30-6:30pm;East Meeting level: 1,2,3 #16

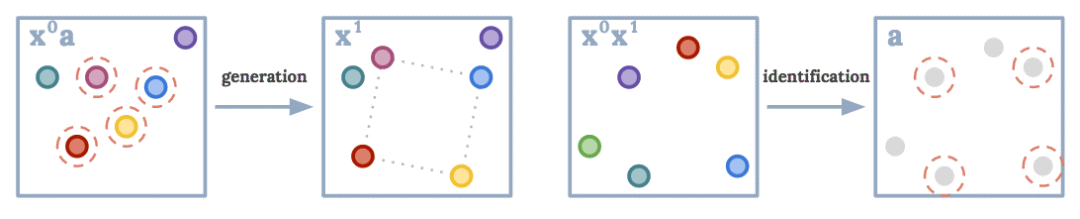

Concept Learning with Energy-Based Models

基于能量的模型可以快速推断二维数据点的概念。

学习“正方形”这个概念

workshop;5月2日 11am-1pm;East Meeting Level 8 + 15 #3

OpenReview地址:https://openreview.net/pdf?id=H12Y1dJDG