数据分析师应该知道的16种回归技术:介绍篇

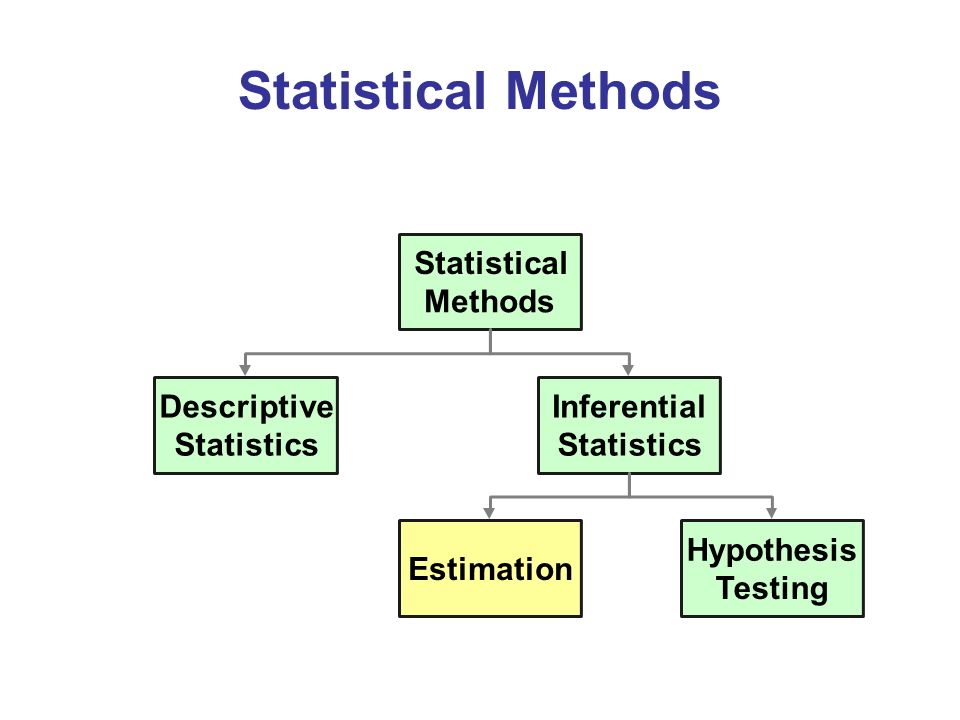

回归分析是我们进行数据挖掘和模型预测时最常用的统计方法之一。目前已经有十几种回归方法用来分析不同类型的数据,每一种回归方法都有它自己的特征。然而大多数人仅仅了解2-3种常见的回归方法,如:线性和逻辑回归。对于某些数据,如果我们依然使用常见的几种回归方法,就会导致错误的统计决策。因此,每一位数据分析师都应该熟知每类回归方法以及它们适应的数据类型。

什么是回归分析

首先让我们看一个简单的例子:假如公司经理要求你预测公司来年的销售额,这里有数百个影响销量的因子。在这个例子中,销量就是的你的因变量,所有影响销量的因子都是你的自变量。回归分析将会帮助你解决这个问题。

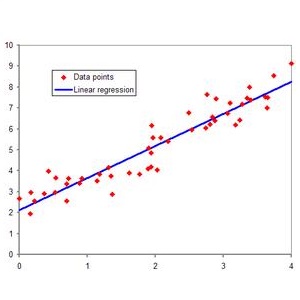

简单地说,回归分析就是用来模拟一个因变量和一个或多个自变量之间的关系。

对于前面的例子,通过回归分析,我们可以回答下列问题:

哪些因子对销量有显著的影响

因子是如何影响销量的

公司来年销售额是多少

回归分析常用术语

异常点(outliers):指数据集中那些远高或远低于总体平均水平的点,我们也称这些点为极端值

多重共线性(Multicollinearity):指自变量之间有较高的相关性。

异方差性(Heteroscedasticity):指总体回归函数中的随机误差项不满足同方差性。

过拟合(Overfitting)和欠拟合(Underfitting):使用不必要的解释变量可能会导致过拟合,过拟合意味着算法可以很好拟合训练集但不能较好地反映测试集的特征,这也称为高方差问题;当模型不能有效拟合训练集时,就认为模型欠拟合,这也称为高偏差问题。

16种回归方法

目前已经收集的16种回归方法

线性回归

多项式回归

逻辑回归

KNN回归

分位数回归

岭回归

Lasso回归

弹性网络回归

主成份回归

局部最小二乘回归

支持向量回归

有序回归

泊松回归

负二项回归

准泊松回归

Cox回归

后续课程会对上面的15种回归方法进行一一讲解,欢迎大家关注学习。

长按二维码关注“数萃大数据”