测试阶段模型自适应方法总结

©PaperWeekly 原创 · 作者 | 张一帆

研究方向 | 计算机视觉

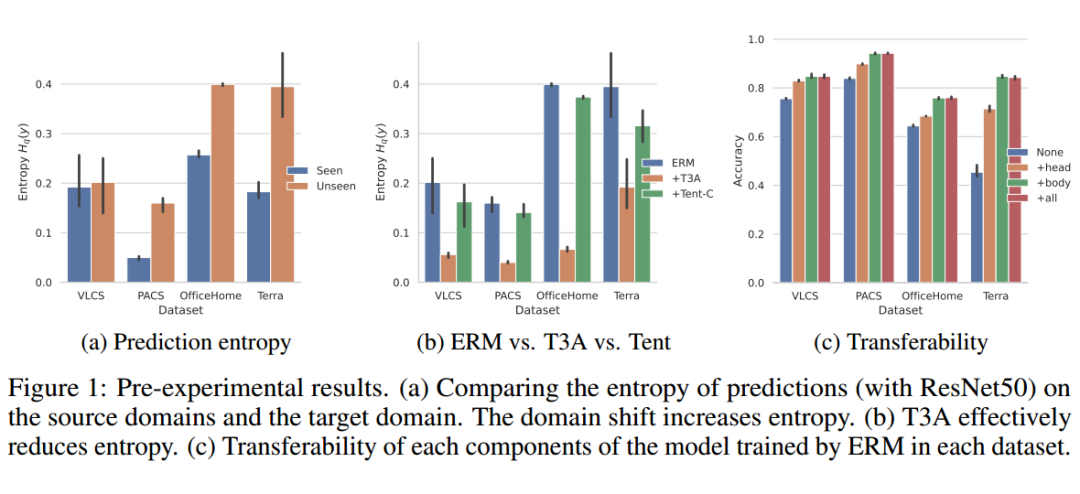

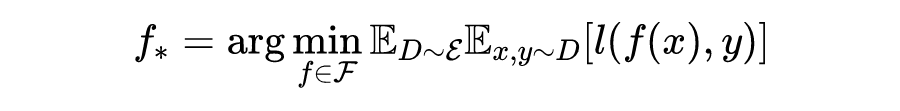

Domain Generalization(DG:域泛化)一直以来都是各大顶会的热门研究方向。DA 假设我们有多个个带标签的训练集(源域),这时候我们想让模型在另一个数据集上同样表现很好(目标域),但是在训练过程中根本不知道目标域是什么,这个时候如何提升模型泛化性呢?核心在于如何利用多个源域带来的丰富信息。

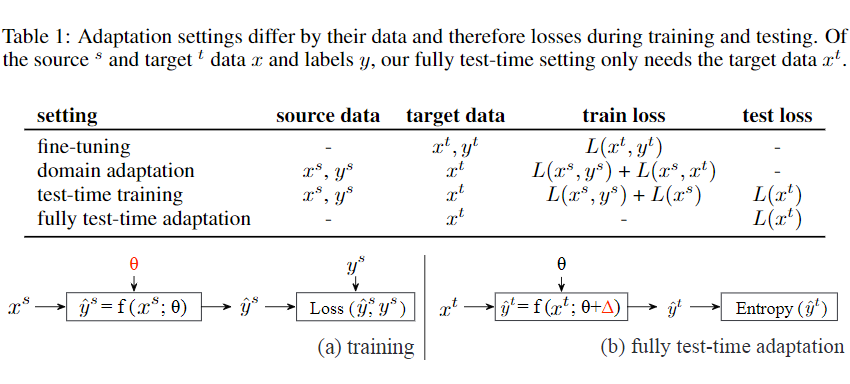

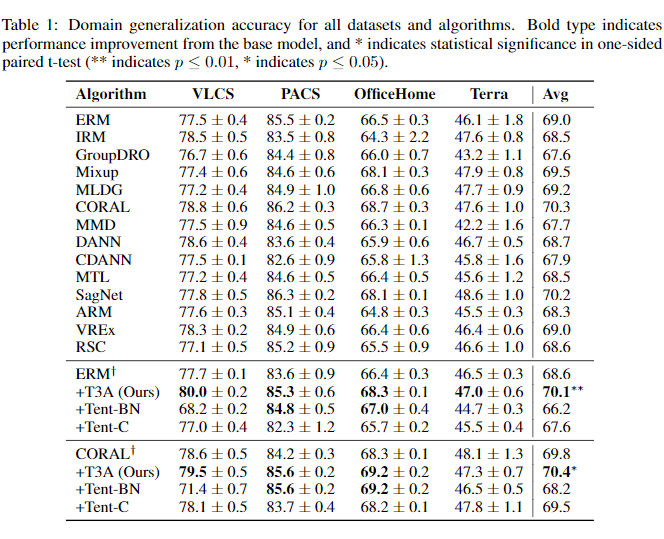

DG 最困难的地方在于 test-sample 的不可知,训练时不可用,近期有一系列方法开始尝试假设 test sample 以 online 的形式出现,然后利用其信息增强泛化性,下表总结了 test time daptation 方法与传统 DA,DG 方法的区别。

传统 DG 方法就是在源域 finetune 预训练模型,然后部署时不经过任何调整。DA 方法可以根据无标签的目标域数据在训练时调整模型,test-time training 方法在测试时会有一些无监督损失比如检测旋转角度等,然后对每个 test sample 也会进行旋转角度的检测,本文所述的 fully test-time adaptation 在 training 的时候不需要无监督损失,而只需要在 test 的时候进行 adaptation。

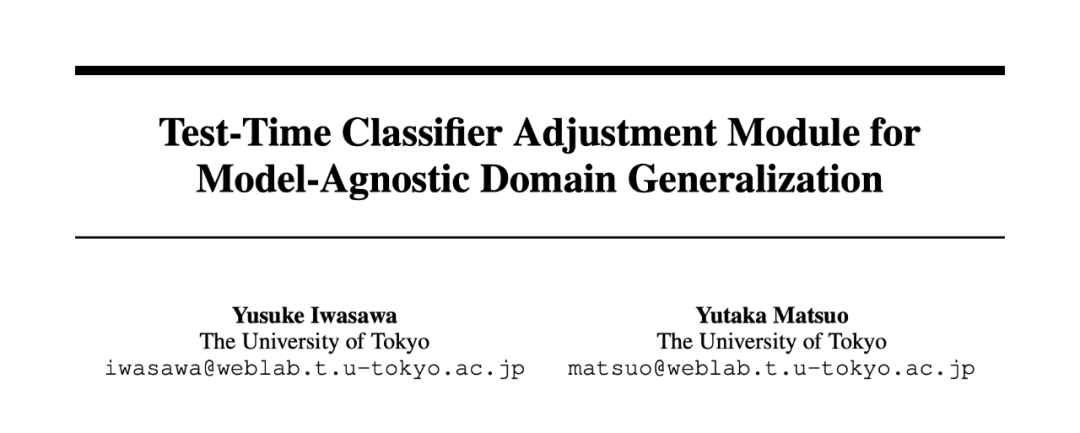

论文标题:

Test-Time Classifier Adjustment Module for Model-Agnostic Domain Generalization

NeurIPS 2021 Spotlight

https://proceedings.neurips.cc/paper/2021/hash/1415fe9fea0fa1e45dddcff5682239a0-Abstract.html

https://github.com/matsuolab/T3A

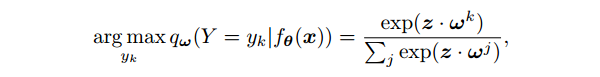

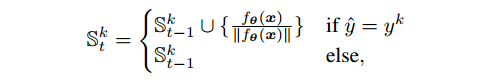

T3A 有如下几个良好的性质:

2. 计算效率高:唯一的计算开销是最后一个线性层的前向传播的成本,与特征提取器的前向和后向传播相比,这通常可以忽略不计。

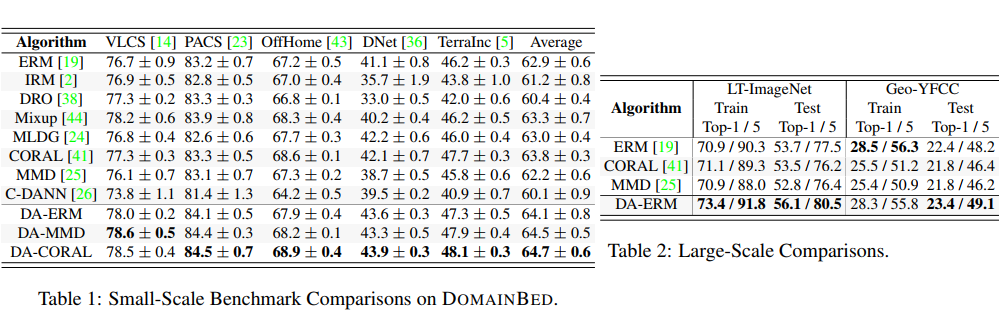

DomainBed

论文标题:

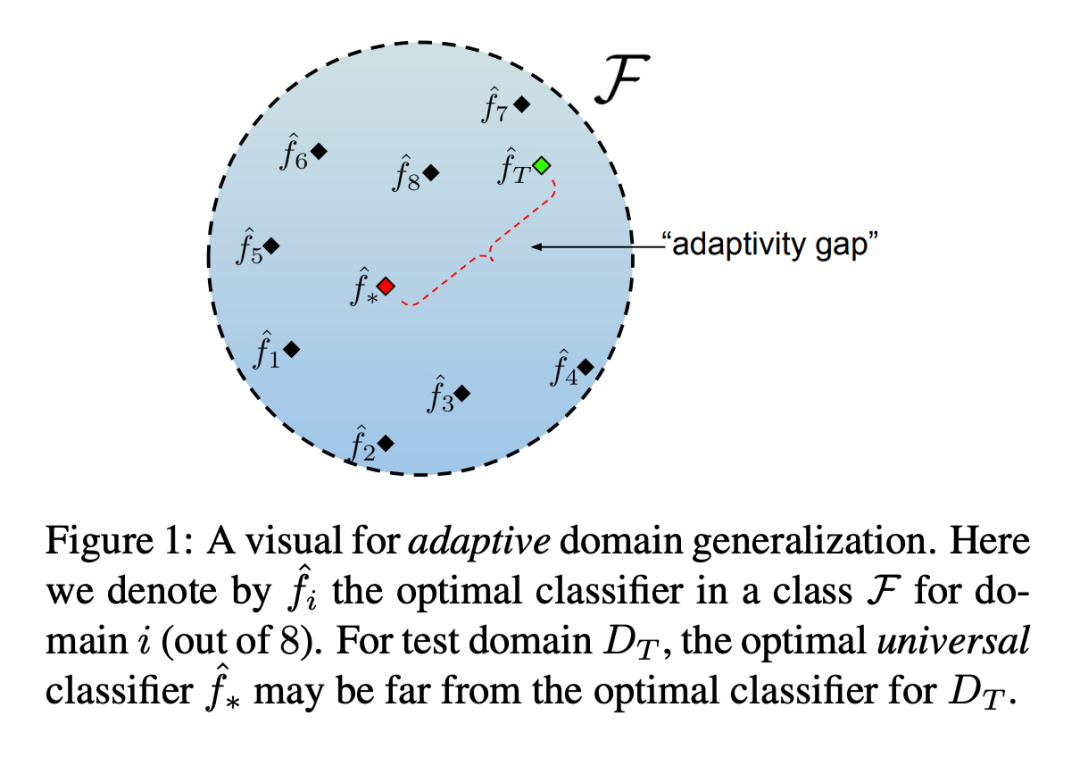

Adaptive Methods for Real-World Domain Generalization

CVPR 2021

https://arxiv.org/abs/2103.15796

https://github.com/abhimanyudubey/DomainBed

具体实现分为如下几步:

3. Inference: 测试的时候同样的需要先得到 domain embedding 和 image embedding,将二者结合起来一起输入分类器得到最终结果。

Tent

论文标题:

Tent: Fully Test-Time Adaptation by Entropy Minimization

ICLR 2021 Spotlight

https://arxiv.org/abs/2006.10726

https://github.com/DequanWang/tent

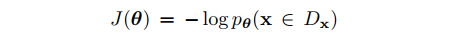

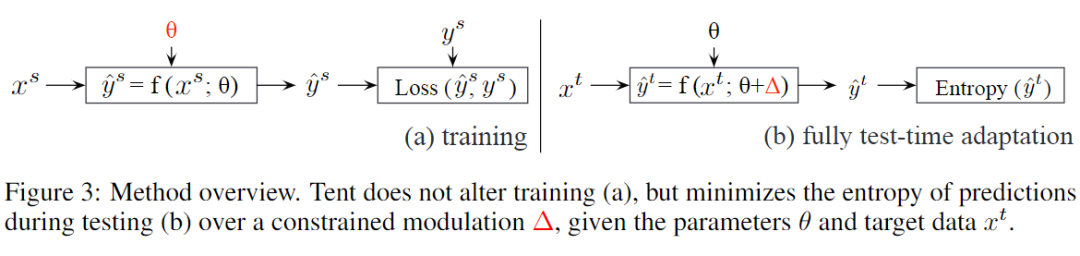

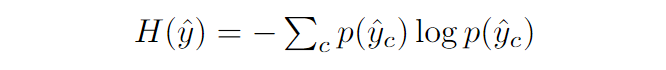

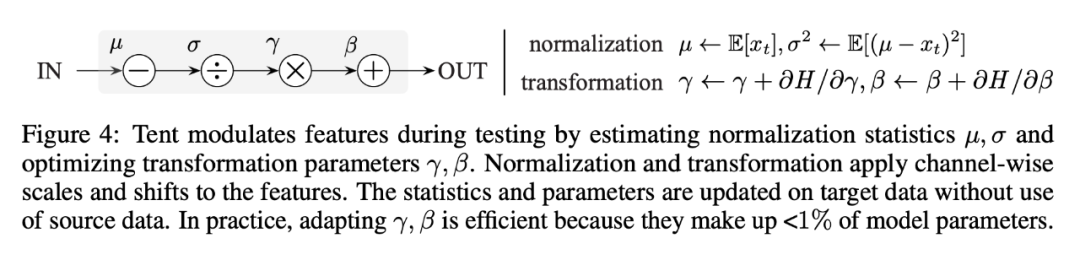

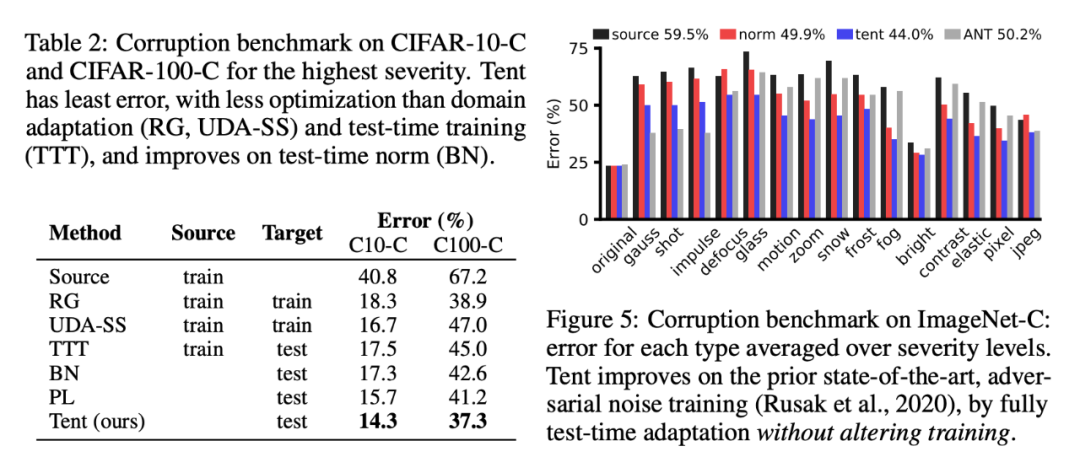

本文最主要的 intuition 是最小化模型预测的 entropy,具体实现如下所示。

实现上只需重新定义源模型的归一化层。在测试过程中更新所有层和通道的归一化统计数据和仿射参数

TADE

论文来源:

论文链接:

代码链接:

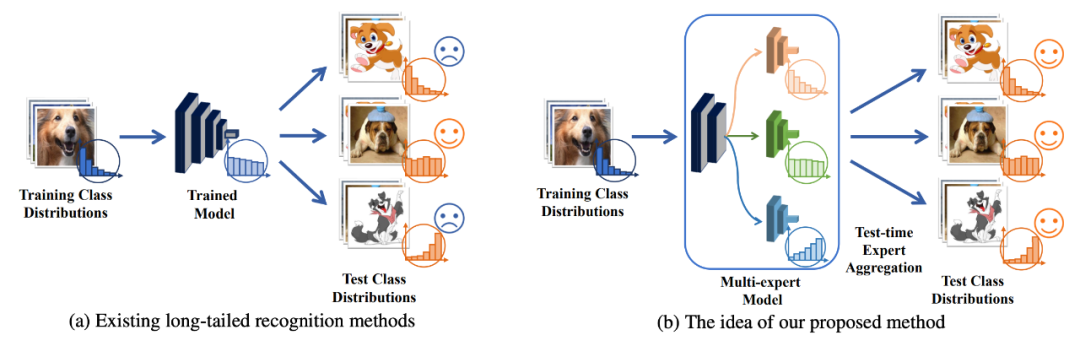

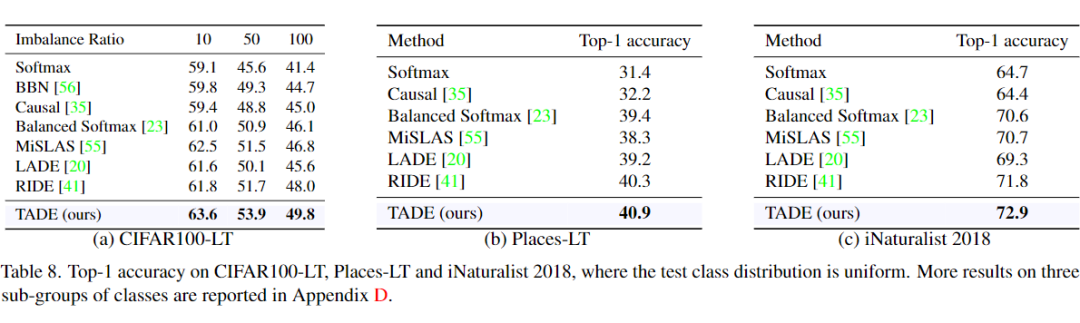

这篇文章的主题并不是 DG,而是长尾分布。这项工作研究了一个更实际的任务设置,称为测试不可知性长尾识别,其中训练类分布是长尾的,而测试类分布是未知的,可以任意倾斜。除了类不平衡的问题之外,这个任务还带来了另一个挑战:在训练样本和测试样本之间的类分布转移是未知的。

为了处理这个任务,本文提出了一种新的方法,称为测试时间聚合多样化专家 Test-time Aggregating Diverse Experts,顾名思义,也是用到了 test-time adaptation 的技术,因此我们对它的方法做一个简单介绍。

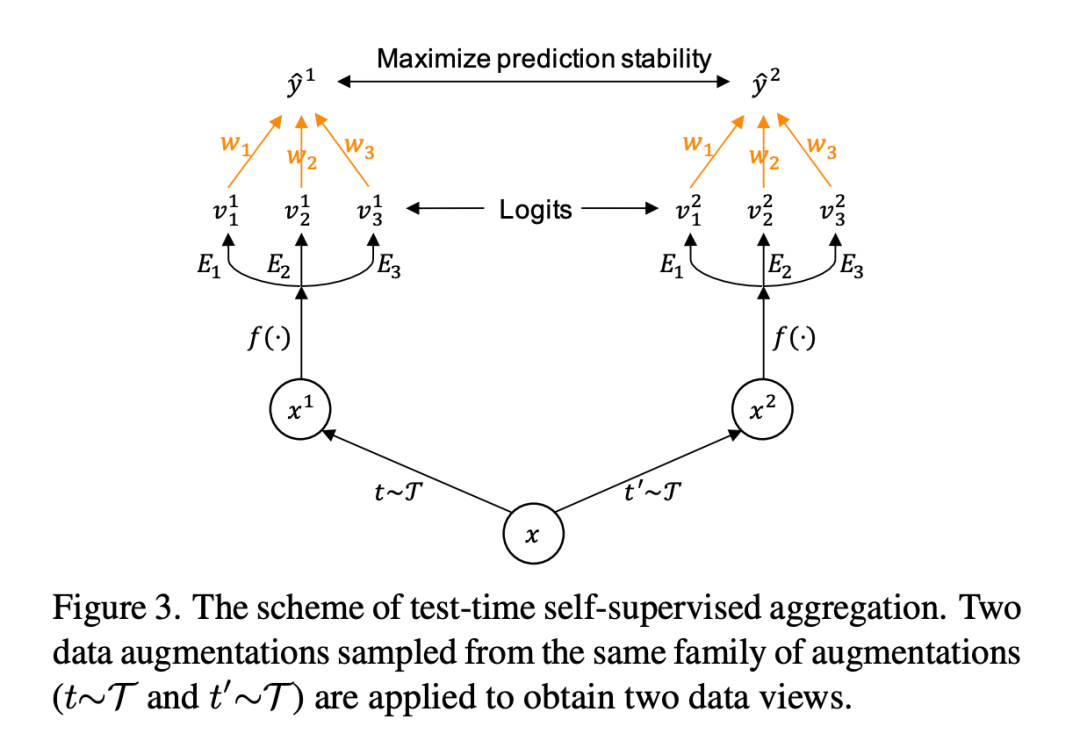

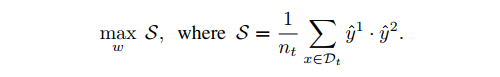

4.1 Test-time Self-supervised Aggregation

Prediction stability maximization: 本文设计了一种新的自我监督方法,即预测稳定性最大化,通过最大化未标记测试样本的模型预测稳定性来学习专家(带有冻结参数)的聚集权值。如上图所示,该方法由以下三个主要组件组成。

1. Data view generation:像 moco v2 一样生成数据增强样本;

2. Learnable aggregation weight:给定一组可学习的权重 ,我们根据对每个 expert 的结果的加权组合得到最终结果 ;

更多阅读

#投 稿 通 道#

让你的文字被更多人看到

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学术热点剖析、科研心得或竞赛经验讲解等。我们的目的只有一个,让知识真正流动起来。

📝 稿件基本要求:

• 文章确系个人原创作品,未曾在公开渠道发表,如为其他平台已发表或待发表的文章,请明确标注

• 稿件建议以 markdown 格式撰写,文中配图以附件形式发送,要求图片清晰,无版权问题

• PaperWeekly 尊重原作者署名权,并将为每篇被采纳的原创首发稿件,提供业内具有竞争力稿酬,具体依据文章阅读量和文章质量阶梯制结算

📬 投稿通道:

• 投稿邮箱:hr@paperweekly.site

• 来稿请备注即时联系方式(微信),以便我们在稿件选用的第一时间联系作者

• 您也可以直接添加小编微信(pwbot02)快速投稿,备注:姓名-投稿

△长按添加PaperWeekly小编