ACL 2022 | 基于自监督图对齐的多语言知识图谱推理

单位 | Amazon & UCLA

论文链接:

代码链接:

研究背景

在本文中,我们探索了如何自动预测和补全多个不同语言的知识图谱(KG)。不同于单语言知识图谱补全,来自多种语言的 KG 不是彼此独立的,它们通常有一些共享的实体和关系(seed alignment)。有效地利用不同 KG 存在的这些可传播的知识,不仅有利于知识向低完整性的 KG 传播,还可以减轻所有语言的 KG 补全所需的人工标注成本。然而,知识在多语言 KG 之间的传播面临着两大挑战。

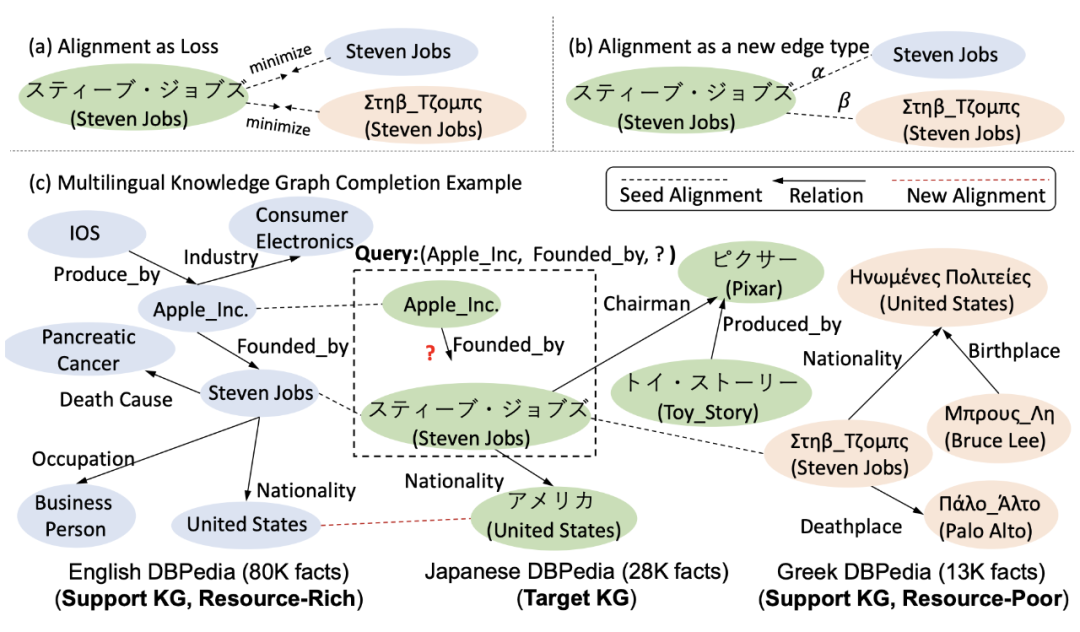

▲ 图1: 多语言KG实例

1. 不同 KG 存在着异质性,例如 KG 的数据质量,噪声,大小不同。现有的工作利用损失函数推动每一对对齐实体的向量表征尽可能地靠近,但忽略了各个对齐实体来自于不同的 KG 从而具有语言多样性,且可能带来噪声。例如在图 1 中的三个 KG 里,当我们想利用英语和希腊 KG(Supporter KGs)来补全日语 KG(Target KG)时,英语 KG(80K 事实三元组)相比于希腊 KG(13K 事实三元组)蕴含更丰富的知识。

为了补全日语 KG 中(Apple Inc., 成立, ?)这一三元组,我们可以通过 Steven Jobs 这一对齐实体从英语 KG 中传递相比于希腊 KG 更多的知识。但是,如果粗暴地利用同一损失函数推动日文中的 Steven Jobs 与英语 KG 和希腊 KG 中的 Steven Jobs 同样接近,则日文中的 Steven Jobs 将接收到来自英语和希腊 KG 中对齐实体相同程度的影响。这样学习到的向量表征,可能带来其他 KG 中蕴含的无关的信息从而导致模型预测出错。

2. seed alignment 作为知识传播的监督信号,往往很稀疏, 因为它需要进行跨语言昂贵的人工标注。为缓解稀疏性问题,已有的工作提出在模型训练过程中根据实体的向量表征相似性来生成新的对齐实体对(alignment)。新生成的实体对可以增加 KG 之间的互联互通以促进知识的传播。然而,这些方法往往属于无监习,因此生成的实体对可能存在噪声。

模型介绍

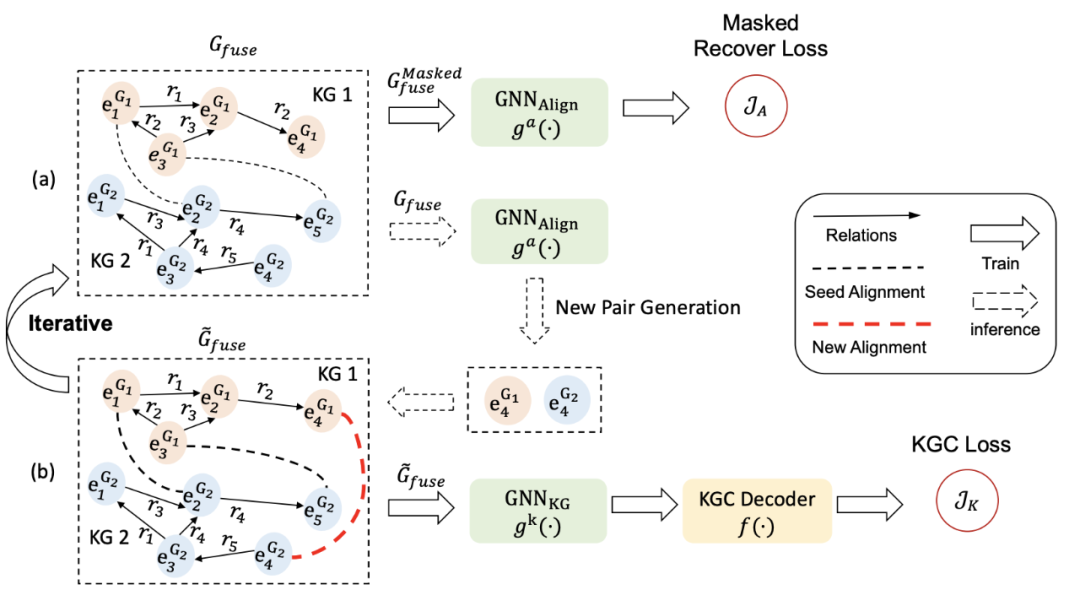

基于上述观察,我们提出了一个基于自监督图对齐的多语言知识图谱推理框架——SS-AGA。SS-AGA 将实体对齐视为一种新的边类型。这种边连接每对来自不同 KG 的对齐实体,从而将所有 KG 连接成一个整体的知识图谱。基于这样统一的建模,我们提出了一种关系感知注意机制的 GNN 编码器 ,来聚合邻近实体中的知识从而得到每个实体的向量表征。

编码器的注意力机制学习到不同邻近实体的权重,从而区分了来自不同语言的多个对齐实体传播的影响。为缓解 seed alignment 的稀疏性问题,SS-AGA 利用实体对生成器,以自监督的方式在训练过程中迭代地识别新的对齐实体对。具体而言,我们随机屏蔽掉一些已知的对齐实体,让生成器通过它们的向量表征相似性来恢复它们。

▲ 图2: SS-AGA框架图

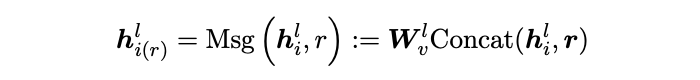

2.1 关系感知的多知识图谱表征学习

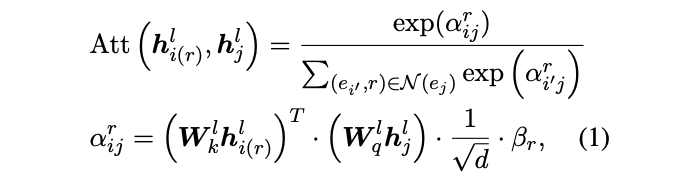

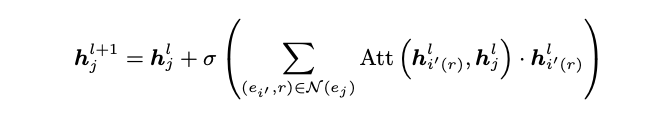

首先,我们设计一个关系感知注意机制的 GNN 编码器来同时学习所有 KG 的向量表征。我们将实体对齐视为一种新的边类型从而把所有 KG 联合成一张大图,通过学习到的注意力权重来区分来自不同 KG 的对齐实体所传播的影响。具体的关系感知注意力机制如下:

随后,我们利用知识图谱解码器(例如 TransE, RotateE)基于学习到的 KG 向量表征,来计算三元组的分数,从而进行预测。在训练过程中,我们利用如下的损失函数:

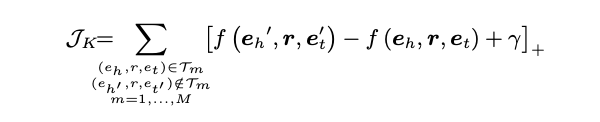

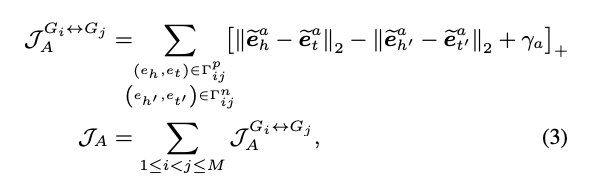

2.2 基于自监督的新对齐实体生成器

新对齐实体生成器依赖于两组实体向量表征:结构性向量表征和文本向量表征。结构性向量表征基于上述介绍的 GNN 编码器得到,它聚集了邻近实体所蕴含的知识。文本向量表征通过每个实体的文本信息和 mBert 得到。

我们将实体间的相似性建模为它们的结构性向量表征和文本向量表征的余弦相似度最大值。如果一对实体根据 CSLS 度量法则互为最近邻,我们则把它们生成为新的实体对。我们额外使用自监督的方式来生成新实体对,从而提高生成质量。具体来说,我们随机屏蔽掉一些对齐实体,让生成器恢复它们。

实验结果

3.1 新开源数据集

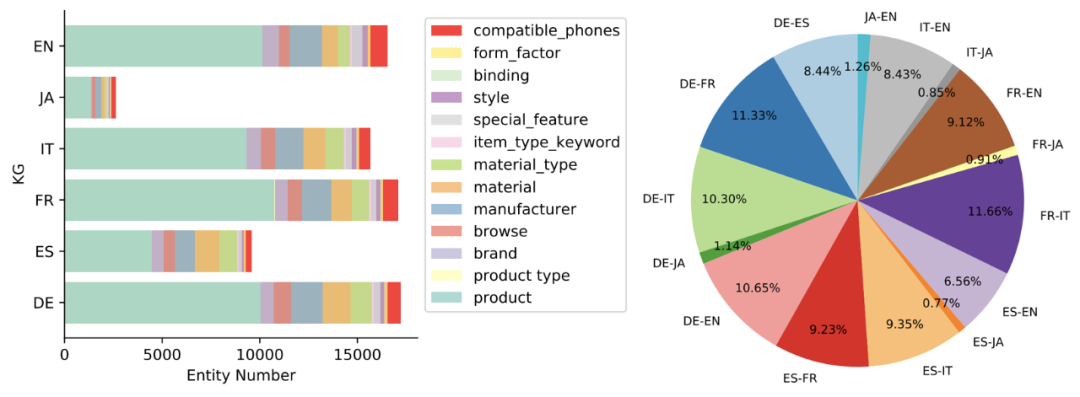

我们在两个真实世界数据集上进行了实验。除了蕴含 5 种语言的 dbpedia 数据集(DBP-5L),我们额外开源了一个多语言电子商务产品 KG 数据集 -E-PKG. 它包含与手机相关的产品信息和 6 种语言:English(EN),German(DE),French(FR),Japanese(JA),Spanish(ES),Italian(IT)。下图是 E-PKG 中各语言 KG 的实体分布图和 seed alignmen 比例图。更多细节可以在论文的附页中找到。

▲ 图3:E-PKG实体分布图和seed alignment分布图

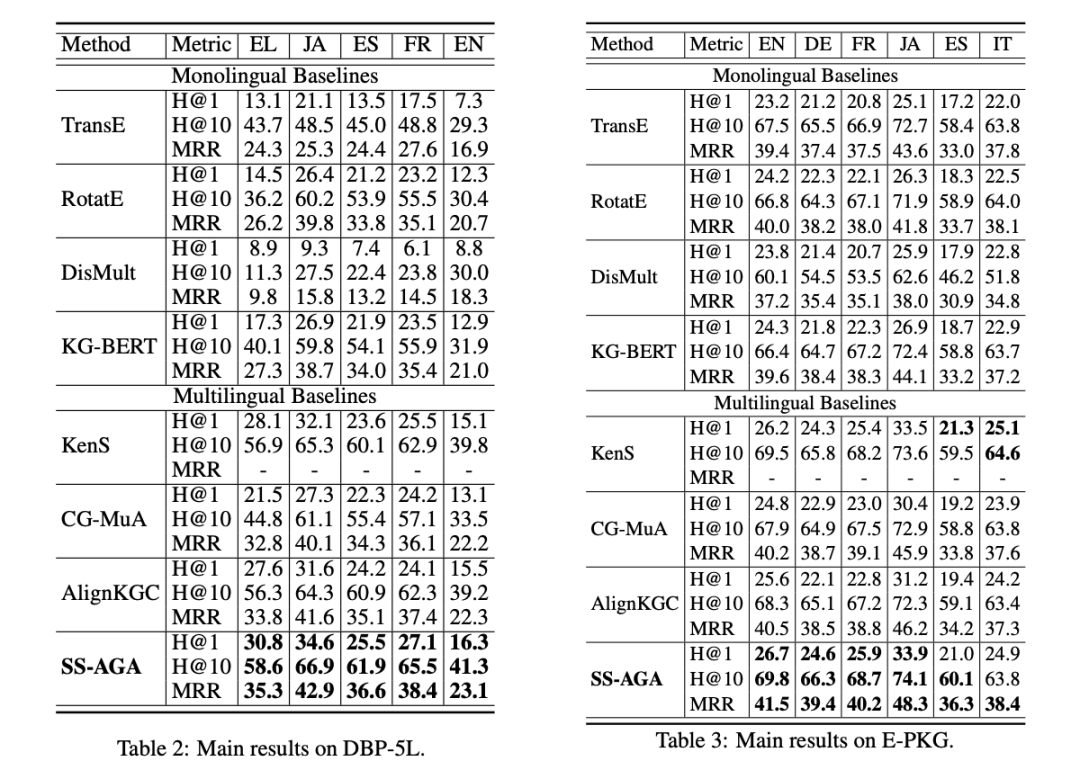

3.2 整体模型效果

我们选取了若干单 KG 模型和多 KG 模型进行对比。从下表中可以发现,多 KG 模型普遍比单 KG 模型拥有更好的性能,特别是在低完整性的 KG 上(ES in DBP-5L)。这验证了在多 KG 之间传播知识相比于单独补全每一个 KG,能获得更好的效果。其次,SS-AGA 在大部分衡量指标上相比基线模型能获得更高的补全精度。

▲ 图4:E-PKG 和 DBP-5L KG补全结果图

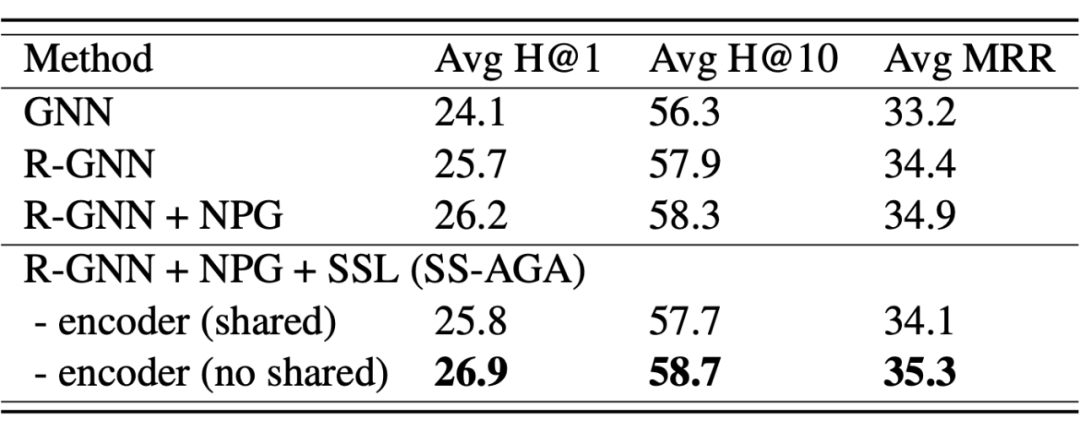

3.3 消融实验

我们在 DBP-5L 上依次移除了 SS-AGA 中 GNN 编码器中的关系感知机制,新对齐实体生成器,新对齐实体生成器的自监督学习过程,以及共享用于生成器和知识图谱表征学习的 GNN 编码器参数,来进行消融实验。从下表中可以看出,不同模块的设计均对 SS-AGA 的整体效果有所提升。

▲ 图5:DBP-5L消融实验

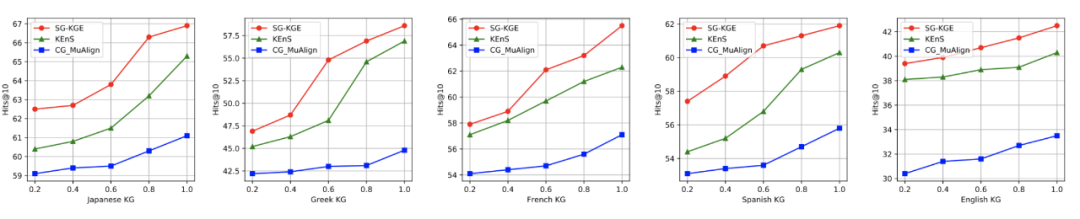

3.4 模型在稀疏seed alignment情况下的优势

我们改变 KG 中 seed alignment 的数量来研究各个多 KG 模型对 seed alignmen 数量的灵敏度。如下图所示,当 seed alignment 数量减少时,所有模型的准确度均有下降,这验证了 seed alignment 对于多 KG 知识传播的重要性。其次,完整性低的 KG 例如 Greek KG 在 seed alignment 数量减少时,补全准确率相比其他 KG 有着更显著的下降。这说明多 KG 之间的知识传播对完整性低的 KG 有更大的帮助。最后,SS-AGA 在稀疏 seed alignment 情况下,能产生比其他多 KG 基线模型更高的准确率。

▲ 图6:DBP-5L不同seed alignment比例下多KG模型的性能对比

3.5 知识传播的案例分析

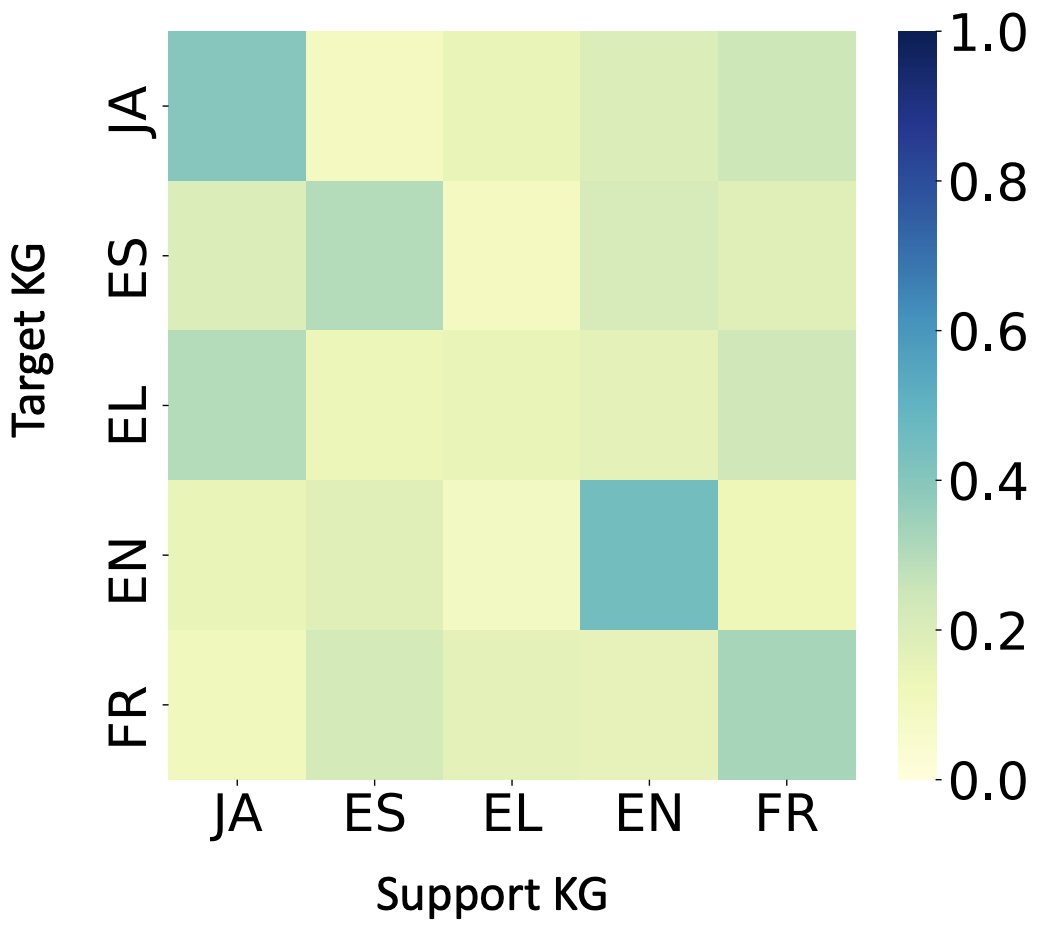

最后,我们可视化 GNN 编码器中学到的来自不同 KG 的平均注意力权重。对于完整性较高的 KG 例如英语 KG,它们最大的权重来自于本身,而对于完备性较低的希腊 KG,较高的权重值来自于其他语言的 KG。这表明希腊 KG 上的性能提升很大程度来源于其他 KG 里有效的知识传播。

▲ 图7:DBP-5L中平均注意力权重

总结

在这项工作中, 我们提出了用于多语言知识图谱补全的模型 SS-AGA。它通过融合各语言 KG 并使用关系感知注意力机制 GNN 编码器来解决多语言KG的异质性问题。通过利用自监督新实体生成器,SS-AGA 在训练过程中不断生成新的实体对从而缓解了seed alignment 的稀疏性问题。最后,我们开源了一个新的多语言电子商务产品 KG 数据集 -E-PKG,并在两个真实数据集上验证了 SS-AGA 的有效性。

参考文献

[1] Xuelu Chen, Muhao Chen, Changjun Fan, Ankith Uppunda, Yizhou Sun, and Carlo Zaniolo. 2020. Multilingual knowledge graph completion via ensemble knowledge transfer. In Proceedings of the 2020 Conference on Empirical Methods in Natural Language Processing: Findings, pages 3227–3238.

[2] Yixin Cao, Zhiyuan Liu, Chengjiang Li, Zhiyuan Liu, Juanzi Li, and Tat-Seng Chua. 2019. Multi-channel graph neural network for entity alignment. In ACL.

[3] Zhao Zhang, Fuzhen Zhuang, Hengshu Zhu, Zhiping Shi, Hui Xiong, and Qing He. 2020. Relational graph neural network with hierarchical attention for knowledge graph completion. Proceedings of the AAAI Conference on Artificial Intelligence, pages 9612–9619.

[4] Qi Zhu, Hao Wei, Bunyamin Sisman, Da Zheng, Christos Faloutsos, Xin Luna Dong, and Jiawei Han. 2020. Collective multi-type entity alignment between knowledge graphs. In Proceedings of The Web Conference 2020.

欢迎关注 Amazon Search Query Understanding Team 在近年来在 ACL,EMNLP,NAACL,WWW,KDD,CIKM,SIGIR 等发表的工作,扫描下方二维码即可进行查看:

同时欢迎想来 Aamazon Search research internship 通过邮件联系:amzzhe@amazon.com(李正)。

邮件标题:Research Internship + Name + Time(Spring / Summer / Fall / Winter)+ 个人简历

更多阅读

#投 稿 通 道#

让你的文字被更多人看到

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学术热点剖析、科研心得或竞赛经验讲解等。我们的目的只有一个,让知识真正流动起来。

📝 稿件基本要求:

• 文章确系个人原创作品,未曾在公开渠道发表,如为其他平台已发表或待发表的文章,请明确标注

• 稿件建议以 markdown 格式撰写,文中配图以附件形式发送,要求图片清晰,无版权问题

• PaperWeekly 尊重原作者署名权,并将为每篇被采纳的原创首发稿件,提供业内具有竞争力稿酬,具体依据文章阅读量和文章质量阶梯制结算

📬 投稿通道:

• 投稿邮箱:hr@paperweekly.site

• 来稿请备注即时联系方式(微信),以便我们在稿件选用的第一时间联系作者

• 您也可以直接添加小编微信(pwbot02)快速投稿,备注:姓名-投稿

△长按添加PaperWeekly小编

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧