刚刚,ACL最佳论文奖出炉,刘群团队获最佳长文奖

作者:杨晓凡

编辑:camel

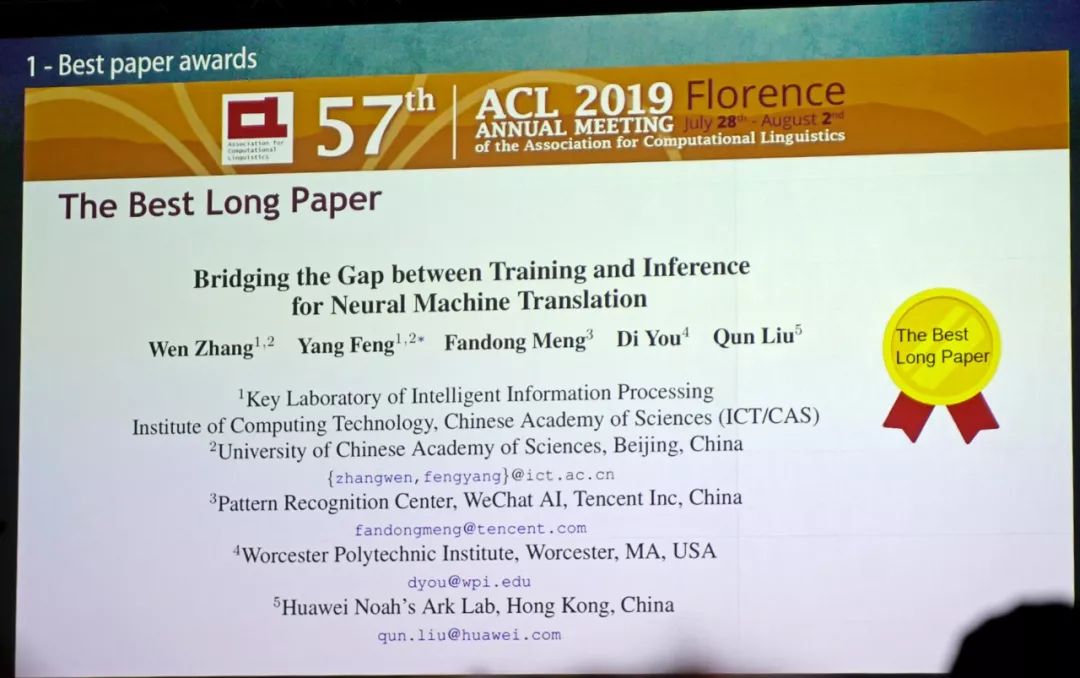

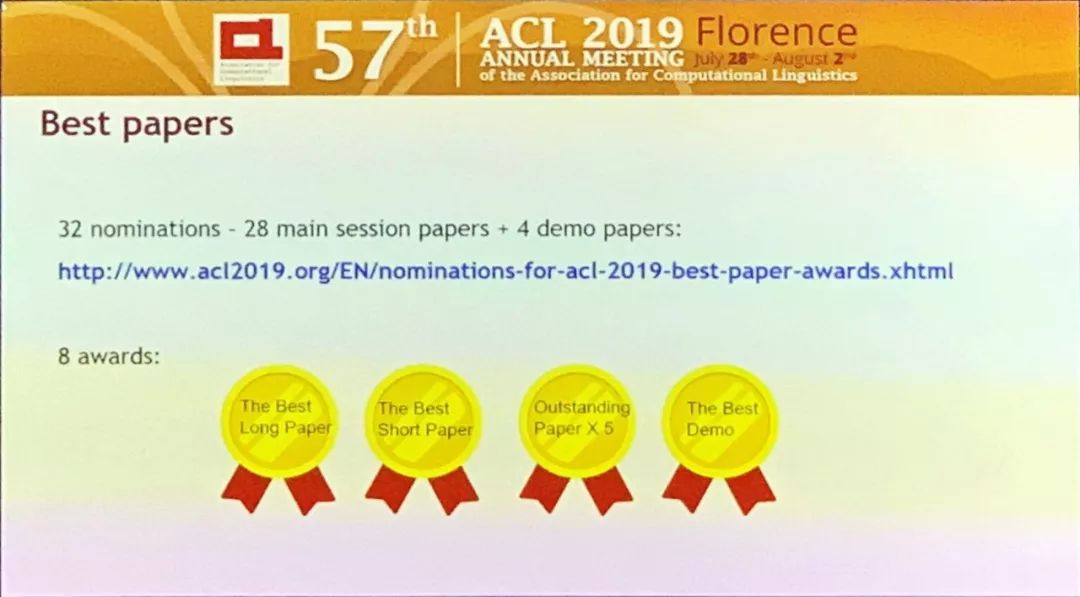

最佳长论文奖

中文标题:弥补神经机器翻译在训练和推理过程之间的缺口

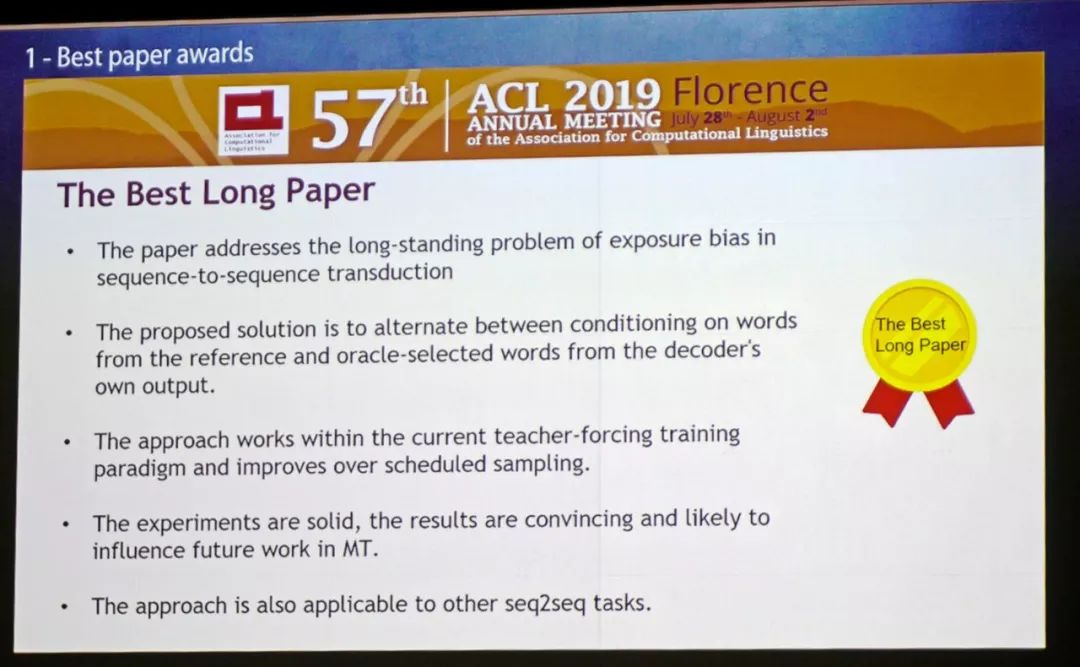

该论文解决了seq2seq转换中长期存在的暴露偏差问题;

论文所提出的解决方案是:判断依据在“基于参考文本中的词”和“解码器自己的输出中预选择词”两种之间切换

这个方法适用于当前的teacher-forcing训练范式,并改进了规划抽样;

论文的实验做的非常完善,结果令人信服,并可能影响机器翻译未来的工作;

该方法也适用于其他seq2seq任务。

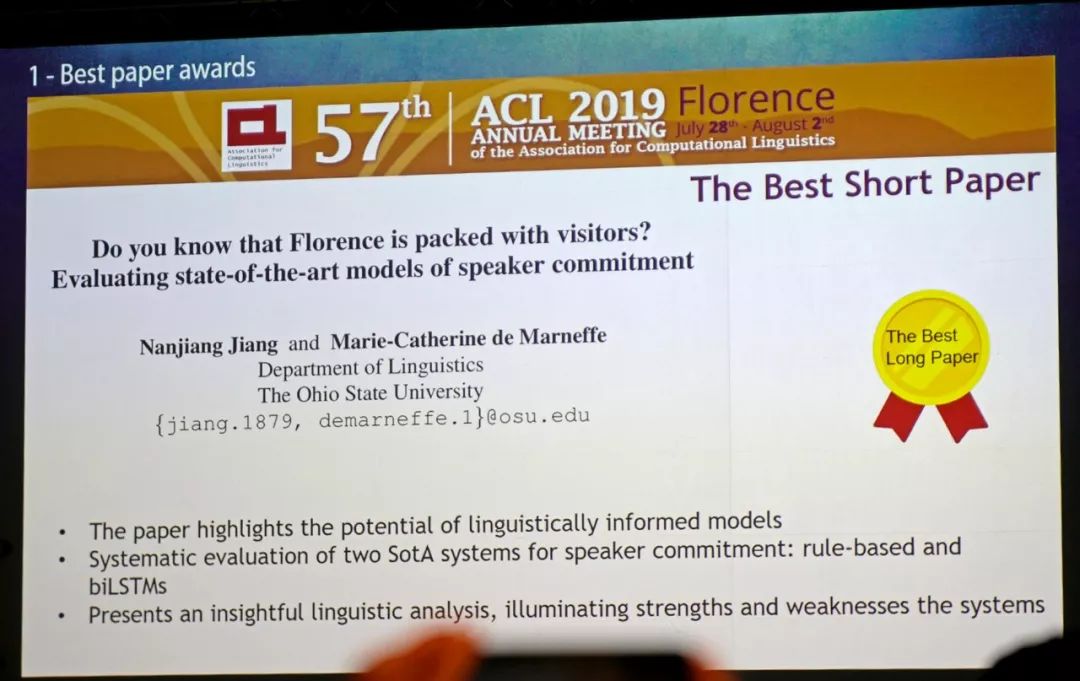

最佳短论文奖

中文标题:“你知不知道佛罗伦萨全都是游客?”,评价最先进的说话人承诺模型

论文作者: Nanjiang Jiang, Marie-Catherine de Marneffe

论文地址: https://www.aclweb.org/anthology/P19-1412

获奖理由:

这篇论文展示出了带有语言学知识的模型的巨大潜力

对基于规则的和双向LSTM这两种最先进的说话人承诺模型进行了系统的评价

论文中的语言学分析给人启发,也展现出了系统的优势和劣势

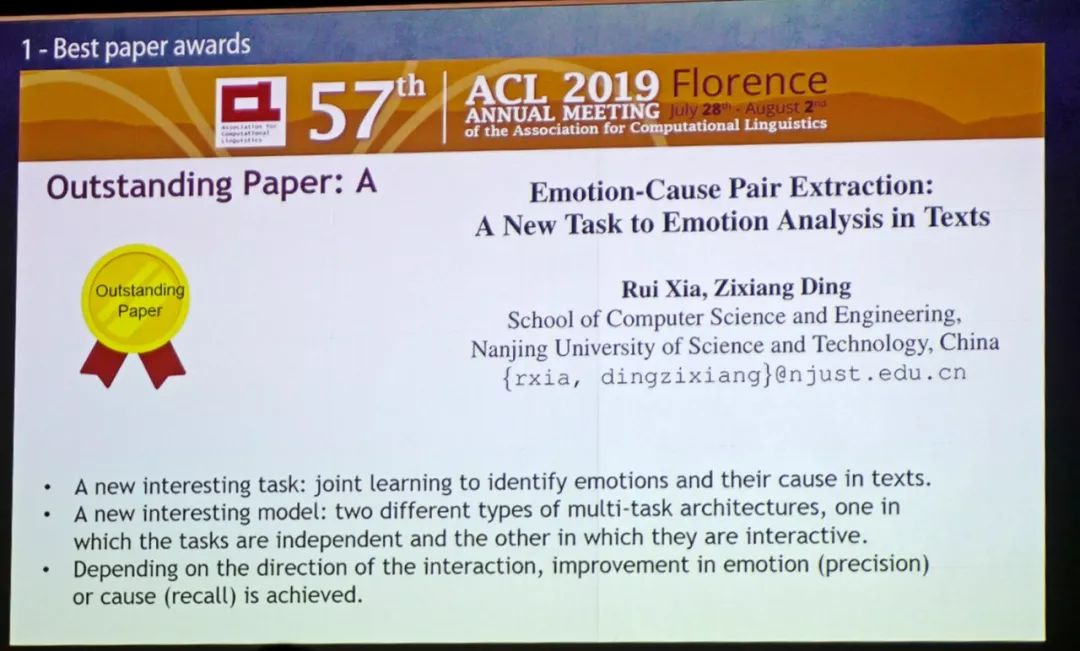

杰出论文奖(五篇)

中文标题:情绪-原因对的提取:文本情感分析中的一个新任务

提出了一项新的有趣的任务:在文本中通过联合学习来识别情感及原因。

提出一个新的有趣的模型:两种不同类型的多任务架构,一种是任务独立的,另一种是交互的。

根据相互作用的方向,实现情绪(精确度)或原因(召回)的改善。

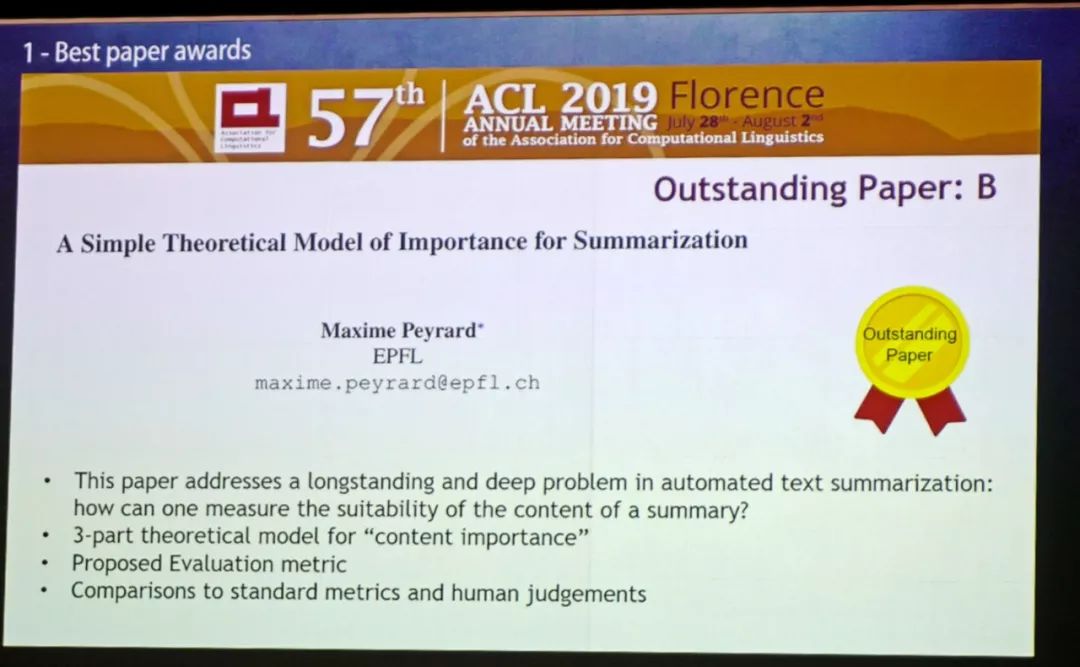

中文标题:文本摘要重要性的一个简单的理论模型

这篇文章讨论了自动文本摘要中长期存在的深层问题:如何衡量摘要内容的适用性?

提出了「内容重要性」的三部分理论模型

提出了建设性的评估指标

文章中还与标准指标和人类判断进行了比较

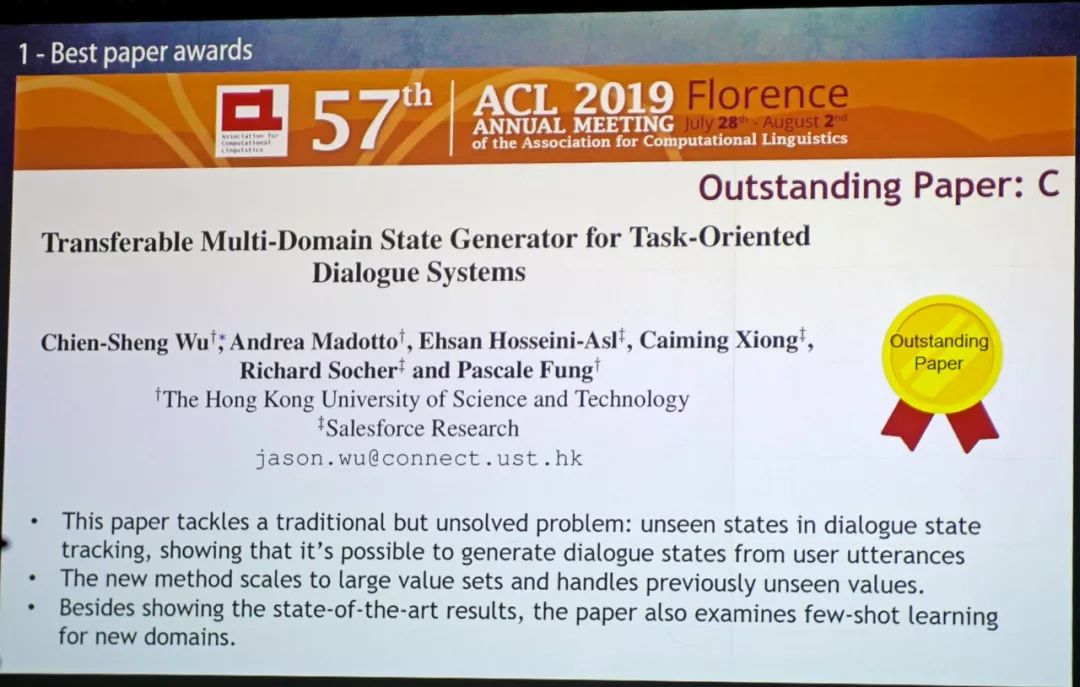

中文标题:用于面向任务的对话系统的可传输的多领域状态生成器

本文解决了传统但未解决的问题:对话状态跟踪中看不见的状态;表明可以从用户话语中生成对话状态;

新方法可扩展到大值集(large value sets)并能处理以前看不见的值;

除了展示最先进的结果外,本文还研究了针对新领域的few-shot学习。

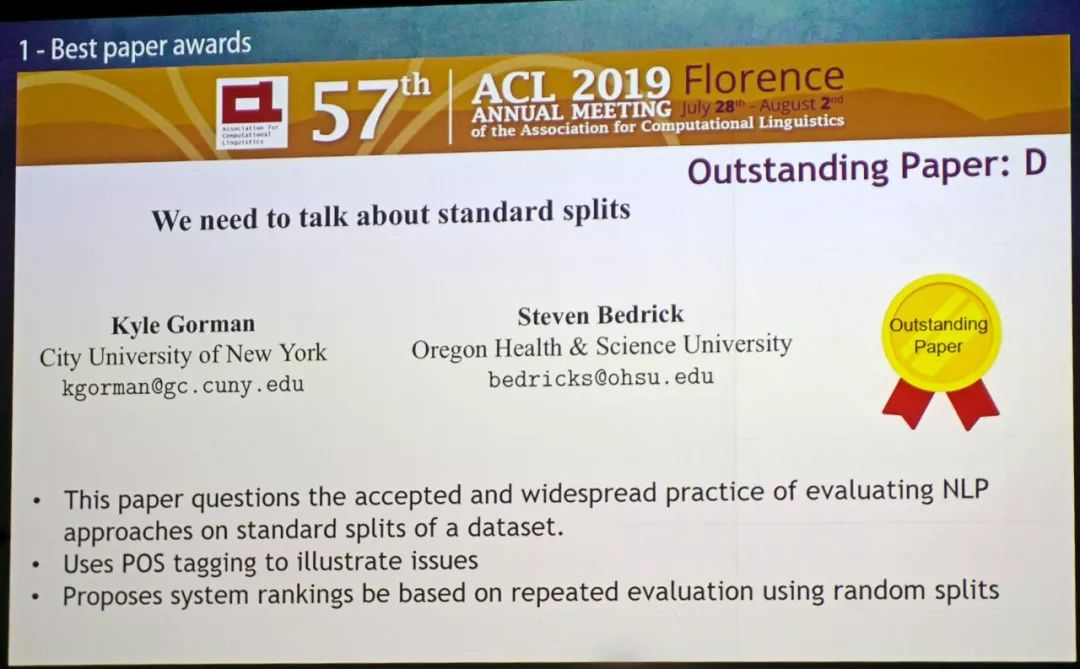

中文标题:我们需要谈谈标准的数据集分割做法

本文质疑了评估NLP模型时公认且广泛运用的方法;

本文提出了几种关于数据集的标准拆分方法;

本文使用POS标记说明了问题;

本文建议系统排名应当基于使用随机分组的重复评估方法

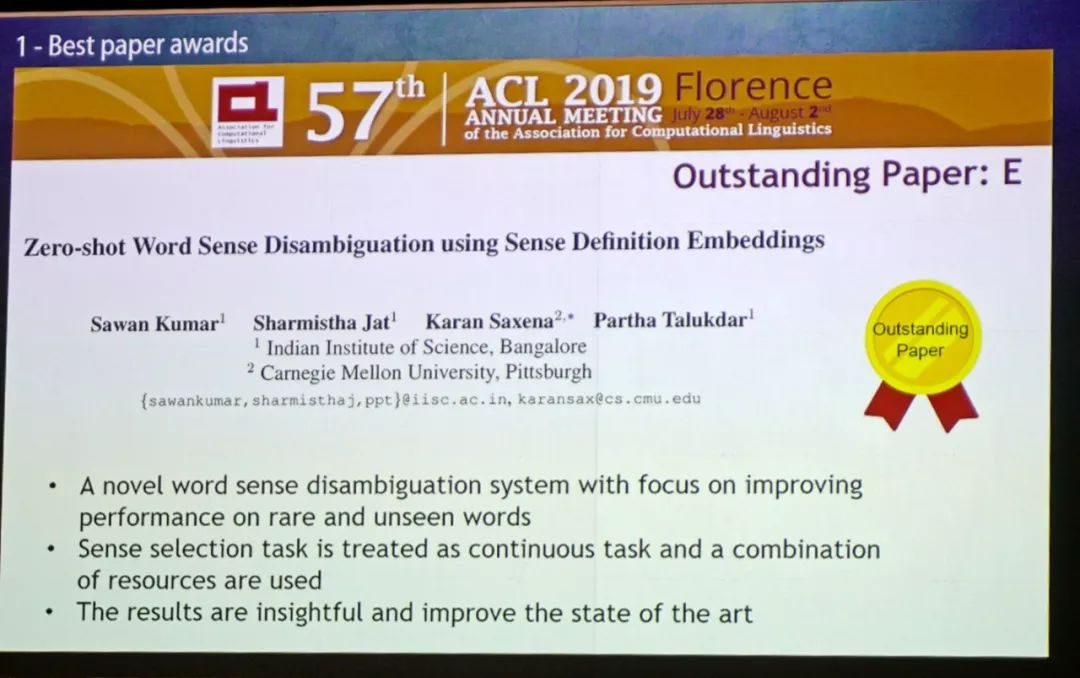

中文标题:通过阅读实体描述进行零样本实体链接

本文提出了一种新颖的词义消歧系统,专门用于提高稀少的和未见过的词上的表现;

本文提出的感知选择任务被视为连续任务,并且使用了资源的组合;

本文的结果富有洞察力,并且改善了现有水平。

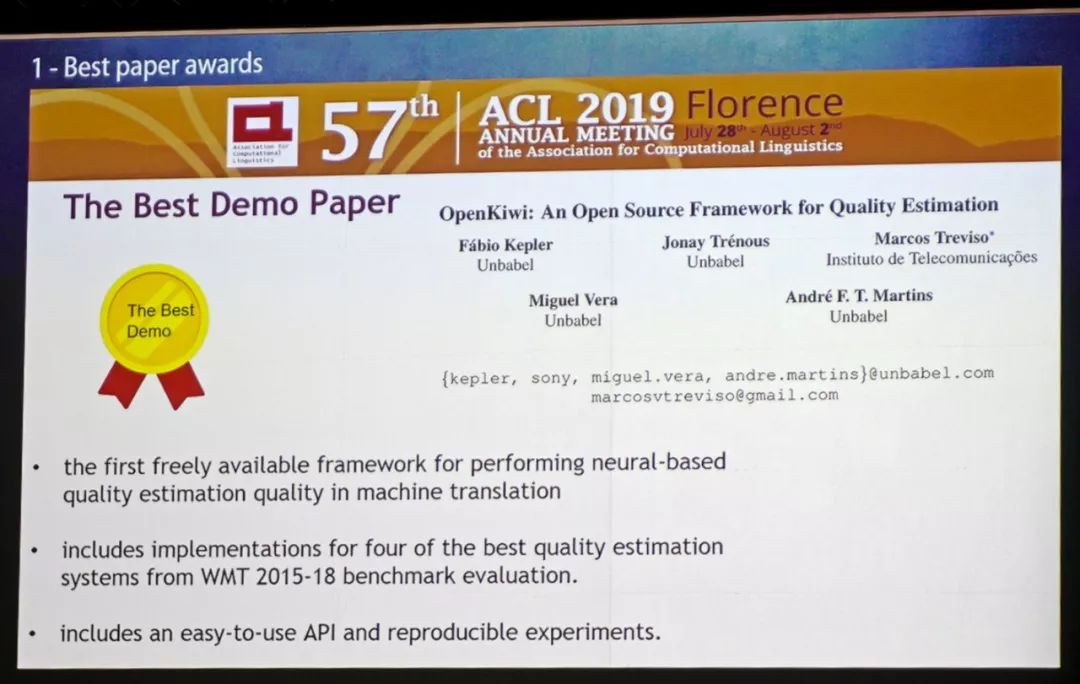

最佳 Demo 论文奖

这是机器翻译中第一个可以自由使用的用于执行基于神经的质量估计的框架;

包含了WMT 2015-18基准评估中四种最佳质量评估系统的实现;

包含了易于使用的API和可复现的实验。