论文笔记 | How NOT To Evaluate Your Dialogue System

EMNLP 2016

原文链接:https://arxiv.org/pdf/1603.08023.pdf

问题

本文针对对话任务的自动评测问题进行讨论。随着对话系统研究的发展,对话检索和生成模型层出不穷,目前主要采用人工标注的方式进行评测,那么之前的一些自动评测指标,如机器翻译任务中的BLEU等是否在对话生成的评测中依然适用?

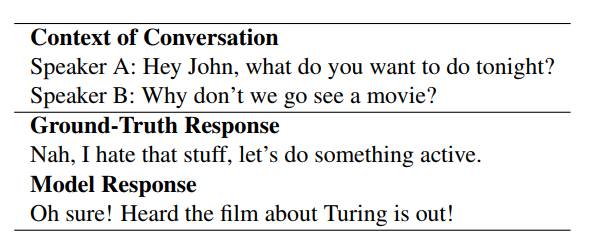

如上例子可以看出,虽然BLEU分数为0,但是模型生成的回复实际上是一个合适的回复。

本文讨论了基于词语重叠的自动评测指标(BLEU、METEOR、ROUGE)和基于词向量表征相似度(Word2Vec),实验对比发现,这些既有指标都不适用于对话评估。

方法

这里的核心思想是比较自动评测指标和人工标注的相关性。

首先需要有候选回复,一般得到回复的方法分为检索和生成两类,这里分别采用了这两类中的典型方法:TF-IDF、Dual Encoder、LSTM、HRED。

需要对比的几种自动评测指标:BLEU、METEOR、ROUGE、基于词向量表征的相似度。

分别对模型给出的回复计算自动评测指标和进行人工标注,然后计算相关性。

实验

数据:通用内容的数据集(Twitter)、某专业领域的数据集(Ubuntu)

结果:各自动评测指标同人工标注的相关性较差,说明这些既有指标都不适用于对话评估。

作者:李想,北京大学在读博士,研究方向为自然语言处理。

登录查看更多

相关内容

专知会员服务

33+阅读 · 2020年2月29日

Arxiv

4+阅读 · 2018年6月11日