【SCIR笔记】ACL20 让模型“事半功倍”,探究少样本序列标注方法

来自:工大SCIR Lab

论文名称:Few-shot SlotTagging with Collapsed Dependency Transfer and Label-enhanced Task-adaptiveProjection Network

论文作者:侯宇泰,车万翔,赖勇魁,周之涵,刘一佳,刘晗,刘挺

原创作者:侯宇泰

论文链接:

https://arxiv.org/abs/1906.08711

代码链接:

https://github.com/AtmaHou/FewShotTagging

少样本学习(Few-shot learning)是近年来研究热点之一。然而,已有研究主要集中在图像任务和简单分类任务上,针对NLP复杂任务(e.g. 对话任务)或者NLP特有挑战(e.g. 结构化预测问题)的小样本研究领域,仍然是一片蓝海。

本文首先简单介绍小样本学习任务,然后介绍我们在ACL2020上的论文。论文中我们以对话中的语义槽标记(Slot Tagging)为切入点,探究了小样本下的序列标注问题。在语义槽标记(Slot Tagging)和命名实体识别(NER)两个序列标注任务上我们的模型大幅优于最强的Few-shot baseline 7.96和11.70 F1-score。

1. 少样本学习

(Few-shot Learning)

近年来,人工智能在深度学习方法的帮助下取得了令人瞩目的成就。然而目前的深度学习方法都需要大量的标注训练数据,而在真实的落地场景下,大量人工标注数据往往是很难获得的。以任务型对话为例,产品开发时往往难以获得待开发功能的真实用户语料。即使有生语料,任务型对话开发也面临着人工数据标注成本高昂的挑战。同时,如Fig 1所示,像对话系统这样的人工智能应用往往面临着需求频繁变化的问题,导致繁重数据标注任务常常需要反复进行。

Fig 1 现实中智能系统经常需要适配新的功能

反观人类,人在学习一个新的任务时只需要少数几个样例(见Fig 2)。这种巨大的反差启发科研人员开始探索能够像人一样,利用先前经验和少量数据进行学习的人工智能系统。

Fig 2 人类擅长从少量样本中学习

少样本学习(Few-shot Learning)就是专门针对上述问题的新兴研究方向。如Fig 3所示,少样本学习专门研究如何利用过往经验知识,在新的任务上只使用少数几个样例数据进行学习,通常在新的任务上每个类别只有1-5个样例数据。

Fig 3 5 way-1 shot少样本学习样例

以往少样本的研究主要集中在图像领域,针对NLP特有问题(e.g. 结构化预测问题和序列标注问题)的少样本研究的还较少。这些Few-shot NLP问题有着独特的挑战,相关技术也能切实帮助NLP应用解决数据难题真正落地,是值得探索的新兴研究领域(Fig 4)。

Fig 4 Few-shot在NLP问题的研究方兴未艾

2. 简介

目前针对少样本学习的工作主要研究少样本的图像分类问题,对于自然语言处理任务的探索也主要着眼于短文本分类任务。我们的工作以语义槽标记(Slot Tagging)入手,探索了序列标注(Sequence Labeling)任务中的少样本学习方法。

少样本序列标注任务面临着不同于其他纯粹的分类任务的独特挑战,因为序列标注是一个结构化预测问题,有建模标签间的依赖关系的需求。然而,不同领域通常具有不同的标签集,这使得难以跨领域地学习标签依赖性——无法利用过往经验。

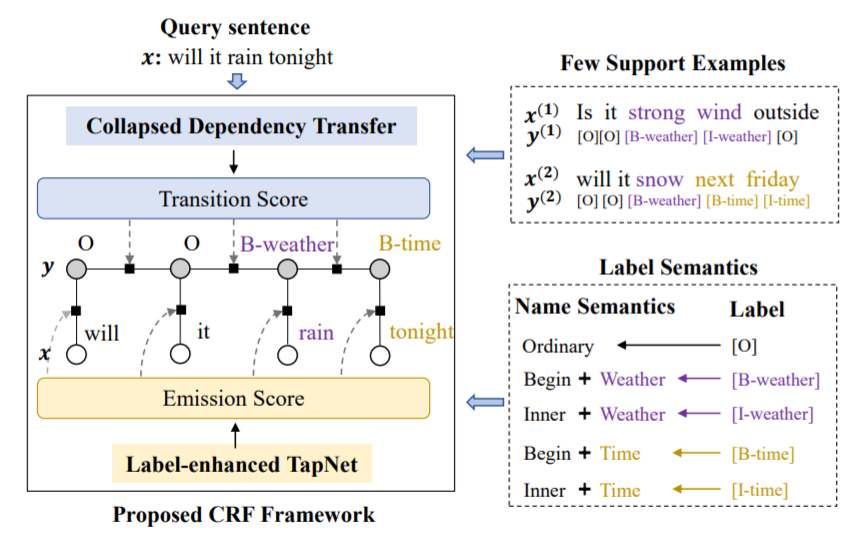

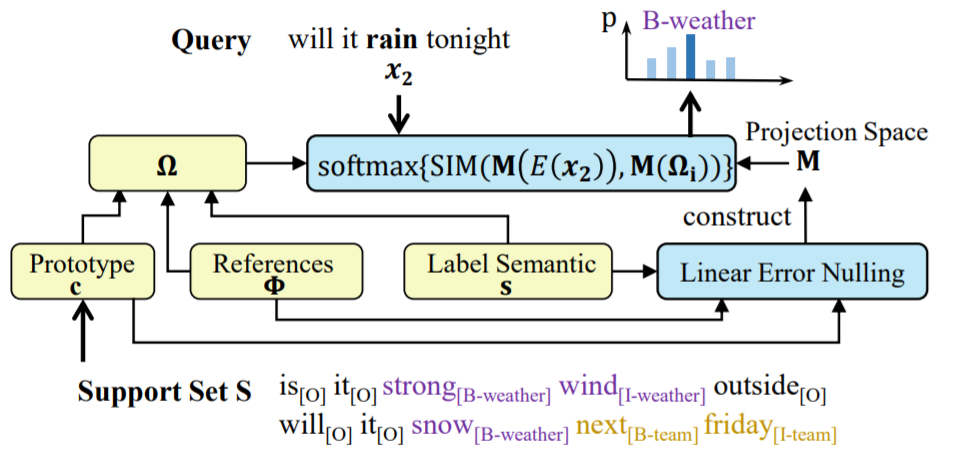

Fig 5 我们的少样本语义槽标记模型框架图

在本文中,为了建模标签之间的依赖关系(Transition Score),我们提出了一种跨领域建模标签依赖关系的方法——坍缩依赖迁移(Collapsed Dependency Transfer)。我们首先从数据充足的源域(Source Domain)学习抽象标签依赖关系,并在少样本的目标域中泛化学到的依赖关系来辅助标签序列的预测。

为了在小样本情形下得到每个词的标签概率(Emission Score),我们提出L-TapNet,来基于每个词和不同标签表示的相似度计算属于不同标签的概率。L-TapNet在计算时利用了label名字中的语义信息,并通过线性偏差消除法(Linear-error Nulling)构造映射空间来将不同标签类别在embedding空间有效分开。

最终,我们提出了一种基于CRF的少样本序列标记框架,以整合上面提到跨领域标签依赖建模和L-TapNet给出的标签概率(见Fig 5)。在语义槽标记(Slot Tagging)和命名实体识别(NER)数据集上的实验表明,我们的模型在1-shot设置中分别显着优于最强的少样本学习baseline 7.96和11.70 F1-score。

3. 方法

3.1 模型

如Fig 5所示,我们提出了一个基于CRF的少样本序列标记框架。它通过整合基于相似性的标签概率(Emission Score)和从先前经验学到的跨领域标签依赖关系(Transition Score)来找到最佳标签序列。具体的,框架由三个主要模块构成:Transition Scorer、Emission Scorer、Context Embedder。

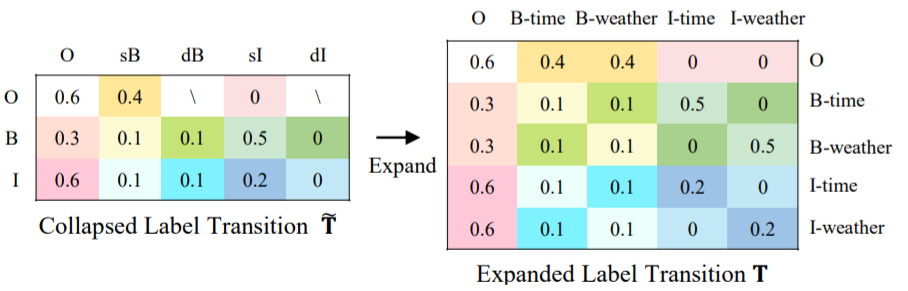

1)转移打分模块Transition Scorer

Transition Scorer 负责估计标签的转移概率。如Fig 6所示,它通过将特定领域的标签划分为几个抽象标签类别,并建模抽象标签之间依赖关系。由于我们的抽象分类标准是可以跨领域的,我们得以将抽象的标签依赖信息从源域迁移到目标域。在目标域上,我们直接将迁移的抽象标签依赖关系扩展为特定领域的具体标签之间的依赖关系。扩展过程如图所示,我们把抽象转移概率表(Collapsed LabelTransition)中的值,填到具体转移表(Expanded Label Transition)中颜色相同的位置,从而得到具体的转移概率。由于整个过程是可导的,因而我们直接端到端地在一个个具体的源领域,用反向传播的方式学习抽象转移概率。

Fig 6 坍缩标签依赖示意图

2) 标签概率打分模块Emission Scorer

如Fig 7所示,Emission Scorer利用词(Token)和标签表示(Label Representation)的相似度,得到待预测语句每一个词的标签分布概率分布。这个过程中,标签表示是通过观察少量已有标签样本得到的,如平均所有该标签词的embedding,而相似度度量函数是在富数据源于学得的。在我们的框架中,Emission Scorer可以替换为任意的少样本分类模型如Prototypical Network,Matching Network等。这里,我们在近期的图像少样本分类模型TapNet基础上,利用标签名称语义来表示标签,提出了一种标签增强的任务自适应投影网络(L-TapNet)。具体的,我们通过利用标签名中的语义信息得到更好的标签表示,并通过以及线性偏差消除法(Linear-error Nulling)方法,用运算的方法得到一个映射空间,使得在映射空间中,不同的,不同的标签表示能有效地分开。

Fig 7 L-TapNet 发射概率模型

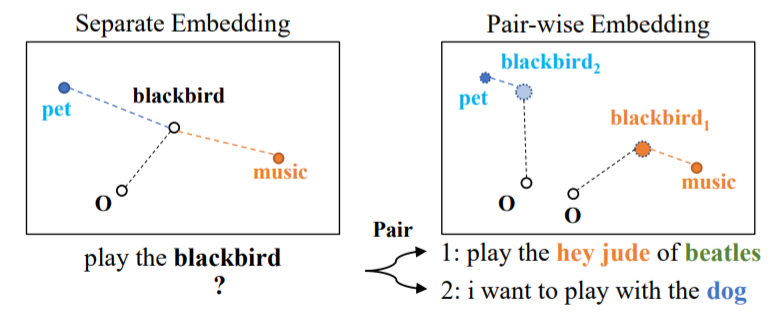

3)上下文相关词表示模块 Context Embedder

Context Embedder为语句中的每一个词提供上下文相关的词表示,这里我们使用bert来完成。为了更好的捕获领域特点和消除歧义,我们提出pair-wise embedder成对地表示带标签支持样例和待标注样本。具体如Fig 8 所示,通过利用support句子中的领域特定上下文,我们能够有效地消除词表示的歧义。

Fig 8 Pair-wise Embedding示例图

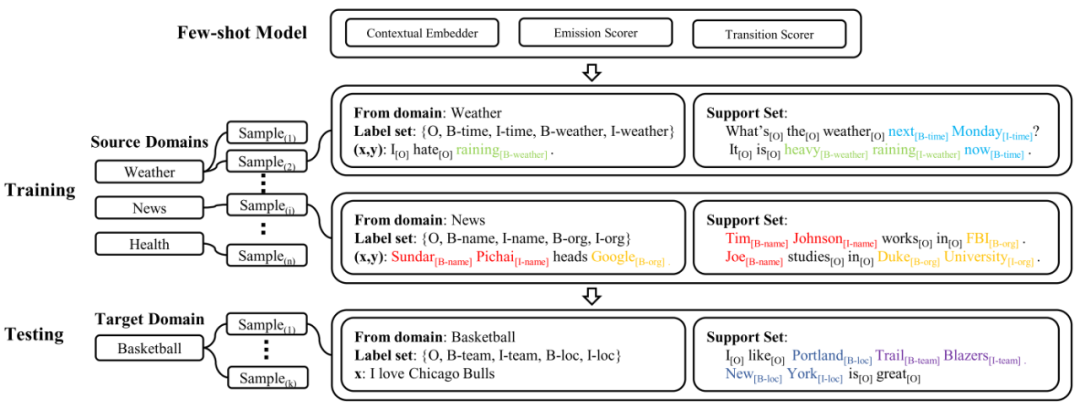

3.2 模型训练

Fig 9 模型训练与测试过程

前人工作(Vinyalset al., 2016)提出,在训练时模拟few-shot状态有助于提升模型表现。我们沿用了他们的这种Meta-training的训练策略,训练过程如Fig 9所示。

特别的,我们的整个模型架构都是可导的,因而,我们在训练时直接使用CRF的LogLikelihood作为Loss进行端到端训练。

4. 实验

4.1 数据集

针对语义槽标记任务,我们使用snips dataset (Coucke et al., 2018)来评价模型. 它一共包含7个领域的数据:Weather (We), Music (Mu), PlayList (Pl),Book (Bo), Search Screen (Se), Restaurant (Re) and Creative Work (Cr).

对于NER任务,我们使用4个不同的数据集:CoNLL-2003 (Sang and De Meulder, 2003),GUM (Zeldes, 2017), WNUT-2017 (Derczynski et al., 2017) 以及 Ontonotes (Pradhan et al., 2013),每一个数据集包含一个领域的数据:News, Wiki, Social and Mixed。

我们把现有的数据构造成了N-way,K-shot的格式。

4.2 实验

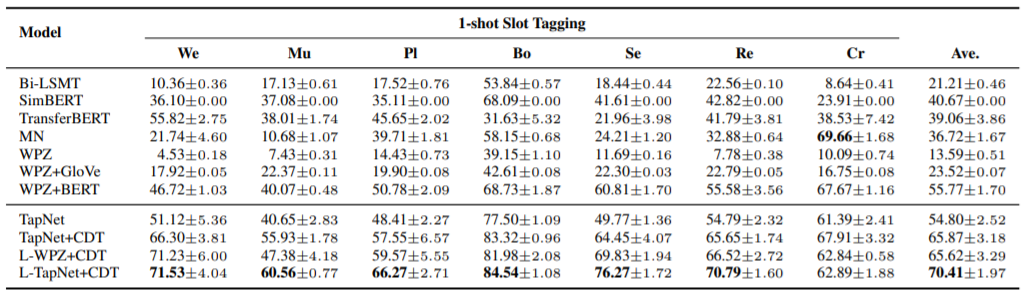

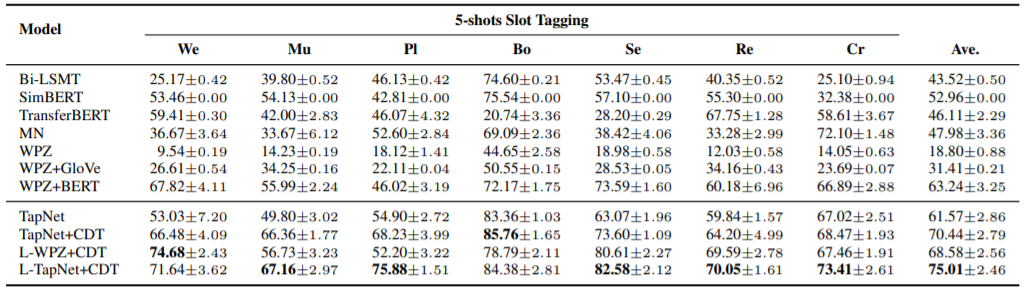

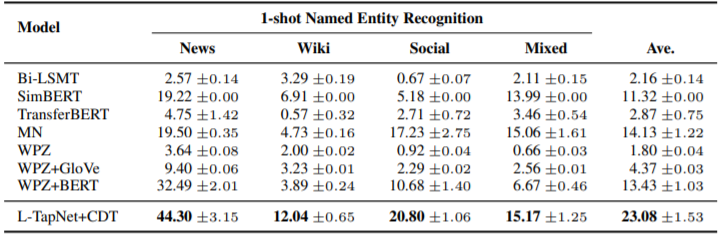

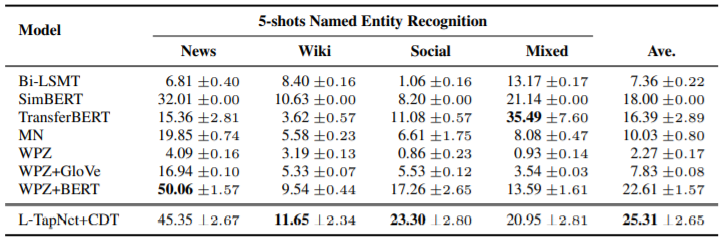

Slot Tagging 和 NER的实验结果(表1 - 4)显示我们的模型(Ours)取得了最最优效果,并大幅领先最强的已有模型。同时,建模跨领域的标签依赖关系(CDT)和考虑标签名语义能够稳定地提升模型表现。此外,我们可以看到少样本方法相对传统方法(TransferBERT,Bi-LSTM等)的巨大优势。

表1 1-shot 语义槽标记实验结果

表2 5-shot 语义槽标记实验结果

表3 1-shot NER实验结果

表4 5-shot NER实验结果

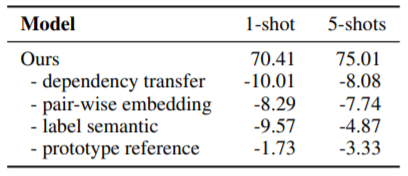

4.3 分析实验

表5展示了模型各模块有效性分析实验室结果。可以看到,我们提出各个模块都不同程度地对最终模型提升贡献了。

表5 消融实验结果

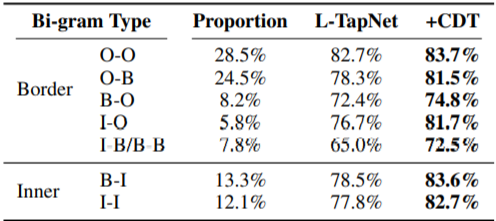

表6展示了错误案例分析结果,根据标签类型,标签转移情况可以分为以下类别:O-O,O-B,B-O,I-O,B-I,I-I和其他。结果展示了模型对不同类型的标签转移情况的准确率。Proportion表示数据集中不同转移情况占的比例。表6的案例分析结果显示,跨领域的标签依赖(CDT)可以有效的提升两类标签预测精度:标签边缘的标签与涉及到标签一致性的标签。

表6 标签准确率案例分析

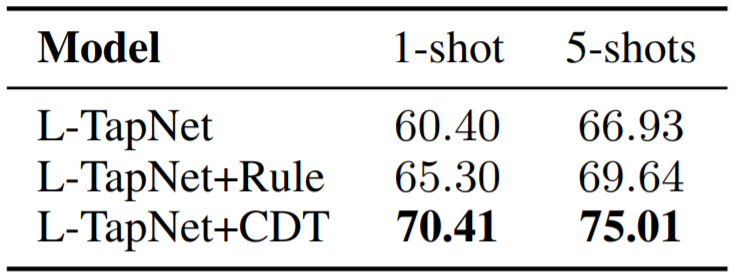

此外,在表七中,我们和标签转移规则进行了比较,发现CDT可以大幅优于传统的基于规则的转移,由此可知迁移标签依赖学到了规则意外的更丰富的知识。

表7 CDT与转移规则的比较

5.结论

本文的主要贡献可归纳如下:

(1)我们提出了一种基于CRF的少样本序列标记框架,它通过整合token相似度和标签依赖关系的先前经验来预测少样本序列标签。

(2)我们引入坍缩依赖迁移(Collapsed Dependency Transfer)来跨标签集、跨领域转移标签依赖性。

(3)我们提出了L-TapNet来得到更好的标签表示建模,从而更准确地预测标签概率。

6.相关链接

讲解视频:

1)12分钟短版(英文):

https://slideslive.com/38929212/exploration-on-fewshot-tagging

2)50分钟细节版(中文):

https://mooc.yanxishe.com/open/course/795

我们组织的小样本评测比赛:

https://smp2020.aconf.cn/smp.html#3

参考文献

[1]OriolVinyals, Charles Blundell, Timothy Lillicrap, Daan Wierstra, et al. 2016.Matching networks for one shot learning. In NIPS, pages 3630–3638.

[2]AliceCoucke, Alaa Saade, Adrien Ball, Theodore ´ Bluche, Alexandre Caulier, DavidLeroy, Clement ´ Doumouro, Thibault Gisselbrecht, Francesco Caltagirone,Thibaut Lavril, Mael Primet, and Joseph ¨ Dureau. 2018. Snips voice platform:an embedded spoken language understanding system for privateby-design voiceinterfaces. CoRR, abs/1805.10190.

[3]ErikF. Tjong Kim Sang and Fien De Meulder. 2003. Introduction to the conll-2003shared task: Language-independent named entity recognition. In Proc. of the CoNLL-HLT-NAACL,pages 142–147.

[4]AmirZeldes. 2017. The gum corpus: creating multilayer resources in the classroom.Language Resources and Evaluation, 51(3):581–612.

[5]LeonDerczynski, Eric Nichols, Marieke van Erp, and Nut Limsopatham. 2017. Resultsof the wnut2017 shared task on novel and emerging entity recognition. In Proc.of the 3rd Workshop on Noisy Usergenerated Text, pages 140–147.

[6]SameerPradhan, Alessandro Moschitti, Nianwen Xue, Hwee Tou Ng, Anders Bjorkelund,Olga Uryupina, ¨ Yuchen Zhang, and Zhi Zhong. 2013. Towards robust linguisticanalysis using ontonotes. In Proc. of the CoNLL, pages 143–152.

本期编辑:冯梓娴

由于微信平台算法改版,公号内容将不再以时间排序展示,如果大家想第一时间看到我们的推送,强烈建议星标我们和给我们多点点【在看】。星标具体步骤为:

(1)点击页面最上方“深度学习自然语言处理”,进入公众号主页。

(2)点击右上角的小点点,在弹出页面点击“设为星标”,就可以啦。

感谢支持,比心

投稿或交流学习,备注:昵称-学校(公司)-方向,进入DL&NLP交流群。

方向有很多:机器学习、深度学习,python,情感分析、意见挖掘、句法分析、机器翻译、人机对话、知识图谱、语音识别等。

记得备注呦

推荐两个专辑给大家:

专辑 | 李宏毅人类语言处理2020笔记

整理不易,还望给个在看!