ICLR 再聚焦“AI炼金术”,不同的是一些解决思路浮出水面

去年 12 月,加州旧金山 Google 分部的 AI 研究人员 Ali Rahimi 在一场 AI 会议的演讲中大力抨击 AI 领域的现状,这个演讲收获了长达 40 秒的掌声。Rahimi 在当时的发言中指出,计算机通过反复试验来学习的机器学习算法已经成为了一种“炼金术”——研究人员不清楚为什么某些算法有效而其他算法不可行,也没有严格的标准来选择模型结构。

在近日于温哥华召开的 International Conference on Learning Representations (ICLR)会议上所发表的论文中,Rahimi 及其合作者举例说明了“AI 炼金术”问题,并提供了一些加强 AI 严谨性的解决办法。

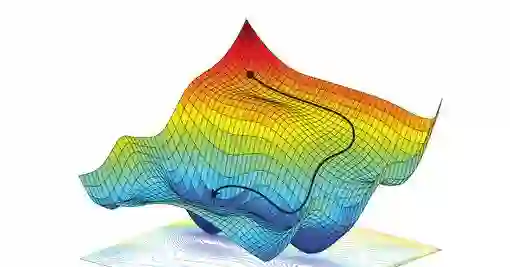

图丨三维图展示“随机梯度下降法(SGD)”通过试错的方式寻找最低点来优化算法的过程

“AI 炼金术”问题与 AI 的可重复性问题截然不同,可重复性问题是指由于实验环境的不一致,研究人员无法复现彼此的结果;它也不同于机器学习中的“黑盒问题”或者叫“可解释性问题”,即难以解释 AI 模型是如何有效工作的。正如 Rahimi 所说,“机器学习模型是一个黑盒子,和整个 AI 领域的研究都变成了黑盒子,这是两个完全不同的概念。”

他还表示,如果不能深入理解搭建和训练模型所用到的基本工具,AI 研究人员就像中世纪的炼金术士——不过是依赖于道听途说的传闻罢了。

加州山景城的 Google 计算机科学家 François Chollet 补充道,“人们很容易陷入‘舶来品崇拜’(看见外来的先进科技物品,便会将之当作神祇般崇拜)”。例如,调整 AI 模型学习率的方法,他们只会使用它却不理解为什么这个方法就比别的好。再比如 AI 研究人员训练模型的过程,就像在黑暗中前行。他们实现了所谓的“随机梯度下降法(SGD)”,来优化模型参数以尽可能降低错误率。然而,尽管有数千篇关于这一课题的学术论文以及应用该方法的无数方式,但这个方法的验证仍是依赖于试验所得。

Rahimi 的这篇论文强调了一些算法中的不必要设计以及其可能导致次优表现这一现象。比如,一个新的机器翻译模型在被去除掉一些复杂部分之后取得了更好的翻译效果,这就说明模型的原始设计者并没有完全理解那些多余部分。而伦敦 Twitter 的机器学习研究人员 Ferenc Huszár 也指出,有的时候又是完全相反的情况——一个算法的精华部分就在于那些小的看似多余的设计,而还有的情况是,一个算法本身在技术上是有缺陷的,可却能因为上层调用的小技巧而表现出色。

Rahimi 还提供了一些建议,用于深入分析哪种算法效果最好、什么时候效果最好这些问题。他说,研究人员应该像之前提到的翻译算法那样进行“消融研究”——一次删除一部分算法,以查看每个部分的功能。他还呼吁进行“切片分析”,仔细分析算法某些部分的改进可能会在其他什么地方牺牲性能。另外,研究人员应该在不同条件下测试他们的算法,并且报告所有的性能。

加州大学伯克利分校的计算机科学家 Ben Recht 也是 Rahimi 的炼金术主题演讲的合作者,他说人工智能研究需要借鉴物理学研究方法——将问题缩小成更小的问题。“物理学家很擅长设计简单的实验以剖开现象、解释本质”,他说道。一些 AI 研究人员已经开始采用这种方法,比如在处理大量彩色照片之前,先在小的黑白手写字符图片上测试图像识别算法,以便更好地理解算法的内部机制。

伦敦 DeepMind 的计算机科学家 Csaba Szepesvári 说,该领域也需要减少对比赛结果的重视。他说,比起解释算法内在原理的论文,测试结果超越了当时基准模型的论文,更可能被发表。各种“造型奇特“的翻译算法正是这样通过同行评审的。“科学的目的是产生知识,”他说,“应该去创造一些其他人可以采用并继续开拓发展的东西。”

但也并不是每个人都同意 Rahimi 和 Recht 对 AI 领域的批判。Facebook 的首席人工智能科学家 Yann LeCun 担心,将过多技术尝试上的努力转移到算法理解上可能会减缓创新速度并阻碍人工智能的实际应用。“这不是炼金术,而是工程学,并且,工程本来就是混乱的。”

Recht 强调了系统性研究和探索性研究的同等重要性。“这两个方向我们都需要,”他说,“我们需要搞清楚哪些地方有弊端,以便能够建立可靠的系统;我们也必须推进前沿工作的探索,实现飞跃。”

-End-