提到强化学习只知道AlphaGo?其实,RL在工业界还有这些应用

原作 Ben Lorica

唐旭 编译自 Oreilly

量子位 出品 | 公众号 QbitAI

关于作者:

Ben Lorica,O’Reilly Media的首席数据科学家,同时是Strata Data Conference和O’Reilly Artificial Intelligence Conference的项目主任。

AlphaGo Zero的出现让人们再次提起了对强化学习的兴趣。紧随深度学习之后,强化学习成为了目前AI领域最热门的话题。

大部分公司对强化学习这个事做了调查和评估,然而很少有人真正搞明白它究竟能做什么。

考虑到RL的概念现在已经被混淆进了一大坨乱七八糟的问题和技术里,我们有必要先给它下个定义。

一般而言,RL的目标是学会如何将观测结果和测量值映射到一系列行为,同时最大化长期奖励。这个概念通常将那些“智能体与环境进行交互并学会最佳决策序列”的应用包括在内。

事实上,很多RL的最初应用都处于那些长期在寻求自动化序列决策的领域。

有别于传统的在线学习(online learning)——你经常得到这样的组合:延迟的反馈、稀少的奖励,以及会在交互时对环境造成影响的智能体——RL提出了一系列全然不同的挑战。

DL已经被许多公司用到了各种各样的应用上,与之相比RL的应用领域还相对有限,而我们想给它来个盘点。

在我开始之前,我想先谈谈RL在实际中遇到的一些难处。

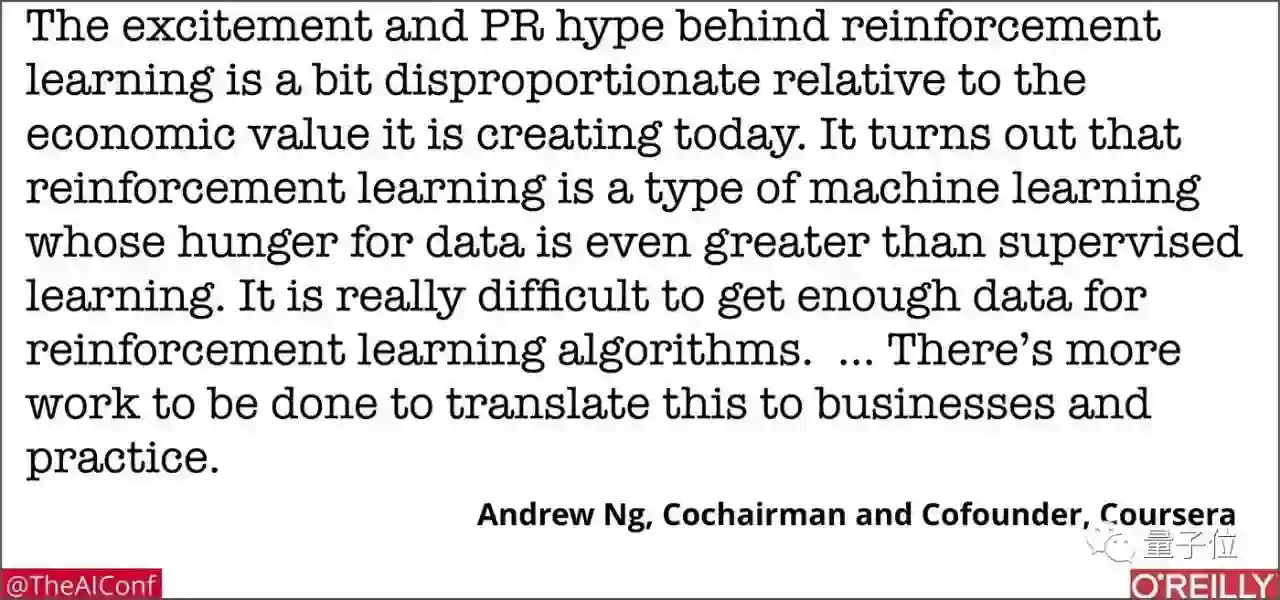

正如吴恩达在旧金山AI大会上的主旨发言中所说,RL需要大量的数据,与此同时,需要与那些能够获取模拟数据的领域(比如游戏和机器人)建立联系。

从论文中汲取养分并将它们应用于实际同样不易:即便是对于RL的研究者而言,要重复研究结果依然十分困难,更别说是一般的数据科学家了;而随着机器学习被部署到关键性的任务中,可重复性以及预估错误的能力就变得不可或缺。

因此,至少就现在而言,对于需要持续控制的关键任务应用而言,RL可能并不是理想选择。

尽管如此,还是有不少有趣的应用和产品要依赖于RL。由RL帮忙实现的序列决策自动化能给包括个性化、明确界定任务自动化在内的许多设置带来益处。

对于公司而言,他们的首要任务就是搞定复合这些描述的简单案例,而不是去纠结那些过于复杂、“需要AI”的大坑。

好了,下面我就把这些RL开始出现的关键领域给你高亮。

机器人和工业自动化

RL在高维控制问题中的应用,比如机器人,已经成为学术和工业界的一大研究主题。与此同时,一些创业公司也开始用RL为工业机器人来打造产品。

工业自动化则是另一个前景不错的领域。

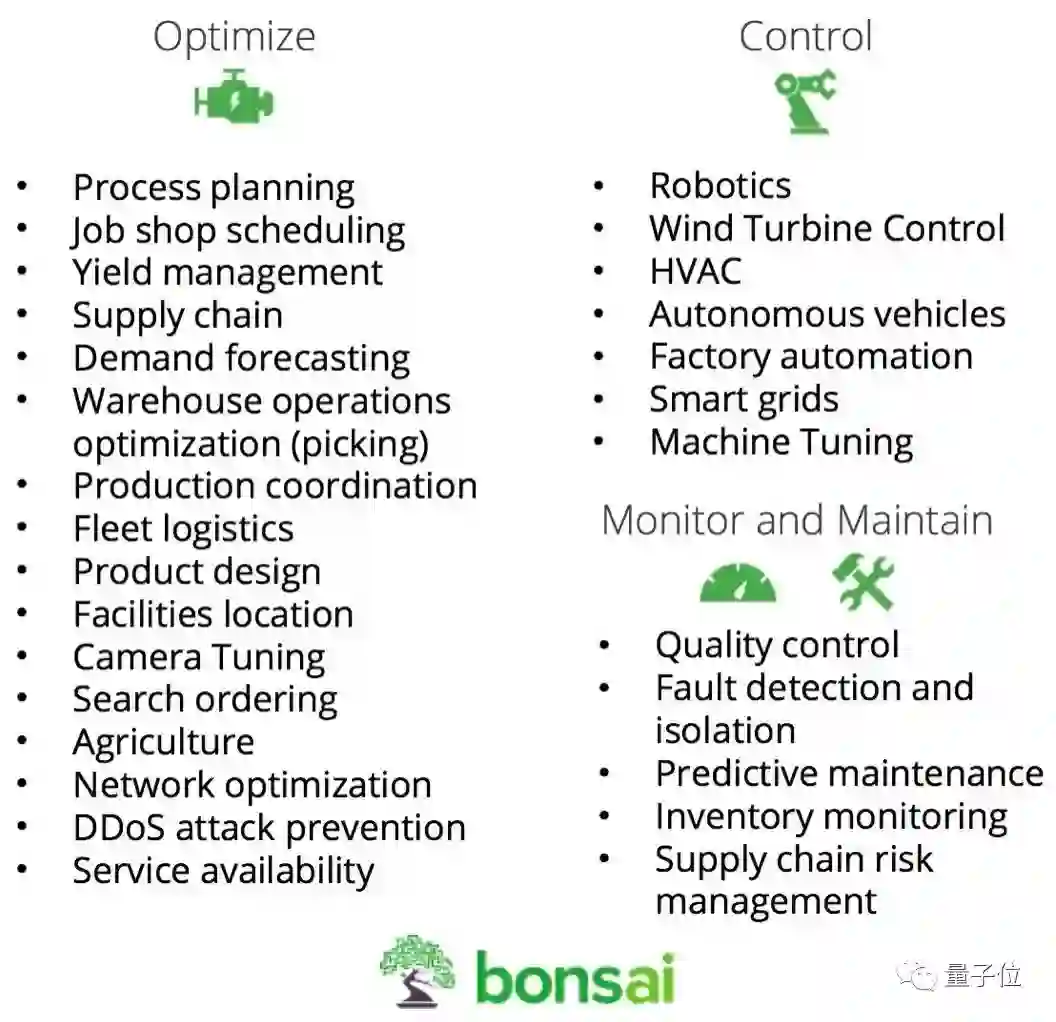

目前看来,DeepMInd提供的RL技术帮助谷歌显著地降低了自己数据中心的能源消耗。创业公司们已经意识到在自动化解决方案领域中存在着一个巨大的市场,有几家创业公司正在为一些公司制作能让后者将RL和其他技术用进工业应用的工具,Bonsai就是其中之一。一个例子是调试机器和设备,而这一领域目前被人类专家所垄断。

对照工业系统,Bonsai最近列出了如下几个“考虑下RL没亏吃”的标准:

1. 你在进行模拟,因为要教会机器通过试验、避开错误,你的系统和过程太复杂了。

2. 你正在处理大型状态空间。

3. 你希望为人类分析师和领域专家提供操作效率优化和决策支持。

数据科学和机器学习

使用机器学习库正在变得更容易,不过对于数据科学家而言,选择一个合适的模型或模型架构依然有点难度。

随着深度学习更多地为数据科学家和机器学习工程师所用,能帮助人们搭建、调整神经网络架构的工具已经成了热门研究领域。

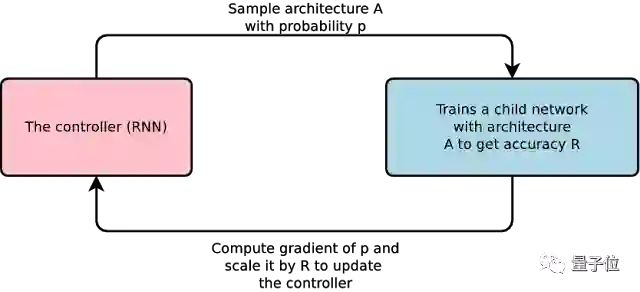

有几组研究人员提出了利用RL来让设计神经网络架构的过程更为开放。谷歌的AutoML使用RL来为计算机视觉和语言建模创造最先进的机器生成神经网络架构。

△ AutoML相关论文

https://arxiv.org/abs/1611.01578

除了能够简化机器学习的生成过程,一些人认为RL将能够帮助软件工程师编写计算机程序。

教育和培训

在线平台已经在进行利用机器学习来打造个性化体验的试验。有几位研究者正在研究RL和其他机器学习方法在辅导系统和个性化学习中的应用。

RL的使用将促成全新培训系统的出现,系统将能够根据学生需求来对指导和材料进行调整。有一组研究者正在开发RL算法和统计学方法,以降低未来辅导系统的数据需求。

医疗健康

RL中与环境进行交互并根据行为回收反馈的智能体设置与医药科学中治疗方案的学习问题存在很多类似之处。

事实上,许多医疗保健领域的RL应用就是为了寻找最佳治疗方案。最近有几篇论文,研究了强化学习在医疗器械、药物剂量和两阶段临床试验中的应用,例如:

A Reinforcement Learning Approach to Weaning of Mechanical Ventilation in Intensive Care Units

https://arxiv.org/abs/1704.06300

Optimal medication dosing from suboptimal clinical examples: a deep reinforcement learning approach

https://www.ncbi.nlm.nih.gov/pubmed/28268938

Informing sequential clinical decision-making through reinforcement learning: an empirical study

http://pubmedcentralcanada.ca/pmcc/articles/PMC3143507/

文本、语音和对话系统

好的非结构化文本解锁工具总是不会缺少买家。

今年早些时候,SalesForce的AI研究者们把深度RL用在了在提取文本摘要(从原始文本文档中抽象出的内容中自动生成摘要的技术)上。现在许多公司都在寻找更好的文本挖掘解决方案,RL在这一领域估计要吸一大批粉。

RL还让对话式系统(比如聊天机器人)从用户的交互行为中学习,从而随着时间而不断提升(许多商业化的聊天机器人现在用的是决策树)。

媒体和广告

微软最近公布了一套可在Azure上获取的、名为“决策服务”的内部系统。他们的论文介绍了“决策服务”在内容推荐和广告上的应用。更普遍点说,“决策服务”面向的是那些遭遇了“反馈循环和偏见、分散的数据收集、环境的变化、弱爆了的监测和故障排除”等失败模式的机器学习产品。

其他RL应用还包括跨渠道营销优化和在线广告展示的实时竞价系统。

金融

这块稍微有点尴尬。作为一名曾经的数据分析师,我遇到过不少对DL和RL进行过评估的交易者和分析师,但是除了小的指引,很少有人把这些工具用到以外的地方。关于这方面的论文是不少,但很少有公司真正去做这类软件。

不过有一个例外:摩根大通的一套用于交易执行的系统。依托于RL,这套系统被用于以可能的最快速度和最佳价格来执行交易。

像所有其他的新技术一样,使用RL的关键在于理解它的优势和弱点,然后找到简单的应用案例来尝试它。别被那些铺天盖地的AI宣传弄花了眼,你应该把RL看作一种有用的机器学习技术,尽管它只是对某些特定的问题有效。

原文:https://www.oreilly.com/ideas/practical-applications-of-reinforcement-learning-in-industry?imm_mid=0f9d5c&cmp=em-data-na-na-newsltr_ai_20171218

— 完 —

活动报名

加入社群

量子位AI社群12群开始招募啦,欢迎对AI感兴趣的同学,加小助手微信qbitbot4入群;

此外,量子位专业细分群(自动驾驶、CV、NLP、机器学习等)正在招募,面向正在从事相关领域的工程师及研究人员。

进群请加小助手微信号qbitbot4,并务必备注相应群的关键词~通过审核后我们将邀请进群。(专业群审核较严,敬请谅解)

诚挚招聘

量子位正在招募编辑/记者,工作地点在北京中关村。期待有才气、有热情的同学加入我们!相关细节,请在量子位公众号(QbitAI)对话界面,回复“招聘”两个字。

量子位 QbitAI · 头条号签约作者

վ'ᴗ' ի 追踪AI技术和产品新动态