【泡泡图灵智库】基于视觉的多模态多任务的端到端的无人车控制方法(arXiv)

泡泡图灵智库,带你精读机器人顶级会议文章

标题:End-to-end Multi-Modal Multi-Task Vehicle Control for Self-Driving Cars with Visual Perceptions

作者:Zhengyuan Yang, Yixuan Zhang, Jerry Yu, Junjie Cai and Jiebo Luo

来源:arXiv 2018

编译:杨小育

审核:皮燕燕

欢迎个人转发朋友圈;其他机构或自媒体如需转载,后台留言申请授权

摘要

大家好,今天为大家带来的文章是——基于视觉的多模态多任务的端到端的无人车控制方法,该文章发表于arXiv 2018。

卷积神经网络(CNN)已经成功地应用于自动驾驶任务,来实现端到端的车辆控制。先前的端对端转向控制方法采用图像或图像序列作为输入,并直接用CNN预测转向角。尽管CNN可以很好的实现转向角控制,但仅控制转向角并不足以实现对车辆的控制。在这项工作中,我们提出了一个多任务学习框架,以端到端的方式同时预测转向角和汽车速度。仅通过视觉输入来实现车速的精确预测具有重要的意义,作者提出一种深度神经网络结构来预测离散速度指令和转向角。此外,还提出了一种多模态多任务网络,通过将先前的反馈速度和图像信息作为输入来预测速度值和转向角。在公共Udacity数据集和新收集的SAIC数据集上进行实验。结果表明,文章中所提出的模型准确地预测了转向角和速度值。此外,我们改进了数据集的合成方法,以解决实际道路测试中的误差累积问题。

主要贡献

1、提出了一种多模态多任务网络,用于端到端的转向角和速度预测。

2、建立了一个新的SAIC数据集,其中包含白天和晚上的驾驶记录。

3 、改进了故障案例数据的合成方法,以解决实车测试中的误差累积问题。

算法流程

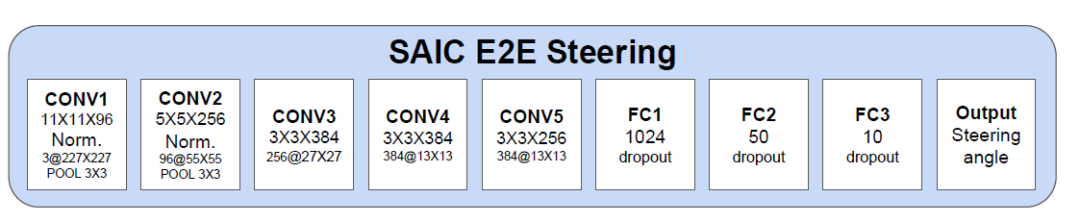

图 1 基础转向角预测模型

图 2 改进的速度和转向角预测模型

卷积层具有与基础转向模型中结构相同,被编码的视觉特征被馈送到LSTM层用于时间维度上的分析,进而输出图像序列特征用于转向角回归和速度指令分类。作为第一步,速度指令包含三个类:“加速”,“减速”和“保持速度”。其中,作者使用交叉熵进行速度指令的分类。

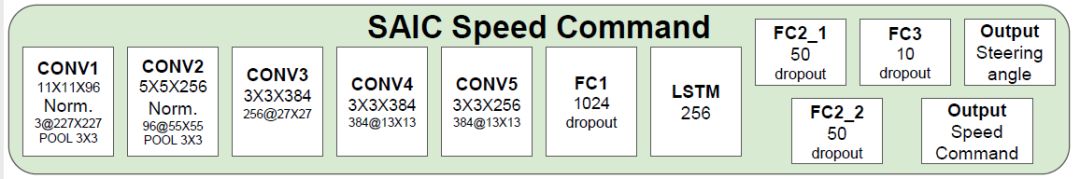

图 3 多模态多任务预测模型

主要结果

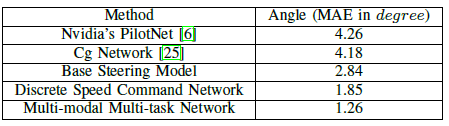

图4 不同方法在Udacity数据集上的转向角预测结果

图 5 多模态多任务网络在Udacity数据集和SAIC数据集上的速度预测结果

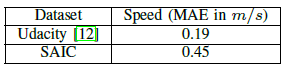

图 6 多模态多任务网络在Udacity数据集上的转向角预测结果

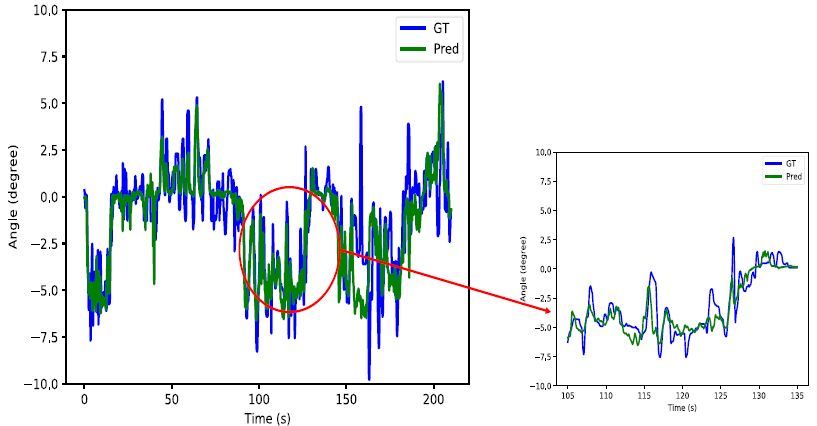

图 7 多模态多任务网络在Udacity数据集上的速度预测结果

Abstract

Convolutional Neural Networks (CNN) have been successfully applied to autonomous driving tasks, many in an end-to-end manner. Previous end-to-end steering control methods take an image or an image sequence as the input and directly predict the steering angle with CNN. Although single task learning on steering angles has reported good performances, the steering angle alone is not sufficient for vehicle control. In this work, we propose a multi-task learning framework to predict the steering angle and speed control simultaneously in an end-to-end manner. Since it is nontrivial to predict accurate speed values with only visual inputs, we first propose a network to predict discrete speed commands and steering angles with image sequences. Moreover, we propose a multi-modal multi-task network to predict speed values and steering angles by taking previous feedback speeds and visual recordings as inputs. Experiments are conducted on the public Udacity dataset and a newly collected SAIC dataset. Results show that the proposed model predicts steering angles and speed values accurately. Furthermore, we improve the failure data synthesis methods to solve the problem of error accumulation in real road tests.

如果你对本文感兴趣,想要下载完整文章进行阅读,可以关注【泡泡机器人SLAM】公众号。

点击阅读原文,即可获取本文下载链接。

欢迎来到泡泡论坛,这里有大牛为你解答关于SLAM的任何疑惑。

有想问的问题,或者想刷帖回答问题,泡泡论坛欢迎你!

泡泡网站:www.paopaorobot.org

泡泡论坛:http://paopaorobot.org/bbs/

泡泡机器人SLAM的原创内容均由泡泡机器人的成员花费大量心血制作而成,希望大家珍惜我们的劳动成果,转载请务必注明出自【泡泡机器人SLAM】微信公众号,否则侵权必究!同时,我们也欢迎各位转载到自己的朋友圈,让更多的人能进入到SLAM这个领域中,让我们共同为推进中国的SLAM事业而努力!

商业合作及转载请联系liufuqiang_robot@hotmail.com