学界 | 斯坦福论文:马尔可夫链的生成对抗式学习

论文地址:https://openreview.net/pdf?id=S1L-hCNtl

摘要:我们研究了生成对抗的训练方法来对马尔可夫链(Markov chain)的转移算子(transition operator)进行学习,目的是将其静态分布(stationary distribution)和目标数据分布相匹配。我们提出了一种新型的训练流程,以避免从静态分布中直接采样,但是仍然有能力逐渐达到目标分布。此模型可以从随机噪声开始,是无似然性的,并且能够在单步运行期间生成多个不同的样本。初步试验结果显示,当它临近其静态时,马尔可夫链可以生成高质量样本,即使是对于传统生成对抗网络相关理念中的较小结构亦是如此。

1 引言(略)

2 问题预设

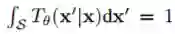

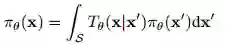

设 S 为随机变量

因此,在 X 的范围内每一个 Tθ都定义一个时间同质的马尔可夫链。我们把

假设在我们可以得到的样本中有一个未知分布 pd(x),比如,数据分布。我们的目的有二:找到一个 θ 使

πθ 接近 Pd(x);

对应的马尔科夫链快速收敛。

3 马尔可夫链的对抗性训练

对于任意θ,即使πθ因为唯一的静态分布而存在,大多数情况下直接计算 x 分布的实际似然度仍然是十分困难的。然而,从

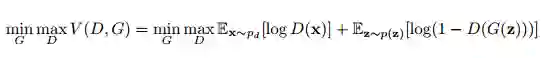

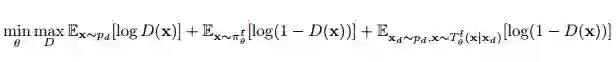

生成对抗网络(GAN)(Goodfellow et al., 2014)是采用两个参与者极小极大博弈来训练深度生成模型的框架。GAN 训练一个生成器网络 G 以转换噪声变量 z ∼ p(z) 为 G(z) 而生成样本。而辨别器网络 D(x) 则区分样本是来自生成器还是来自给定数据分布 pd 的真实样本。该关系可正式表述为以下关系式:

在我们的预设中,我们选择 z ∼ π 0,并令 Gθ(z) 为 t 步后的马尔可夫链状态,如果 t 足够大的话,那么 Gθ(z) 就是πθ良好的近似值。然而,我们遇到了优化方面的问题,因为需要求沿整条马尔可夫链反向传播的梯度,这就导致了梯度更新极其昂贵,即因为梯度估计量的大方差而降低的收敛速度。因此,我们提出了更加高效的近似方法,该方法可由以下目标函数表达:

其中

1. 样本在 t¯步时,给定起始样本 x0 ∼ π 0。

2. 样本在 tˆ步时,给定一个带小量随机扰动的数据样本 x ∼ pd。

直观讲,第一个条件鼓励马尔可夫链在(长度 t 的)相对短的运行中向 pd 收敛。我们只考虑这一需求,这个方法将对应于一个潜层变量模型的原始采样,就像 Sohl-Dickstein et al. (2015)、Salimans et al. (2015) 和 Bordes et al. (2017) 的情况。然而,相比于这些模型,我们的目标是训练一个迭代步骤,其中样本的质量通过增加模拟步的数量而获得提升。并且在链的 burn-in 期后,可廉价生成多个样本。这种完成需要第二个条件,它迫使收敛变成静态,其中 pd 的每个点转化至数据流形中的另一个点。

在静态分布中,等式 3 中的目标比 等式 2 优化起来更简单。通过利用带有更低方差的评估梯度,平均上,生成器将只运行 (t¯ + tˆ)/2 步,而不是从链中取样直至收敛,如果最初的马尔可夫链的混合需要多步操作,这将极其费时。

4 实验

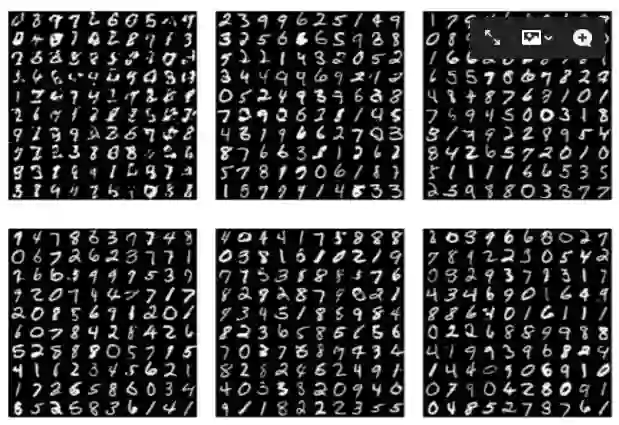

图 1. 马尔可夫链和 mlp 架构的例子。从左上到右下,每个小图都分别进行了π 1 θ、 π 2 θ、π 5 θ、π 10 θ、π 20 θ、π 50 θ采样。该图通过初始 x0 的采样,100 批的数据样本生成的,迁跃算符重复使用。

我们在 MNIST 数据集上训练了这个模型,其目标是将数据生成分布与πθ相匹配,研究人员倾向于使用简单迁跃算符来匹配复杂分布。研究人员考虑了三种迁跃算符架构 Tθ(·|x)。每个都有一个对称的编码器-解码器结构,高斯噪声被加入了隐代码中,解码器架构分别为:

DCGAN(Radford 等人,2015)所用的生成网络架构,其中包含两个全连接层,随后是两个转置卷积。该模型强大到足以在一个步长中生成清晰图像。

弱化的 DCGAN,一个全连接层和一个转置卷积层(conv)。

两个全连接层组成的 MLP,它是最弱的模型(mlp)。

本文转自机器之心,点击此处阅读原文

PS. 如有想加入极市专业CV开发者微信群,请填写申请表(链接:http://cn.mikecrm.com/wcotd9)申请入群~