7 Papers & Radios | 中国首次实现量子优越性;华为诺亚等预训练图像处理Transformer

机器之心 & ArXiv Weekly Radiostation

参与:杜伟、楚航、罗若天

本周的重要研究包括首次实现中国量子优越性的量子计算原型机「九章」以及华为诺亚、北京大学等联合提出的预训练图像处理 Transformer。

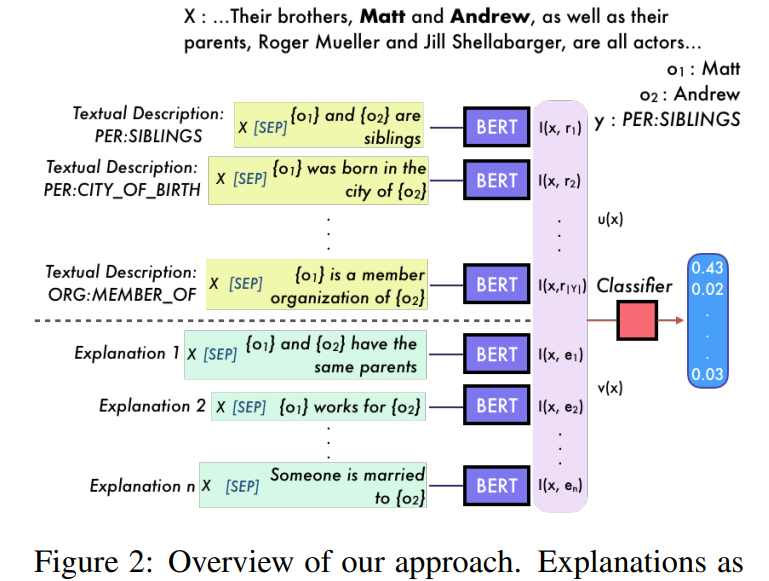

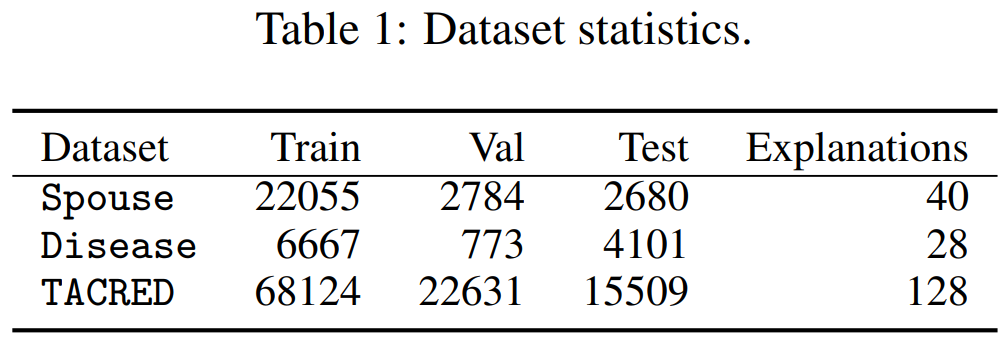

ExpBERT: Representation Engineering with Natural Language Explanations

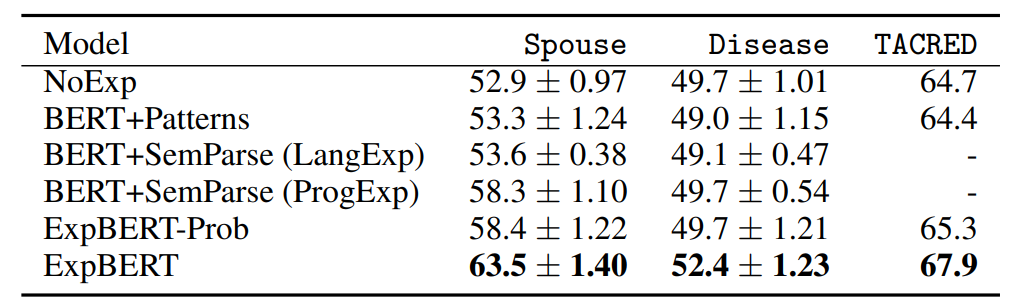

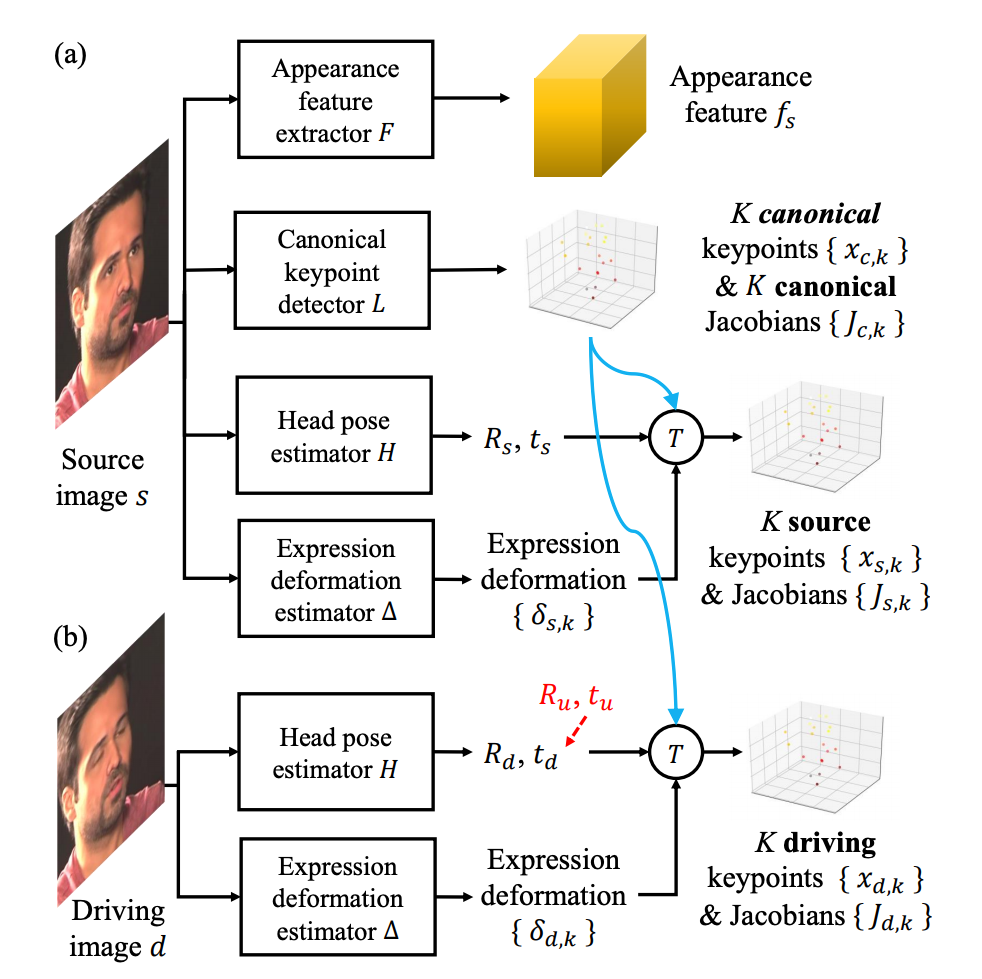

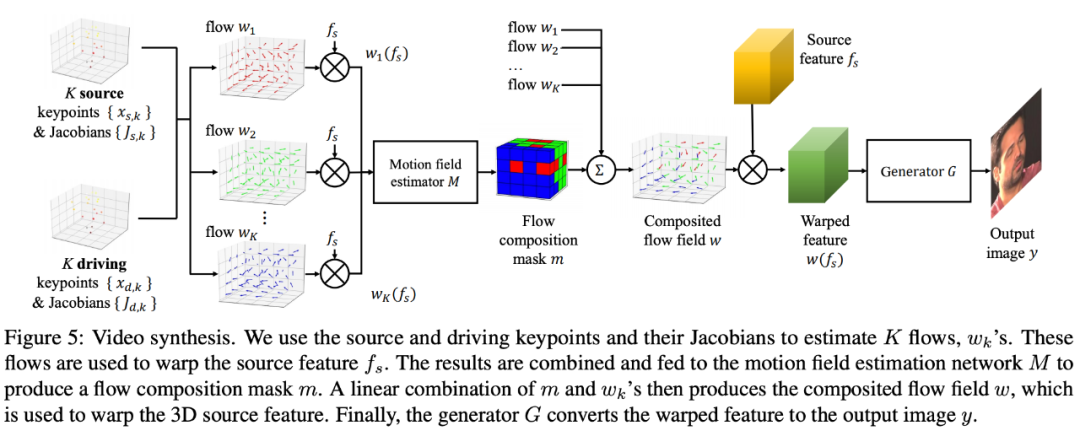

One-Shot Free-View Neural Talking-Head Synthesis for Video Conferencing

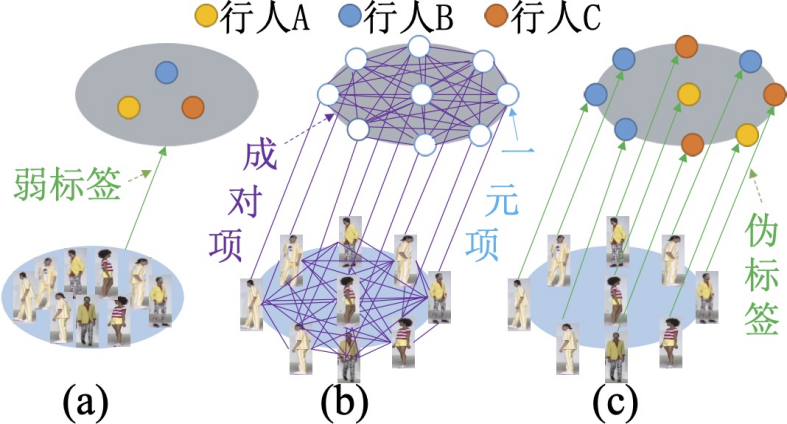

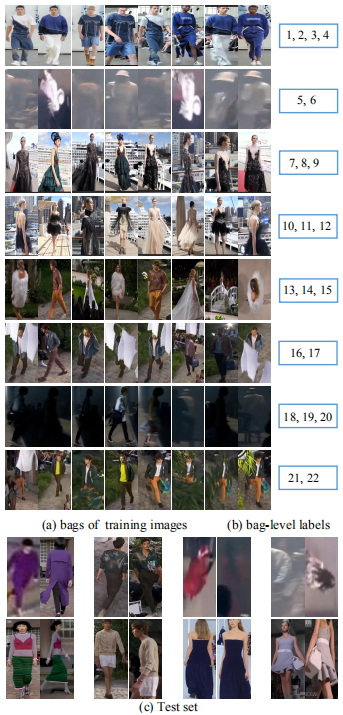

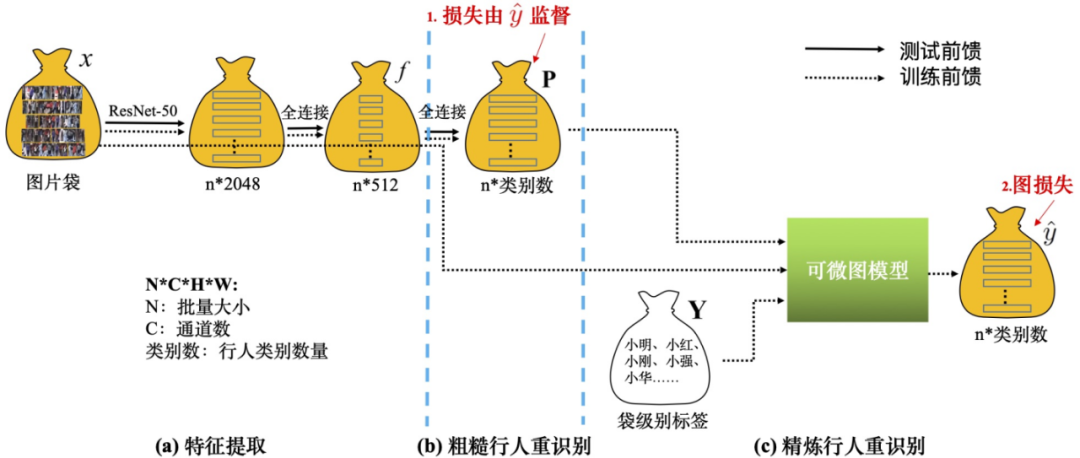

Weakly Supervised Person Re-ID: Differentiable Graphical Learning and A New Benchmark

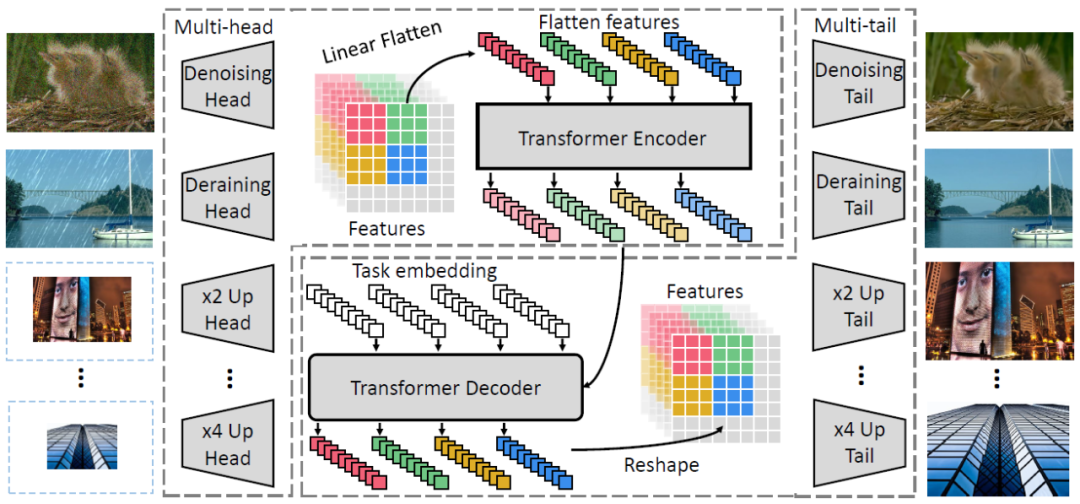

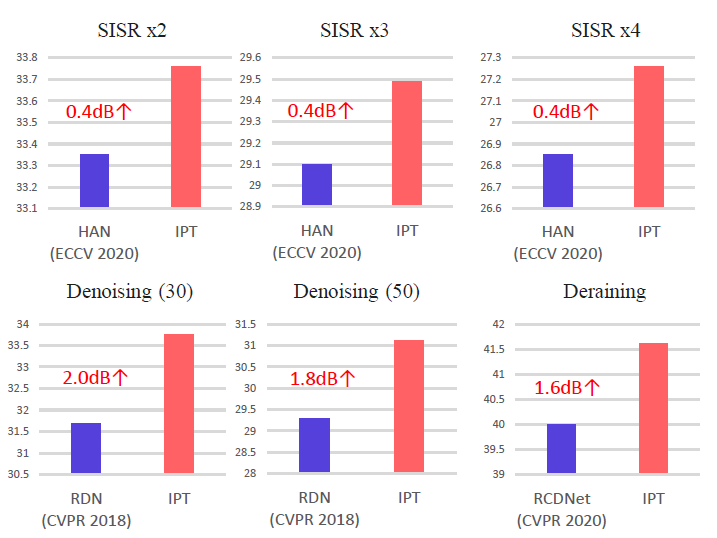

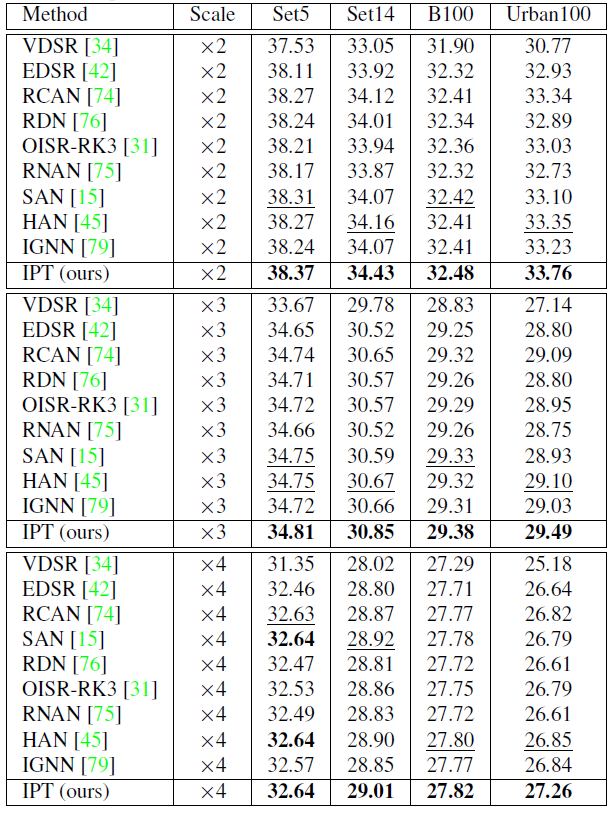

Pre-Trained Image Processing Transformer

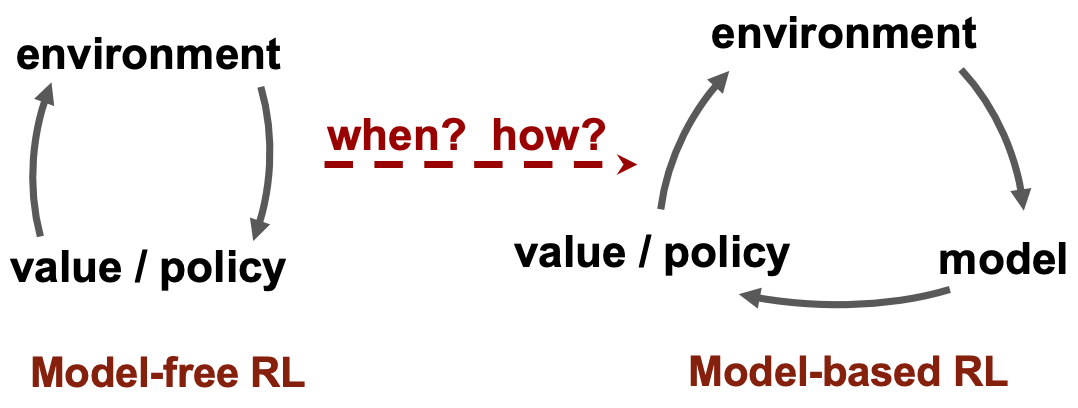

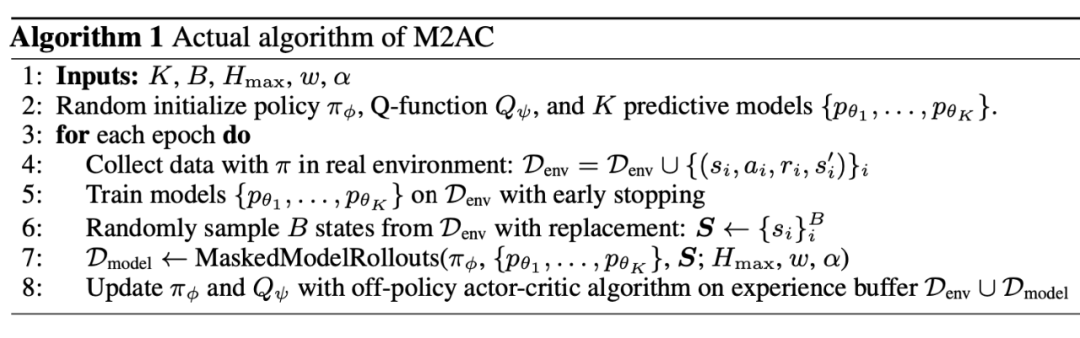

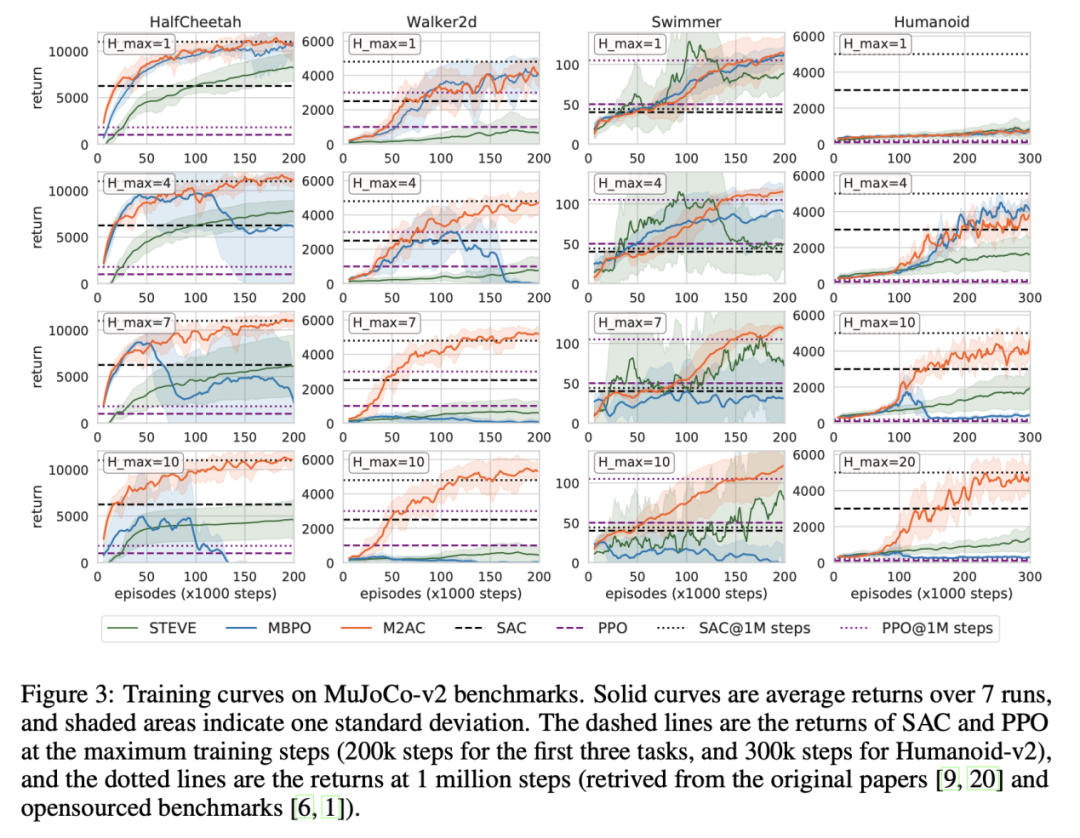

Trust the Model When It Is Confident: Masked Model-based Actor-Critic

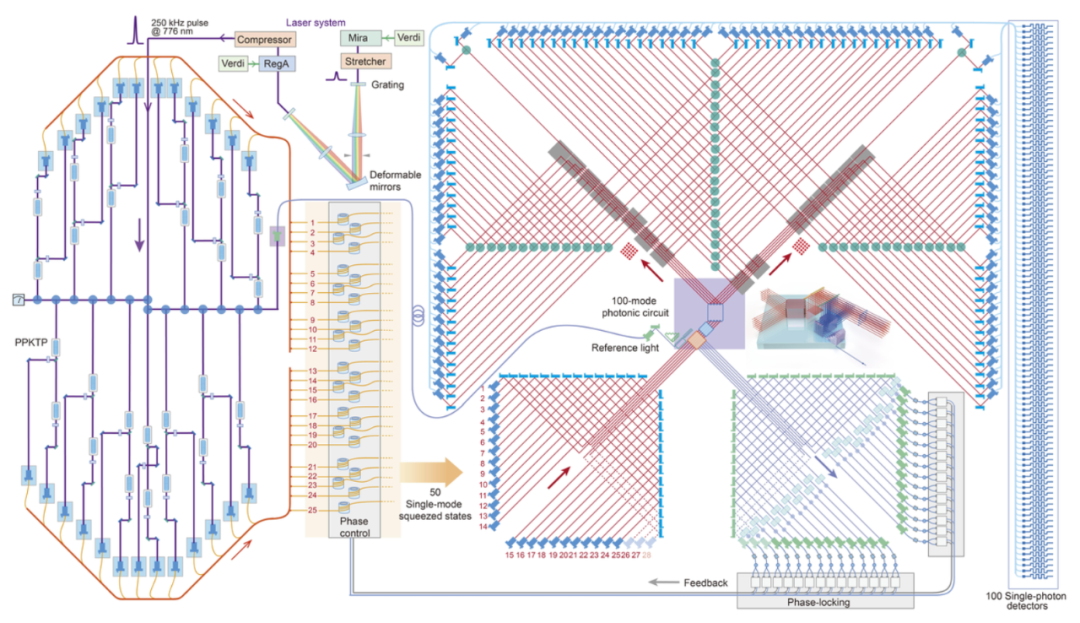

Quantum Computational Advantage using Photons

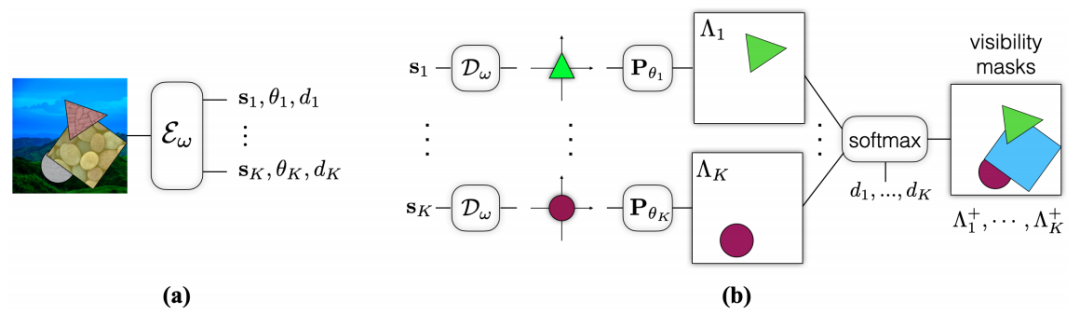

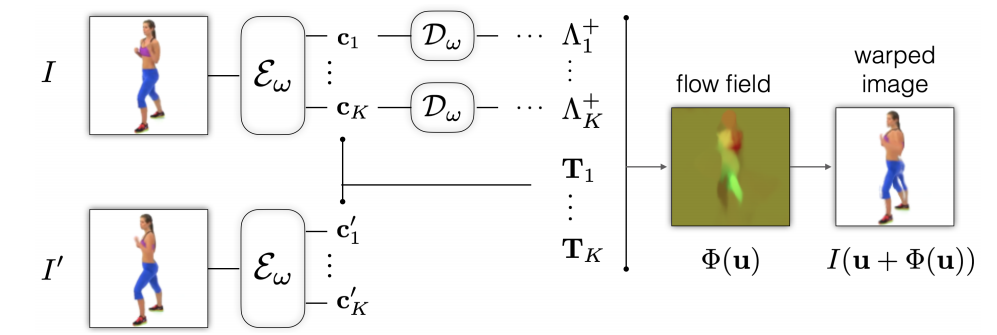

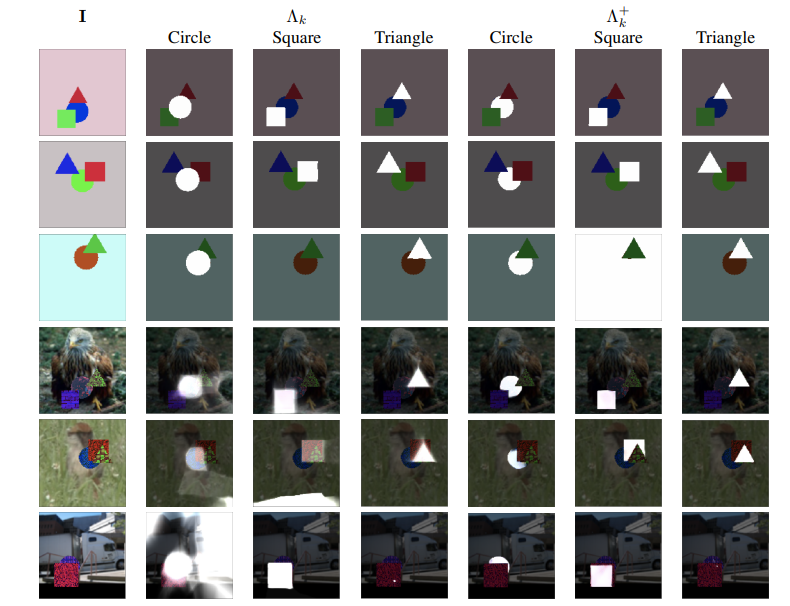

Unsupervised part representation by Flow Capsules

ArXiv Weekly Radiostation:NLP、CV、ML 更多精选论文(附音频)

作者:Shikhar Murty、Pang Wei Koh、Percy Liang

论文链接:https://arxiv.org/abs/2005.01932

作者:Ting-Chun Wang、Arun Mallya、Ming-Yu Liu

论文链接:https://arxiv.org/pdf/2011.15126.pdf

SYSU-30k 数据集样例。

整体框架图。

作者:Hanting Chen、Yunhe Wang、Tianyu Guo 等

论文链接:https://arxiv.org/pdf/2012.00364.pdf

作者:Feiyang Pan、Jia He、Dandan Tu、Qing He

论文链接:https://papers.nips.cc/paper/2020/file/77133be2e96a577bd4794928976d2ae2-Paper.pdf

作者:Han-Sen Zhong、Hui Wang、Yu-Hao Deng

论文链接:https://science.sciencemag.org/content/early/2020/12/02/science.abe8770

作者:Sara Sabour、Andrea Tagliasacchi、Soroosh Yazdani、Geoffrey E. Hinton、David J. Fleet

论文链接:https://arxiv.org/pdf/2011.13920.pdf