论文浅尝 - ICLR2020 | 具有通用视觉表示的神经机器翻译

论文笔记整理:柏超宇,东南大学在读硕士。

来源:ICLR2020 https://openreview.net/forum?id=Byl8hhNYPS

代码链接:https://github.com/cooelf/UVR-NMT

简介和动机

近年来,不少工作已经证明了视觉信息在机器翻译(NMT)这个任务上面是帮助的,但是这种模型存在着不少的限制,视觉信息仅仅用于小型的多模态数据集,而不能应用于大规模纯文本数据集上面,并且是制作训练集的成本较高,一幅图片要配上两种语言的平行句子对,当前多模态机器翻译模型无法充分利用视觉信息。

在这篇文章中作者提出了一种仅依靠在单语文本中将图像信息作为客观信息融入进来,而不是现有的依靠图像双语标注方法,从而突破了在NMT中使用视觉信息的瓶颈,并在多个数据集上取得了提升。

模型方法

模型先基于多模态数据集Multi30K制作了一个主题-图像查找表,在训练和解码的过程中,计算每个词的TF-IDF,从主题-图像查找表中检索出与源句子具有相似主题的一组图像。然后设计了一个简单的注意力层,将图像表示和原始源句表示融合在一起,作为对解码器的输入,以预测目标翻译。这种方法可以容易地应用到纯文本的NMT模型中,而无需标注大规模的双语并行语料库。

在获得主题-图像查找表后,模型可以对纯文本数据集进行翻译,对于输入进来的句子,模型仍然会执行上面相似的操作①去除句子中停用词②计算每个词的TF-IDF③取k个TF-IDF值最高的词④在主题-图片查询表中找到k个词对应的图片⑤取出出现次数最多的m张图片,这个图片集合可以和文本输入一起送入后续的网络,增强翻译的效果。

后面的任务可以看作是一个seq2seq模型,即将文本序列和图片序列进行编码融合,随后解码出另一种语言的序列。

在文本的encoder和decoder阶段作者使用了流行的Transformer模型,而在融合阶段有所创新使用了一个单层的attention来完成文本embeeding和图片特征向量之间的融合,将文本表示向量作为Q输入进了图片的attention层中。

由于机器翻译任务最终需要生成的是另一种语言的文本序列,图像只是起辅助作用,所以需要调整下两个模态信息的权重。最终得到的H向量即可送入解码器进行解码。

数据集和实验

我们在三个数据集上进行实验:WMT16 En-RO, WMT14 EN-DE和WMT14 EN-FR。这三个数据集大小从小到大增加,从而在不同大小的数据集上都能验证该方法。加上视觉特征后,翻译效果都有了不错的提升。更重要的是,由于视觉模块只加了一层的attention层,所以加上视觉特征后参数量没有显著增加,训练和推理的时间也不会长很多,

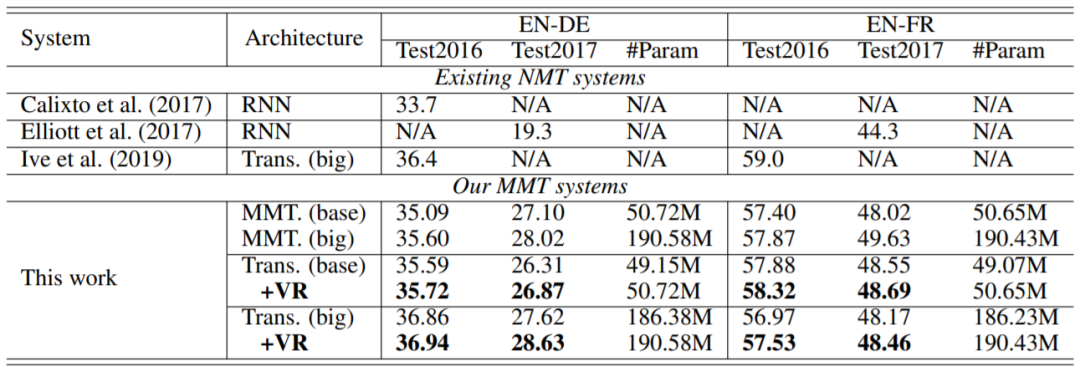

而在Multi30K这个多模态数据集上面,该模型也能取得不错的效果,比起传统的多模态方法在一些指标上面也能有所提升。

同时作者也对融合权重λ和每个句子配合的图片数量进行了研究,手动去设置权重的话是很难得到一个平衡两个模态信息的值,而像这个模型中采用了自动计算的方法所得到的结果始终优于手动设置的值。同时,为单个句子配上过多的图片也会让模型产生困惑,需要在保证信息充足的情况下减少噪声的引入。

这个工作突破了原有机器翻译依赖双语视觉标注的限制,能将训练好的模型应用在纯文本的数据集上并取得不错的效果。

模型没有过多的增加Transformer的复杂度,可能将中间的层换成VL-BERT这样的包含更多背景知识的模型会得到更好的效果。但肯定会大大提升模型复杂度。希望感兴趣的同学一起阅读原文。

OpenKG

开放知识图谱(简称 OpenKG)旨在促进中文知识图谱数据的开放与互联,促进知识图谱和语义技术的普及和广泛应用。

点击阅读原文,进入 OpenKG 博客。