苹果连发三篇机器学习新研究:全是讲如何让Siri更厉害

安妮 编译整理

量子位 出品 | 公众号 QbitAI

Siri的本领升级了。

苹果上月推出的机器学习博客今天连更3篇新文,全部是有关Siri的研究技术。

三篇讲了啥?

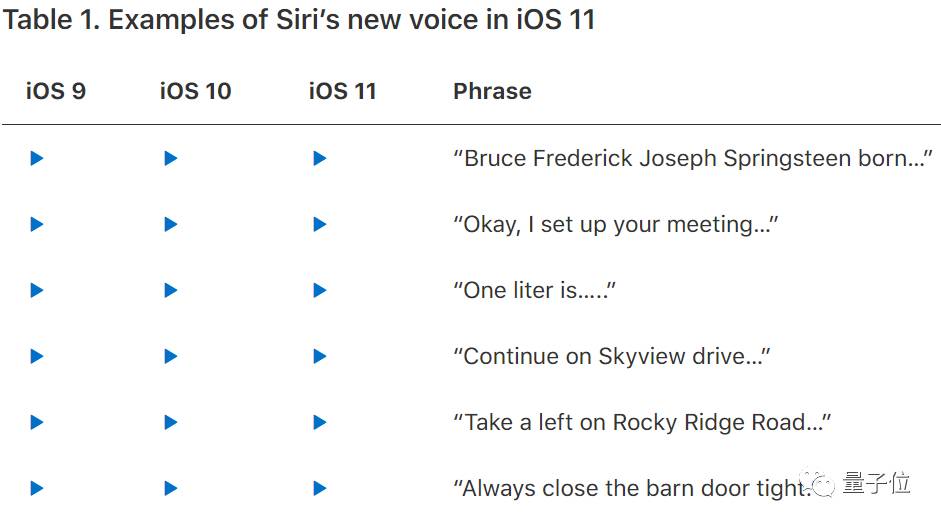

在这篇题为《Deep Learning for Siri’s Voice: On-device Deep Mixture Density Networks for Hybrid Unit Selection Synthesis》的文章中,苹果介绍了Siri语音合成技术的演变过程,并对比从iOS 9到即将应用在新版本中iOS 11的声音变化,详细说明Siri的进化过程。

另外两篇分别题为《Improving Neural Network Acoustic Models by Cross-bandwidth and Cross-lingual Initialization》和《Inverse Text Normalization as a Labeling Problem》,一篇提到Siri如何用机器学习格式化地展示日期、时间等的呈现技术,另一篇讲解了如何让Siri支持更多语言。

苹果机器学习博客地址:

https://machinelearning.apple.com/

看来为了让Siri体验更好,苹果还是下了不少心思。

下面,量子位挑选《Deep Learning for Siri’s Voice: On-device Deep Mixture Density Networks for Hybrid Unit Selection Synthesis》的关键部分翻译整理,与大家分享Siri说话更自然流利背后付出的苦功夫。

深度学习如何让Siri更会说话

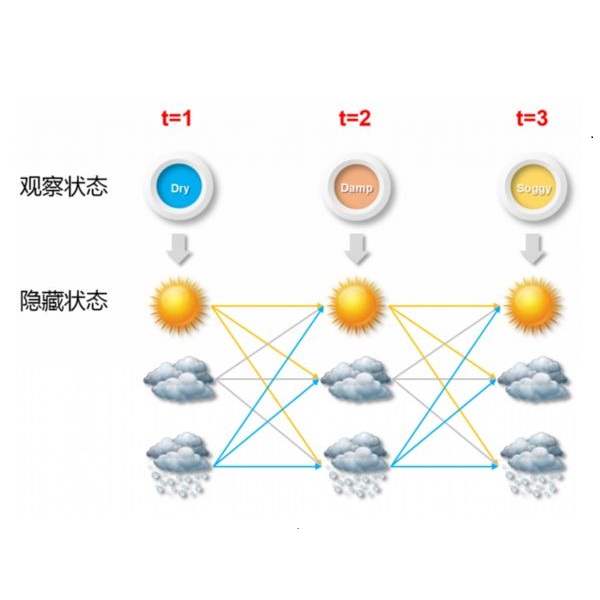

隐马尔可夫模型(HMM)通常被用在目标预测的统计模型中,因为它们直接模拟声音参数的分布,可以轻松利用相对熵(KLD)计算目标损失。

然而,基于深度学习的方法在参数语音合成中表现通常胜过HMM,我们希望将深度学习的优势转化到混合单元选择合成中。

Siri的文本转语音(TTS)目标是训练出基于深度学习的统一模型,能够自动准确预测数据库中单元目标和级联损失。

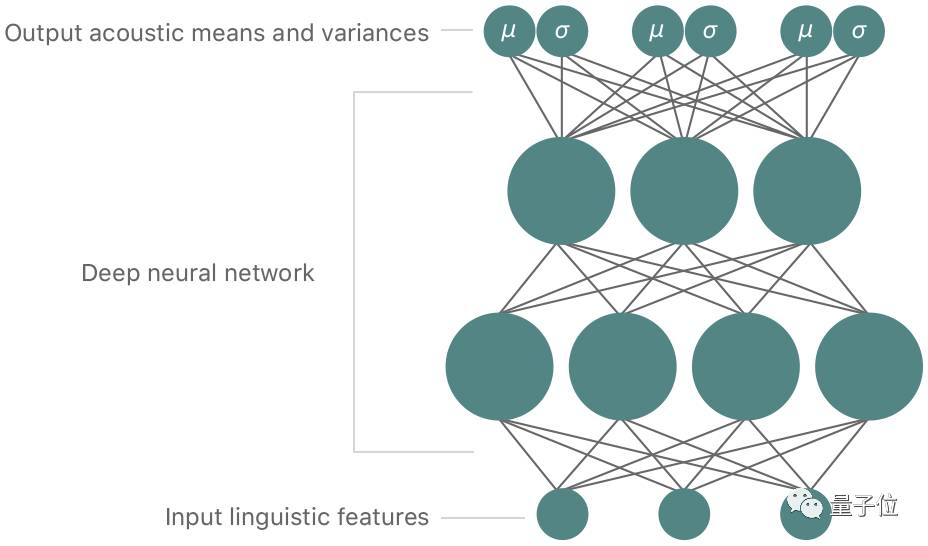

因此,该方法使用深度混合密度网络(MDN)预测特征值分布,而没有用HMM。这里的MDN结合了传统的深度神经网络(DNN)与高斯混合模型(GMM)。

传统的DNN是输入层和输出层间有多个隐藏神经元的人造神经网络,可以建立输入和输出特征之间复杂的非线性关系。我们可以通过反向传播调整网络的权重训练DNN。

与之相比,GMM使用一组高斯分布提供给定输入和输出数据的概率分布,并且通常使用期望最大化(EM)方法训练。MDN通过DNN对输入和输出数据的复杂关系建模,输出概率分布信息,从而结合了DNN和GMM的优点。

△ 深度混合密度网络,用来指导单元选择合成语音特征的均值和方差

在Siri上,我们使用基于MDN的统一目标和连接模型,来预测语音的目标特征(频谱、音高和持续时间)分布,以及单元间的连接成本指导单位搜索。由于MDN的输出是以高斯概率的形式分布,我们可以将其作为目标和级联成本的损失函数(Loss Function)。

无论是在像共振峰等稳定且更新缓慢的语音特征,还是多变的特征中,这种做法的优势均显而易见。考虑到这种可变性,可以选用深度MDN模型中嵌入的方差调整参数。

由于预测方差与上下文相关,可以将它们看作自动依赖上下文权重的损失。因为我们需要计算特定目标和连接损失,所以这对于提高合成质量非常重要。

在使用深度MDN的基础上对单位进行评分后,我们用传统的维特比算法寻找单位最佳路径。然后,再用波形相似重叠相加算法(WSOLA)将各单元连接,找出最优级联时间,创建平滑连续的合成语音。

最后,附论文链接地址:

https://machinelearning.apple.com/2017/08/06/Siri-voices.html#9

论文翻到底还能听到从iOS 9到11 Siri的声音对比,iOS 11版的Siri语调自然,口语力惊艳。

— 完 —

加入社群

量子位AI社群7群开始招募啦,欢迎对AI感兴趣的同学,加小助手微信qbitbot2入群;

此外,量子位专业细分群(自动驾驶、CV、NLP、机器学习等)正在招募,面向正在从事相关领域的工程师及研究人员。

进群请加小助手微信号qbitbot2,并务必备注相应群的关键词~通过审核后我们将邀请进群。(专业群审核较严,敬请谅解)

诚挚招聘

量子位正在招募编辑/记者,工作地点在北京中关村。期待有才气、有热情的同学加入我们!相关细节,请在量子位公众号(QbitAI)对话界面,回复“招聘”两个字。

量子位 QbitAI

վ'ᴗ' ի 追踪AI技术和产品新动态