CMU 深度学习导论更新 | 第二讲:神经网络作为通用逼近器

AI 研习社获得官方授权,汉化翻译CMU 2018 秋季《深度学习导论》课程,9月27日正式上线中文字幕版。

第二讲

神经网络作为通用逼近器

上手视频约 5 分钟 ▼

翻译 | 董丹丹、张硕玺、汪鹏、shunshun

校对 | 汪鹏

字幕 | 凡江

加入小组

好消息!CMU 深度学习小组在 AI 研习社上线啦!

电脑端点击网址:http://www.gair.link/page/groupDetail/18

看到绿色按钮【申请加入】,点击即可提交申请或者直接加入。

目前已经有超过20位学习小组成员成功在小组学习打卡。

你也可以和其他社友们一起探讨学习过程中的各种问题,期待你的加入哟!

以下是课程相关简介:

CMU 2018 秋季《深度学习导论》为官方开源最新版本,由卡耐基梅隆大学教授 Bhiksha Raj 授权 AI 研习社翻译。9 月 27 日开始正式同步更新在 AI 研习社,跟随官网课程节奏而更新。

观看网址:http://www.mooc.ai/course/562

(长按下方二维码或者点击文末阅读原文)

课程介绍

「深度学习」系统,以神经网络为代表,逐渐应用于所有的 AI 任务,从语言理解,语音和图像识别到机器翻译,规划,甚至是游戏电竞和自动驾驶。结果是在许多高级学术环境中,深度学习的专业知识正从深奥晦涩的理想转变为行业必要的先决条件,并且在工业界的就业市场中占有非常大的优势。

在本课程中将会学习深度神经网络的基础知识,以及它们在众多 AI 任务中的应用。课程结束后,期望学生能对深度学习有足够的了解,并且能够在众多的实际任务中应用深度学习。

课程官方链接:http://deeplearning.cs.cmu.edu/

学生评价

本课程包含全面的概念描述,它帮助我们理解了深度学习的基础知识。课程从多层感知机开始逐渐深入更复杂的概念,比如注意力机制以及序列模型,另外我们必须完全掌握 Pytorch,这对实现深度学习模型非常重要。作为学生,会学习使用构建深度学习模型所需要的工具。家庭作业主要包括两个部分,分别是 Autolab 和 Kaggle。

Kaggle 部分让我们探索多种架构以及理解如何进行微调并不断改进模型。所有的家庭作业涉及的任务都非常相似,尝试使用多种深度学习方法来解决相同任务是非常有趣的。总而言之,在课程结束之际你会充满信心去构建并调试深度学习模型。

老师的学术功底很强,同时也是个故事大师,整理出来的人工神经网络的发展脉络很清晰明了,以此为基础引导学生由浅入深的思考问题,有节奏的从理论到现实问题的转移,十分推荐。@付腾

领衔主讲

Bhiksha Raj

先修要求

使用主流的工具包(复习课和实验课主要用的工具是 PyTorch)。工具包主要用 Python 编程。学生只要需要掌握其中一门编程语言,或者可以使用自己熟练的编程语言并且学习一种工具包来进行编程。

学生需要熟悉基础微积分 (微分,链式法则),线性代数和概率论。

每周学习时间 (Units): 本课程值得每周花 36 小时学习

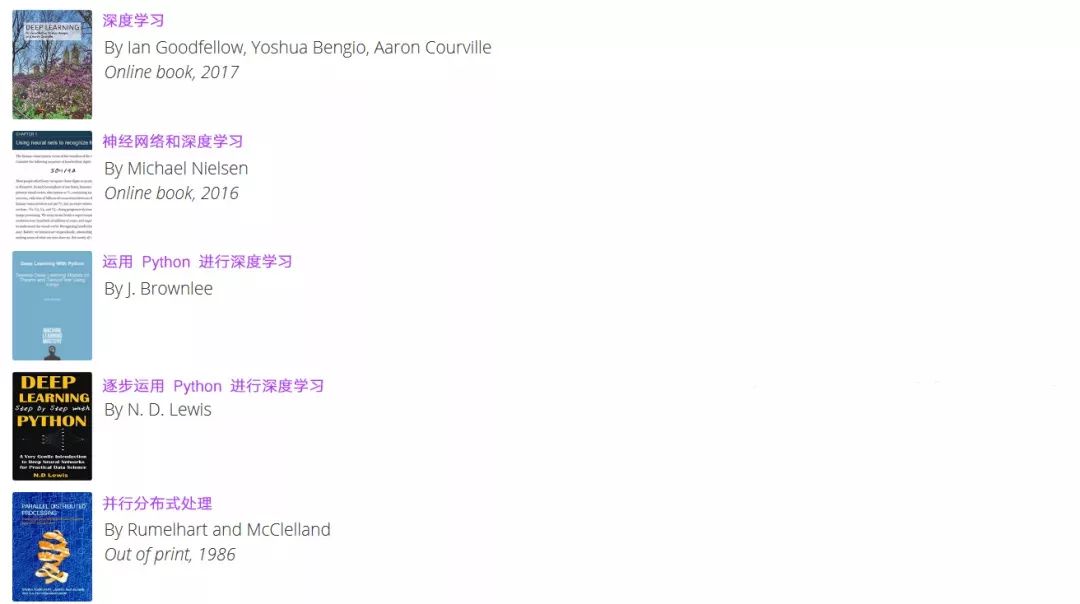

教材

教材资源和课程PDF文件均可在AI研习社找到。除此之外,AI研习社同步更新Piazza讨论版上的问题和教授解答,帮你全方位更加全面地学习这门课程。

链接地址:http://www.gair.link/page/tag/124

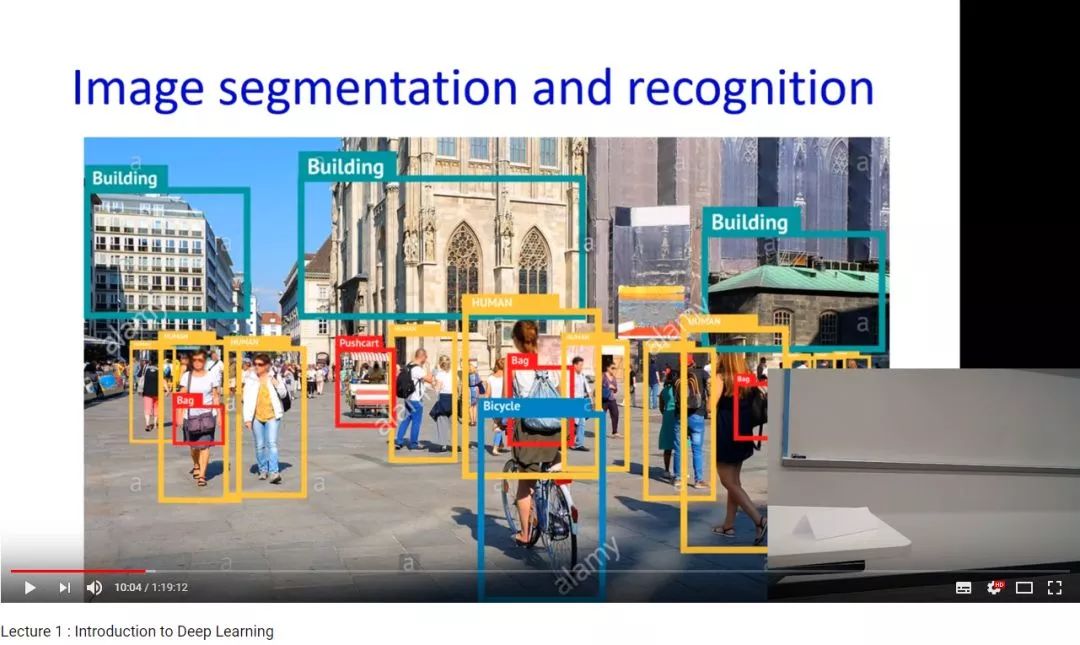

# 课程截图

课程大纲

第一讲:

深度学习简介

课程安排

神经计算的历史和认知基础

多层感知机

第二讲

神经网络作为通用逼近器

第三讲

训练神经网络

感知器学习规则

经验风险最小化

梯度下降优化

第四讲

反向传播

反向传播的微积分

第五讲

神经网络的收敛性

收敛率

损失面

学习率以及优化方法

最优化方法 RMSProp, Adagrad,Momentum

第六讲

随机梯度下降

模型加速

过拟合

正则化

第七讲

技巧:选择分歧损失函数;批归一化;Dropout

训练过程回顾

学生答疑解惑

第八讲

继续前面的优化课

第九讲

卷积神经网络

权重模板

平移不变性

权值共享训练网络

构建卷积模型

第十讲

视觉模型

神经认知机

卷积神经网络的数学细节

Alexnet,Inception,VGG 网络

第十一讲

循环神经网络 (RNNs)

建模系列

随着时间的反向传播

双向 RNN

第十二讲

稳定性

梯度爆炸/梯度消失

长短期记忆神经网络以及方差

Resnets

第十三讲

循环神经网络的损失函数

序列预测

第十四讲

序列到序列方法

连接时序分类

第十五讲

序列到序列模型,注意力模型,语音和语言示例

第十六讲

神经网络是什么

自动编码器和降维

表征学习

第十七讲

变分自动编码器

第十八讲

生成对抗网络(第一部分)

生成对抗网络(第二部分)

第十九讲

Hopfield 神经网络

玻尔兹曼机

第二十讲

训练 Hopfield 网络

随机 Hopfield 网络

第二十一讲

受限玻尔兹曼机

深度玻尔兹曼机

第二十二讲

强化学习第一部分

第二十三讲

强化学习第二部分

第二十四讲

感恩节假期

第二十五讲

强化学习第三部分

第二十六讲

强化学习第四部分

第二十七讲

Q 学习

深度 Q 学习

第二十八讲

新模型以及深度学习的趋势

课程回顾

复习课时间表

第一节:AWS 云服务

第二节:初试深度学习代码

第三节:高效深度学习/优化算法

第四节:卷积神经网络

第五节:调试及可视化

第六节:循环神经网络基础

第七节:循环神经网络第二部分:损失函数,联结时序分类(CTC)

第八节:注意力机制

第九节:深度学习相关研究

第十节:变分自动编码器

第十一节:生成对抗网络

第十二节:强化学习

第十三节:Hopfield 网络,玻尔兹曼机,受限玻尔兹曼机

中文字幕,观看视频 CMU 秋季新课《深度学习导论》 ↓