《探索多行动回合制兵棋的学习分类系统行为》美国空军学院2022最新102页论文

I. 引言

1.1 问题背景

1.2 动机

1.3 研究问题

1.4 研究任务

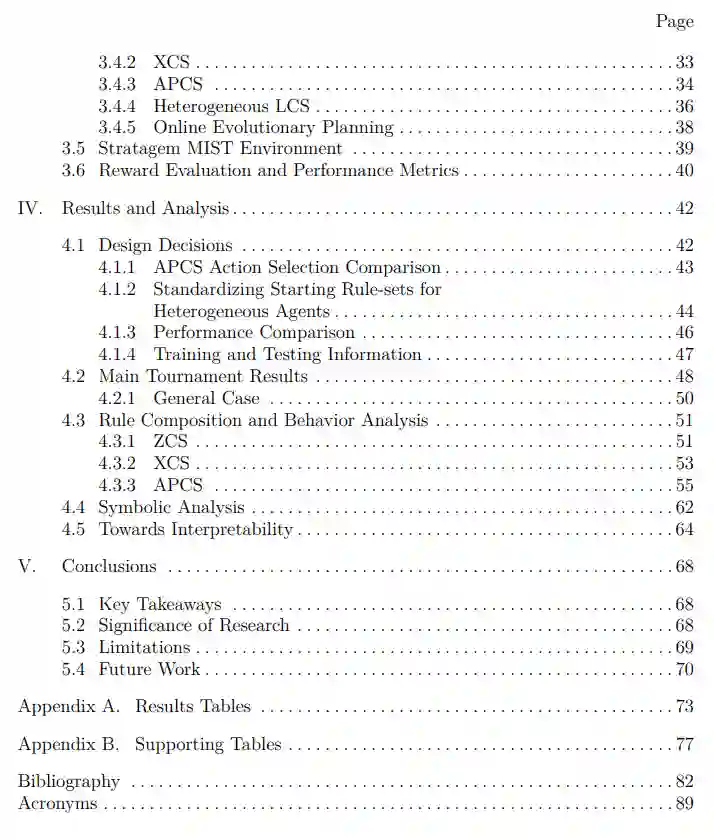

1.5 文件概述

专知便捷查看

便捷下载,请关注专知人工智能公众号(点击上方蓝色专知关注)

后台回复“WLCS” 就可以获取《《探索多行动回合制兵棋的学习分类系统行为》美国空军学院2022最新102页论文》 专知下载链接

登录查看更多

相关内容

Arxiv

1+阅读 · 2022年11月21日