传统图特征提取方法 | 节点级别的的特征(Node-level)

“强基固本,行稳致远”,科学研究离不开理论基础,人工智能学科更是需要数学、物理、神经科学等基础学科提供有力支撑,为了紧扣时代脉搏,我们推出“强基固本”专栏,讲解AI领域的基础知识,为你的科研学习提供助力,夯实理论基础,提升原始创新能力,敬请关注。

01

(1)基于节点重要性的特征,衡量了某节点在网络中的重要程度,如:节点度,节点中心性度量;

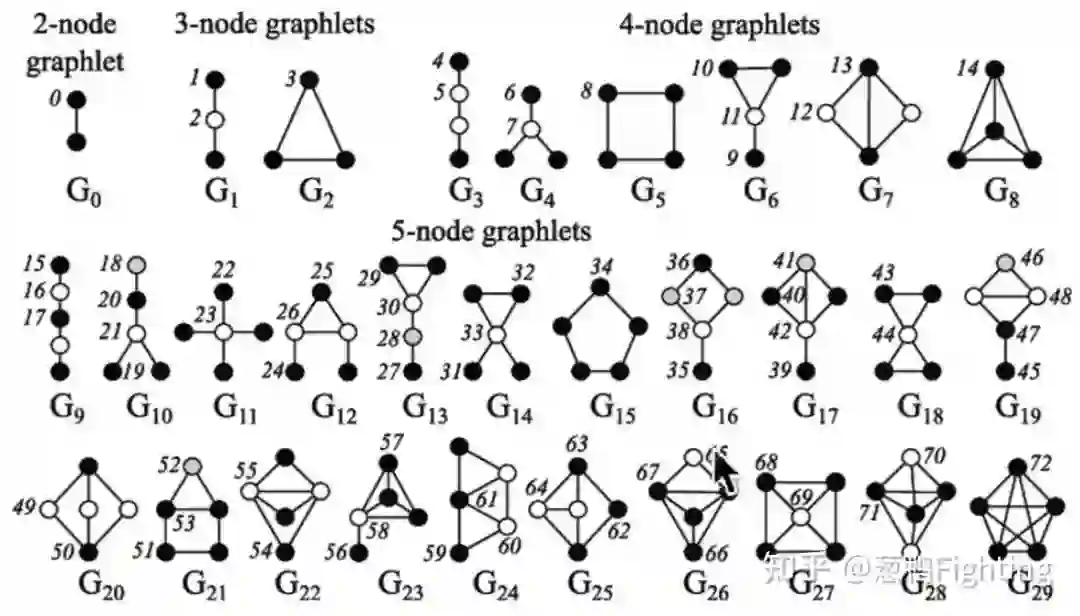

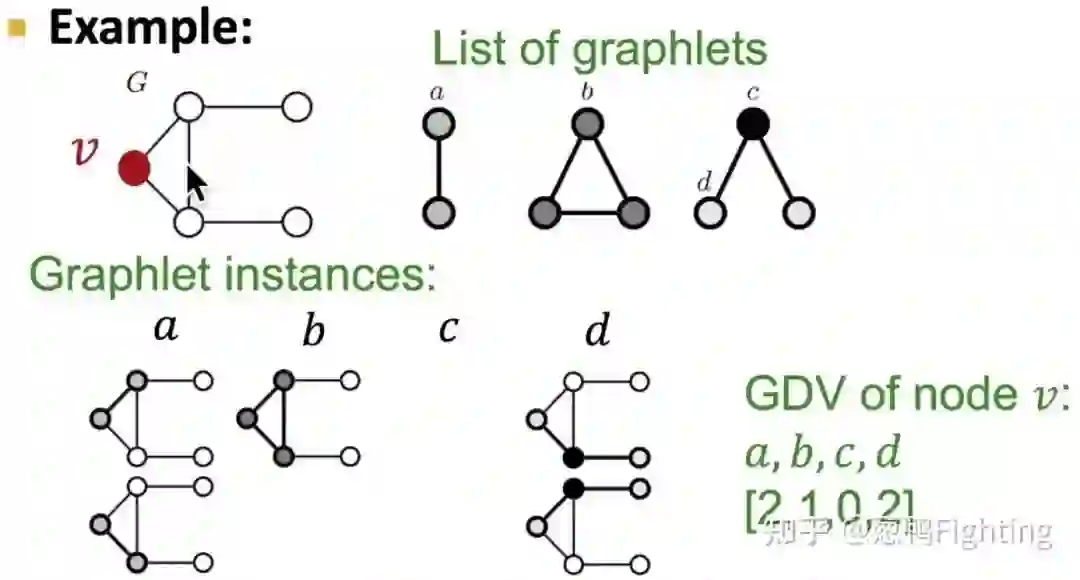

(2)基于结构的特征,能够捕捉节点周围领域的拓扑属性,如:节点度,聚类系数,图元度向量(GDV,graphlet degree vector)

1. 节点度(Node Degree)

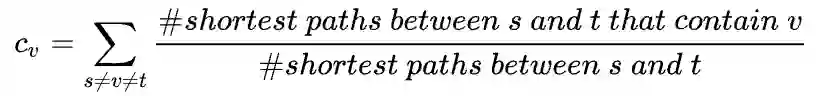

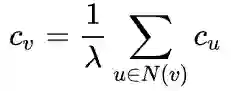

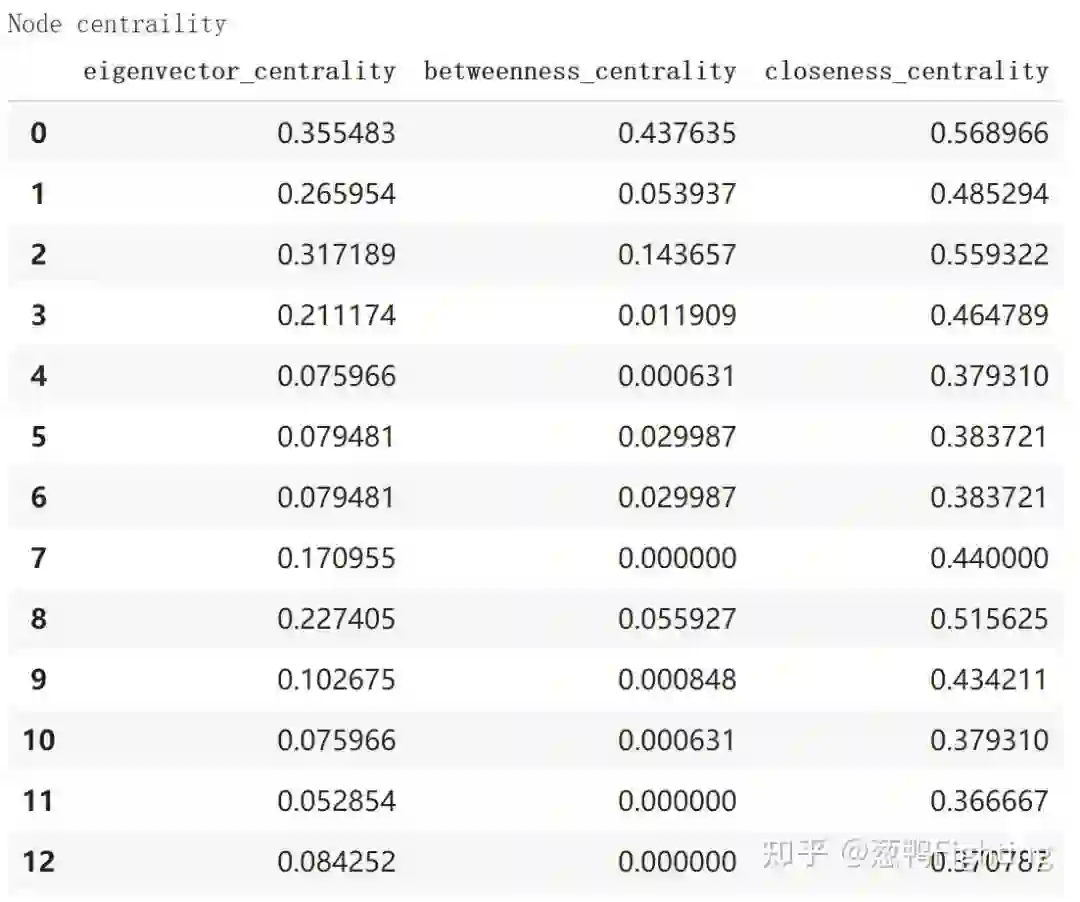

2. 节点中心性(Node Centrality)

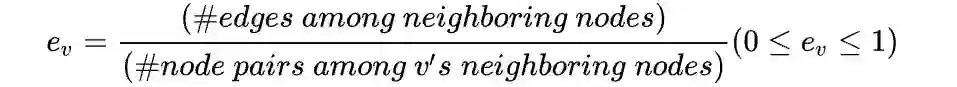

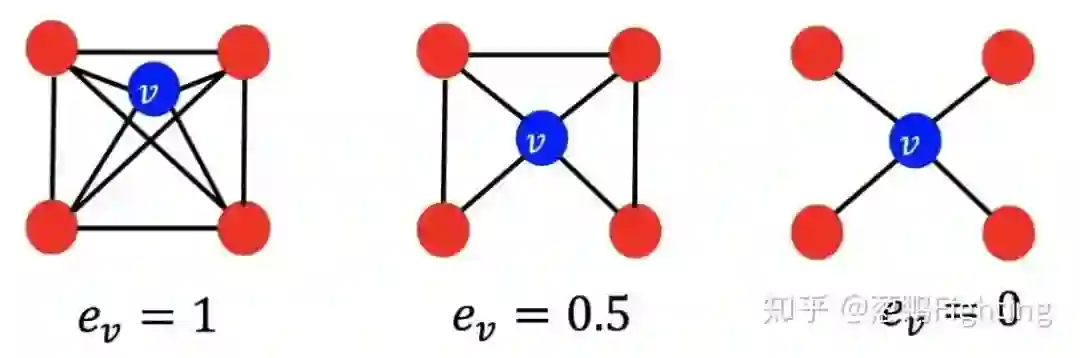

3. 聚类系数(Clustering Coefficients)

的聚类系数:

的聚类系数:

聚类系数示例图(图源自CS224W课程)

4. 图元度向量(Graphlet Degree Vector)

图元示例图(图源自CS224W课程)

图元度向量示例(图源自CS224W课程)

02

导入第三方库

# 导入第三方网络分析库 networkx# 导入绘图库import networkx as nximport matplotlib.pyplot as pltimport pandas as pd

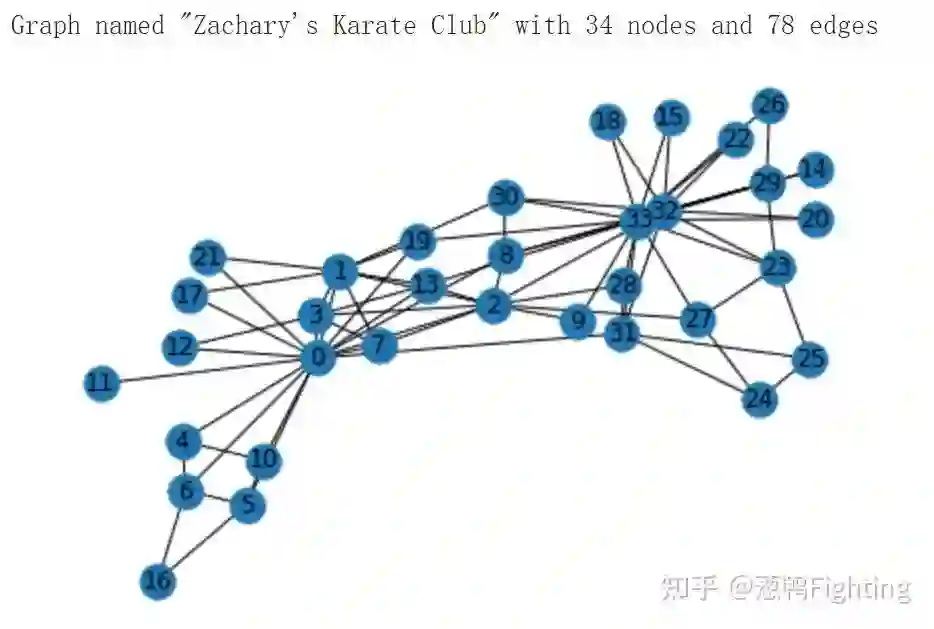

导入示例数据集

# 导入networkx自带的网络数据集 karate club 作为示例测试代码G = nx.karate_club_graph()# 打印查看网络的基本信息以及可视化print(nx.info(G))nx.draw(G, pos=nx.spring_layout(G), with_labels=True)

节点度函数 G.degree(v)

# 打印查看节点度信息print("Node Degree")for v in G:print(f"{v:4} {G.degree(v):6}")

节点中心性函数

# 打印查看各种节点中心性数值# 各个中心性函数返回的是字典类型数据,key为节点index,value为中心性数值print("Node centraility")eigen_dict = nx.eigenvector_centrality(G)betw_dict = nx.betweenness_centrality(G)close_dict = nx.closeness_centrality(G)centrality_df = pd.DataFrame( { 'eigenvector_centrality': [eigen_dict[v] for v in G], 'betweenness_centrality': [betw_dict[v] for v in G], 'closeness_centrality': [close_dict[v] for v in G], })centrality_df

节点聚类系数函数 nx.clustering(G)

# 打印查看各种节点聚类系数# 聚类系数函数nx.clustering(G)返回的是字典类型数据,key为节点index,value为聚类系数数值print("Node Clustering Coefficients")nx.clustering(G)

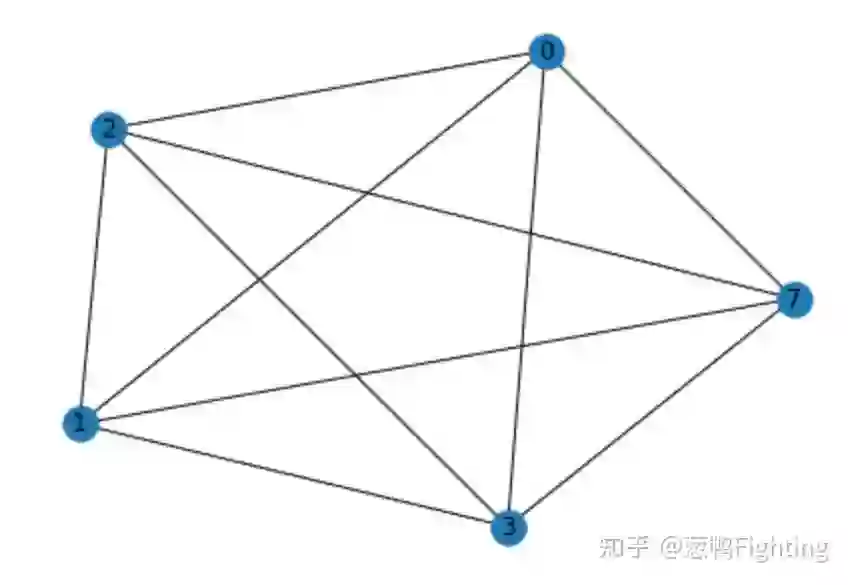

ego = nx.ego_graph(G, 7)nx.draw(ego, pos=nx.spring_layout(ego), with_labels=True)

完整代码

03

登录查看更多

相关内容

Arxiv

26+阅读 · 2020年12月29日