深度神经网络结构搜索综述(中文版),20页pdf

深度神经网络在图像识别、语言识别和机器翻译等人工智能任务中取得了巨大进展,很大程度上归功于优秀的神经网络结构设计。神经网络大都由手工设计,需要专业的机器学习知识以及大量的试错。为此,自动化的神经网络结构搜索成为研究热点。神经网络结构搜索(neural architecture search,NAS)主要由搜索空间、搜索策略与性能评估方法3部分组成。在搜索空间设计上,出于计算量的考虑,通常不会搜索整个网络结构,而是先将网络分成几块,然后搜索块中的结构。根据实际情况的不同,可以共享不同块中的结构,也可以对每个块单独搜索不同的结构。在搜索策略上,主流的优化方法包含强化学习、进化算法、贝叶斯优化和基于梯度的优化等。在性能评估上,为了节省计算时间,通常不会将每一个网络都充分训练到收敛,而是通过权值共享、早停等方法尽可能减小单个网络的训练时间。与手工设计的网络相比,神经网络结构搜索得到的深度神经网络具有更好的性能。在ImageNet分类任务上,与手工设计的MobileNetV2相比,通过神经网络结构搜索得到的MobileNetV3减少了近30%的计算量,并且top-1分类精度提升了3.2%;在Cityscapes语义分割任务上,与手工设计的DeepLabv3+相比,通过神经网络结构搜索得到的Auto-DeepLab-L可以在没有ImageNet预训练的情况下,达到比DeepLabv3+更高的平均交并比(mean intersection over union,mIOU),同时减小一半以上的计算量。神经网络结构搜索得到的深度神经网络通常比手工设计的神经网络有着更好的表现,是未来神经网络设计的发展趋势。

http://www.cjig.cn/jig/ch/reader/view_abstract.aspx?file_no=20210202&flag=1

随着计算机与 GPU(graphics processing unit)算 力的增长,深度神经网络不仅在语音识别、图像理解 以及自然语言处理等人工智能领域 ( LeCun 等, 2015)得到广泛应用,而且在癌症检测、自动驾驶和 复杂游戏等复杂系统中也得到应用。深度神经网络 在识别任务中已经超越了人类的准确度,对比传统算法有着巨大的突破,如手工设计的方向梯度直方 图(histogram of oriented gradient,HOG) 特征(Dalal 和 Triggs,2005)和尺度不变特征变换(scale-invariant feature transform,SIFT) 特征( Lowe,2004) 等。这些 性能的提升主要是由于深度神经网络能够提取很高 层次的特征,从而得到对输入数据更加有效的表示。除此之外,GPU 算力的提升使得神经网络的层数进 一步增加,表征能力进一步增强。神经网络的结构 从 AlexNet(Krizhevsky 等,2012)进化到 VGGNet(Si-monyan 和 Zisserman,2014),再到 GoogLeNet(Szegedy 等,2015)和 ResNet(He 等,2016),神经网络的结构 变得越来越复杂。

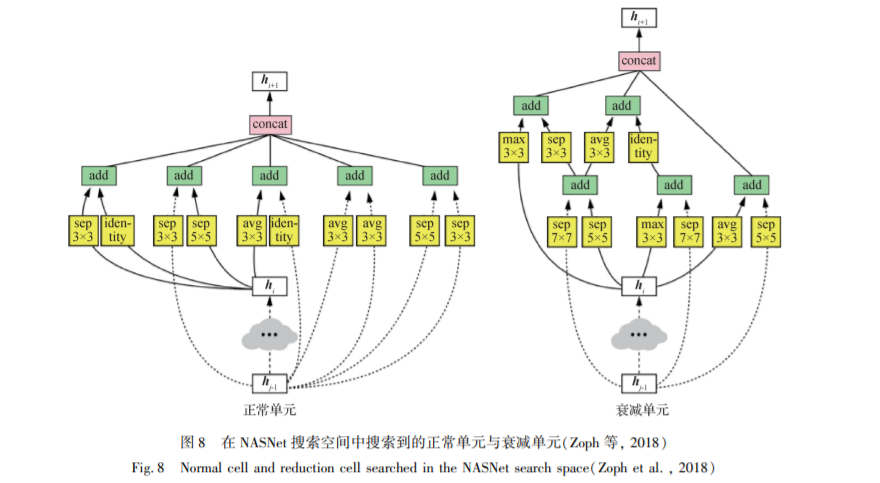

深度神经网络之所以能取得很好的性能,很大 程度上是由于优秀的网络结构设计。神经网络的设 计需要考虑很多因素。以卷积神经网络为例,需要 根据目标数据集来决定使用多少层的卷积神经网 络。比如 ResNet(He 等,2016)有 18 层、34 层、152 层 等不同版本,需要在准确率和计算量之间进行权衡。例如在较大的数据集上使用 ResNet-18 ( He 等, 2016)可能会出现拟合能力较差的情况;在较小的 数据集上使用 ResNet-152(He 等,2016)则很可能会 过拟合,并且增大算力开销。除了层数之外还需要 考虑卷积核的大小,如果全部使用 3 × 3 大小的卷积 核,那么层数较少的情况下感知野会比较小,如果全 部使用 7 × 7 大小的卷积核,算力要求会呈倍数增 长。需要仔细权衡在哪些层使用 3 × 3 大小的卷积 核,在哪些层使用 5 × 5 或者 7 × 7 大小的卷积核,既 要保证获得足够大的感知野,又不会使得计算量过 大而无法训练到收敛;另外还需要考虑在哪些层进 行下采样(downsample),是否使用最大池化层(max pooling)、平均池化层(average pooling),或者使用步 长(stride)大于 1 的卷积层进行下采样;在 ResNet (He 等,2016)证实残差学习(residual learning)能够 极大地改善深度神经网络的收敛结果之后,还需要 考虑不同的网络层之间的连接方式。从 2014 年 VGGNet(Simonyan 和 Zisserman,2014)的线性结构, Inception ( Szegedy 等, 2015, 2016, 2017; Ioffe 和 Szegedy,2015 ) 网络的多路结构设计, 到 2016 年 ResNet ( He 等, 2016 ) 的 残 差 连 接 和 2017 年 DenseNet(Huang 等,2017) 的密集连接,再到 2017 年 SENet(Hu 等,2018)中注意力机制( attention)的 加入,神经网络结构的设计变得愈发复杂,不再是简 单的线性结构的设计,而是有向无环图( directed acyclic graph)的设计,这使得在特定场景下,设计兼 顾性能和计算量的神经网络变得愈发困难。

2017 年以前的神经网络大都是手工设计,根据 特定的任务设计一个合适的神经网络需要花费大量 精力和时间。因此,一些自动化的神经网络结构设 计方法被提出,也称做神经网络结构搜索( neural architecture search, NAS)。神经网络结构搜索类似 于机器学习中的超参数优化(hyperparameter optimization),超参数优化在机器学习领域是一个很重要 的研究主题( Bergstra 等,2011;Bergstra 和 Bengio, 2012; Snoek 等, 2012, 2015; Saxena 和 Verbeek, 2016)。但是这些方法仍然局限在定长的搜索空间 内,很难应用在变长度的搜索设定上,比如搜索神经 网络的结构和每层的设定,因此这些方法缺少通用 性和灵活性。

神经网络结构搜索可以分成 3 个维度:搜索空 间(search space)、搜索策略(search strategy)和性能 评估策略( performance estimation strategy)。 搜索过 程如图 1 所示,搜索策略从搜索空间 A 中选取某个 神经网络结构 a,然后用性能估计策略来估计该网 络结构的泛化性能,最后将估计的泛化性能反馈给 搜索策略,进一步改进搜索策略(Elsken 等,2019)。

搜索空间定义了可以表征的神经网络结构,在 搜索空间的设计上嵌入了很多先验知识,这样可以 一定程度上减小搜索空间的大小,使搜索变得更简 单。除此之外,嵌入的先验知识也使得搜索空间中 的所有结构都有相对较好的性能。搜索空间通常分 为两种,一种是比较简单的链式结构,另一种则是有 向无环图的结构。在搜索空间中通常将单个神经网 络结构编码成定长或者变长的串(token)。

搜索策略则是用来探索搜索空间,通常会面临 探索—利用权衡( exploration-exploitation trade-off), 一方面需要尽快找到最优解,另一方面又不能过早 地收敛到一个局部最优结构。常用的方法有强化学习、进化算法、贝叶斯优化和基于梯度的优化方法等。

神经网络结构搜索的目标是从定义的搜索空间 内,面向某个未知数据集,找到具有最高的泛化性能 的网络结构。性能评估策略在神经网络结构搜索中 则用来估计采样到的神经网络结构的泛化性能。最 简单直接的方式就是将每个神经网络在训练数据上 都训练到收敛,然后将验证数据上的测试结果作为 估计的泛化性能,但是需要花费相当多的时间,例如 在 Zoph 和 Le(2016)的方法中,仅在 CIFAR-10 数据 集上的搜索就使用 800 个 GPU 并行搜索了一个月 左右的时间。

本文在图像分类任务上,集中分析卷积神经网 络的结构搜索。首先回顾较经典的深度神经网络的 发展历程,然后从搜索空间、搜索策略、性能评估策略 以及应用方向等角度详细介绍神经网络结构搜索的 各种方法的优缺点, 进而分析各种方法在不同场景和 数据集下的性能表现,最后分析了未来的发展趋势。

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“NAS20” 可以获取《深度神经网络结构搜索综述(中文版),20页pdf》专知下载链接索引