千言:多技能对话赛题详解来了,涵盖闲聊对话、知识对话、推荐对话等

人机对话是人工智能的重要挑战,最近几年随着人工智能的兴起,人机对话的研究也越来越火热。从2016年开始,NLP顶级会议ACL和EMNLP对话相关论文的数量增长迅猛,2020年相比于2010年对话论文数量有数倍的增长。

目前,学术界已经公开了多个面向开放域对话建模的开源数据集。但大多数研究工作仅关注模型在单一或少量数据集上的效果。尽管一些模型在单一数据集上取得了很好的效果,但缺乏在多个不同技能、不同领域数据上的评价,与真正很好的解决开放域对话这一技术挑战还有一定距离。为了解决这个问题,我们需要有一套评估全面,领域覆盖广的公开评测数据集。

2020 CCF BDCI百度和清华大学在算法赛道贡献的“千言:多技能对话”赛题正是针对这一技术领域开展,收集了面向闲聊对话、知识对话、推荐对话的7大公开开放域对话数据集,并对数据进行了统一的整理以及提供了统一的评测方式,期望从多个技能、多个领域的角度对模型效果进行综合评价。

来自百度自然语言处理部的工程师于10月28日晚于飞桨直播间对本次赛题做了详细剖析,从任务构建、评估方式、基线模型全方面解答了选手疑惑,并给出了多种模型优化思路。报名比赛即可获取视频资料,快快扫码吧!

千言:多技能对话

百度X清华强强联合 多技能多领域综合评判

本次竞赛数据基于千言数据集(https://www.luge.ai)及清华开放数据集(https://github.com/thu-coai/CDial-GPT)进行构建。其中,“千言”是百度联合中国计算机学会、中国中文信息学会共同发起的,由来自国内多家高校和企业的数据资源研发者共同建设的中文开源数据集及评测项目。本次竞赛数据集旨在为研究人员和开发者提供学术和技术交流的平台,进一步提升开放域对话的研究水平,推动自然语言理解和人工智能领域技术的应用和发展。

本次竞赛的开放域对话数据集包含多个数据,涵盖了多个功能场景,旨在衡量开放域对话模型在各个不同技能上的效果和模型通用性。具体来说,本次比赛中我们主要从日常闲聊对话,知识对话、推荐对话方面考察模型能力:

任务一、闲聊对话

即给定对话历史,预测回复。主要考察在闲聊场景中,是否可以生成流畅的、与上下文相关的对话回复。

输入输出

输入:当前对话的对话历史H=u_1,u_2,...,u_t。即前t句对话语句。

输出:符合对话历史的流畅回复u_{t+1},并且要求该回复与给定的对话历史是相关的。

数据集

闲聊对话相关数据:华为的微博数据 [1] ,北航和微软的豆瓣多轮对话 [2] ,清华的LCCC数据集 [3] 。

任务二、知识对话

即在闲聊的基础上进一步引入知识,除给定对话历史外还会给定对话的背景知识,以及对话目标,给予背景知识和对话历史预测回复。

主要考察是否可以在对话过程中充分利用外部知识,并且在生成对话回复的过程中引入外部知识。

输入输出

输入:对话目标g(部分数据集没有)、知识信息M、对话历史H(u_1, u_2, …, u_t-1)

输出:符合对话历史和对话目标,且自然流畅、信息丰富的机器回复u_t

数据集

知识对话相关数据:百度的DuConv [4] ,清华的KdConv [5],腾讯的检索辅助生成对话数据集 [6]。

以DuConv数据集为例为各位选手介绍此任务:

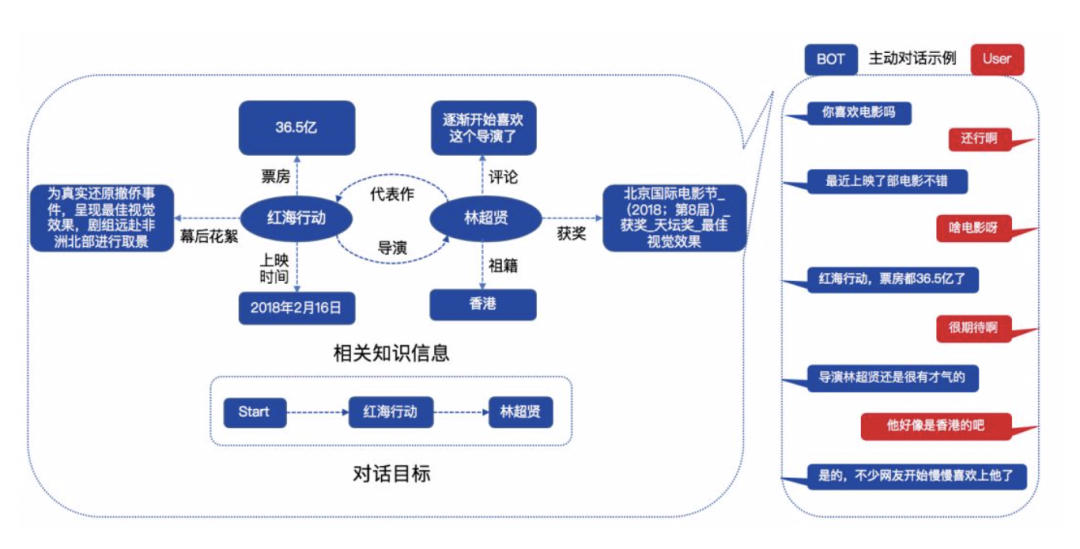

我们给机器设置的对话目标是从当前话题跳转到目标话题上,由于目标话题和当前话题存在相关和不相关两种情况,因此我们在对话目标设定上同时考虑这两种情况,如图1左下所示,首先让机器从当前话题(Start)跳转到任意目标话题A(红海行动),然后进一步跳转到和话题A相关的另一目标话题B(林超贤)上。

图1主动对话示例

如图1左上部分所示,给机器提供的是聊天相关的背景知识。图1右侧为主动对话示例,机器主动发起对话,根据背景知识主动引领对话进程,自然流畅的实现话题的迁移目标。

DuConv数据集详细介绍指路:https://mp.weixin.qq.com/s/uyNlO97QQ4nQpFjYNOVceg

论文指路:https://www.aclweb.org/anthology/P19-1369/

任务三、推荐对话

即在知识对话的基础上引入了用户画像及聊天场景。基于对话目标、背景知识,用户画像,对话场景和对话历史来预测回复。

主要考察是否可以在对话过程中基于用户兴趣以及用户的实时反馈,主动对用户做出推荐。

输入输出

输入:第一个对话目标g_1、最后两个对话目标g_L-1和g_L、知识信息M、用户Profile (画像)P、对话场景S、对话历史H(u_1, u_2, …, u_t-1)

输出:符合对话历史和对话目标序列,且自然流畅、信息丰富的机器回复u_t。

数据集

推荐对话相关数据:百度的DuRecDial [7]。

任务介绍

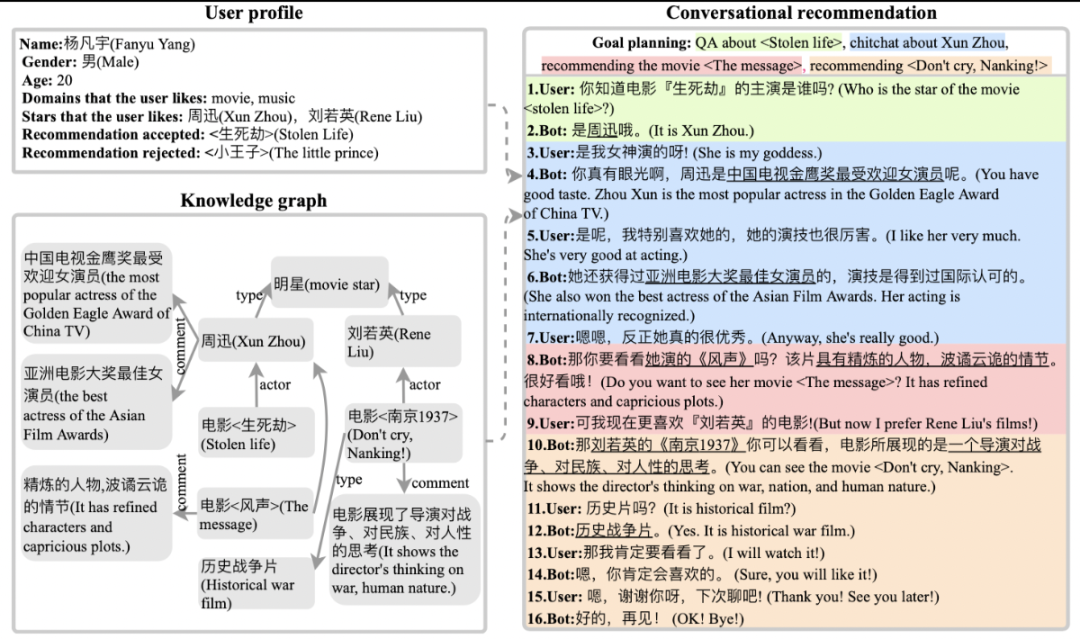

研究人员要求两人进行对话,其中一人扮演recommendation seeker(用户),另一个人扮演recommender(bot),要求recommender主动引导对话,然后基于用户profile推荐,而不是用户引导对话或寻求推荐。例如在用户关于『生死劫』的问答后,机器根据其长期偏好和知识图谱信息,规划对话目标序列(关于『周迅』的闲聊>>推荐电影『风声』),并自然地引导对话,当用户转移话题(更喜欢『刘若英』的电影),机器根据其profile,精准推荐『南京1937』,最终完成所有对话目标。对话结束后,用户profile会根据其反馈而更新,以便于提高后续对话的用户体验。

图2 融合多对话类型的对话式推荐样例

用户profile如图2左上部分所示,给机器提供的知识图谱信息是目标序列相关的子图信息。图2右侧为多类型对话中的对话式推荐示例,用户问答后,机器主动引导对话,自然流畅地实现对话目标的转移。

这个任务跟之前任务的不同主要包括:

对话包含多个goal(目标),每个goal都包含goal type和goal topic;type决定对话类型,topic对type进一步细化,决定对话的具体内容。

机器通过规划对话目标序列来主动引导对话,而用户不知道对话目标。

详细介绍指路:https://mp.weixin.qq.com/s/f3dCOc4Mog9eZTl0k5YQew

论文指路:https://arxiv.org/pdf/2005.03954.pdf

100小时算力加持,AI Studio练习场助你冲榜

本届大赛百度大脑AI Studio同步开放了【千言:多技能对话】练习场,并为各位参赛者带来了如下几大福利:

额外测试提交机会:练习场为参赛选手提供A榜阶段每天附加1次的提交机会,助力你更好地验证模型效果。不仅如此,练习场在排行榜中公布具体评测指标得分,助力选手进一步提升成绩。

免费GPU算力:百度大脑AI Studio练习场为参赛选手额外发放100小时 GPU Tesla V100算力卡,报名即可在数据下载页获取算力码申请地址。

官方基线系统:报名即可在数据下载页获取可一键Fork的基线系统。

练习赛附加奖项:除主赛场奖池外,在练习赛中排名前50的队伍可获得飞桨纪念品一份。

百度工程师亲授解题思路:来自百度自然处理部的工程师于10月28日晚于飞浆直播间对本次赛题做了详细剖析,从任务构建、评估方式、基线模型全方面解答了选手疑惑,并给出了多种模型优化思路。扫码报名比赛即可获取视频链接。

海阔凭鱼跃,天高任鸟飞。作为国内AI及大数据方面的大型比赛擂台,CCF BDCI的规模与影响力均属行业顶级,同时赛题全面、评审专业、奖品丰厚。如果你也想要一展身手,与各路大神同台竞技,那么千万不要错过哦!

相关文献:

[1] Lifeng Shang, Zhengdong Lu, Hang Li. 2015. Neural Responding Machine for Short-Text Conversation. In ACL.

[2] Yu Wu, Wei Wu, Chen Xing, Ming Zhou, Zhoujun Li. 2017. Sequential Matching Network: A New Archtechture for Multi-turn Response Selection in Retrieval-based Chatbots. In ACL.

[3] Yida Wang, Pei Ke, Yinhe Zheng, Kaili Huang, Yong Jiang, Xiaoyan Zhu, Minlie Huang. 2020. A Large-Scale Chinese Short-Text Conversation Dataset. In NLPCC

[4] Wenquan Wu, Zhen Guo, Xiangyang Zhou, Hua Wu, Xiyuan Zhang, Rongzhong Lian, and Haifeng Wang. 2019. Proactive human-machine conversation with explicit conversation goal. In ACL.

[5] Hao Zhou, Chujie Zheng, Kaili Huang, Minlie Huang, Xiaoyan Zhu. 2020. KdConv: A Chinese Multi-domain Dialogue Dataset Towards Multi-turn Knowledge-driven Conversation. In ACL.

[6] Deng Cai, Yan Wang, Wei Bi, Zhaopeng Tu, Xiaojiang Liu, Shuming Shi. 2019. Retrieval-guided Dialogue Response Generation via a Matching-to-Generation Framework. In EMNLP.

[7] Zeming Liu, Haifeng Wang, Zheng-Yu Niu, Hua Wu, Wanxiang Che, Ting Liu. 2020. Towards Conversational Recommendation over Multi-Type Dialogs. In ACL.