太魔幻了!DALL·E 2 居然能用自创的语言来生成图像,AI模型的可解释性再一次暴露短板

DALL·E-2 的秘密语言

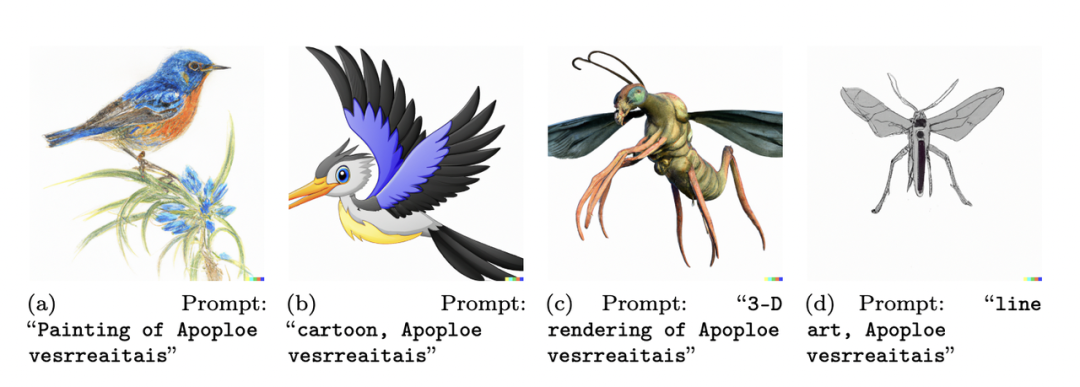

Daras 和 Dimakis 采用了一种简单的方法来破解DALL·E-2的词汇库。

DALL·E-2 的秘密语言

-

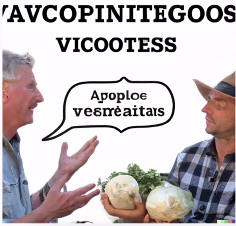

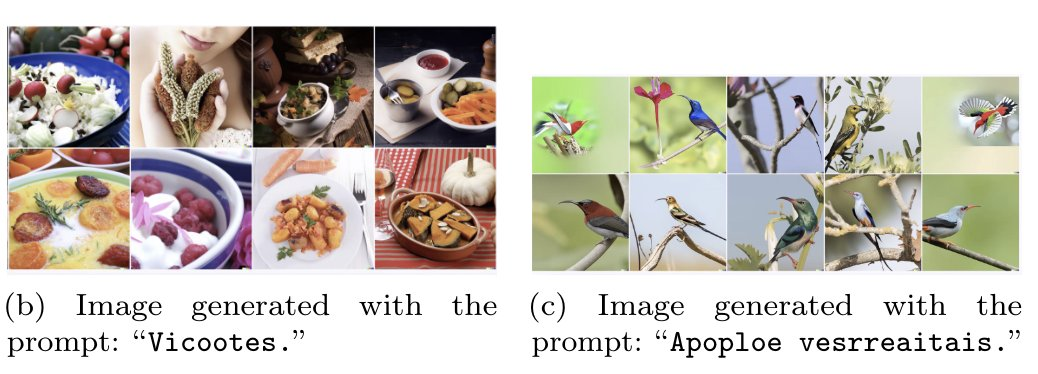

A book that has the word vegetables written on it.(上面写着“蔬菜”一词的书。) -

Two people talking about vegetables, with subtitles.(两个人在谈论蔬菜,有字幕。) -

The word vegetables written in 10 languages.(以10种语言书写的“蔬菜”一词。)

-它的语言模型是来自CLIP,所以问题一定是来自那个模型。

-我的理解是,它只在图像上进行训练,对吧?它用文本描述对图像进行编码,但它实际上从未 “看到 ”文本描述,除非图像中恰好有文本。

-任何被索引到文本描述的图像文本(或图像文本的插值)都不会只是随机的胡言乱语,这很有道理。有趣的是它如何对语言概念本身进行索引,以及它将它们混合在一起的能力。就像人类对语言的使用一样。

剥其机理

剥其机理

安全性和可解释性的挑战

安全性和可解释性的挑战

登录查看更多

相关内容

专知会员服务

27+阅读 · 2022年3月3日

Arxiv

17+阅读 · 2021年6月25日