OpenAI的DALL·E迎来升级,不止文本生成图像,还可二次创作

在令人叹为观止方面,OpenAI 从不令人失望。

去年 1 月 6 日,OpenAI 发布了新模型 DALL·E,不用跨界也能从文本生成图像,打破了自然语言与视觉次元壁,引起了 AI 圈的一阵欢呼。

时隔一年多后,DALL·E 迎来了升级版本——DALL·E 2。

与 DALL·E 相比,DALL·E 2 在生成用户描述的图像时具有更高的分辨率和更低的延迟。并且,新版本还增添了一些新的功能,比如对原始图像进行编辑。

不过,OpenAI 没有直接向公众开放 DALL·E 2。目前,研究者可以在线注册预览该系统。OpenAI 希望以后可以将它用于第三方应用程序。

试玩 Waitlist 地址:https://labs.openai.com/waitlist

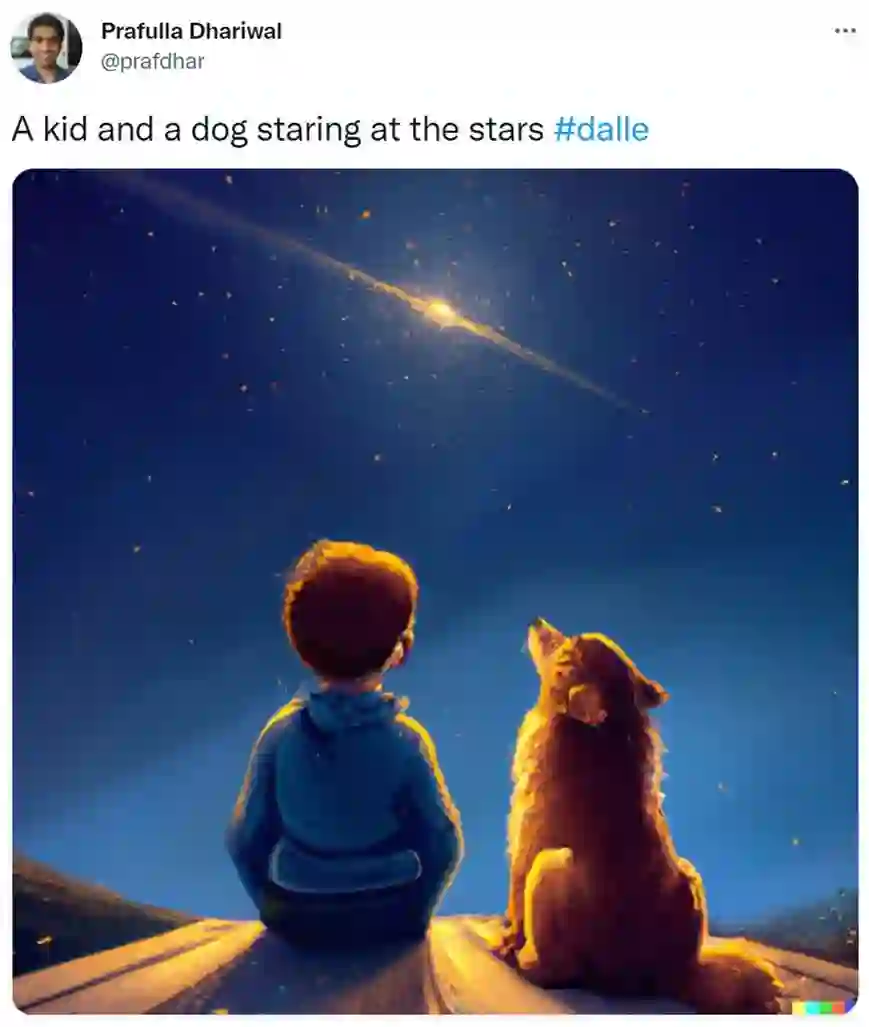

OpenAI 还公布了 DALL·E 2 的研究论文《Hierarchical Text-Conditional Image Generation with CLIP Latents》,OpenAI 研究科学家、共同一作 Prafulla Dhariwal 表示,「这个神经网络真是太神奇了,根据文本描述就能生成对应图像。」

论文地址:https://cdn.openai.com/papers/dall-e-2.pdf

网友纷纷晒出了使用 DALL·E 2 生成的图像,比如玩滑板的熊猫靓仔。

又比如席地而坐看星空的小孩和小狗。

DALL·E 2 生成艺术大作

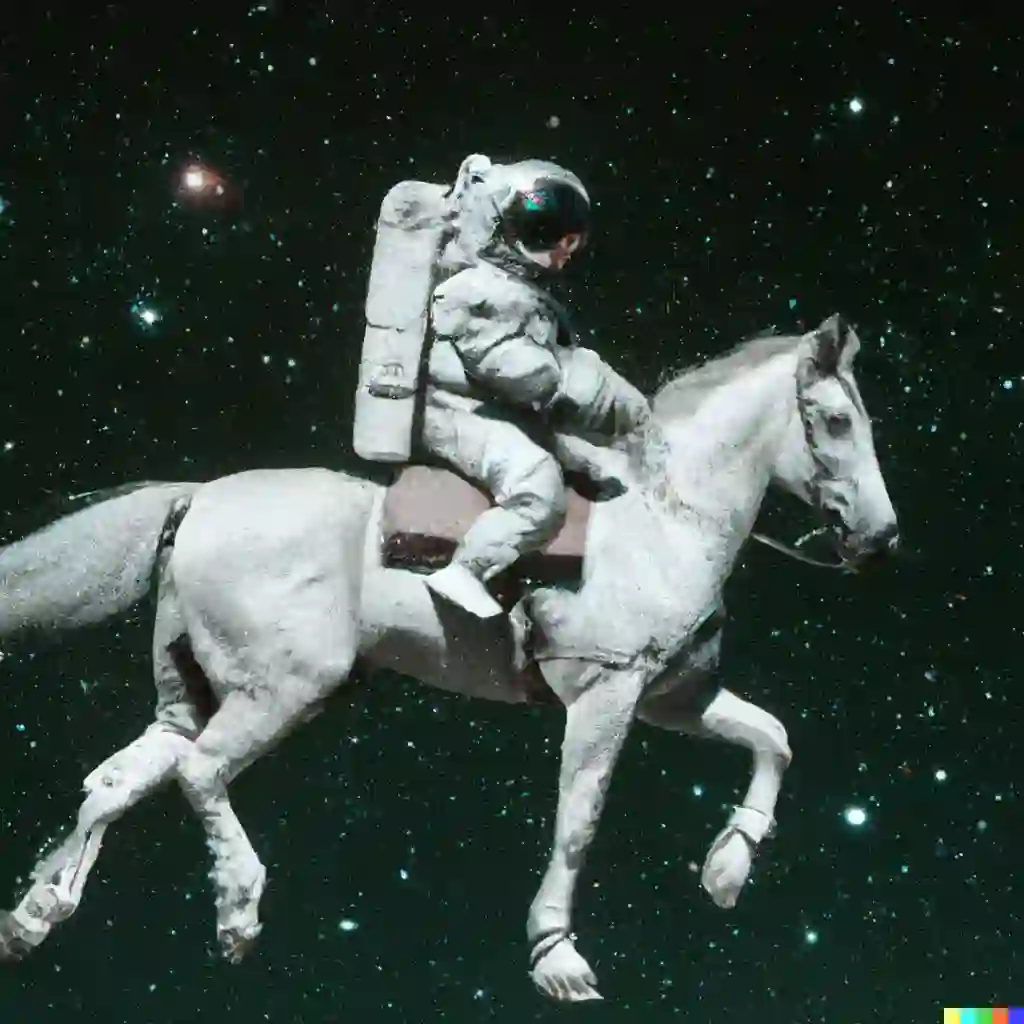

DALL·E 2 的表现如何呢?我们先睹为快。首先,DALL·E 2 可以从文本描述中创建原始、逼真的图像和艺术,它可以组合概念、属性和风格进行图像生成。例如一位骑着马的宇航员:

生成的图像可不止一张(官网示例给出 10 张),它还能生成下图这样的(一位骑着马的宇航员),真是风格多变:

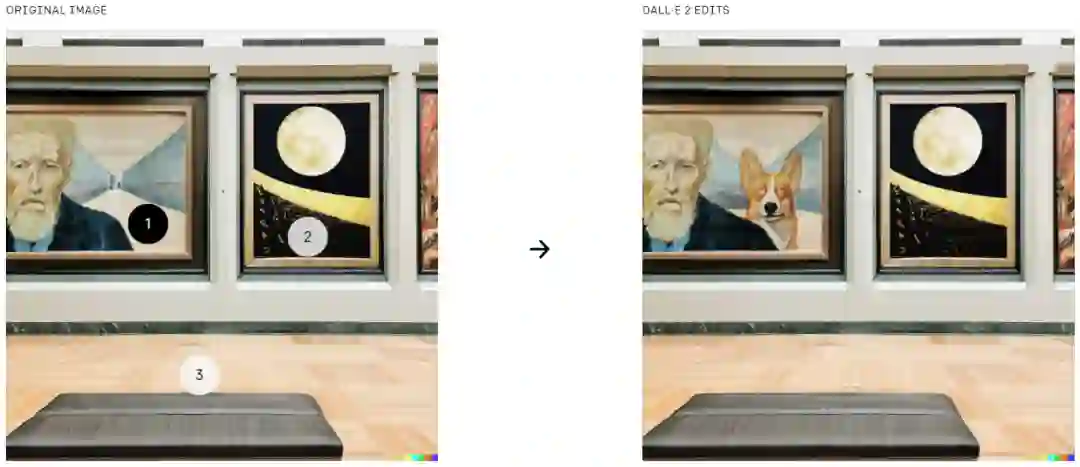

DALL·E 2 可以根据自然语言字幕对现有图像进行编辑。它可以在考虑阴影、反射和纹理的同时添加和删除元素。如下图所示,左边是原始图像,右边是 DALL·E 2 编辑后的图像。两张图对比后,我们发现左图中有数字 1、2、3,点击相应的位置,可以添加元素例如柯基犬,下图选择在 1 处添加柯基犬。

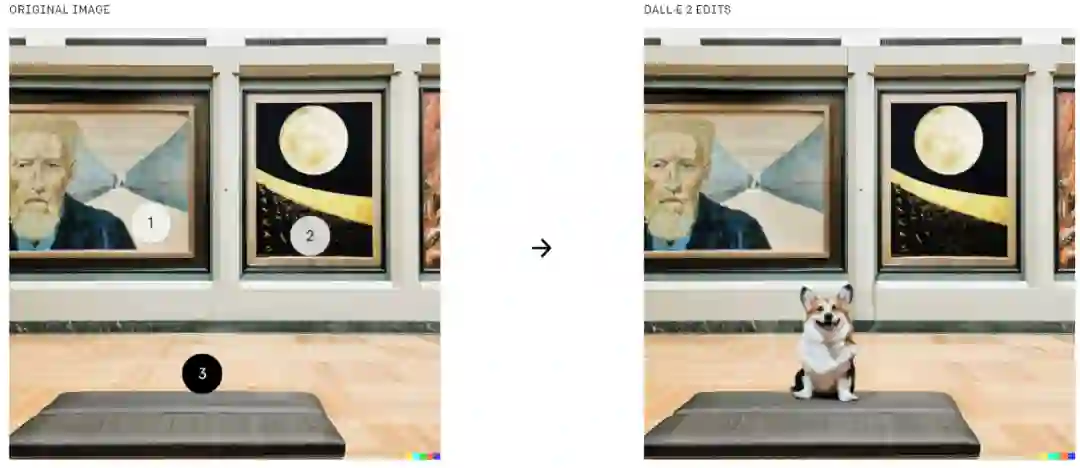

你也可以在 3 处添加一只柯基犬。

DALL·E 2 可以根据原图像进行二次创作,创造出不同的变体:

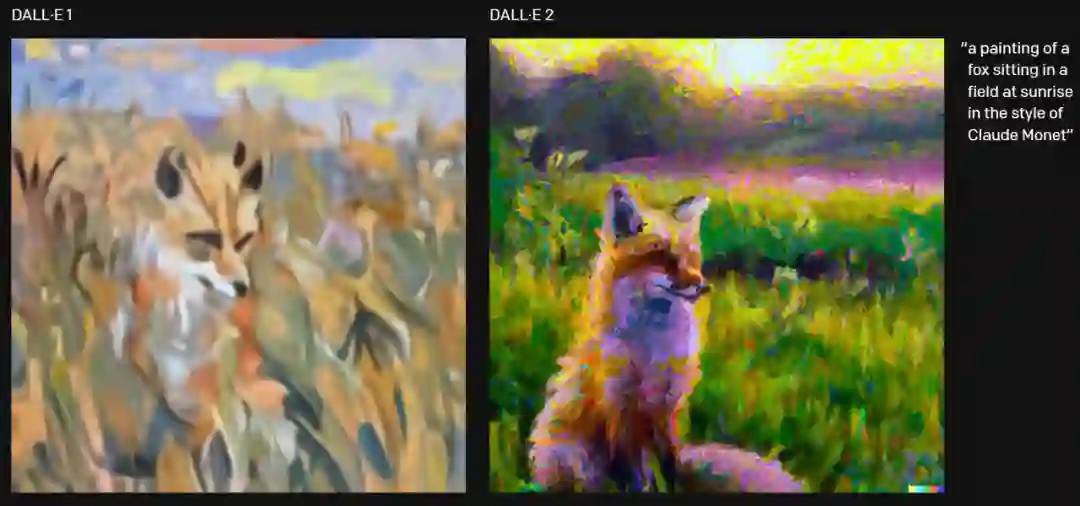

你可能会问,DALL·E 2 比一代模型到底好在哪?简单来说 DALL·E 2 以 4 倍的分辨率生成更逼真、更准确的图像。例如下图生成一幅「日出时坐在田野里的狐狸,生成的图像为莫奈风格。」DALL·E 2 生成的图像更准确。

看完上述展示,我们可以将 DALL·E 2 的特点归结如下:DALL·E 2 的一项新功能是修复,在 DALL·E 1 的基础上,将文本到图像生成应用在图像更细粒度的级别上。用户可以从现有的图片开始,选择一个区域,让模型对图像进行编辑,例如,你可以在客厅的墙上画一幅画,然后用另一幅画代替它,又或者在咖啡桌上放一瓶花。该模型可以填充 (或删除) 对象,同时考虑房间中阴影的方向等细节。

DALL·E 2 的另一个功能是生成图像不同变体,用户上传一张图像,然后模型创建出一系列类似的变体。此外,DALL·E 2 还可以混合两张图片,生成包含这两种元素的图片。其生成的图像为 1024 x 1024 像素,大大超过了 256 x 256 像素。

生成模型的迭代

DALL·E 2 建立在 CLIP 之上,OpenAI 研究科学家 Prafulla Dhariwal 说:「DALL·E 1 只是从语言中提取了 GPT-3 的方法并将其应用于生成图像:将图像压缩成一系列单词,并且学会了预测接下来会发生什么。」

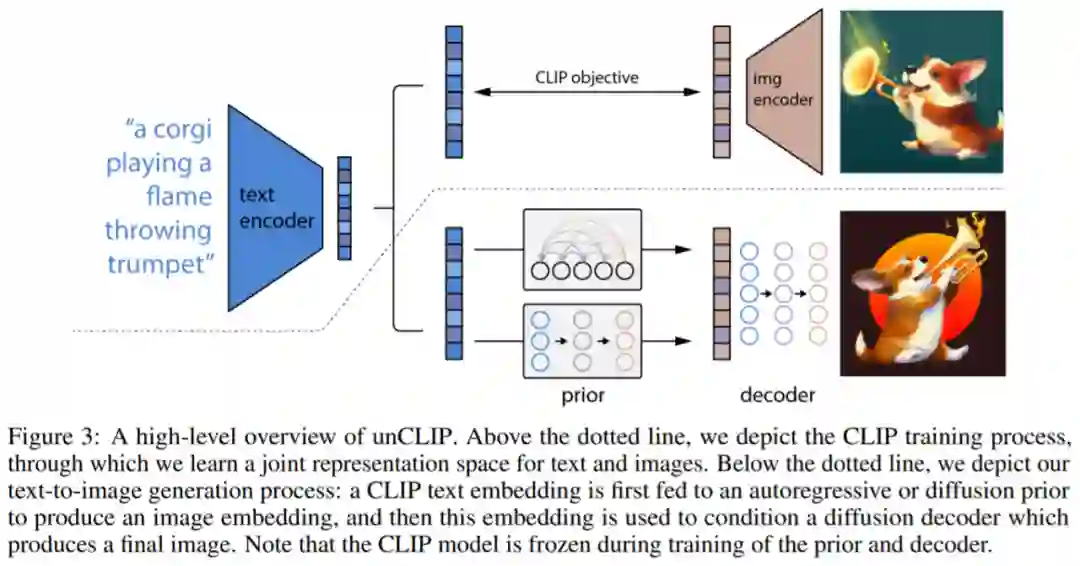

这是许多文本 AI 应用程序使用的 GPT 模型。但单词匹配并不一定能符合人们的预期,而且预测过程限制了图像的真实性。CLIP 旨在以人类的方式查看图像并总结其内容,OpenAI 迭代创建了一个 CLIP 的倒置版本——「unCLIP」,它能从描述生成图像,而 DALL·E 2 使用称为扩散(diffusion)的过程生成图像。

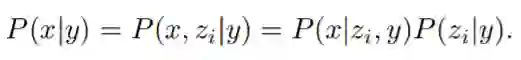

训练数据集由图像 x 及其对应的字幕 y 对 (x, y) 组成。给定图像 x, z_i 和 z_t 分别表示 CLIP 图像和文本嵌入。OpenAI 生成堆栈以使用两个组件从字幕生成图像:

先验 P(z_i |y) 生成以字幕 y 为条件的 CLIP 图像嵌入 z_i;

解码器 P(x|z_i , y) 以 CLIP 图像嵌入 z_i(以及可选的文本字幕 y)为条件生成图像 x。

解码器允许研究者在给定 CLIP 图像嵌入的情况下反演图像(invert images),而先验允许学习图像嵌入本身的生成模型。堆叠这两个组件产生一个图像 x 、给定字幕 y 的生成模型 P(x|y) :

DALL·E 的完整模型从未公开发布,但其他开发人员在过去一年中已经构建了一些模仿 DALL·E 功能的工具。最受欢迎的主流应用程序之一是 Wombo 的 Dream 移动应用程序,它能够根据用户描述的各种内容生成图片。

OpenAI 已经采取了一些内置的保护措施。该模型是在已剔除不良数据的数据集上进行训练的,理想情况下会限制其产生令人反感的内容的能力。

为避免生成的图片被滥用,DALL·E 2 在生成的图片上都标有水印,以表明该作品是 AI 生成的。此外,该模型也无法根据名称生成任何可识别的面孔。

DALL·E 2 将由经过审查的合作伙伴进行测试,但有一些要求:禁止用户上传或生成「可能造成伤害」的图像。他们还必须说明用 AI 生成图像的作用,并且不能通过应用程序或网站将生成的图像提供给其他人。

但 OpenAI 希望稍后再将 DALL·E 2 其添加到该组织的 API 工具集中,使其能够为第三方应用程序提供支持。Dhariwal 说:「我们希望分阶段进行这个过程,以从获得的反馈中不断评估如何安全地发布这项技术。」

参考链接:

https://openai.com/dall-e-2/

https://www.theverge.com/2022/4/6/23012123/openai-clip-dalle-2-ai-text-to-image-generator-testing

© THE END

转载请联系本公众号获得授权

投稿或寻求报道:content@jiqizhixin.com