清华等世界12所顶尖高校学霸组团「打王者」,竟是为了搞科研?

新智元报道

新智元报道

编辑:好困 桃子

【新智元导读】见过学霸打王者的样子吗?这不,清华、中科大、耶鲁等世界12所顶尖高校学霸集结,一来打王者,二来搞科研。

之前凑在一起「打王者」的学霸又来了!

成都大运会开幕在即,「世界大学生数智竞技邀请赛」正式启动。

国际级规模的大赛共邀请了12支队伍(包含中国大陆地区4所高校、中国港澳台地区及海外8所高校)参加。

每支队伍都需要训练三位英雄,并在之后让自己的AI进行「3V3」的对战,而获得冠军的团队可获得高达20万的奖金。

在此前的1V1中,各大高校的AI各种「骚操作」不断。

比如,丝血完成反杀之后,又闪现进塔的蓝方貂蝉。

在这背后默默提供支持的,正是以「强化学习」为基础,《王者荣耀》和腾讯AI Lab共同研发的AI开放研究平台 —— 开悟。

不过,为什么是强化学习?

强化学习和游戏有什么关系?

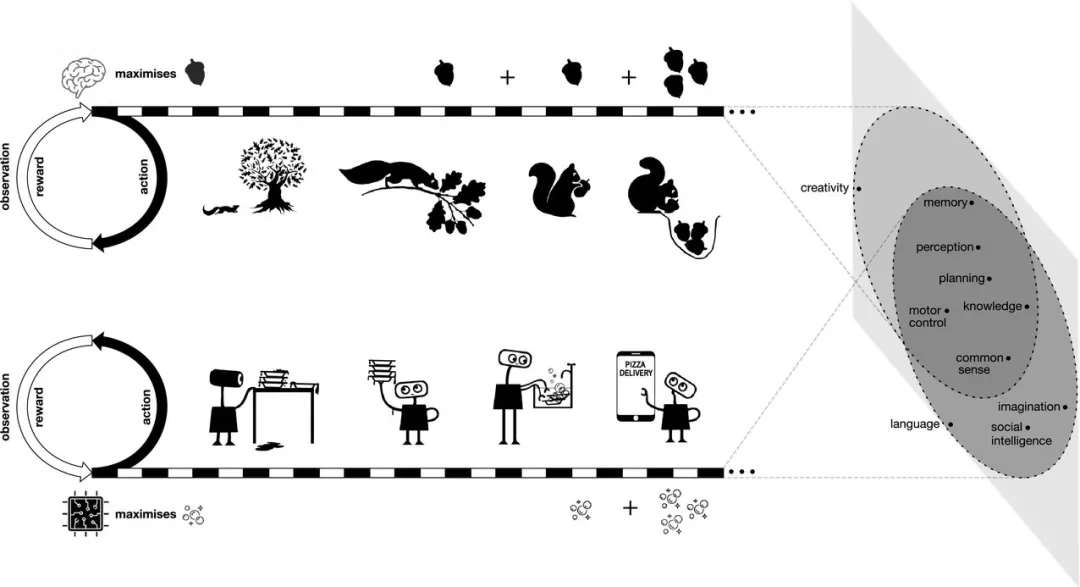

强化学习(Reinforcement Learning)是除了监督学习和非监督学习之外的第三种基本的机器学习方法。一定程度上,一些复杂的强化学习算法在具备解决复杂问题的通用智能,可以在围棋和电子游戏中达到人类水平,算是现阶段人工智能领域研究中的一门「必修课」。

举个例子,不知道大家还记不记得曾经风靡一时的Flappy Bird吗,这其实就是一个典型的强化学习场景:

1. 智能体——小鸟

2. 与智能体进行交互的「环境」——参差不齐的水管

3. 智能体可能做出的「动作」——向上飞一下或者什么都不做

4. 智能体采取的行动所遵循的「策略」——为躲避水管而采取行动的概率

5. 智能体在采取行动时得到的「奖励」——飞得越远得分就越高

环境会给智能体一个观测值,智能体接收到环境给的观测值之后会做出一个动作, 这个动作给予一个奖励,以及给出一个新的观测值。智能体根据环境给予的奖励值去更新自己的策略。

最终,智能体能通过强化学习找到一种方法,使自己从系统的每个状态中提取的平均价值最大化。

虽然早在上世纪50年代,强化学习的相关理论就已经开始成形。但真正走入到大众的视野之中,还是要靠着「游戏」。

2016年1月,DeepMind的围棋AI——AlphaGo登上《Nature》封面:Mastering the game of Go with deep neural networks and tree search(通过深度神经网络和搜索树,学会围棋游戏)。

通过利用强化学习的Value Networks(价值网络)和 Policy Networks(策略网络),AlphaGo可以实现棋盘位置的评估,以及步法的选择。

两个月后,AlphaGo在和李世石的对战中实现惊天逆转,取得胜利。

看到AlphaGo的成功,OpenAI直呼厉害!

于是在2016年11月,OpenAI Five正式立项。

虽然相比于更加正经的围棋来说,玩《Dota 2》的OpenAI Five感觉完全是在「不务正业」。但实际上,后者的难度其实要高得多:

OpenAI Five需要从8000到80000个动作中做出选择,其中每一步还需观察约16000个值。相比之下,国际象棋中平均的可行动作是35个,围棋是250个。

经过近3年的训练,OpenAI Five在2019年以2:0击败了世界冠军团队。

同年,DeepMind也祭出了自己潜心打造的AlphaStar,在《星际争霸2》中以5比0的比分,击败了顶尖的职业级玩家。

当然,除了利用已有的游戏场景训练强化学习智能体以外,也可以从0打造「训练基地」。

2021年,在斯坦福教授李飞飞的带领下,研究小组创建了一个计算机模拟的「游乐场」——DERL(深度进化强化学习)。

在这篇刊登在《自然通讯》上的论文中,团队设置了一个虚拟空间,并将简单的模拟生物放入其中。当然,这些生物只是一些通过「随机方式」进行移动的「几何图形」(Unimal)。

这些Unimal生长在不同的星球中,星球中充满了「起伏的山丘」和「低矮的障碍物」,他们在更加激烈的环境中展开竞争。

Unimal必须通过这些多变的地形,并将一个块状物移动到目标位置,而只有胜者才能继续产生后代。

李飞飞的这项研究也位学界带来了一种新的思路:当我们不知道该如何设计执行特殊任务的机器人时,不妨在强化学习的环境中让它们自己「进化」出合适的形态。

说到这里其实已经不难看出,不管是顶级的公司,还是大学的教授都在利用游戏+强化学习的形式来探索人工智能新的边界。

在如此重要的领域里,怎么能少了中国团队的身影。

于是乎,王者荣耀AI正式发布。

与《Dota2》和《星际争霸2》类似,在《王者荣耀》中玩家的动作状态空间高达10的20000次方,远远大于围棋及其他游戏,甚至超过整个宇宙的原子总数(10的80次方)。

王者荣耀AI产品可以分为两个部分:「打游戏」的王者绝悟以及「造绝悟」的开悟平台。

王者绝悟,简单来说就是《王者荣耀》版的OpenAI Five或AlphaStar,它是《王者荣耀》与腾讯AI Lab共同探索人工智能在游戏场景应用而推出的「策略协作型AI」。

其中,「策略」指的是AI能够通过获取到的信息,分析局势优化策略,做出更有利于获胜的行为。「协作」则指操作游戏内多个智能体(即多个不同的英雄)互相配合,协同推进博弈。

在2018年对战顶尖水平的非职业战队时,王者绝悟就表现出即时策略团队协作能力。

在对方团灭后,兵线还尚未到达,下路高地塔还有过半血量,王者绝悟果断选择四人轮流抗塔,无兵线强拆。

不过,在训练这些AI之前,首先得有一个可供训练的平台。

对于DeepMind和OpenAI来说,只需稍稍发挥一下自己的影响力就能在现成的游戏平台上开启「深度合作」模式。

然而,对于普通的研究者来说,想要在这些游戏上做研究就只能调用开放的接口了,体验上来讲肯定要差许多。

不过,以《王者荣耀》为模拟环境的开悟平台就不一样了,虽然也是基于游戏,但却是开放的。

再结合上算法、 数据、算力的优势,开悟平台可以为学术研究人员提供一个全栈打通的闭环科研验证环境。

除了可以提供「AI+游戏」的研究场景,以及大规模弹性算力来支撑AI的研究外,还有统一的强化框架来加速研发。

不仅如此,开悟平台还会提供通用的训练和推理服务,进一步加速AI的训练。

比如开篇提到的去年《王者荣耀》开悟AI赛事的1V1比拼中,清北、中科院、浙大等20余所高校,借助开悟平台提供的算法、算力、数据、场景等资源,训练出了自己的AI模型。

也许在观众看来,双方的比拼是一场操作水平的竞技。但是实际上,这是强化学习技术层面上的角逐 —— AI是如何应用大策略,比如何时进攻、何时撤退、在哪埋伏;以及微观数据判断 —— 比如血量的计算、出装、技能CD计算等等。

如果没有开悟平台的话,也许这些表面是电竞比拼,实际是科技水平对决的精彩比赛也就不复存在了。

但,可能又会有新的疑问出现了。

为何要在游戏中研究人工智能?

其实答案很简单。

最直接的原因就是AI可以构建建更动态有趣的游戏环境和更灵活多变的游戏角色,提升游戏制作效率和玩家的游戏体验。

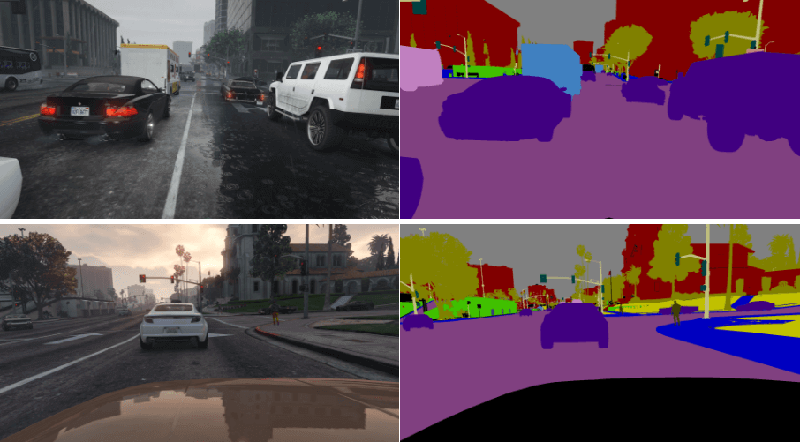

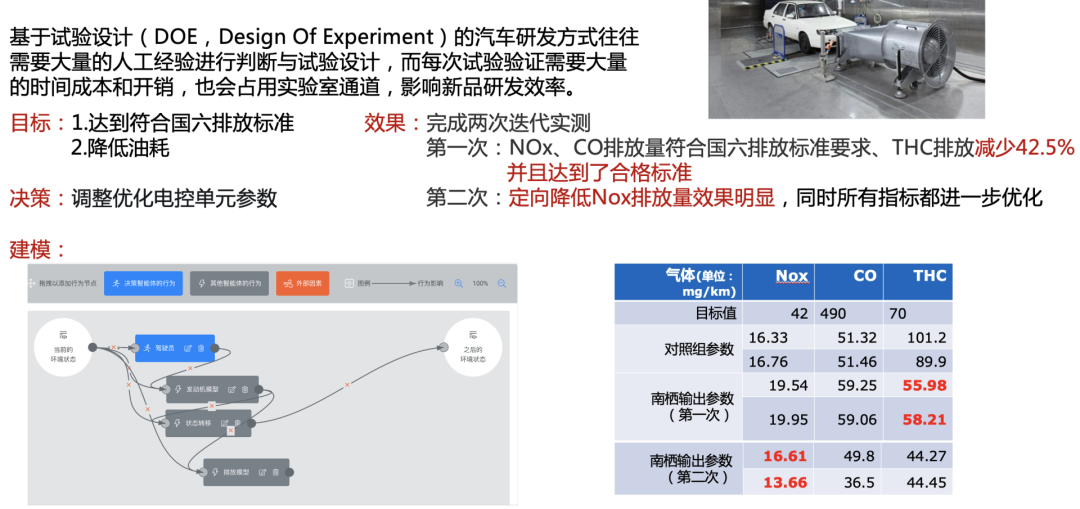

当然,更重要的意义是将人工智能技术应用于诸如医疗、制造、无人驾驶、城市管理等现实生活中的领域。

而游戏则为AI技术研发提供了具有明显优势的虚拟实验环境:

-

提供易于量化的训练和评估指标

-

难度接近甚至超过很多现实任务

-

更快的速度、更低的成本

-

更多场景、更加安全

AGI会在游戏里诞生吗?