【ICLR2022】通过传播网络代码学习通用的神经结构

论文题目:Learning Versatile Neural Architectures by Propagating Network Codes

作者:丁明宇,霍宇琦,卢浩宇,杨林杰,王哲,卢志武,王井东,罗平

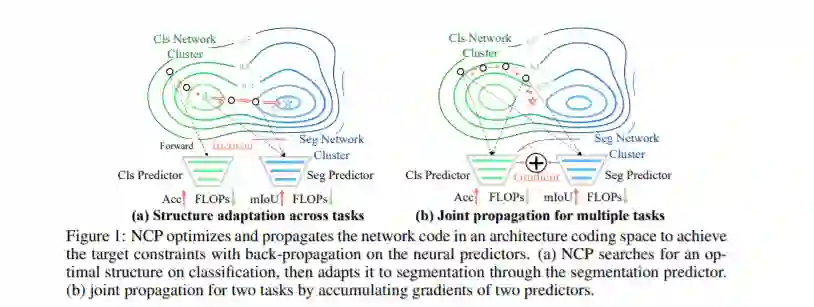

论文概述:这项工作探索了如何设计一个能够适应多种异构视觉任务的神经网络,例如图像分割、3D 目标检测和视频动作识别。因为不同任务中的网络架构搜索(NAS)空间和方法都是不一致的,这个问题非常具有挑战性。我们从两个方面解决这个问题。我们首先为多个任务设计了统一的网络空间,并在许多广泛使用的数据集上,包括 ImageNet、Cityscapes、KITTI 和HMDB51,来构建多任务的NAS基准(NAS-Bench-MR)。我们进一步提出了网络编码传播(NCP),它反向传播神经预测器的梯度,以沿着所需的梯度方向直接更新架构的编码,从而可以适用于多种任务和优化目标。

与通常专注于单个任务的现有的NAS技术不同,NCP 具有几个独特的优点。(1)NCP将架构优化从数据驱动转变为架构驱动,实现了在不同数据分布的多任务之间联合搜索架构。(2) NCP 从网络编码中而不是原始数据中学习,使其能够跨数据集有效地更新架构。(3) 除了我们的NAS-Bench-MR之外,NCP 在其他的NAS基准测试中表现良好,例如NAS-Bench-201。(4) NCP对任务间、跨任务和任务内的深入研究,即多任务神经架构和不同任务之间的架构转移,显示了跨任务神经架构设计的重要性。例如,在减少了17%的计算量的情况下,NCP 返回的单个网络架构在 ImageNet-50-1000 和 Cityscapes两个数据集上分别实现了86%的准确率和77.16%的 mIoU,优于其他对比方案。更有趣的是,在相同的计算量下,NCP 能够实现从语义分割架构转移到3D目标检测,并优于直接在 3D 检测上搜索的架构。

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“NCP” 就可以获取《【ICLR2022】通过传播网络代码学习通用的神经结构》专知下载链接