CSIG云上微表情第29期研讨会成功举办--[论文速览]见微知著–基于面孔线索的情感计算

微表情是一种短暂的、微弱的、无意识的面部微表情,持续时间往往在0.5s内,能够揭示人类试图隐藏的真实情绪。微表情识别的研究旨在让机器有足够的智能,能够从人脸视频序列中识别人类的真实情绪。然而由于微表情持续时间短、面部肌肉运动强度低,对其进行准确的表征与识别是一项极具挑战性的任务。为了促进心理学领域和计算机视觉领域针对微表情的进一步研究,由中国图象图形学学会(CSIG)和中国科学院心理研究所主办、CSIG机器视觉专业委员会和CSIG情感计算与理解专业委员会联合承办,中国科学院心理研究所的王甦菁博士组织了一系列云上微表情的学术活动。

-

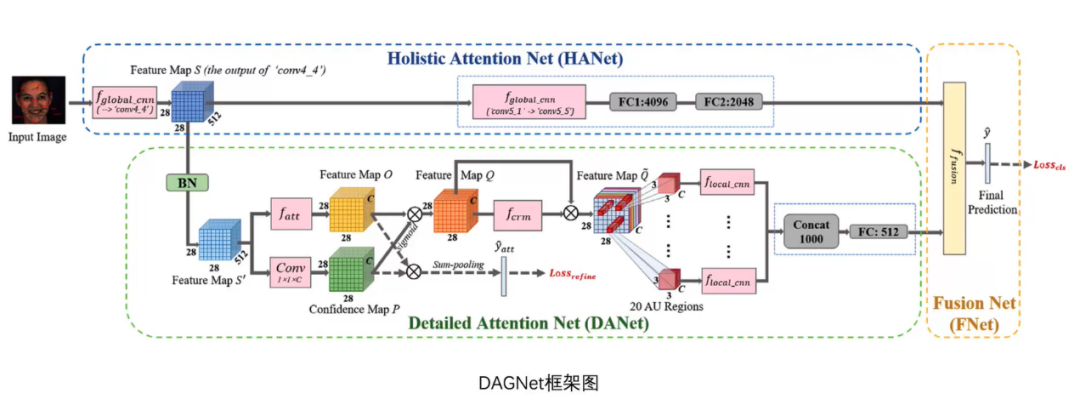

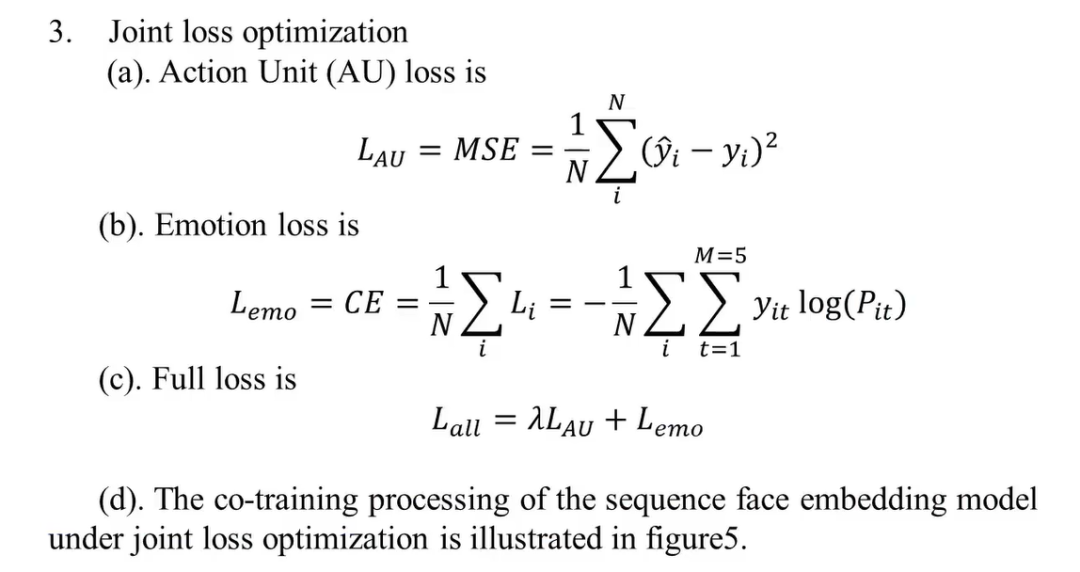

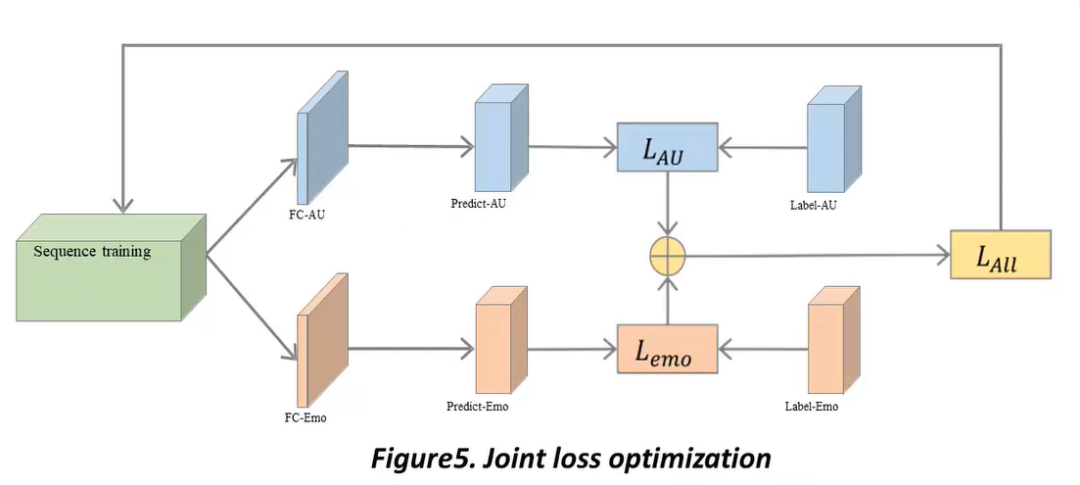

面部运动单元检测任务-北京交通大学在读硕士生宋文宇同学

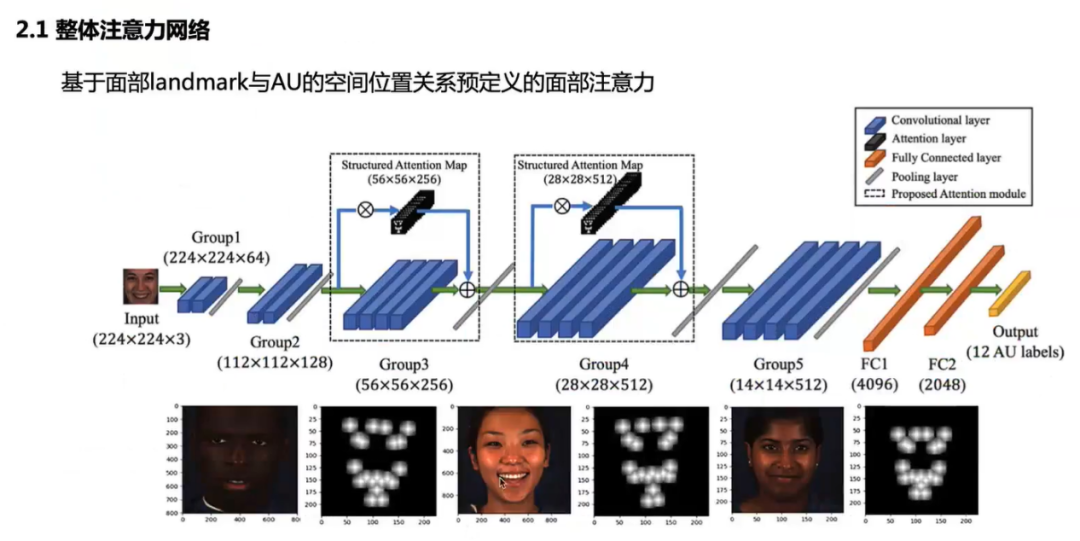

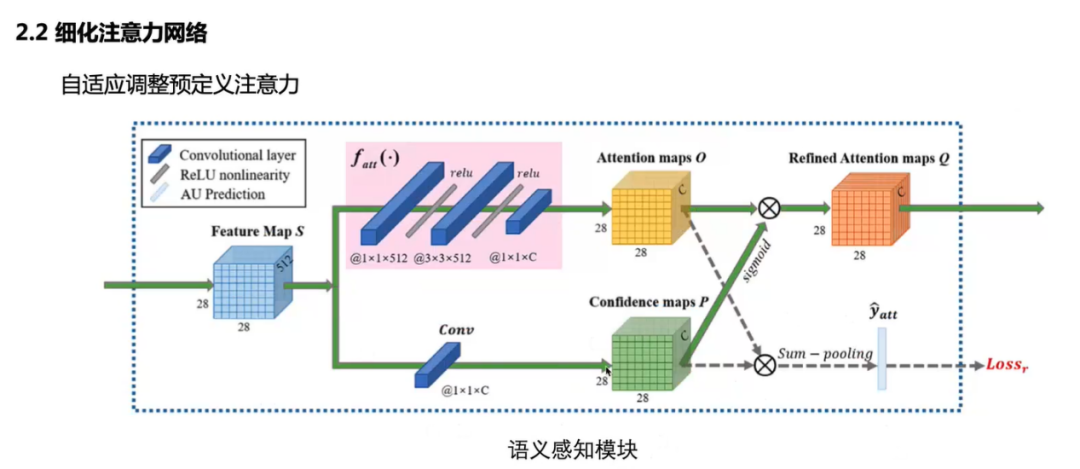

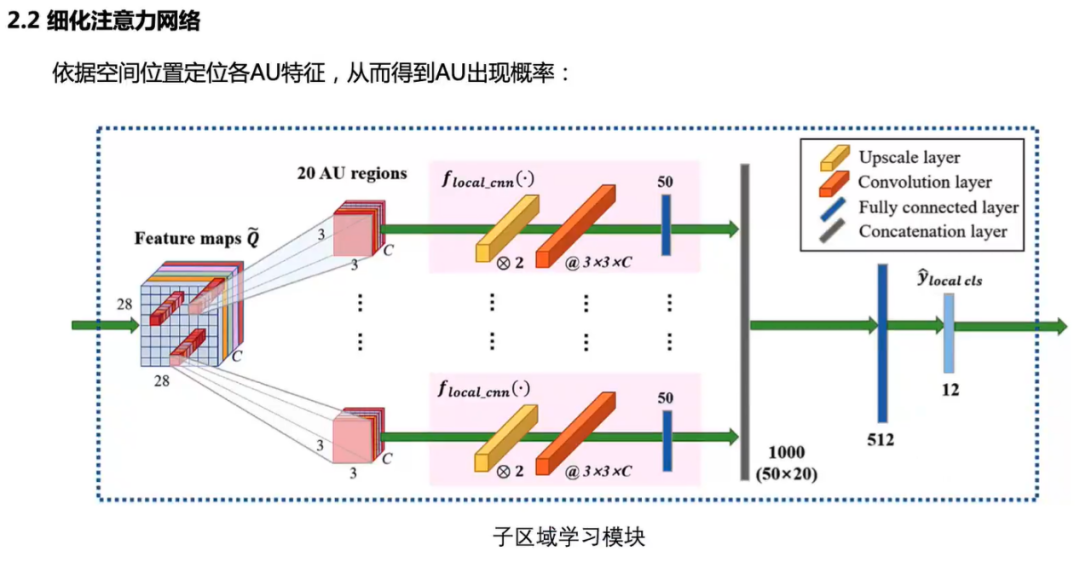

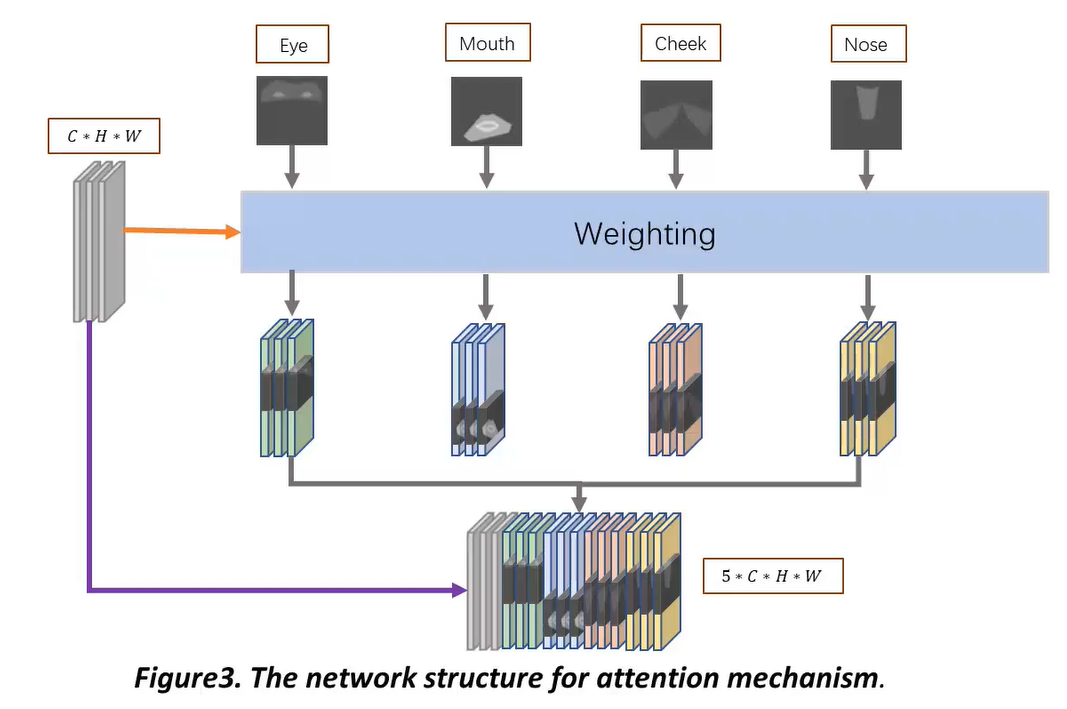

受注意力机制应用在各种视觉任务的启发,基于注意力的AU检测也得到了一定的发展。一方面,由于AU与相应的肌肉动作有关,每个AU的活动区域也相对有限。通常由面部landmark定义面部相关任务的空间位置。相关研究表明使用预定义的注意力机制来裁剪或增强面部区域对于面部AU检测任务来说是有帮助的。

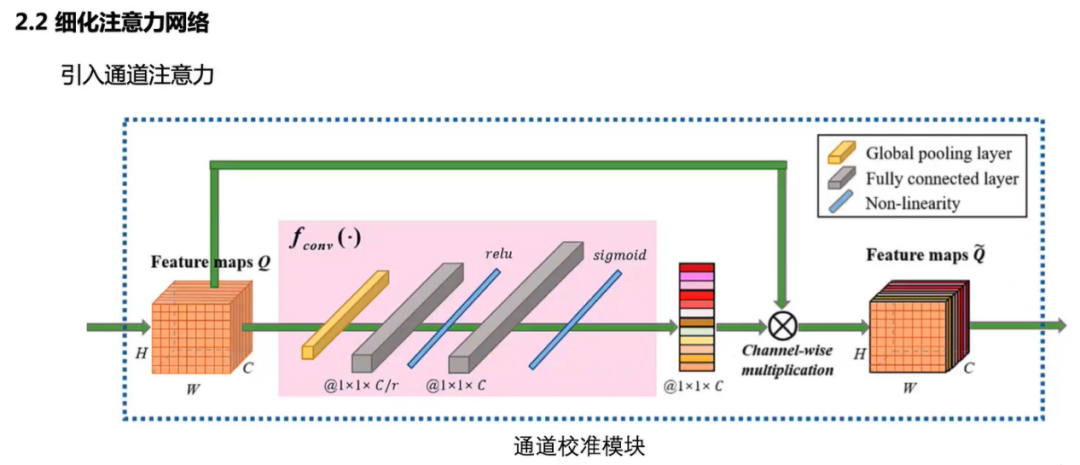

另一方面,如果将每个通道视为每个AU的对应特征,则可以通过对通道维度进行建模来自适应地调整每个AU的特征响应。

同时引入空间注意力和通道注意力可以在学习AU的空间位置的同时引入AU之间的依赖关系,这有助于面部AU的检测。

在AU检测领域常用的BP4D和DISFA数据集上进行了实验,验证了宋同学等人提出的DAGNet方法的有效性。

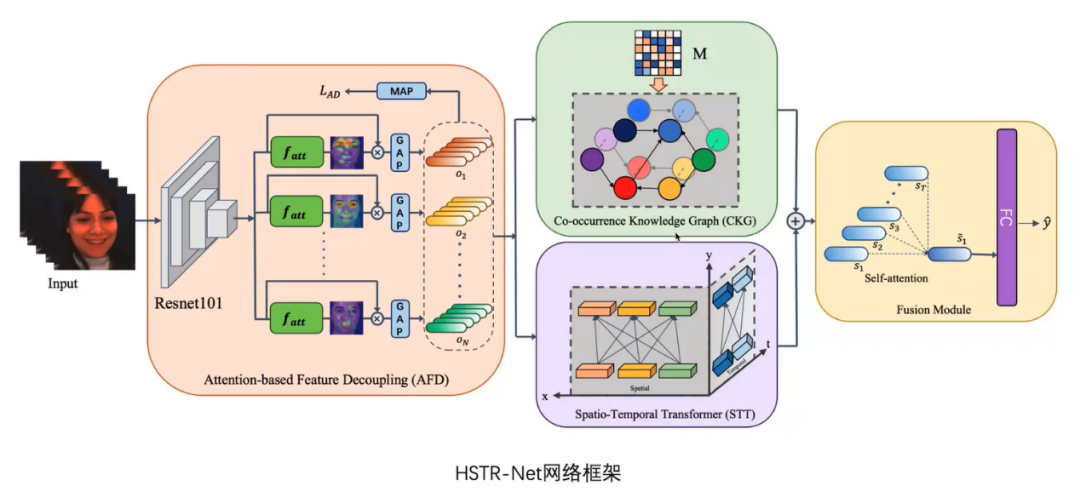

接下来,宋同学也介绍了她们正在审稿中的一项工作,即用于面部动作单元检测的异构时空关系学习网络。面部动作单元的时间关系和动作关系等属性使得AU检测不同于一般的多标签分类任务。因此,如何捕获AU的空间和时间共现成为提高检测精度的关键。在安高云教授的指导下,宋同学等人提出了一个异构的时空关系学习网络(HSTR-Net)来捕获AU的时空关系。网络框架如下所示:

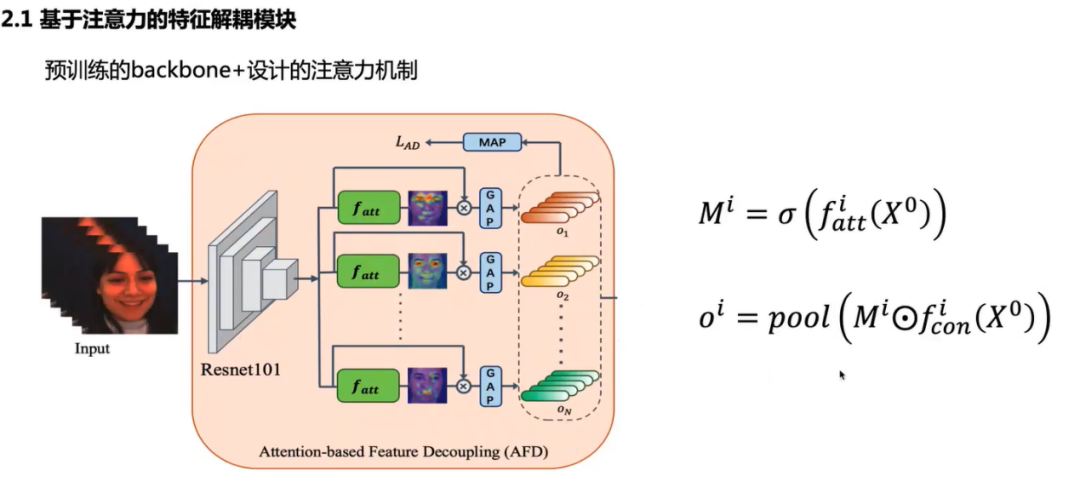

首先,宋同学介绍了基于注意力的特征解耦模块。

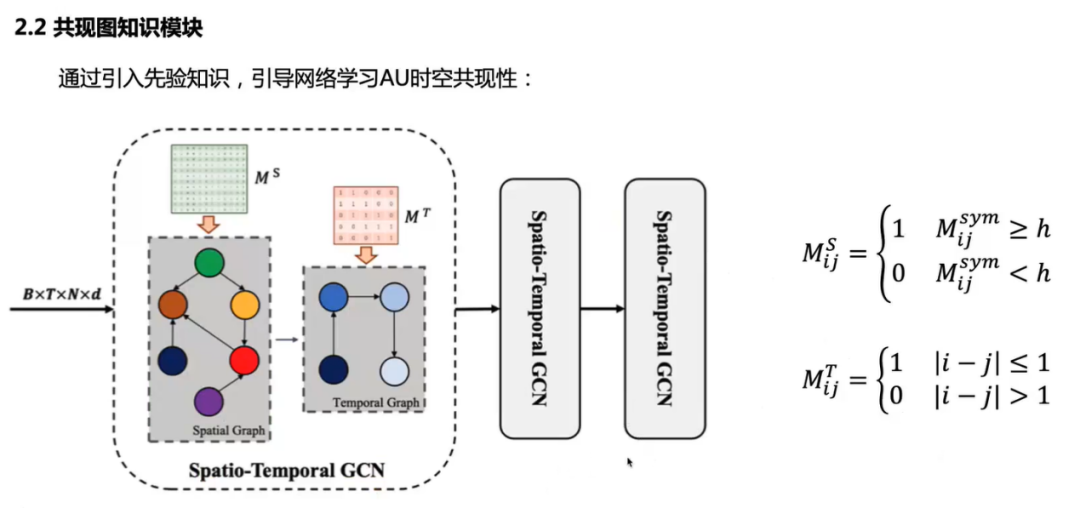

然后,共现知识图模块通过引入先验关系信息引导网络对时空关系进行建模:

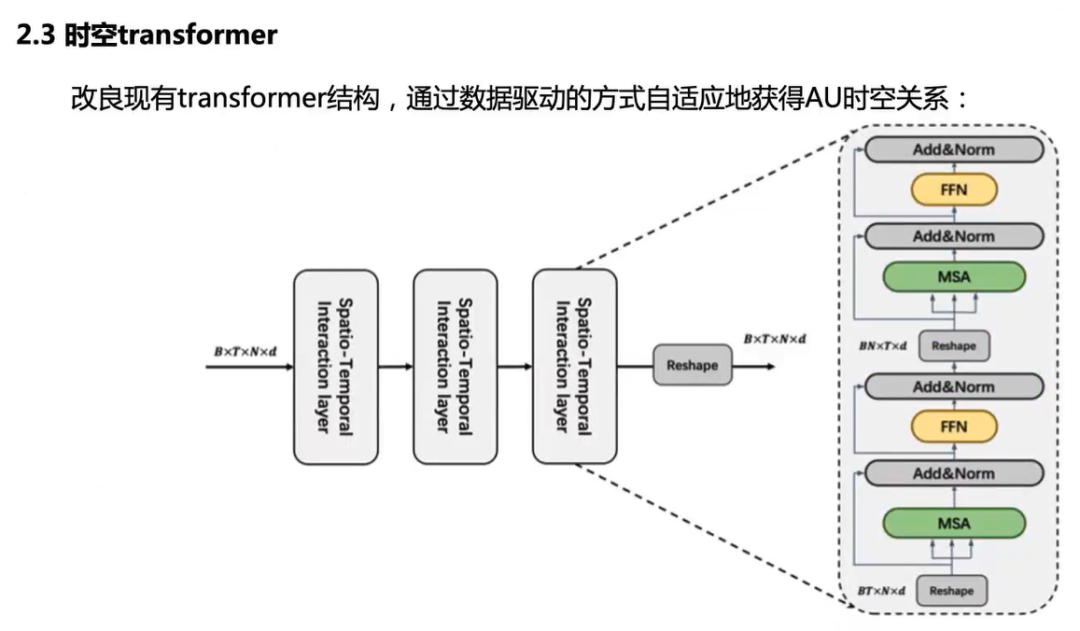

时空Transformer模块通过时空特征交互自适应地捕获时空关系。为了进一步建模AU之间的时间关系,在时间维度上利用自注意力机制融合AU特征。

在BP4D和DISFA数据集上进行的实验结果表明了宋同学等人所提方法的有效性。

[2] Song, W., Shi S., Dong, Y., & An, G. (2022). Heterogeneous Spatio-Temporal Relation Learning Network for Facial Action Unit Detection. 审稿中

微表情识别任务-合肥工业大学在读博士生王毅同学

在讲座的第二部分,王毅同学介绍了在汪萌教授和孙晓教授指导下完成的工作,即基于注意力机制和局部增强的微表情识别方法。

首先,王同学简要介绍了研究背景,包括微表情定义、潜在应用、研究挑战和所提解决方案。并且,王同学对目前主要的研究工作进行了总结。

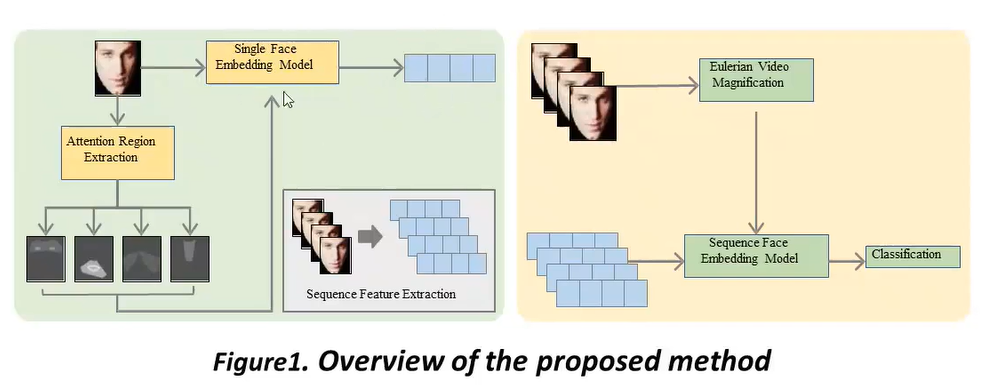

然后,王同学展示了主要的网络框架,如下图所示。

引入注意力机制来增强模型的表示性能,以提高识别精度。

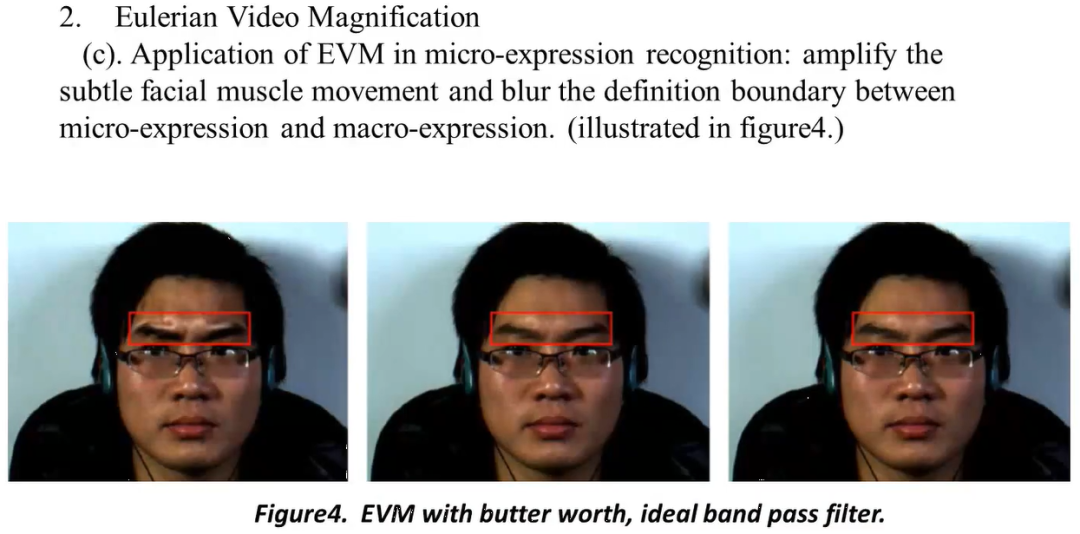

此外,在数据预处理中使用欧拉视频放大法来增强面部变化区域。

AffectNet被用来预训练一个带有注意力区域的面部兴趣区域(RoI)特征提取器。最后,王同学等人将面部RoI特征与全局面部特征相结合来识别微表情。

在两个常用的微表情数据集CASME II和SAMM上的实验结果,验证了王同学等人所提出的MER-AMRE框架的鲁棒性和通用性。

在问答环节,听众和讲者们就AU检测的评估标准、AU样本分布与时空Transformer的关系、基于欧拉放大的微表情识别的技术问题和数据库细节等问题进行了讨论。

在活动的最后,讲座的主持人李婧婷博士对活动进行了总结并对第三十期CSIG云上微表情活动进行了预告。敬请继续关注!

另外,主持人还介绍了将由ACM Multimedia2022举办的微表情研讨会。相关细节将会在网站上(https://megc2022.github.io)陆续发布,欢迎大家关注。

此次讲座的回放已经发布在B站:https://www.bilibili.com/video/BV19B4y1p7Ze?share_source=copy_web。

最后,中国科学院心理研究所微表情实验室(MELAB)诚聘博士后,微表情相关方向,计算机或心理学专业皆可,有意请联系王甦菁老师(wangsujing@psych.ac.cn)。