【CMU 2018 春季课程】深度学习——Bhiksha Raj 主讲(附 PPT 和 video)

新智元推荐

来源:专知

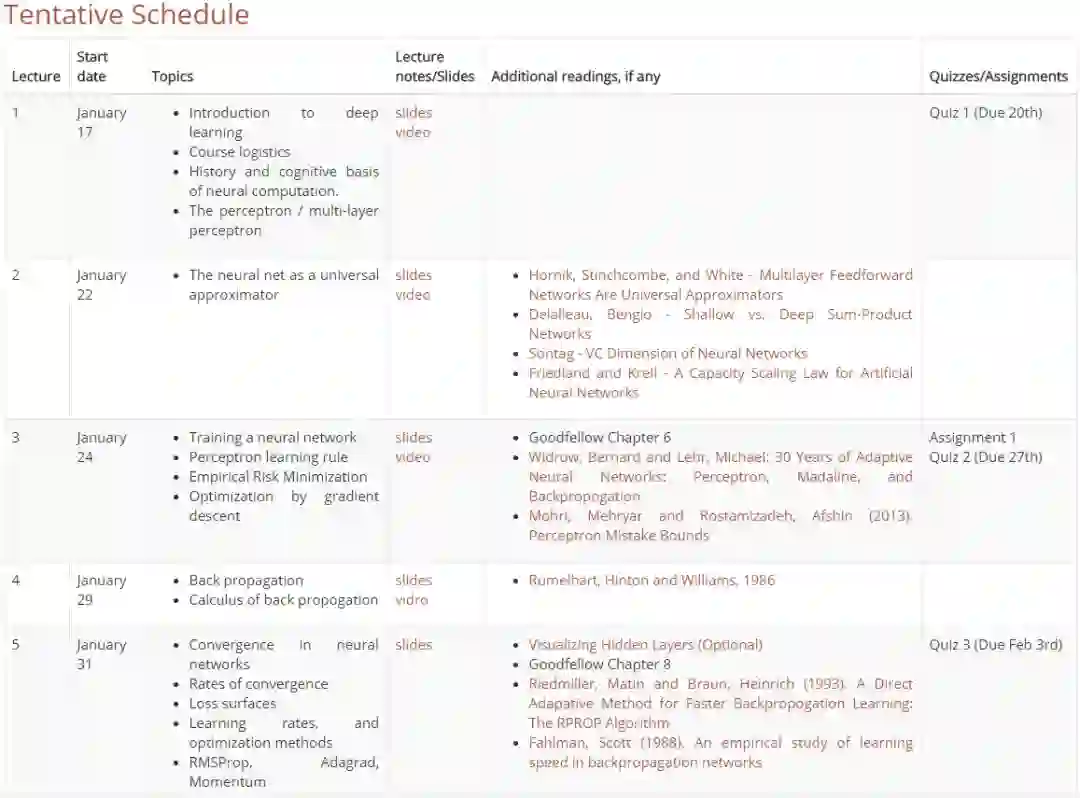

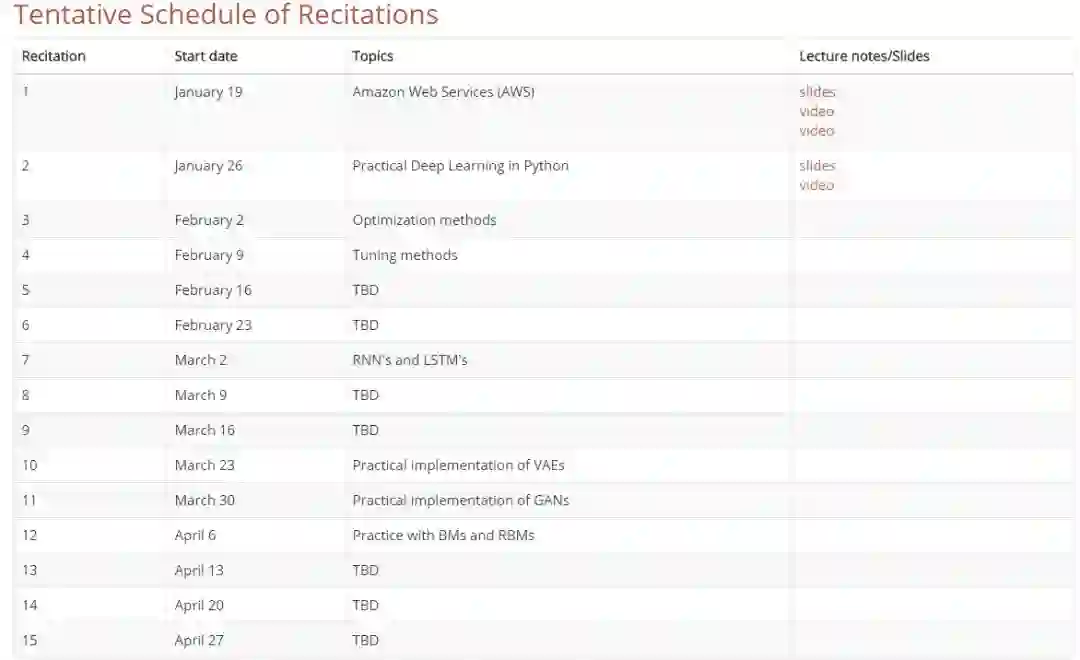

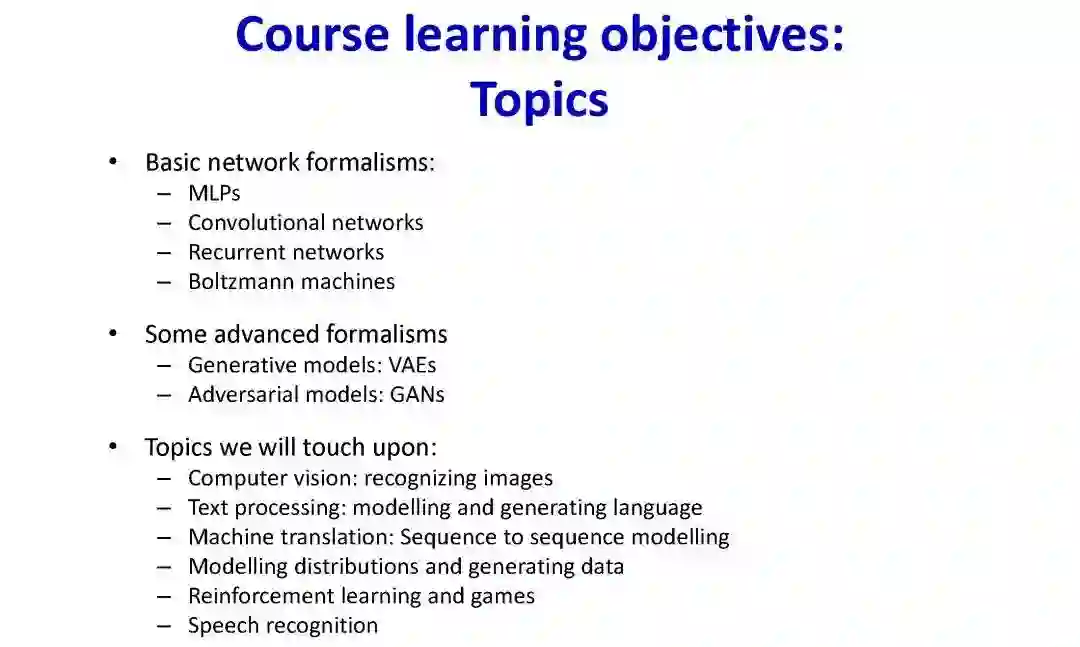

【新智元导读】卡耐基梅隆大学深度学习春季课程开课了!课程的主讲老师是卡耐基梅隆大学计算机学院的 BhikshaRaj,课程内容涵盖了深度学习的基础内容:深度学习介绍、反向传播、感知器、经验风险最小化、随机梯度下降等等,以及比较新的强化学习、对抗网络、深度 Q 学习等。在深度学习研究领域 CMU 一直走在世界前列,其课程几乎是深度学习入门首选材料,本文整理了课程的 slides 和 video,想要系统地学习并掌握深度学习的读者千万不要错过。

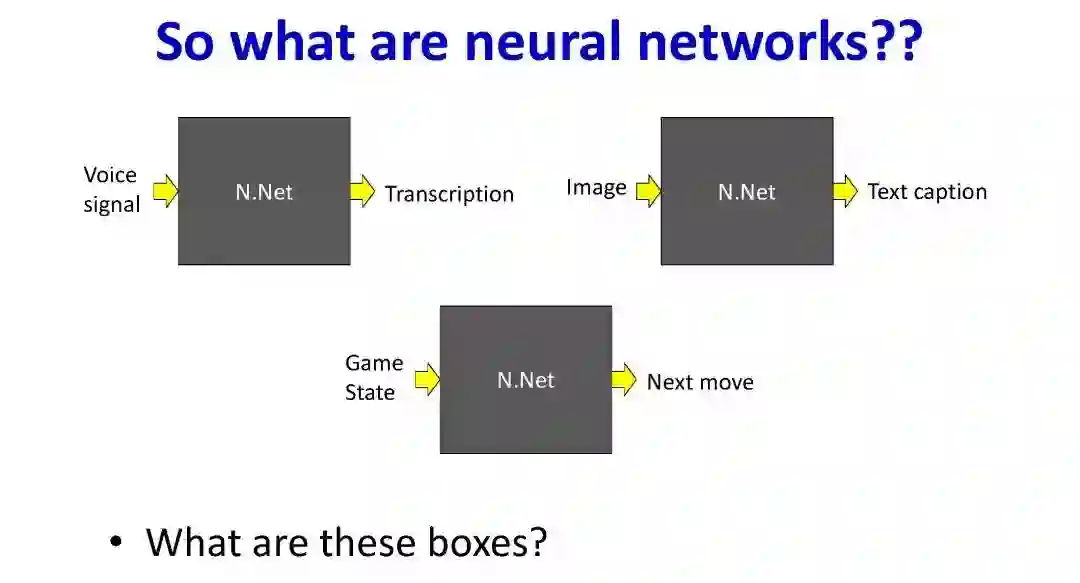

本文是对美国卡耐基梅隆大学(CMU)2017 年秋季课程——深度学习的介绍。深度学习” 系统,以深度神经网络为代表,逐渐占领了所有人工智能任务,包括语言理解、语音和图像识别、机器翻译、规划,甚至是游戏和自动驾驶。因此,掌握深度学习专业知识已经逐渐从高深莫测到现在许多高级学术问题中必须掌握的背景知识,现在深度学习人才在就业方向上也有很大的优势。

在本课程中,我们将学习深度神经网络的基础知识,以及它在各种 AI 任务中的应用。到课程结束时,学生将会对这个课题有很大的了解,并且能够将它应用到各种各样的任务。 学生还能了解当前该领域大量的文献,并通过进一步的研究扩展自己的专业知识。

教师:Bhiksha Raj(bhiksha@cs.cmu.edu)

课程时间:周一和周三,9.00am-10.20am

地点:Porter Hall 125C

阅读:周五,9.00am-10.20am, 地点: GHC 4307

我们将使用几个主流工具包之一(主要用的工具包是 PyTorch)。这个工具包大部分是用 Python 编程的。 您需要能够使用它进行编程。 或者,您必须找到你熟悉的语言对应的工具包进行编程。

你需要熟悉基本微积分(微分,链式规则),线性代数和基本概率知识。

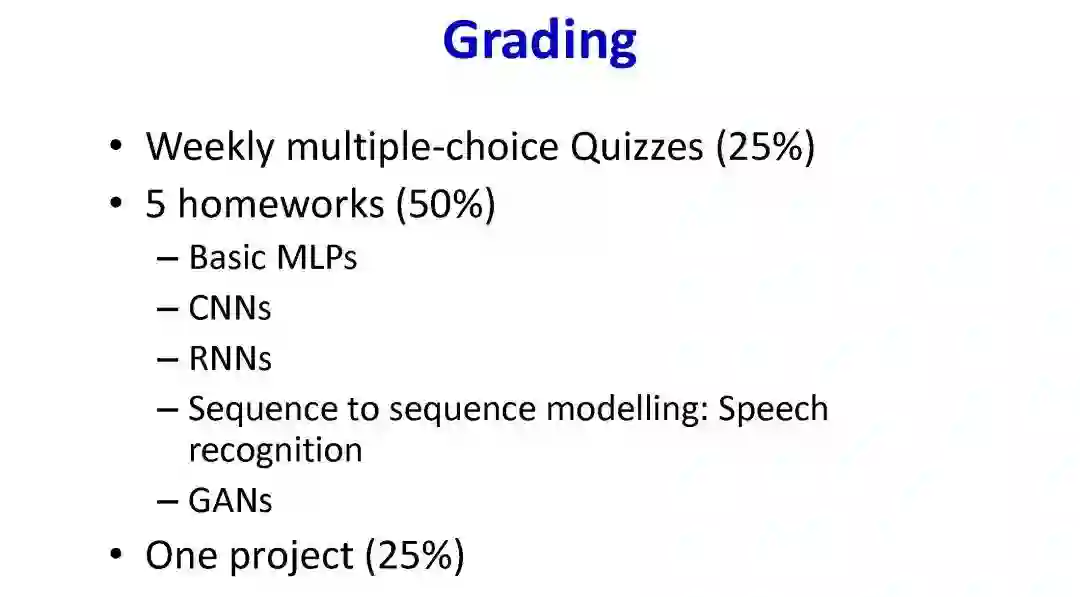

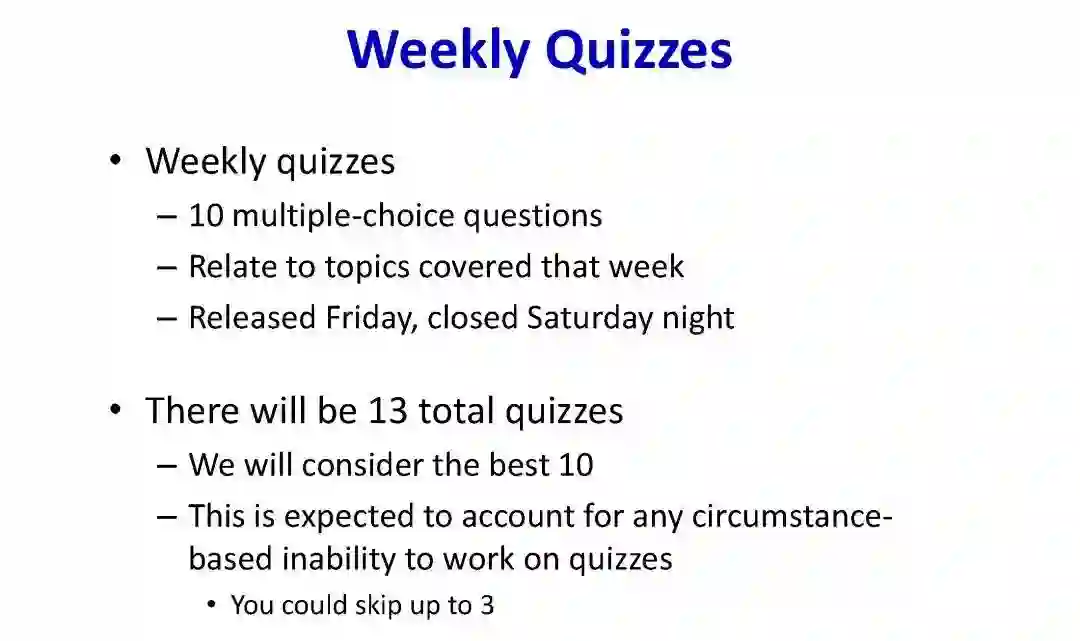

评分将以每周测试、家庭作业和期末项目为基础。

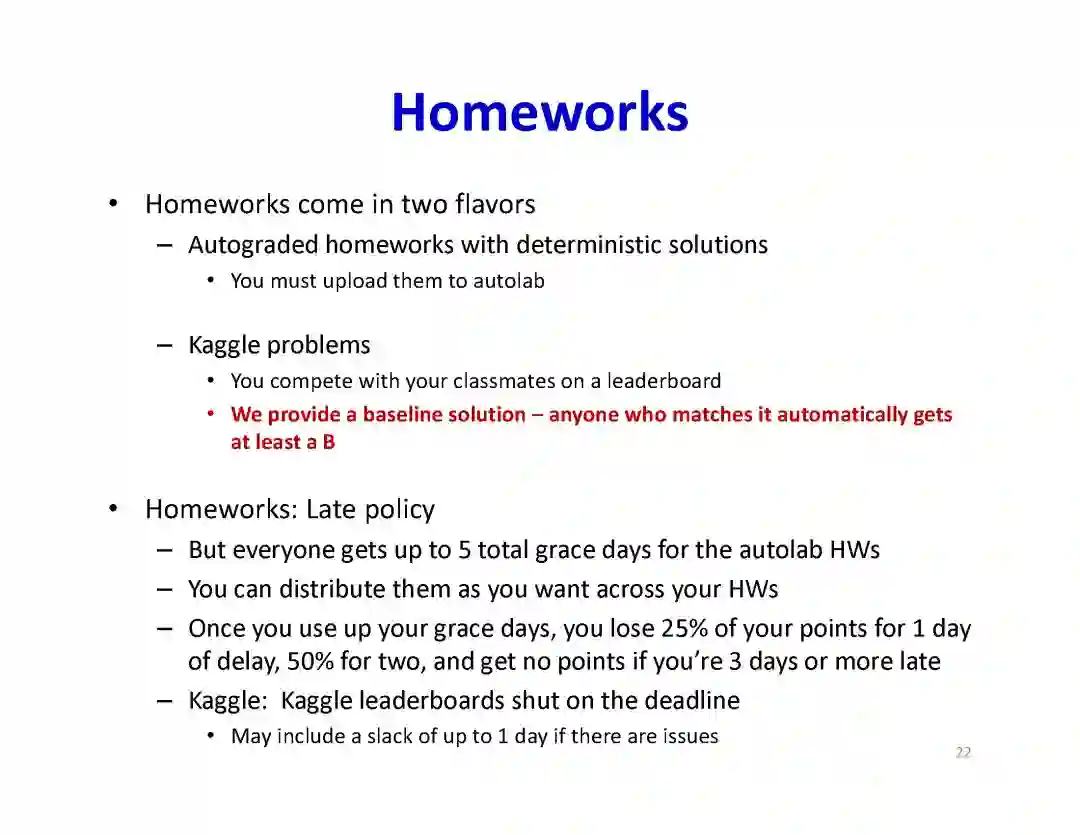

总共有五个作业,请注意作业 4 和 5 同时布置,也将在同一天到期。

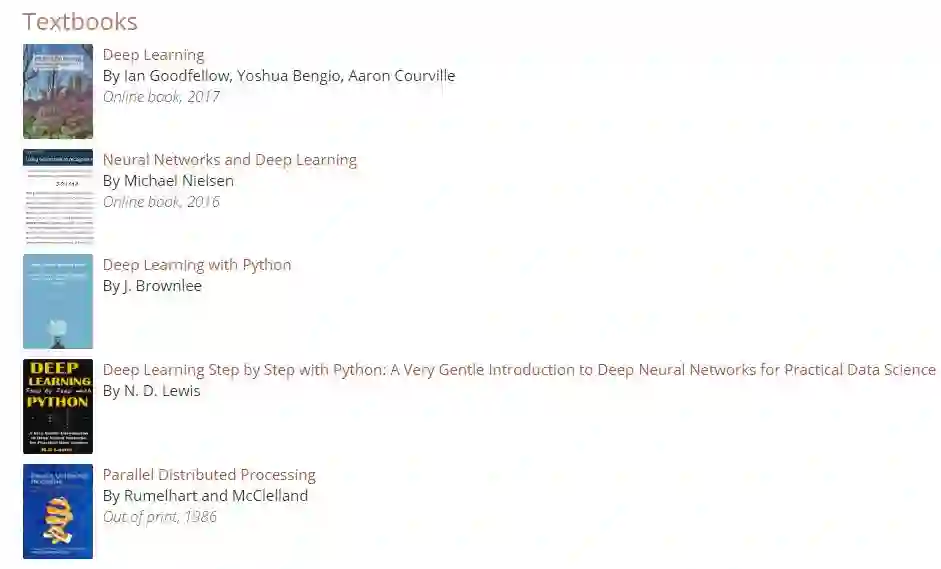

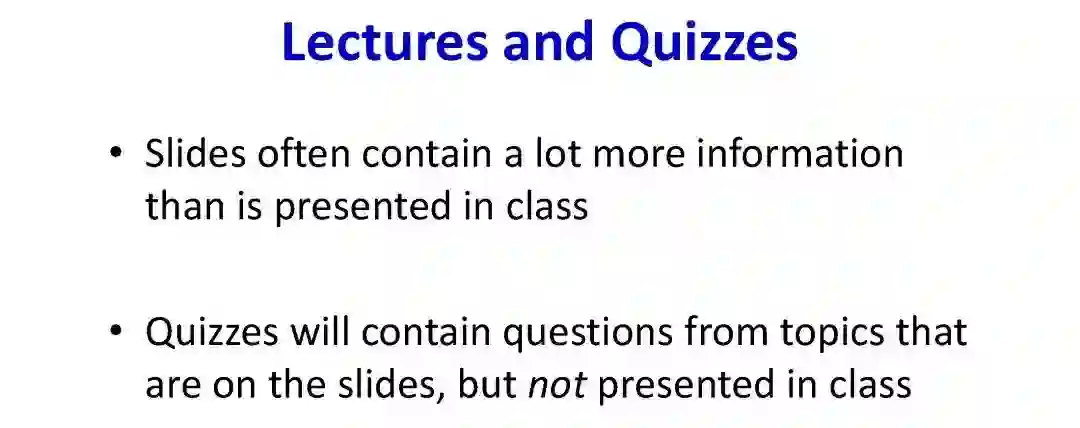

该课程不使用特定的某一本教材,而是会从许多资料中整理获得。 我们在本页末尾列出相关书籍。 我们也会为每个班级挂上相关的阅读材料。学生可以在课前熟悉这些材料。你阅读的时候可能会遇到障碍,但是不需要担心,我们会在课堂上进行简单的解释。

讨论板:Piazza

我们使用 Piazza 进行讨论,链接:http://piazza.com/cmu/spring2018/11785

Wiki 页面

我们已经创建了一个实验性的 wiki 来解释当今使用的神经网络的类型,链接:

https://www.contrib.andrew.cmu.edu/~dalud/deep-learning-wiki/doku.php

你也可以在这里找到一个很好的模型。如果你还不能完全理解 Wiki 上的许多体系结构,我们希望,在课程结束时,你将能够解释。

Kaggle

Kaggle 是一个流行的数据平台,参观者可以学习和分析一个数据集,竞争最佳模型。对于作业 4 和 5,您将把评估结果提交给 Kaggle 排行榜,Kaggle 链接:https://www.kaggle.com/

第 1 讲:

深度学习简介

课程安排

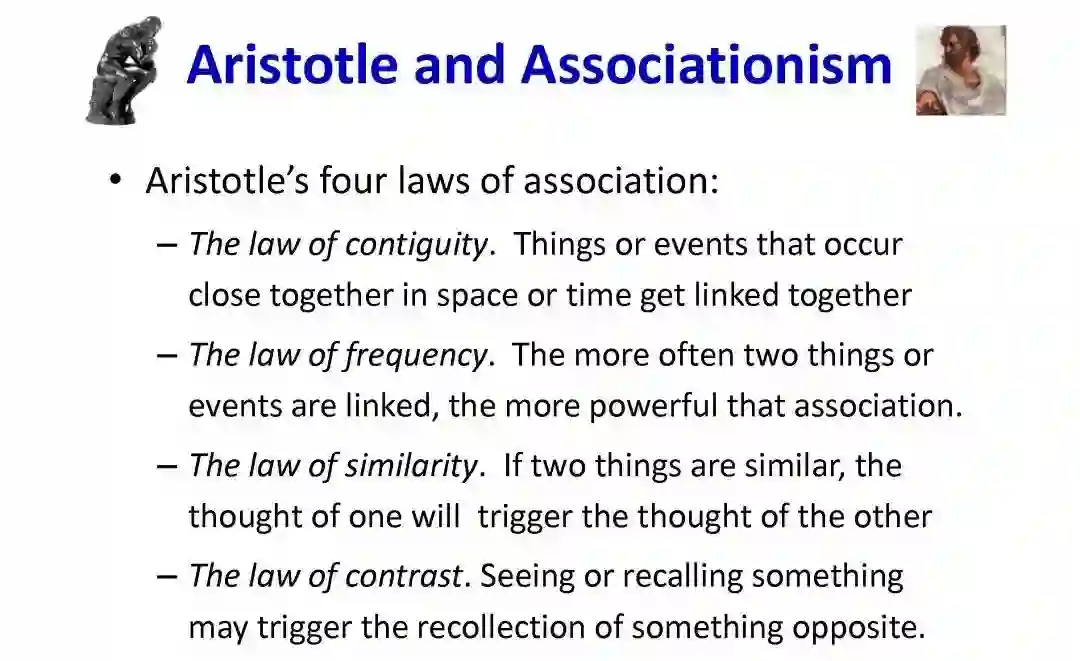

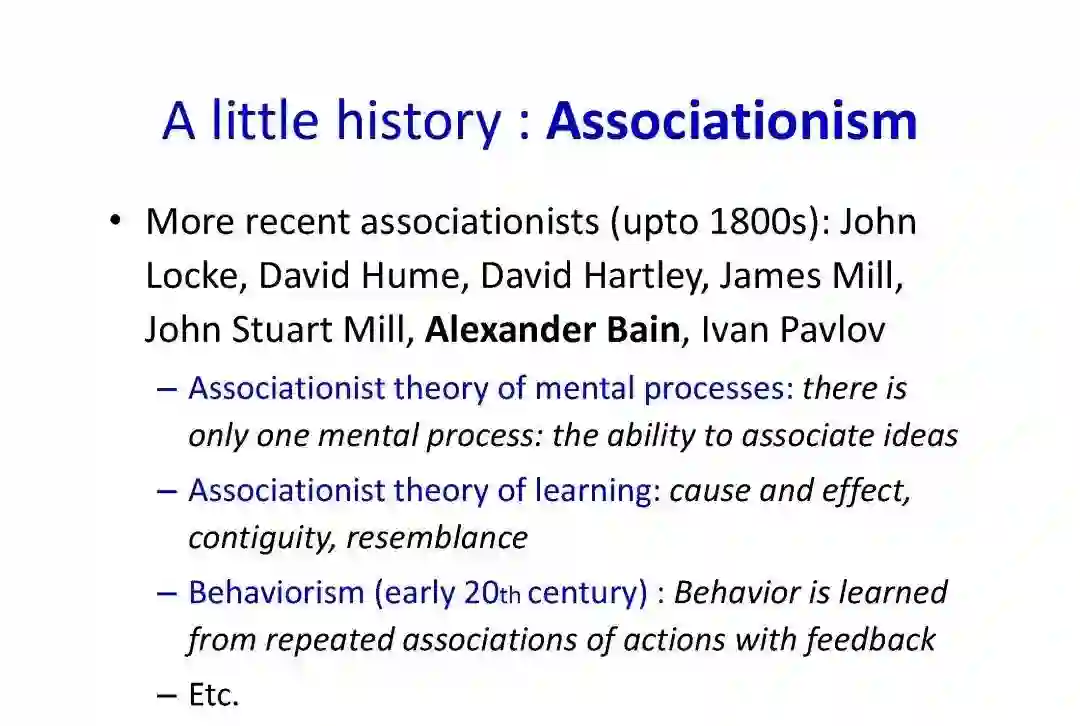

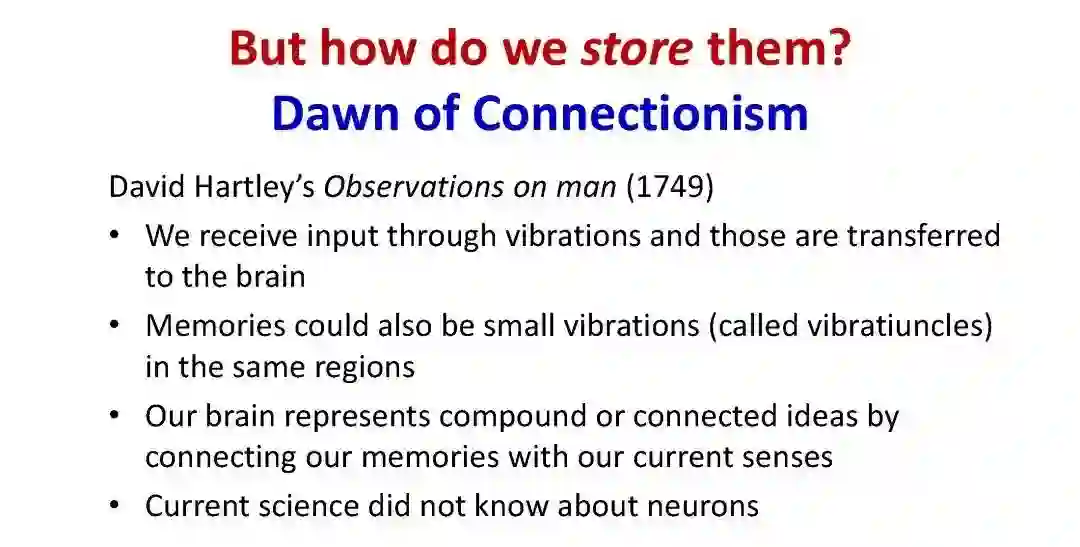

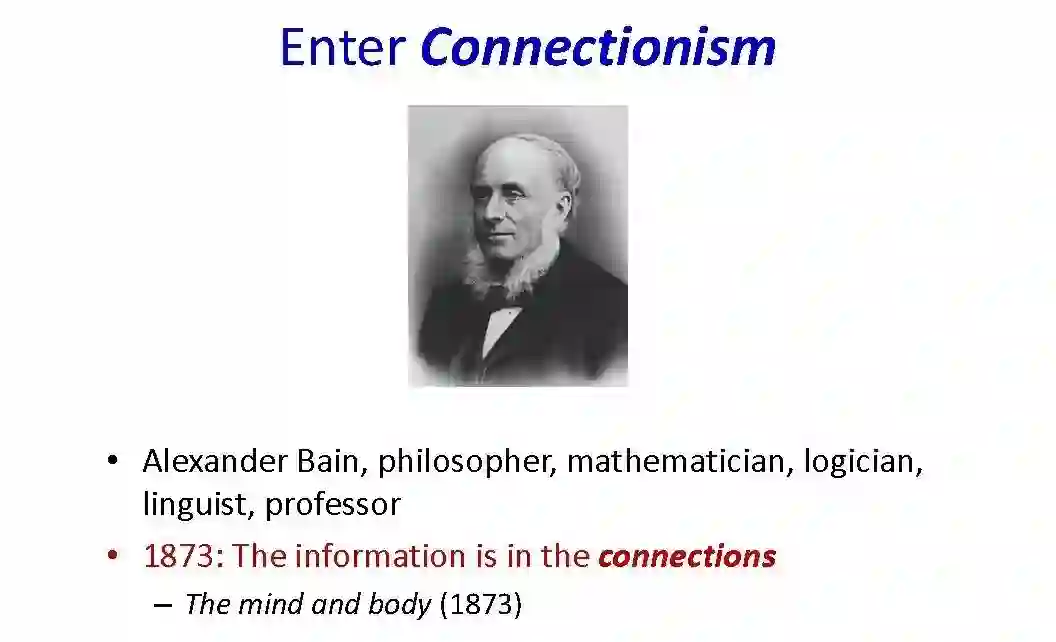

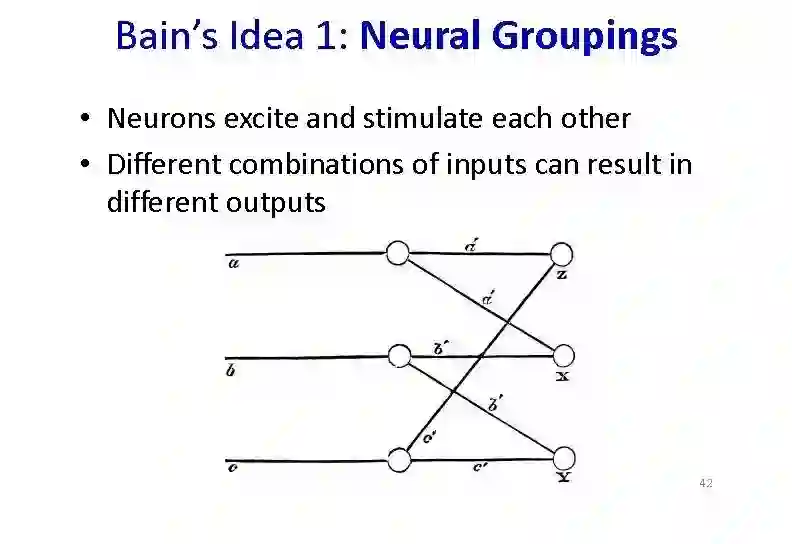

神经计算的历史和认知基础

感知机和多层感知机

Slides: http://deeplearning.cs.cmu.edu/slides/lec1.intro.pdf

video: https://piazza.com/class/j9xdaodf6p1443?cid=22

第 2 讲:

神经网络,一个通用的近似器

Slides: http://deeplearning.cs.cmu.edu/slides/lec2.universal.pdf

video: https://www.youtube.com/watch?v=zlnQyxiEGNM&t=2s

第 3 讲:

训练一个神经网络

感知器学习规则

经验风险最小化

根据梯度下降法进行优化

Slides: http://deeplearning.cs.cmu.edu/slides/lec3.learning.pdf

video: https://www.youtube.com/watch?v=HyjB2uMZK5k

第 4 讲:

反向传播

反向传播的微积分学(Calculus)

Slides: http://deeplearning.cs.cmu.edu/slides/lec4.learning.pdf

第 5 讲:

神经网络的收敛问题

收敛速度

损失函数

学习率和优化方法

RMSProp, Adagrad, Momentum

Slides: http://deeplearning.cs.cmu.edu/slides/lec5.convergence.pdf

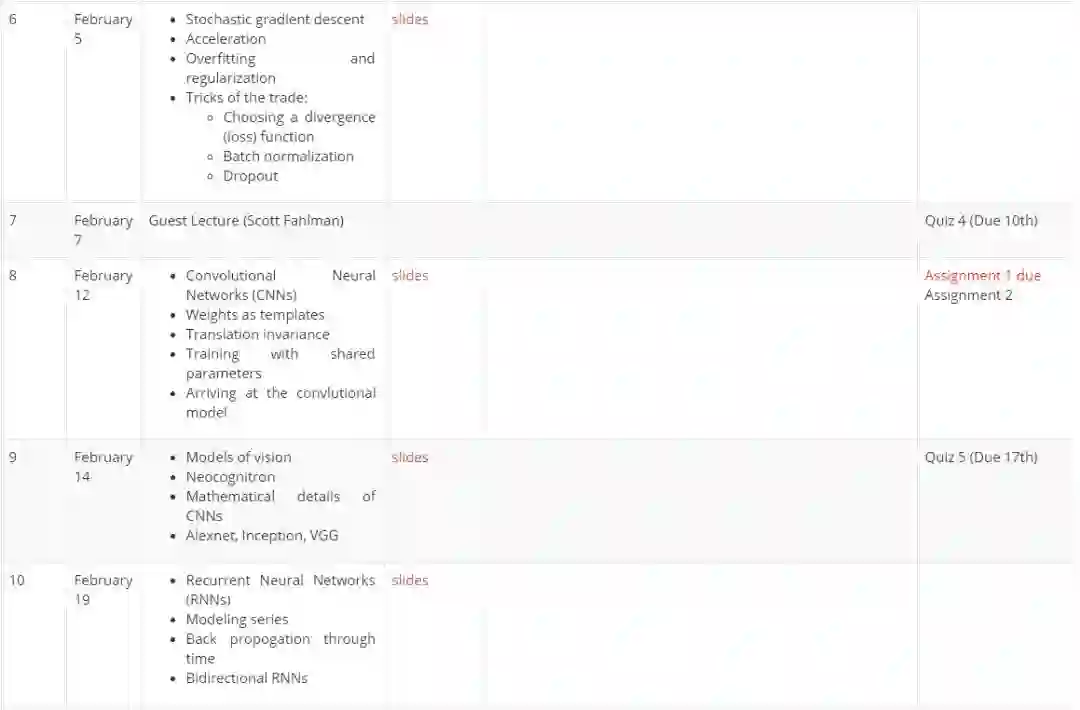

第 6 讲:

随机梯度下降

加速

过拟合和正则化

小技巧:选择散度 (损失) 函数、批正则化(Batch normalization),Dropout

Slides: http://deeplearning.cs.cmu.edu/slides/lec6.stochastic_gradient.pdf

第 7 讲:

嘉宾讲座(Scott Fahiman)

第 8 讲:

卷积神经网络(CNNs)

Weights as templates

平移不变性

使用参数共享进行训练

Arriving at the convlutional model

Slides: http://deeplearning.cs.cmu.edu/slides/lec9.CNN.pdf

第 9 讲:

视觉模型

神经认知机

CNN 的数学细节

Alexnet,Inception,VGGSlides: http://deeplearning.cs.cmu.edu/slides/lec10.CNN.pdf

第 10 讲:

循环神经网络(RNNs)

序列建模

通过时间反向传播

双向 RNN

Slides: http://deeplearning.cs.cmu.edu/slides/lec11.recurrent.pdf

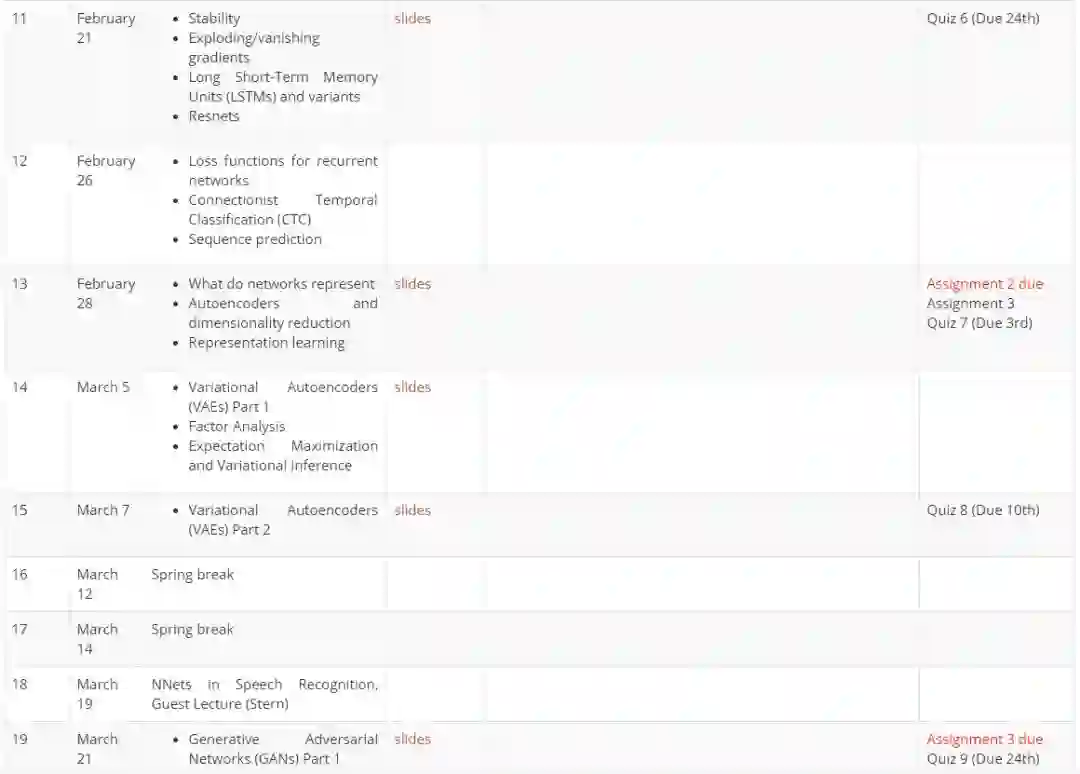

第 11 讲:

模型稳定性

梯度爆炸 / 消失

长短期记忆单元(LSTM)及其变种

Resnets

Slides:http://deeplearning.cs.cmu.edu/slides/lec12.recurrent.pdf

第 12 讲:

循环网络的损失函数

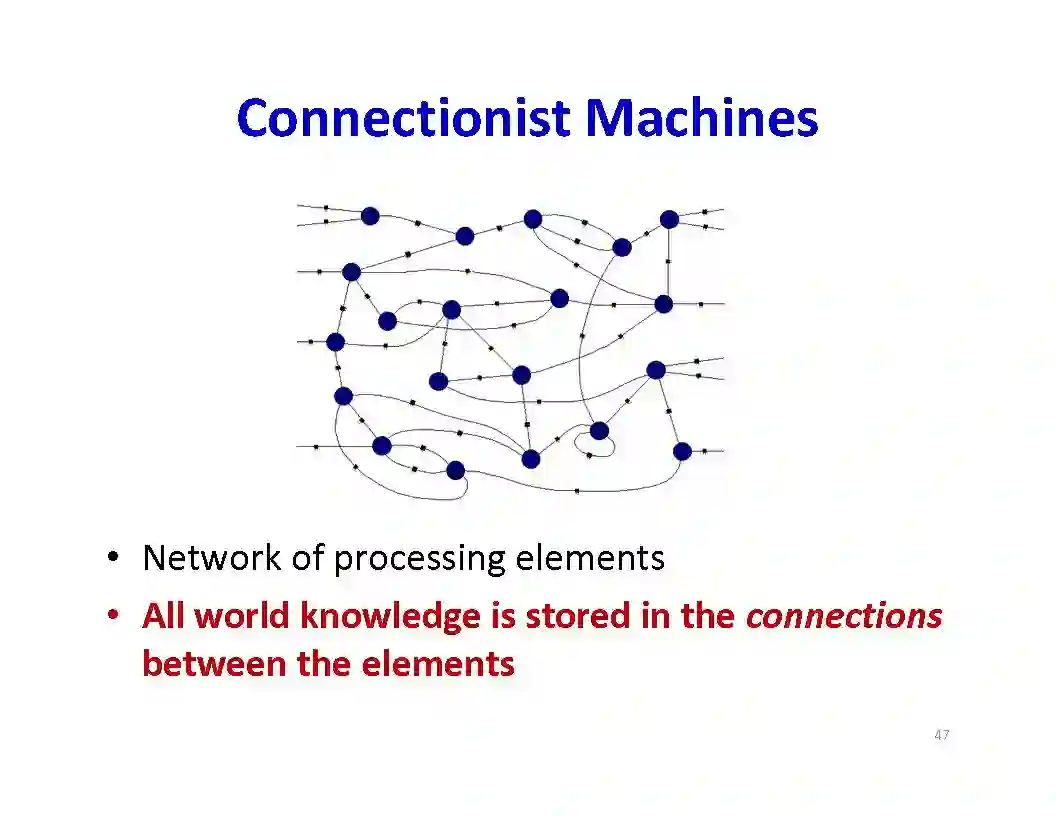

连接主义时序分类(CTC)

序列预测

第 13 讲:

网络代表什么?

自动编码器和降维

表示学习Slides:http://deeplearning.cs.cmu.edu/slides/lec15.representations.pdf

第 14 讲:

变份自动编码器(VAEs)第 1 部分

因子分析

期望最大化与变分推理

Slides:http://deeplearning.cs.cmu.edu/slides/lec18.vae.pdf

第 15 讲:

变分自动编码器(VAEs)第 2 部分

Slides:http://deeplearning.cs.cmu.edu/slides/lec18.vae.pdf

第 16、17 讲:

春假

第 18 讲:

语音识别中的神经网络,嘉宾讲座(Stern)

第 19 讲:

生成对抗网络(GANs),第 1 部分

Slides:http://deeplearning.cs.cmu.edu/slides/lec20.GAN.pdf

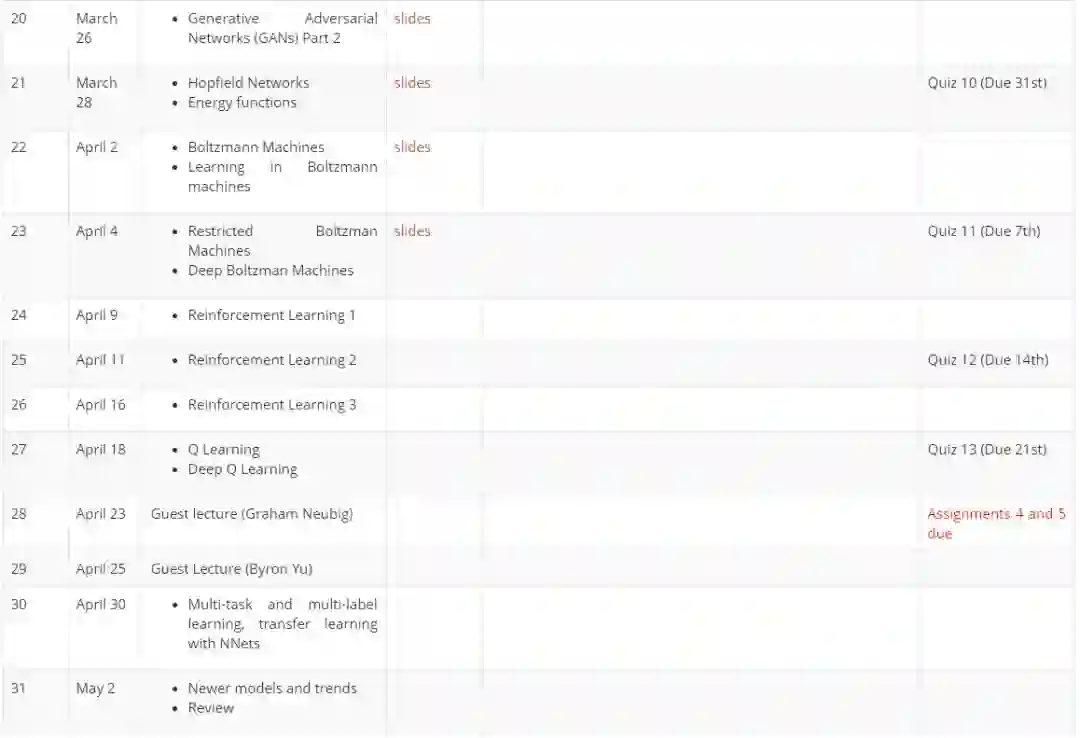

第 20 讲:

生成对抗网络(GANs),第 2 部分

Slides:http://deeplearning.cs.cmu.edu/slides/lec20.GAN.pdf

第 21 讲:

Hopfield 网络

能量函数

Slides: http://deeplearning.cs.cmu.edu/slides/lec20.GAN.pdf

第 22 讲:

玻尔兹曼机

玻尔兹曼机的学习

Slides: http://deeplearning.cs.cmu.edu/slides/lec22.hopfield.pdf

第 23 讲:

受限玻尔兹曼机

深度玻尔兹曼机

Slides: http://deeplearning.cs.cmu.edu/slides/lec22.hopfield.pdf

第 24 讲:

强化学习 1

第 25 讲:

强化学习 2

第 26 讲:

强化学习 3

第 27 讲:

Q 学习

深度 Q 学习

第 28 讲:

嘉宾讲座(GrahamNeubig)

第 29 讲:

嘉宾讲座(Byron Yu)

第 30 讲:

多任务和多标签学习、迁移学习

第 31 讲:

新模型以及深度学习的趋势

课程回顾

Deep Learning By Ian Goodfellow, Yoshua Bengio, Aaron CourvilleOnline book, 2017

Neural Networks and DeepLearning By Michael NielsenOnline book, 2016

Deep Learning with PythonBy J. Brownlee

Deep Learning Step by Stepwith Python: A Very Gentle Introduction to Deep Neural Networks for PracticalData Science By N. D. Lewis

Parallel DistributedProcessing By Rumelhart andMcClelland Out of print, 1986

原文链接:

http://deeplearning.cs.cmu.edu/

(本文转载自专知,点击阅读原文查看原文)

加入社群

新智元AI技术+产业社群招募中,欢迎对AI技术+产业落地感兴趣的同学,加小助手微信号: aiera2015_1 入群;通过审核后我们将邀请进群,加入社群后务必修改群备注(姓名-公司-职位;专业群审核较严,敬请谅解)。

此外,新智元AI技术+产业领域社群(智能汽车、机器学习、深度学习、神经网络等)正在面向正在从事相关领域的工程师及研究人员进行招募。

加入新智元技术社群 共享AI+开放平台