【Google-普林斯顿】从学习速率中解开自适应梯度法,Disentangling Adaptive Gradient

https://arxiv.org/abs/2002.11803

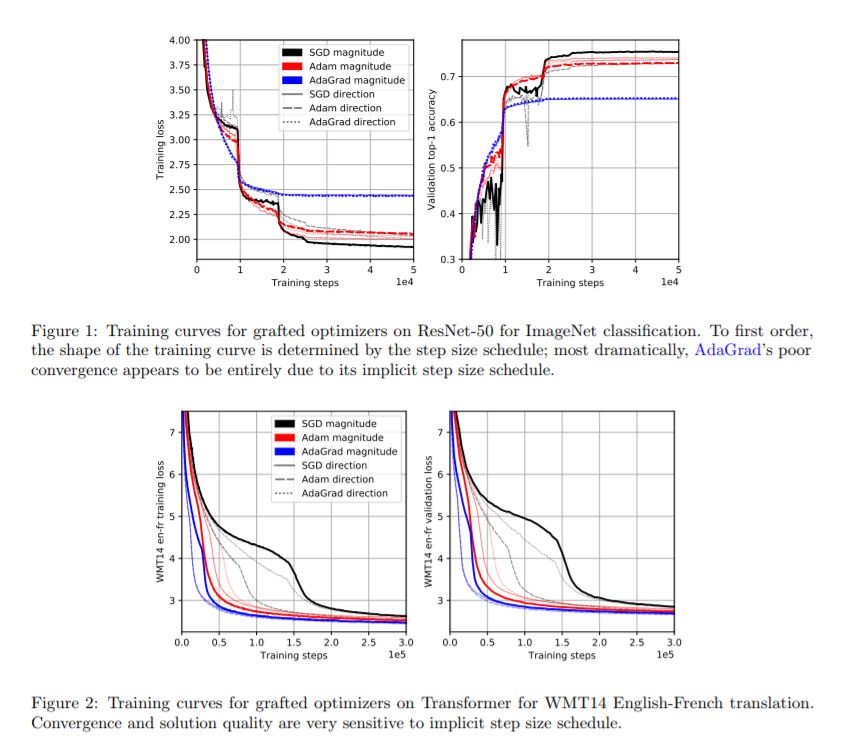

我们研究了深度学习优化算法评估中的几个混合因素。首先,我们深入研究自适应梯度方法如何与学习速率调整相互作用,这是一个众所周知的难以调整的超参数,它对神经网络训练的收敛和推广具有显着影响。我们引入了一个“嫁接”实验,该实验将更新的大小与其方向解耦,发现文献中的许多现有信念可能是由于对步长的隐式时间表的隔离不足而产生的。除了这一贡献之外,我们还对自适应梯度方法的推广进行了一些实证和理论回顾,旨在为这一空间带来更清晰的视角。

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“DAGM” 就可以获取《从学习速率中解开自适应梯度法,Disentangling Adaptive Gradient》专知下载链接

登录查看更多

相关内容

专知会员服务

19+阅读 · 2020年6月29日

专知会员服务

54+阅读 · 2020年3月5日

专知会员服务

39+阅读 · 2020年1月30日

专知会员服务

24+阅读 · 2019年11月11日

Arxiv

7+阅读 · 2020年3月12日

Arxiv

11+阅读 · 2020年2月18日

Arxiv

5+阅读 · 2018年12月15日

Arxiv

3+阅读 · 2018年9月6日

Arxiv

3+阅读 · 2018年7月19日