没有深度学习,相关滤波的视觉跟踪能走多远?

Tracking 主要分两大块:基于相关滤波的视觉跟踪和基于深度学习框架的视觉跟踪。我们做了一项任性的研究:一点深度特征都不用,相关滤波方法能达到最好的效果是什么?

就是盯着“你”不放(来源于Got-10k数据集)

视觉目标跟踪作为计算机视觉的研究热点问题之一,已在视频监控、自动驾驶、人机交互、智能导航和赛事直播等方面广泛应用。

视觉目标跟踪的任务是在视频序列中持续精准地估计目标的位置、形状变化或所占面积, 确定目标的运动速度、方向及轨迹等运动信息, 以完成更高级的任务。

由于被跟踪目标存在着部分或完全遮挡、尺度形变或背景杂乱等多方面因素的干扰,建立一个通用且鲁棒的视觉跟踪系统仍然存在巨大挑战。

基于判别相关滤波(DCF)的视觉跟踪算法目前已取得了显著性进展,DCF具有较高的跟踪精度,同时还具备高效的实时性能,几乎独占跟踪领域半壁江山。

DCF在空域内通过对前景目标的循环移位,密集采样大量正、负样本作为训练集,采用回归到高斯分布的软标签,在最小化岭回归损失函数框架下求解相关滤波器。

借助快速傅里叶变换,DCF框架巧妙地将空域中的相关运算转化为频域中的点乘运算,从而在频域内高效地对目标外观进行建模,达到实时跟踪性能,最终学习到一个具有较强判别力的分类器,将目标从背景中分离出来。

DCF受到众多科学研究者的广泛关注和深入研究。

Bolme等人[1]首次将相关滤波方法引入到自适应目标跟踪领域,提出了平方误差最小滤波器(MOSSE)跟踪算法,该算法的最大优点是在训练分类器和定位目标时采用快速傅里叶变换,跟踪速度可达到600帧/ss以上。MOSSE算法利用多帧跟踪样本训练相关滤波器,同时使用峰值旁瓣率检测相关滤波响应的峰值强度,通过及时停止目标外观模型的在线更新来避免跟踪漂移问题。

Henriques等人[2]针对MOSSE中相关滤波中样本数量不足对分类器的影响,提出了基于核技术(CSK)的跟踪算法,改进了MOSSE的循环密集采样方法,利用中心图像块循环移位近似窗口移位。

Danelljan等人[3]为了进一步提升跟踪的性能,改进了CSK跟踪算法,提出了基于颜色空间(CN)的跟踪算法,将RGB的颜色空间扩展到11个通道的CN空间。虽然提高了跟踪的精度,但是由于采用多通道特征,加大了运算量。

(来源于Got-10k数据集)

Henriques等人[4]在核技术的基础上改进了CSK跟踪算法,提出了基于核的多通道相关滤波(KCF)跟踪算法,采用31个通道的方向梯度直方图(HOG)特征, 将多通道特征融入相关滤波框架,结合岭回归与循环矩阵,将相关滤波核化。该方法对运动模糊、光照变化以及颜色变化都具有较强的鲁棒性。

Tang等人[5]在KCF中引入多核学习技术,提出了多核相关滤波(MKCF)跟踪算法,通过加权融合或自适应策略,改善单核学习中由于人工设定带来的不合理性。

针对尺度变化对跟踪性能带来的负面影响,Li等人[6]提出了自适应尺度变化的相关滤波(SAMF)跟踪算法,使用7个较粗的尺度训练平滑滤波器在多尺度图像块上进行检测,选取相关滤波响应最大值对应的平移位置和目标尺度。

(来源于Got-10k数据集)

Danelljan等人[7-8]提出了判别尺度空间(DSST)跟踪算法,采用33个较精细的尺度训练平滑滤波器和尺度滤波器来估计目标位置,然后在检测到的跟踪位置采用尺度滤波器估计目标尺度。

为了解决边界效应问题,Galoogahi等人[9]采用较大尺寸的检测图像块和较小尺寸的滤波器,同时动态减少训练集中的样本数量,提高真实样本的比例,在新的目标函数下构造增广拉格朗日乘子(ALM),并采用交替方向乘子法(ADMM)进行优化来求最优解。

Danelljan等人[10]提出了基于空间正则化的相关滤波(SRDCF)跟踪算法,对滤波器系数进行空间加权,越靠近中心目标位置,权重越小,反之权重越大,使得学习到的滤波器更加集中在中心区域。该算法通过高斯—赛德尔(Gauss-Seidel)方法优化求解目标函数,虽然跟踪器的性能有所提升,但是采用手工特征的HOG仅有9帧/s,相比KCF慢了近25倍。究其原因是SRDCF破坏了相关滤波的循环移位框架,使得优化问题变得困难。在训练过程中记录了初始帧到当前帧的所有样本信息,但由于提取样本特征需要耗费一定的时间,且采用高斯—赛德尔优化求解方法,仍具有很高的计算复杂度。

(来源于Got-10k数据集)

Danelljan等人[11]在SRDCF的基础上,提出了连续卷积相关滤波(CCOT)跟踪算法,改变了以往单分辨率特征图的限制,融合了多分辨率特征图,将传统的手工特征与不同分辨率的深度特征相结合,提高了算法性能,同时通过隐含插值方法,将离散域的相关滤波框架推广到连续域的相关滤波框架,在连续空域中学习连续相关滤波器,达到子像素级别的定位。由于CCOT采用了高维深度特征,增加了外观模型的参数(大约800 000个),使得高维度的参数空间很容易产生过拟合现象而导致跟踪漂移。

为了剔除CCOT中存在的冗余信息,在不失精度的前提下,Danelljan等人[12]提出了有效卷积运算(ECO)跟踪算法来加速CCOT,主要从对卷积操作进行因式分解来减少模型参数,通过高斯混合模型简化训练集且保证样本多样性,以及改进模型更新策略等3个方面改进了CCOT的性能。

(来源于Got-10k数据集)

在整个相关滤波学习过程中,放弃真实背景信息可能会降低学习到的跟踪器的判别力。为了缓解这一缺陷对跟踪器的影响,相继提出了CCOT[11]、ECO[12]、MDNet[13]、CREST[14]、CFCF[15]、DeepSRDCF[16]等基于深度特征的算法。这些算法或是提取深度特征或是运用深度学习框架,带来了很高的计算复杂度。

虽然跟踪性能有了大幅度提升,但是实时性能却有所下降。这恰好也是视觉跟踪实际应用的一大障碍。为了克服以上缺陷,Galoogahi等人[17]提出了背景感知相关滤波(BACF)跟踪算法,可以从整帧图像中密集采样真正的负样本,仅采用手工特征(HOG特征)就能达到很高的跟踪性能,且能满足实时(33.9帧/s)需求。

BACF算法利用一个掩码矩阵,使得较小的相关滤波器能作用于较大的搜索样本,且不会给相关滤波建模带来过多的背景因素干扰,并通过密集采样的方法得到真正的负样本,该方法甚至可以在整幅图像中进行目标搜索,能够取得良好的跟踪效果。

BACF算法在学习相关滤波器时并没有考虑滤波器的时间一致性问题,当目标出现快速运动或遮挡等外观突变现象时,学习到的相关滤波器将会偏向背景而发生漂移。

为了解决了学习到的相关滤波器能够适应连续两帧之间的外观突变问题,提出了一种BTCF算法。

作者:朱建章, 王栋, 卢湖川

来源:中国图象图形学报, 2019, 24(4): 536-549.

DOI: 10.11834/jig.180320

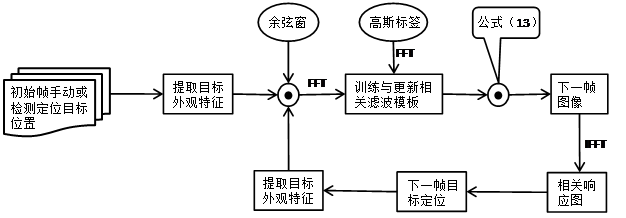

BTCF算法在BACF框架下,引入时间感知信息,构造一个带等式限制的相关滤波目标函数,目的是从时间序列意义上平滑多通道相关滤波, 旨在学习具有较强判别力的相关滤波器。

为了减少计算复杂度,将带等式限制的相关滤波目标函数转化为无约束的增广拉格朗日乘子公式,采用交替方向乘子方法(ADMM)转化为两个具有全局最优解的子问题,迭代逼近目标函数的局部最优解。由于两个子问题都是凸光滑可微的,因此两个子问题分别有各自的闭式解且为子问题的全局最优解。

BTCF算法仅用当前帧信息,无需模型在线更新策略就能学习到具有更强判别力的分类器,将目标从背景中分离出来。

BTCF算法流程图

从OTB2015公开数据库显示的跟踪结果可以看出,BTCF算法在加入时间感知后,成功率曲线图线下面积(AUC)较BACF提升了1.3 %;由于颜色与边缘特征具有互补特性,因此本文在HOG特征的基础上融合CN颜色特征,AUC较BACF提升了4.2 %。纯手工特征跟踪性能在OTB2015数据库上100个视频的AUC为0.663,跟踪速度为25.4帧/s,能够达到实时跟踪的效果。

BTCF算法能够适用于光照变化、目标旋转、遮挡等复杂情况下的视觉跟踪,具有良好的鲁棒性和一定的实时性。

[1] Visual object tracking using adaptive correlation filters[C][DOI:10.1109/CVPR.2010.5539960]

[2] Exploiting the circulant structure of tracking-by-detection with kernels[C][DOI:10.1007/978-3-642-33765-950]

[3] Adaptive color attributes for real-time visual tracking[C][DOI:10.1109/CVPR.2014.143]

[4] High-speed tracking with kernelized correlation filters[J] [DOI:10.1109/TPAMI.2014.2345390]

[5] Multi-kernel correlation filter for visual tracking[C][DOI:10.1109/ICCV.2015.348]

[6] A scale adaptive kernel correlation filter tracker with feature integration[C][DOI: 10.1007/978-3-319-16181-5_18]

[7] Accurate scale estimation for robust visual tracking[C][DOI:10.5244/C.28.65]

[8] Danelljan M, Häger G, Khan F S, et al. Discriminative scale space tracking[J][DOI:10.1109/TPAMI.2016.2609928]

[9] Galoogahi H K, Sim T, Lucey S. Correlation filters with limited boundaries[C][DOI:10.1109/CVPR.2015.7299094]

[10] Danelljan M, Häger G, Khan F S, et al. Learning spatially regularized correlation filters for visual tracking[C][DOI:10.1109/ICCV.2015.490]

[11] Beyond correlation filters: learning continuous convolution operators for visual tracking[C][DOI:10.1007/978-3-319-46454-1_29]

[12] ECO: efficient convolution operators for tracking[C][DOI:10.1109/CVPR.2017.733]

[13] Learning multi-domain convolutional neural networks for visual tracking[C][DOI:10.1109/CVPR.2016.465]

[14] CREST: convolutional residual learning for visual tracking[C][DOI:10.1109/ICCV.2017.279]

[15] Good features to correlate for visual tracking[J][DOI:10.1109/TIP.2018.2806280]

[16] Convolutional features for correlation filter based visual tracking[C][DOI:10.1109/ICCVW.2015.84]

[17] Learning background-aware correlation filters for visual tracking[C][DOI:10.1109/ICCV.2017.129]

编辑:韩小荷

审核/指导:梧桐君

前沿丨观点丨咨讯丨独家

扫描下方二维码 关注学报公众号

中国图象图形学报 | 订阅号

你认真学习的样子

真好看!