强化学习和决策多学科会议(Multi-Disciplinary Conference on Reinforcement Learning and Decision Making, RLDM)的重要前提是,随着时间的推移,多个学科对目标导向的决策有着共同的兴趣。

近日,阿尔伯塔大学计算机科学系教授、强化学习先驱 Richard S. Sutton 在其最新论文《The Quest for a Common Model of the Intelligent Decision Maker》中通过提出决策者的观点来加强和深化这一前提,该观点在心理学、人工智能、经济学、控制理论和神经科学等领域得到实质和广泛的应用,他称之为

「智慧智能体的通用模型」

。通常模型不包含任何特定于任何有机体、世界或应用域的东西,而涵盖了决策者与其世界交互的各个方面(必须有输入、输出和目标)以及决策者的内部组件(用于感知、决策、内部评估和世界模型)。

论文地址:

https://arxiv.org/pdf/2202.13252.pdf

Sutton 确定了这些方面和组件,指出它们在不同学科中被赋予不同的名称,但本质上指向相同的思路。他探讨了设计一个可跨学科应用的中性术语面临的挑战和带来的益处,并表示是时候认可并在智慧智能体的实质性通用模型上构建多样化学科的融合了。

DeepMind Alberta 杰出研究科学家、强化学习教父 Richard S. Sutton

RLDM 的前提是所有对「随时间推移学习和决策以实现目标」感兴趣的学科融合在一起并共享观点是有价值的。心理学、神经科学等自然科学学科、人工智能、优化控制理论等工程科学学科以及经济学和人类学等社会科学学科都只部分关注智能决策者。各个学科的观点不同,但有相通的元素。跨学科的一个目标是确定共同核心,即决策者对所有或许多学科共有的那些方面。

只要能够建立这样一个决策者的通用模型,就可以促进思想和成果的交流,进展可能会更快,获得的理解也可能会更加基础和持久。

探索决策者的通用模型并不新鲜。衡量其当前活力的一个重要指标是 RLDM 和 NeurIPS 等跨学科会议以及《神经计算》、《生物控制论》和《适应行为》等期刊的成功。很多科学洞见可以从跨学科互动中获得,例如贝叶斯方法在心理学中的广泛应用、多巴胺在神经科学中的奖励预测误差解释以及在机器学习中长期使用的神经网络隐喻。尽管很多这些学科之间的重要关系与学科本身一样古老,但远远未解决。为了找到学科之间、甚至一个学科内部之间的共性,人们必须忽略很多分歧。我们必须要有选择性,从大局出发,不要期望没有例外发生。

因此,在这篇论文中,

Sutton 希望推进对智能决策者模型的探索

。首先明确地将探索与富有成效的跨学科互动区分开来;其次强调目标是作为高度跨学科的累积数值信号的最大化;接着又强调了决策者的特定内部结构,即以特定方式交互的四个主要组件,它们为多个学科所共有;最后突出了掩盖领域之间共性的术语差异,并提供了鼓励多学科思维的术语。

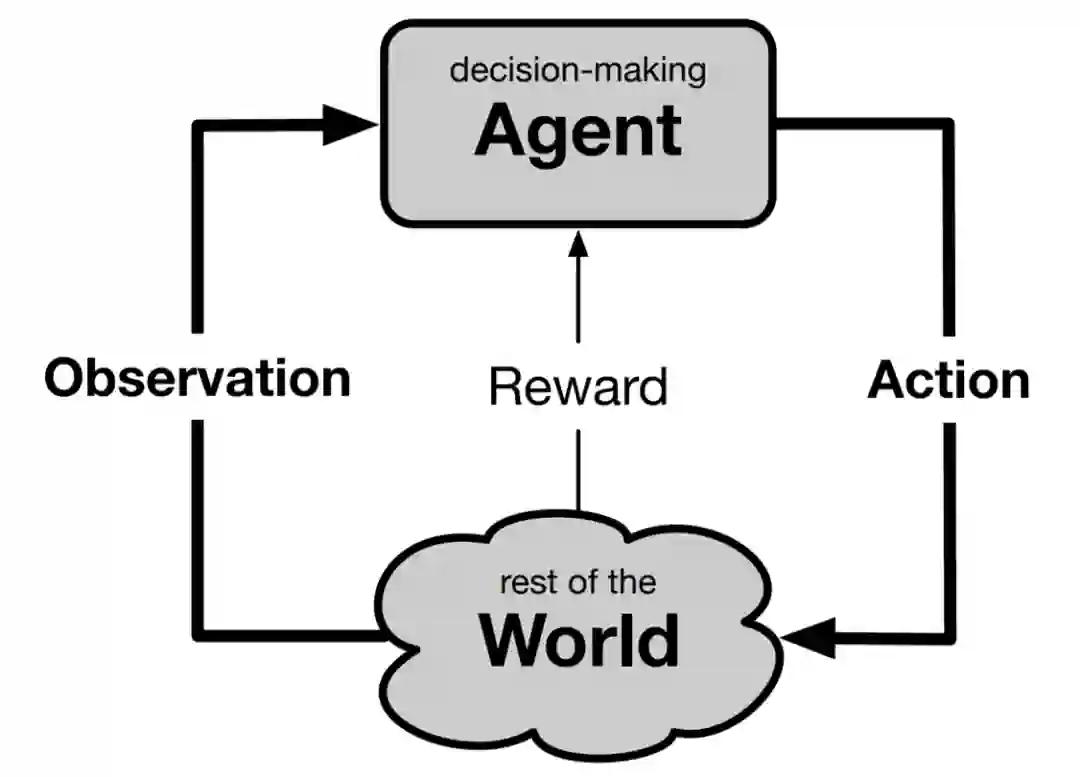

决策者随时间推移做出决策,可以分为离散的步骤,在每个步骤接收新信息并做出可能影响之后所接收信息的决策。也就是说,随着时间推移,与交换的信号产生交互。对于信号和交换信号的实体,我们应该使用什么术语呢?在心理学中,决策者是有机体,它接收刺激并向环境发送响应。在控制理论中,决策者被称为控制者,接收状态并向受控体发送控制信号。决策者在其他领域使用其他术语,这就说明了挑战的存在,即找到不会令读者对某个领域产生偏见的术语,而是促进跨学科边界的思考。

开始建立术语的一个好方法是阐明这些词语想要和不想要传达的意思。后者对我们来说尤其重要,因为我们不希望术语唤起特定于任何具体学科的直觉。例如,将决策者成为有机体会干扰将它看作机器,就像在人工智能中一样。决策者的本质在于它的行动具有一定的自主性,对输入非常敏感,并对未来的输入具有倾向性影响。

对于决策者的一个很好的称呼是智能体,它的定义是「扮演积极决策或产生特定效果的人或物」。人工智能领域通常使用智能体来表述决策者,可能是机器或人。

智能体也比决策者更可取,因为它意味着自主性和目的性。

那么决策智能体与什么进行交互呢?答案是它能与所有不是智能体的一切事物产生交互,这可以被称作它的环境或世界。这两个术语与特定学科没有强关联,但本文选择世界的原因在于它更简单,同时不与任何特定学科产生关联的方式令人印象深刻。如下图所示,为了完成智能体与世界交互的场景,我们必须为每个方向上传递的信号命名。可以很自然地说,智能体采取了行动,并接收到了感知或观察。这里使用了观察,因为它是用于此目的的既定术语,并且避免了关于机器是否有感知的形而上学讨论。在标准用法中,观察指的是可能不完整的关于世界状态的信息。

前面的讨论阐释了 Sutton 在术语方面想要遵循的基本规规则和步骤,具体如下:

2)找到一个能够捕获该含义且不会过度偏向一个或另一个学科的常识词语;

Sutton 遵循的第二种基本规则不是关于术语,而是关乎内容。当我们想要开发一个通用决策模型时,应该包含和排除哪些方面?他试图遵循的规则是涵盖领域(field)的交集而不是并集。也就是说,为了包含一个方面,它仅出现在一个领域是不够的,至少要与其他很多(如果不是全部)领域产生关联。通用模型的各个方面随时间推移必须普遍适用于所有决策,以实现一个目标。

通用模型中不应有任何特定于我们世界的内容,例如视觉、目标、三维空间、其他智能体或语言。我们排除的简单例子是使人们与众不同并异于其他动物的所有事物,或者动物通过进化以适应它们生态环境的所有特定知识。这些都是人类学和行为学中特别重要的主题,真正提高了我们对自然智能系统的理解,但在通用模型中没有位置。同样地,我们排除了由人类设计师在人工只能系统中构建的所有领域知识,以开发出需要更少训练的应用。所有这些在各自学科内部都很重要,但与旨在应用于跨学科的通用模型是无关的。

除了促进跨学科互动之外,通用决策模型可能还有其他用途。由于现有学科和它们的价值已经建立,因此很容易看到学科内部的共性成果。了解自然系统具有清晰的科学价值,创建更有用的工程产品具有显著的实用价值。但是,如果不考虑智能决策与自然决策的关系,也不考虑智能决策产品的实际效用,那么理解智能决策的过程是不是就没有科学价值呢?Sutton 认为是这样。

智能决策不是目前已确定的科学,但也许有一天会成为独立于生物学或其工程应用的决策科学。

现在来讨论决策智能体的目标。现在,大多数学科根据在智能体直接控制之外产生的标量信号来指定智能体的目标,因此我们将其生成置于世界中。在一般情况下,这一信号在每个时间步到达,目标是最大化总和。这种加性奖励可用于将目标表述为折扣总和或有限范围内总和,也或者是基于每个时间步的平均奖励。用于表述奖励的名称有很多,比如报酬(payoff)、收益(gain)或者效用(utility),以及最小化奖励时的成本(cost)。如果允许成本为负,则成本和最小化在形式上是等价的。一个更简单但仍然流行的目标概念是要达到的世界状态。目标状态有时也可以用,但不如加性奖励通用。例如,目标状态无法维护目标,也无法明确说明时间成本与不确定性之间的权衡,但所有这些都可以通过加性框架轻松地处理。

加性奖励具有悠久的跨学科历史。在心理学中,奖励主要用于使动物愉悦的外部物体或事件,即使这种愉悦感源于该物体与以更基本的方式获得回报的事物的关联——初级强化物(primary reinforcer) 。今天在运筹学、经济学和人工智能中对奖励的使用仅限于更重要的信号,并且是接收到的信号,而不是与外部对象或事件相关联。随着 1960 年代最优控制和运筹学研究中马尔可夫决策过程的发展,这种用法似乎已经确立。它现在已成为广泛学科的标准,包括经济学、强化学习、神经科学、心理学、运筹学和人工智能的多个子领域。

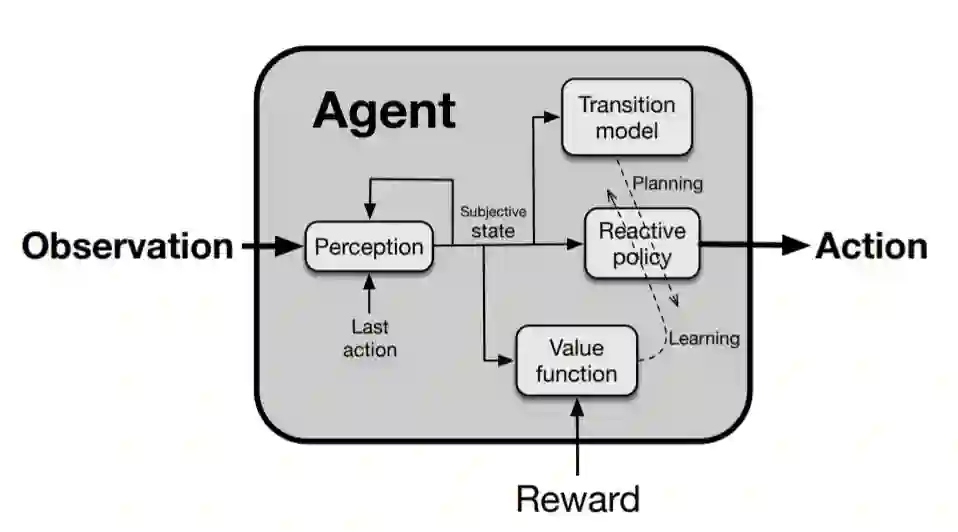

现在我们转向智能体内部结构,智能体通用模型的内部结构通常由四部分组成:感知、反应策略、价值函数、转换模型,如下图所示。这四个组件对许多学科来说都是通用的,但很少有智能体能够包含全部,当然,有些特定智能体可能还包括其他部分,下面 Sutton 介绍了这四个组件。

感知组件可处理观察、动作流以产生主观状态,这是迄今为止对智能体 - 世界交互作用的总结,对于选择动作(反应策略)、预测未来奖励(价值函数)和预测未来主观状态(转换模型)很有用。状态是主观的,因为它是相对于智能体的观察和动作,可能不符合真实世界的内部运作。通常,主观状态的构建是固定的,在这种情况下,智能体被假定为直接接收主观状态作为一种观察。例如,在 Atari 游戏中,主观状态可能是最后 4 个视频帧及其相邻动作。在贝叶斯方法中,主观状态确实与世界的内部运作有关系:主观状态的目的是近似世界内部使用潜在状态的概率分布。在预测状态方法中,主观状态是一组预测。在深度学习中,主观状态通常是递归人工神经网络的瞬间活动。在控制理论中,感知组件的计算通常被称为状态识别或状态估计。

一般而言,感知组件应具有递归形式,这允许智能体从先前的主观状态、最近的观察和最近的动作有效地计算主观状态,而无需重新审视先前冗长的观察和动作。感知组件必须具有快速处理的能力,即在智能体 - 世界交互的连续时间步之间的时间间隔内很好地完成。

通用模型的反应策略组件将主观状态映射到一个动作。与感知一样,反应策略必须快速,感知速度和反应策略共同决定了智能体的整体反应时间。有时感知和反应策略被放在一起处理,就像端到端学习一样。将动作生成分为感知和策略,在许多学科中都很常见。在工程学中,人们通常认为感知是给定的,而不是学习到的,甚至不是智能体的一部分。工程显然有反应策略的思想,通常是通过分析计算或推导出来的。人工智能系统通常假设在动作之前可以有大量处理过程(例如,下棋程序)。在心理学中,通常将感知视为支持但先于动作的感知,并且可以独立于对特定动作的影响进行研究。

通用模型的价值函数组件将主观状态(或状态 - 动作对)映射到标量评估,操作上定义为预期累积奖励。这种评估速度很快,并且独立于直觉等因素,但可能基于长期经验(甚至基于专家设计)或来自有效存储或缓存的广泛计算。无论哪种方式,研究者都可以快速调用评估,以支持改变反应策略的进程。

价值函数具有非常广泛的多学科历史。在经济学中,它们被称为效用函数;在心理学中,它们与次级强化物的旧观念和奖励预测的新观念有关。价值函数这个术语最初来自动态规划,然后在强化学习中得到应用,其中价值函数被广泛用作理论和大多数学习方法的关键组成部分。在神经科学中,价值函数中的误差或奖励预测误差被假设为对神经递质多巴胺的相位信号的解释。

智能体通用模型的第四个也是最后一个组件,即转换模型,它接收状态并预测如果采取不同动作智能体会产生什么样的下一个状态。转换模型可以称为世界模型,但这种说法会夸大转换模型作用。转换模型用于模拟各种动作的影响,并在价值函数的帮助下,评估可能的结果并改变反应策略,以支持具有预测良好结果的动作,以及反对具有预测不良结果的动作。

转换模型在许多学科中扮演着重要的角色。在心理学中,自 Kenneth Craik (1943) 和 Edward Tolman (1948) 的研究以来,由转换模型和感知提供的世界内部模型一直是杰出的思想模型。在神经科学领域,包括 Karl Friston 和 Jeff Hawkins 在内的理论家们开始广泛地发展大脑理论。最近在心理学上,Daniel Kahneman(2011) 提出了两个心理系统的概念,第一系统和第二系统。在控制理论和运筹学研究中,研究者通常使用多种形式的转换模型,包括微分方程模型、差分方程和马尔可夫模型。在强化学习中,基于模型的学习方法早已被提出,它们已经开始在大型应用中发挥效用。在现代深度学习领域,Yoshua Bengio、Yann LeCun 和 Jurgen Schmidhuber 等著名研究者都将世界预测模型置于他们思想理论的中心位置。

这是一个在寻找通用智能体模型任务上的简单方式。本文简要提出的所有观点都值得详细阐述,并对历史进行更深入的处理。然而,主要观点似乎很清楚。我们已经为通用模型提出了一个突出的候选者。它的外部接口——在智能体、世界、动作、观察和奖励方面是通用的、自然的,并且在自然科学和工程学中都被广泛采用。智能体的四个内部组成部分也各自具有悠久而广泛的多学科传统。

本文提出的通用模型可能会因为遗漏的内容而受到批评。例如除奖励之外,它没有明确的观察预测作用,也没有对探索、好奇心或内在动机的处理。并且所有四个组成部分都必须涉及学习,但这里我们仅在反应性策略中描述了学习,而且只是笼统的。读者们无疑会对通用模型没有包含部分功能感到失望,认为这些功能的重要性被低估了。

例如,我认为智能体为自己提出的辅助子任务(Sutton et al. 2022)是智能体开发抽象认知结构的重要且未被充分重视的手段。然而,正是因为辅助子任务没有得到广泛的认可,它们不应该出现在智能体的通用模型中,它们也没有得到跨学科的充分认可。

本文提出的通用模型智能体目的不是为了成为最好最新的,而是希望能够成为一个出发点。它力求成为一个简单的设计,在许多学科中得到很好的广泛理解。每当研究人员引入新智能体设计时,通用模型都意味着作为一个标准,可以用来解释新设计与通用模型的不同之处或扩展。

时在中春,阳和方起——机器之心AI科技年会

机器之

心AI科技年会将于3月23日在北

京举办,在分享交流对人工智能的判断与思考外,更重要的是与读者、合作伙伴和好友们真实的见一面。

这是一次注重交流与见面的聚会,所以叫「年会」,没叫「大会」。

在这场年会上,有三个方向我们希望和大家分享:人工智能、AI for Science和智能汽车。

人工智能论坛关注高性能计算、联邦学习、系统机器学习、强化学习、CV与NLP发展、RISC-V等。

AI x Science论坛关注AI与蛋白质、生物计算、数学、物理、化学、新材料和神经科学等领域的交叉研究进展。

首席智行官大会关注智能汽车、汽车机器人、无人驾驶商业化、车规级芯片和无人物流等。

当然,按以往的惯例,我们还将邀请行业内最具代表性与专业的权威嘉宾带来他们的思考与判断。

欢迎大家点击「阅读原文」报名活动,「中春」见。

© THE END

转载请联系本公众号获得授权

投稿或寻求报道:content@jiqizhixin.com