讯飞与哈工大联合实验室刷新SQuAD成绩,两项指标均大幅提升

文 | 奕欣

来自雷锋网(leiphone-sz)的报道

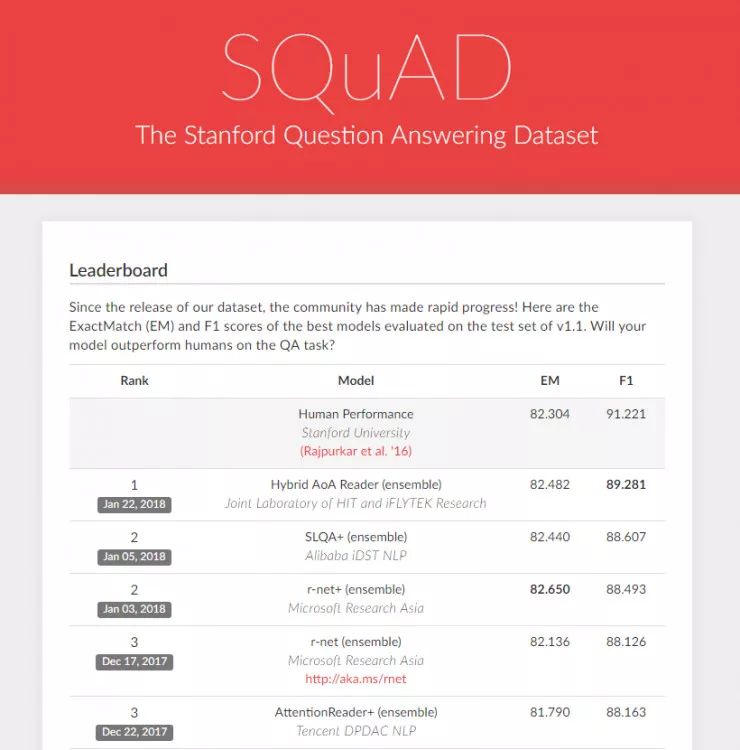

雷锋网AI科技评论按:科大讯飞与哈工大联合实验室(HFL)在 SQuAD 上又刷新了成绩,不仅在精确匹配(Exact Match,下称 EM)指标上超过人类平均水平,模糊匹配(F1-score,下称 F1)指标也首次达到 89.281 。

SQuAD(Stanford Question Answering Dataset)为斯坦福大学发起的文本理解挑战赛,是行业内公认的机器阅读理解领域的顶级水平测试,它构建了一个包含十万个问题的大规模机器阅读理解数据集,选取超过 500 篇的维基百科文章。

在阅读数据集内的文章后,机器需要回答若干与文章内容相关的问题,并通过与标准答案的比对,得到 EM 和 F1 的结果。

在 2018 年 1 月初,以阿里巴巴、微软亚洲研究院(下称 MSRA)为代表的中国研究团队相继刷新了 SQuAD 的 EM 纪录,机器阅读能力的准确率首次超越人类。 而在今天,科大讯飞与哈工大联合实验室也在 SQuAD 上获得了超越人类的 EM 分数,并在 F1 上也获得了第一名的成绩。

早在 2017 年 7 月,科大讯飞与哈工大联合实验室( HFL )在 SQuAD 上提交的系统模型就曾夺得第一,这也是中国本土研究机构首次取得该比赛的冠军。为此,雷锋网(公众号:雷锋网) AI 科技评论专访了科大讯飞研究院副院长王士进,当时他指出,成为世界第一,只是阅读理解系统万里长征的第一步。

虽然国内研究机构所提交的系统相继在 SQuAD 中超过了人类平均水平,相比往期毫无疑问是一个巨大的进步,但这并不能代表机器在阅读理解任务上「完全」战胜人类。毕竟在认知推理层面,机器仍然没有达到人类所具备的真实能力。

阅读理解是 NLP 领域里一个公认的难题,也是未来一个非常重要的趋势。据了解,讯飞与哈工大联合实验室提交的融合式层叠注意力系统(Hybrid Attention-over-Attention Reader)融合了基于上下文的文本表示、自适应转随机梯度下降的优化方法等前沿技术。王士进在此前的采访中表示,在 7 月份向 SQuAD 提交结果前,科大讯飞与哈工大联合实验室团队在该数据集中花了四个多月的时间,主要采用的方法还是主流的深度学习。

原来的做法是,系统会给出一些训练集,包括包括篇章、问题和对应的答案,然后通过神经网络去学习,自动构建找到问题和答案的对应关系的一个方式。但我们做法有两点不一样的地方:

一个是我们的“基于交互式层叠注意力模型”,一开始她可能先锁定住一些片段,然后通过多轮迭代的方式进行过滤,进一步锁定筛选出更精准的一些内容,去除整篇文章的干扰,最终得出问题的答案。

第二,我们采用了模型融合的方式。对于问题我们会提出不同的模型,然后对这些模型进行一个融合(ensamble)。因为我们知道,一般来说单一模型的性能并不是特别好,我们其实研究的是如何把多个不同机理的模型融合和在一起产生最好的效果。

详细的技术细节分析与趋势探讨,可参考雷锋网 AI 科技评论的往期报道《成为世界第一,只是阅读理解系统万里长征的第一步》。

更多精彩内容,敬请关注雷锋网AI 科技评论。

滑动查看更多信息!

▼

雷锋网正在招聘业界记者/编辑,坐标北京

岗位职责:

跟踪国内外科技行业大公司和独角兽动态,特别是人工智能方面的动态,深度挖掘科技行业背后的故事。

岗位要求:

1、科技媒体1-3年从业经验,AI相关背景是加分项;

2、积极主动,有责任心;

3、想法独道,思维辩证;

4、英语优秀,有技术教育从业背景的也可加分。

在这里,你能获得什么?

1、接触当下最新科技趋势以及最热门的公司,与业内和专业人士深入交流;

2、针对性的培训指导;

3、快速自我成长的机会。

工作地址

北京市 - 海淀区 - 苏州街 - 长远天地大厦-b1座1006

简历发送至 liufangping@leiphone.com,或通过拉勾网投递:https://www.lagou.com/jobs/2977550.html

NLP工程师入门实践班

三大模块,五大应用,手把手快速入门NLP、海外博士讲师,丰富项目经验、算法+实践,搭配典型行业应用、随到随学,专业社群,讲师在线答疑,详情点戳阅读原文链接或长按识别下方二维码~