本文介绍的是CVPR2020 oral论文《Deep Spatial Gradient and Temporal Depth Learning for Face Anti-spoofing》,作者来自明略科技。

编辑 | 丛 末

在CVPR2020由中科院自动化研究所模式识别国家重点实验室主办的ChaLearnFace Anti-spoofing Attack Detection Challenge人脸防伪检测挑战赛中,由奥卢大学与明略科学院深度学习实验室等组成的团队,斩获多模态赛道冠军和单模态赛道亚军。

此次挑战赛中,奥卢大学和明略科学院团队运用的方法,主要来自于《Deep Spatial Gradient and Temporal Depth Learning for FaceAnti-spoofing(FAS-SGTD [2]), CVPR2020 (Oral)》和《Searching Central Difference Convolutional Networks for FaceAnti-spoofing(CDCN [1]), CVPR2020》两篇论文的研究成果。

这篇解读,将重点介绍《Deep Spatial Gradient and Temporal Depth Learning for Face Anti-spoofing(FAS-SGTD[2]), CVPR2020 (Oral)》的内容。

论文地址:https://arxiv.org/abs/2003.08061

人脸防伪、活体检测是人脸识别应用中最重要的一环,人脸防伪的方法能够抵御不法分子通过照片、面具等手段对人脸识别系统进行攻击从而牟利,是一项非常有落地实用价值的研究领域。近些年关于人脸防伪的研究切入点很多,有的从针对新的攻击方式入手[9],有的从针对Cross domain入手[9],有的通过设计新的卷积核或者损失函数来更好的捕捉伪造人脸的信息[1],有的通过重构人脸的三维结构来分析是否为真实的人脸[4]。本文从人脸深度信息提取入手,前几年这方面的工作,对时空深度信息提取方法探索的比较粗糙,基本都是ResBlock接个LSTM,虽然会一些可视化的结果,但是依然很难知道学到了什么,为什么新能会好;本文致力于从空间Spatial与时间Temporal层面来揭秘人脸防伪。

单帧的depth regression作者团队认为还是会缺失信息,所以提出了从空间Spatial和时间Temporal层面来探索人脸防伪问题。作者团队在真实的depthlabel上实验对比真实的depth label要优于generateddepth label,并且无论是真实的depth label还是generated depth label上多帧都要优于单帧。

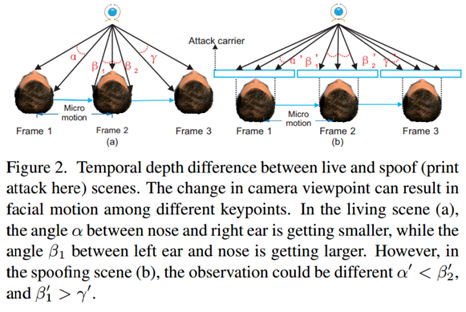

1. 为了更好表征spatial信息,提出基于空间梯度幅值的 Residual Spatial Gradient Block (RSGB)。

2. 为了更好表征temporal信息,提出多级短长时时空传播模块 Spatio-Temporal Propagation Module (STPM)。

3. 为了让网络更好地学习到细节的spoofing patterns,提出了细粒度的监督损失:Contrastive Depth Loss (CDL) 。

4. 提出了新型数据集 Double-modal Anti-spoofingDataset (DMAD) ,第一次对 真实传感器感知的Depth 和 PRNet产生的伪Depth 作为监督信号时的性能差异进行实验分析。

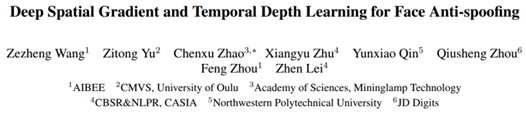

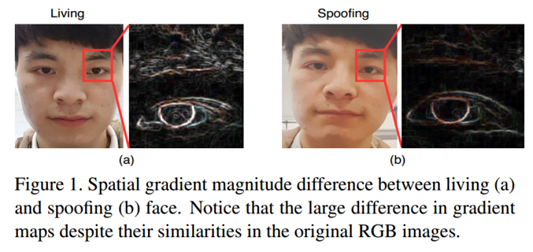

我们先来看看经典的 Fig.1 和 Fig.2,形象地阐述了Living face 和 presentation attacks 的一些时空差异:

从上图经典 Sobel 算子出来的 spatial gradientmagnitude map 可见,真实人脸具有更细致可靠的空间特征。

从上图简单的 Structure from motion 简单示意图可见,帧间的micro motion能够更好地重构出有用的立体信息,而真实人脸和假脸的立体信息也是有差异的。

下面详细介绍一下FAS-SGTD方法的各个子模块。

后面文章提交后才发现,跟 Kaiming 的这篇CVPR2019"Feature Denoising for Improving Adversarial Robustness" [8] 想法有点撞车了。不过出发点是相反的,文[8]中是为了尽量不受 Adversarial 扰动的影响,所以在 feature map level 进行 denosing 残差操作;而本文RSGB更关注局部细节信息,故在 feature map level 进行 sobel 残差操作。图4中,水平方向以及竖直方向的梯度可以由以下卷积操作导出:

其中代表depthwiseconvolution操作,x为输入的feature map。

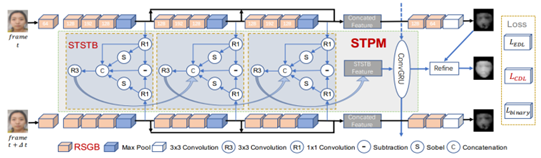

如上图所示,如图3所示,STSTB通过融合五种特征来提取short-term spatio-temporal信息:当前压缩特征,当前空间梯度特征,未来空间梯度特征,时间梯度特征和上一层级STSTB1-1(t)的STSTB特征。融合特征可以通过自学习/自适应的方式来提供加权的空间和时间信息。在本文中,空间和时间梯度分别通过基于Sobel的深度卷积(上文中公式)和时间特征的逐元素减法来实现。

不同于OFF [3] 的是,我们考虑到了未来帧的spatialgradient features,这对多帧活体检测任务是非常重要的,具体关于STPM的消融实验请阅读原文。

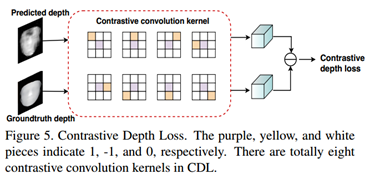

在Pixel to Pixel 的传统MSE loss基础上,加上 Local to Local 的CDL,能保证网络学到更细粒度的特征表达,公式如下:

其中和分别是预测深度和真实深度,为第i个对比深度卷积核,i∈[0,7]。欧式距离损失(EDL)只做到了逐个像素的对预测深度进行监督,而忽略相邻像素之间的深度差。然而,不同对象的距离关系对于深度学习来说也很重要。因此,如上图所示,我们提出了对比深度损失(CDL)来提供更强大的监督,这提高了基于深度防伪模型的通用性。

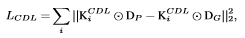

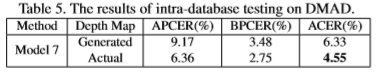

这个数据集总结了多种material材质(不同电子设备的屏幕材质,纸张的材质等),且包含多帧的真实depth信息,在该数据集上的实验结果如下表所示:

实验结果可见,真实的depth map结果明显优于generateddepth map,说明depth回归的精度确实会直接影响人脸防伪的精度,本文中设计的这种能够更精准的回归面部depth的方法是有意义的。

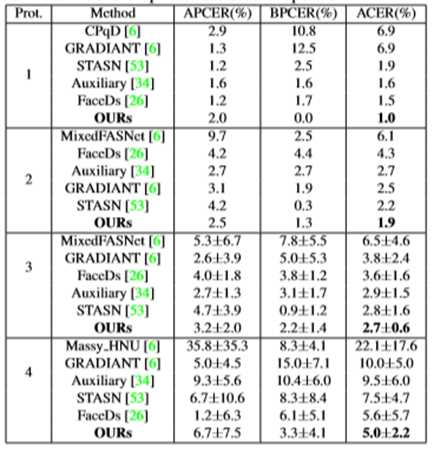

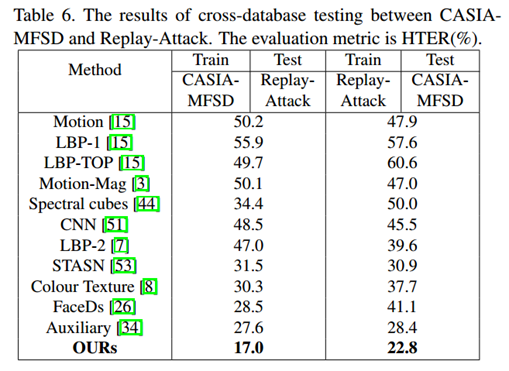

为了验证FAS-SGTD方法的先进性,本文在多个数据集、测试协议上进行测试,其中包括OULU-NPU,这是目前人脸防伪领域最具挑战性的数据集之一,这里面的伪造人脸非常高清,人眼都很难捕捉到线索。还包括跨数据集上的测试,数据集A上训练,B上测试,以及B上训练,A上测试;数据AB是完全不同源的。本文中的方法在各个数据集上都做到了SOTA,首先看一下FAS-SGTD在OULU-NPU上的表现如何:

上表可以看出FAS-SGTD在OULU-NPU上结果很不错,再来看下在很具挑战性的跨数据集测试协议上的实验结果:

可见FAS-SGTD在扩数据集测试上结果依然很鲁棒。

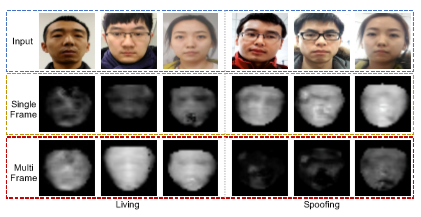

最后看一下多帧depth与单帧depth回归出来的人脸depth map的可视化结果:

图中还是能够明显看出,与单帧depth回归相比,通过多帧depth回归出来的真实人脸面部结构更清晰,伪造人脸的面部结构更稀疏。

在DMAD数据集上的结果可以看出距离真实的depth map,性能依然有差距,说明目前的多帧depth方法依然还有提升的空间。未来会探索更优的方法并且在更大的数据集上验证效果。

[1]Zitong Yu et al., Searching Central Difference Convolutional Networks for FaceAnti-Spoofing, CVPR2020

[2]Zezheng Wang et al., Deep Spatial Gradient and Temporal Depth Learning for FaceAnti-spoofing, CVPR2020 (Oral)

[3]Shuyang Sun et al., Optical flow guided feature: A fast and robust motionrepresentation for video action recognition, CVPR2018

[4]Yaojie Liu et al., Learning deep models for face anti-spoofing: Binary or auxiliarysupervision, CVPR2018

[5]Felix Juefei-Xu et al., Local binary convolutional neural networks, ICCV2017

[6]Shangzhen Luan et al., Gabor convolutional networks, TIP2018

[7]Yuhui Xu et al., PC-DARTS: Partial Channel Connections for Memory-EfficientDifferentiable Architecture Search, ICLR2020

[8]Cihang Xie et al., Feature Denoising for Improving Adversarial Robustness,CVPR2019

[9]Yunxiao Qin et al., Learning Meta Model for Zero- and Few-shot FaceAnti-spoofing, AAAI2020 (Spotlight)

![]()

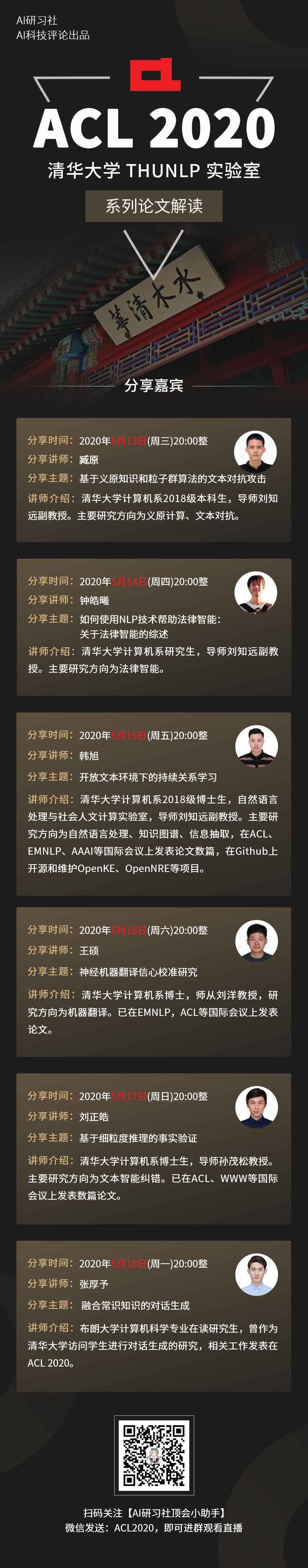

ACL 2020原定于2020年7月5日至10日在美国华盛顿西雅图举行,因新冠肺炎疫情改为线上会议。为促进学术交流,方便国内师生提早了解自然语言处理(NLP)前沿研究,AI 科技评论将推出「ACL 实验室系列论文解读」内容,同时欢迎更多实验室参与分享,敬请期待!

点击"阅读原文",直达“ACL 交流小组”了解更多会议信息。