揭秘 DeepMind 的关系推理网络

来源 | hackernoon

编译 | 孙薇

每当 DeepMind 发表一篇新文章时,媒体都会有狂热的报道,而你常常会在这些报道中读到一些充满误导性的词句。例如,有充满未来主义色彩的媒体是这样报道 DeepMind 关于关系推理网络的新论文的:

DeepMind 研发了一种可以感知周围事物的神经网络。

这样的表达不仅是误导,也使得对于人工智能领域并不是那么熟悉的用户感受到威胁。在这篇文章中,笔者整理了 DeepMind 的新论文,尝试用简单的方式来解释这个新的架构。

你可以在这里(https://arxiv.org/pdf/1706.01427.pdf)找到论文的原始版本。

想要理解这篇论文,首先你需要对神经网络有一些基本的了解。本文会尽量按照论文的整体结构来撰写,但同时也会融合自己的一些理解。

什么是关系推理(Relational Reasoning)?

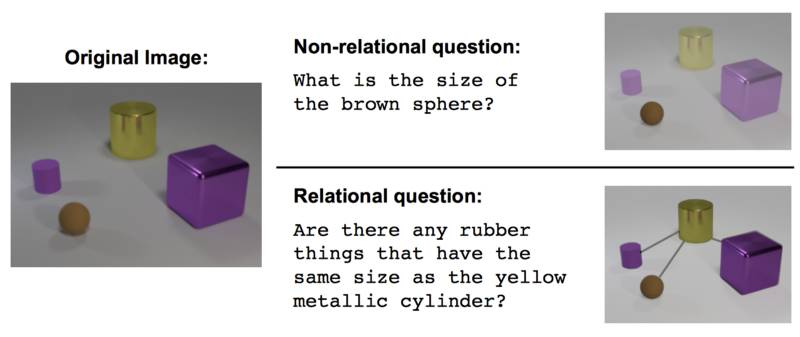

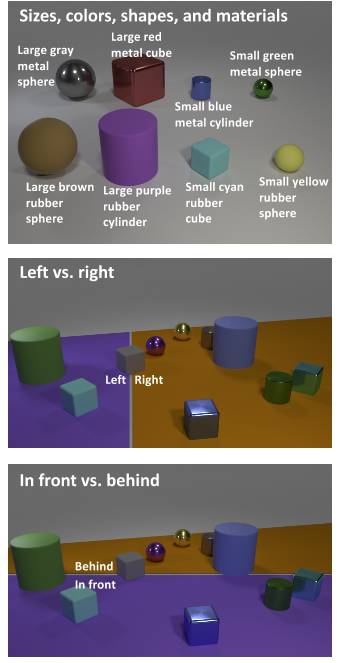

简单来说,关系推理尝试着去理解不同对象(概念)之间的关系,而这种推理被认为是智力的一个基本特征。作者们使用了一个信息图表来解释关系推理这一概念:

关系网络

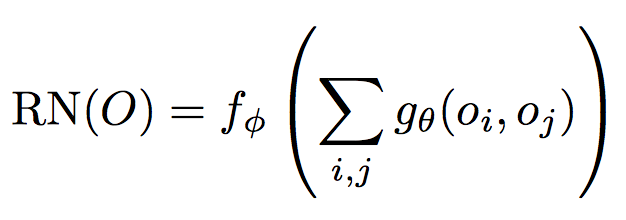

作者们提出了一种神经网络,用于捕获内在的关系(例如,卷积神经网络用于捕获图像的属性)。 他们提出了一个以下的架构:

对于方程式1.0的解释

关于O(O是一组你想要了解他们之中关系的对象)的关系网络是一个 fɸ 函数。

gθ 是另一个读取两个参数 oi 和 oj 的函数,它的输出结果是我们输入的这两个对象参数之间的”关系“。

Σ i,j 的意思是:对于 gθ ,计算所有可能的配对,并且对它们的结果求和。

神经网络和函数

在学习神经网络,反向传播算法(backprop)等时,人们很容易忘记神经网络实际上是一个单一的数学函数! 因此,我在等式1.0中描述的函数是一个神经网络! 更准确地说,是两个神经网络:

gθ , 计算两个对象之间的关系

fɸ , 对于 gθ 的所有结果进行求和,并且计算这个模型的最终输出结果

gθ 和 fɸ 都是多层感知器最简单的形态。

关系神经网络是柔性的

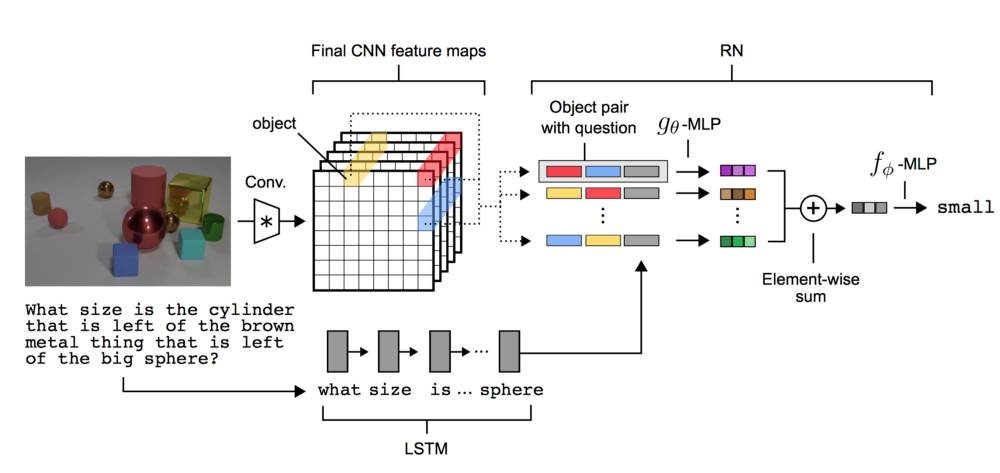

作者们将关系神经网络视为一个模块,它可以学习标记对象之间的关系,更重要的是,他们可以被放到卷积神经网络 (CNN) 和长短期记忆 (LSTM) 中。

卷积网络可以通过图像来了解各个对象,而这对于应用是十分有用的——相比于对于一系列人为定义的对象进行推理,对于图像的推理是更为有用的。

长短期记忆以及词嵌入 (word embedding) 可用于了解对于模型的查询指令的含义。这同样是十分有用的,因为模型现在可以接受并理解英文句子而不是编码数组。

作者们展示了一种可以将关系网络,卷积网络和长短期记忆结合在一起的方法,建立了一种能够学习对象之间关系的端对端神经网络。

对于图2.0的解释

标准卷积神经网络 (CNN) 在k个滤波器中提取该图像的特征。关系网络的“对象”是网格中每个点的特征向量。例如,其中一个“对象”是黄色向量。

一个长短期记忆 (LSTM) 处理被提出的问题,并产生一个代表这个问题的特征向量。这个向量是这个问题粗略的“想法”。

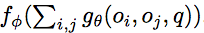

下面的公式稍微修改了方程式1.0。 它增加了另一个术语,如下:

注意使用长短期记忆 (LSTM) 的方程式1.0中所添加q——q是长短期记忆 (LSTM) 的最终状态。关系现在用q来作为条件。

之后,来自卷积神经网络 (CNN) 的“对象”和来自长短期记忆 (LSTM) 的向量被使用于训练关系网络。 每个对象以及每个来自长短期记忆 (LSTM)的问题向量都被用来训练,而它们都是的 gθ (神经网络) 的输入。

然后将 gθ 的输出相加,并用作 fɸ (另一个神经网络)的输入。之后, fɸ 会对问题的答案进行优化。

基准

作者证明了该模型对几个数据集的有效性。我将通过其中一个(在我看来有效性最显着的)数据集 – CLEVR数据集。

CLEVR数据集由不同形状,大小和颜色的对象的图像组成。该模型被问到及关于这些图像的问题,如:

立方体是否与圆柱体相同?

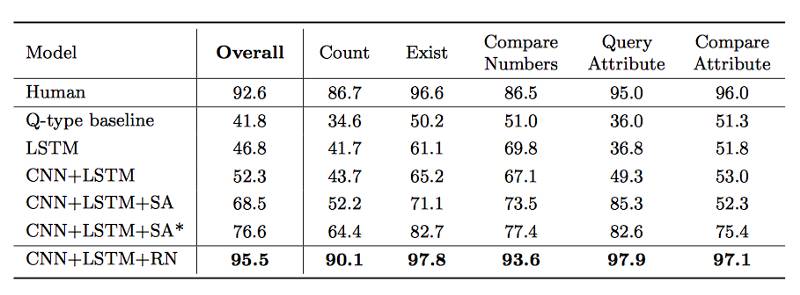

作者们指出,其他系统在准确性方面远远落后于他们自己的模型,这是因为关系网络旨在捕获关系。

他们的模型实现了前所未有的96%+精度,相比之下 Stacked Attention Model (堆叠注意力的模型)只有75%。

总结

关系网络非常擅长学习关系。 它们基于有效的数据方式,同时其比较灵活,并且可以在使用 CNN、LSTM 或两者时用作解决方案。

7月22-23日,本年度中国人工智能技术会议最强音——2017 中国人工智能大会(CCAI 2017)即将在杭州国际会议中心拉开序幕。汇集超过40位学术带头人、8场权威专家主题报告、4场开放式专题研讨会、超过2000位人工智能专业人士将参与本次会议.

目前,大会 8 折优惠门票正在火热发售中,扫描下方二维码或点击【阅读原文】火速抢票。