可解释性:对神经网络中层特征复杂度的解释与拆分

文 | 任洁,李明杰,刘泽旭

源 | 知乎

大家好,我们是任洁,李明杰和刘泽旭,本研究是在张拳石老师 @Qs.Zhang张拳石 指导下完成的工作。

随着深度神经网络的应用日益广泛,可解释性也逐渐受到更多学者的关注。目前对神经网络的可解释性研究主要分为两个方面,一方面是语义层面的解释,另一方面是数学层面对网络表达能力推导。在语义层面,最直接的方法是可视化神经网络的中层特征,同时很多研究也致力于估计输入样本中不同单元对于神经网络输出的重要性(attribution/importance/saliency)。在数学推导的层面,很多研究尝试从各个角度推导出神经网络表达能力的边界。然而,这两类解释性研究往往各自为战,语义层面的解释往往缺乏坚实的理论支撑,数学层面的推导又难以对接到人的认知,让人真正地理解神经网络。

在本文中,作者从特征复杂度的角度出发,尝试将语义解释与神经网络的表达能力相结合。神经网络的中层特征往往是混杂的,包含非常丰富的信息,其中,一些特征是简单的,另一些特征则是非常复杂的,需要经过复杂变换才能学习到。

受这一点启发,本文有如下工作:

-

定义了神经网络中层特征的复杂度; -

在语义层面,实现了对简单特征、复杂特征的拆分及可视化,发现简单特征往往表示物体的主体形状,而复杂特征则是一些细节、噪声信息; -

在表达能力层面,本文用可靠性、有效性,及过拟合程度评测了神经网络特征,量化了特征表达能力与特征复杂度、训练样本数等因素之间的联系; -

基于上述结论,本文利用拆分出的特征向量进一步提升了神经网络的性能,并解释了经典学习算法的效果。

论文标题:

Interpreting and Disentangling Feature Components of Various Complexity from DNNs

论文链接:

http://proceedings.mlr.press/v139/ren21b.html

算法简介

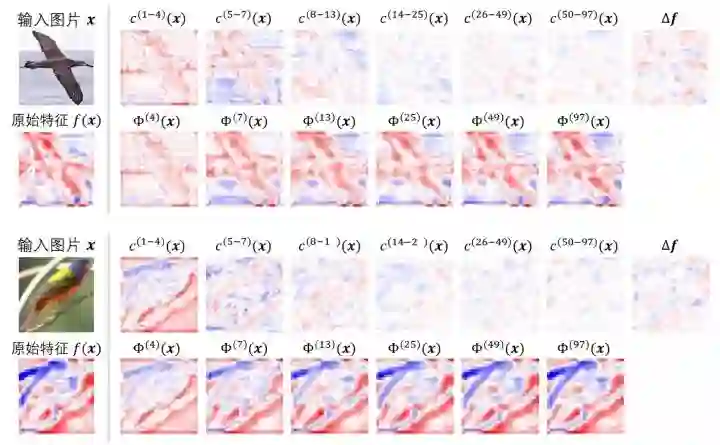

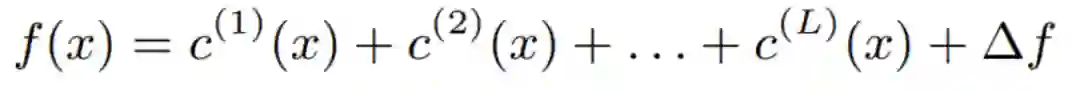

将神经网络中层特征解构并可视化出不同复杂度的特征分量: 神经网络从输入样本中抽取得到了非常丰富的特征,而这些特征既包含简单的特征分量,也包含复杂的特征分量。简单的特征分量往往经过简单的变换就能得到,例如通过一个较浅的神经网络,而复杂的特征分量则需要较深的神经网络才能拟合。即,给定一个训练好的神经网络 ,和输入 ,其中层特征 中包含了不同复杂度的特征分量:

其中

表示不同复杂度的特征分量。我们利用学习某个特征分量所需要的最少的非线性变换数来量化这个特征分量的复杂度。例如,单层神经网络(只包含一个非线性层)所能拟合的特征分量

的复杂度阶数定义为1阶,

称为

的一阶复杂度分量。包含连个非线性层的神经网络所能够拟合的特征

称为二阶复杂度分量,以此类推。

为了从 中拆分出不同复杂度的特征分量,我们通过知识蒸馏的方法训练多个不同深度(包含不同多个非线性层)的拆分网络,浅层的神经网络只能学习到简单特征,而深层网络所拟合的特征包含了简单特征和复杂特征。因此,深度为 的拆分网络和深度为 的拆分网络所拟合的特征的差值,就是复杂度为l阶的特征分量。

下图展示了不同阶特征分量的可视化结果。可以看出,简单特征往往包含与输入物体形状相关的信息,而复杂的特征分量包含了更多的细节信息和噪声信息。

探索实验

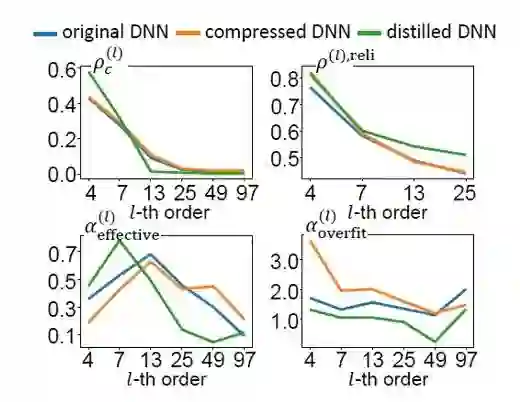

基于上述特征复杂度的定义,我们提出了一系列指标,量化分析了不同特征分量的可靠性、有效性和过拟合程度。

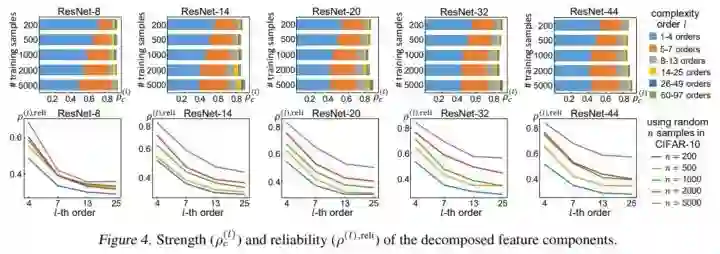

1.可靠性: 本课题组前期的特征表达一致性理论[1]已经证明,对于同一项任务,不同神经网络往往会建模一些公共信息,这些公共信息被认为是完成这项任务的可靠特征。本文中,我们从各阶复杂度的特征分量中进一步提取出了可靠的特征子分量,从而量化了不同复杂度特征分量的可靠性。

实验中,我们发现,增加神经网络的训练样本量,能够有效提升特征的可靠性,但不会显著影响特征复杂度的分布,这在一定程度上与人们的直觉是相反的。

2. 有效性: 基于Shapley value,我们量化了特征分量是否有效地帮助了神经网络的分类(或其他任务)。我们用每个特征分量对分类任务的损失函数的下降的Shapley value量化特征分量的有效性,发现特征不是越复杂越有效的,相反,当特征复杂度为网络深度的一半时,特征分量的有效性最高。

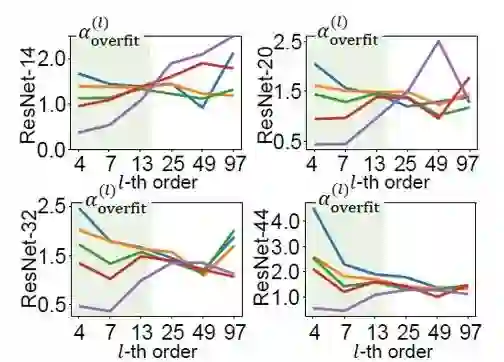

3. 过拟合程度: 与有效性类似,我们利用特征分量对训练损失与测试损失差值的Shapley value,量化特征分量是否是过拟合的。实验发现,当增加训练样本量时,往往能够降低简单特征(低复杂度的特征分量)的过拟合程度,而这一规律对于复杂特征并不适用。

拓展应用

基于以上实验发现,我们进一步利用特征复杂度去提升网络性能,并解释了知识蒸馏、网络压缩这两种经典的深度学习算法。

1. 提升网络性能

前文中我们已经发现,当特征分量的复杂度为网络深度一半时,该分量是对任务最有效的。因此,我们将神经网络原始特征 替换为所拆分出的有效特征分量,使神经网络的分类性能最高提升了5%;并且,我们发现中阶复杂度的特征对神经网络性能的提升更加有效。

2. 解释经典算法

本文中,我们解释了网络压缩和知识蒸馏两种算法对神经网络特征复杂度的影响,发现知识蒸馏使神经网络学到了更可靠、更有效的特征,从而在一定程度上提升了网络性能;网络压缩则主要作用于网络中的简单特征,且不会影响特征可靠性,因此能够保证网络性能不受显著破坏。

【作者】

任洁*:上海交通大学博士一年级,师从张拳石副教授。

李明杰*:上海交通大学本科四年级,现在张拳石实验室进行实习研究。

刘泽旭:上海交通大学本科三年级,曾在张拳石实验室进行实习研究。

张拳石:上海交通大学副教授,博士生导师。[http://qszhang.com]

后台回复关键词【入群】

加入卖萌屋NLP/IR/Rec与求职讨论群

后台回复关键词【顶会】

获取ACL、CIKM等各大顶会论文集!

![]()

[1].https://zhuanlan.zhihu.com/p/102311760

后台回复关键词【

后台回复关键词【