35亿张图像!Facebook基于弱监督学习刷新ImageNet基准测试记录

更多干货内容请关注微信公众号“AI 前线”,(ID:ai-front)

图像识别是人工智能研究的一大支柱,同时也是 Facebook 聚焦的领域之一。我们的研究人员和工程师旨在打破计算机视觉技术的界限,将这项工作应用于现实世界,例如,利用 AI 为视障用户生成照片的音频标题。为了改进计算机视觉系统并训练其识别和分类各种各样的物体,我们每天需要训练数十亿张图像,而不仅是数百万的数据集。

由于目前的模型通常是对经过人类手动进行标记的数据进行训练,所以提高识别率并不是简单地投入更多训练图像就可做到的。这种劳动密集型的监督式学习通常会产生最佳的性能结果,但手动标记数据集这样的方式限制了功能的发展。Facebook 对一些模型进行训练的图像规模达 5000 万,但当训练图像扩大到数十亿的规模时,这种用人工进行所有监督的方式显然是不可行的。

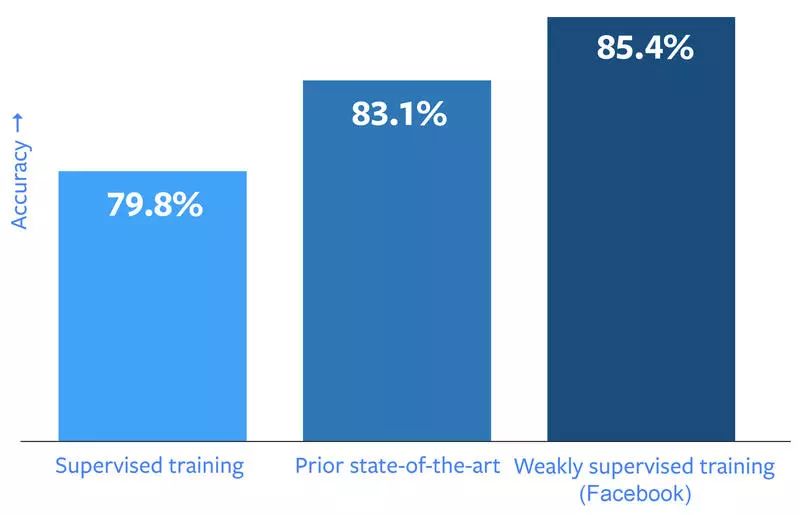

为了解决这个问题,我们的研究人员和工程师在带有标签的大量公共图像上训练图像识别网络,其中最大的图像数据集包括 35 亿张图像和 17000 个主题标签。这种方法的关键是使用现有的、公开的、用户提供的主题标签作为标签,而不是手动对每张图片进行分类。这种方法在我们的测试中运行良好。通过用包含 10 亿张图像的公共数据集来训练计算机视觉系统,我们在常见的基准测试工具 ImageNet 上获得了创纪录的高分,准确率达到 85.4%。除了在图像识别性能方面实现了真正的突破之外,本研究还提供了关于如何从监督式向弱监督式训练转变的方法。在本实验中,我们使用的是现有标签,而不是 AI 训练专用和挑选的标签。我们计划在未来开放这些模型的嵌入源,因此广大研究团体可以使用这些表示来创建高级任务。

由于人们经常使用标签标注他们的照片,因此这些带标签的图像成为模型训练数据的理想来源,而且会引导我们发现更多的相关图片数据。

但有的标签经常可能是非视觉化的概念,例如表示“回到周四”的标签 #tbt。或者有些标签含糊不清,比如标签 #party,它可以表示一个活动或一个设定,或者两者兼而有之。在图像识别过程中,标签充当弱监督数据,模糊和 / 或不相关主题标签则成为可能混淆深度学习模型的不相干标签噪声。

这些标签噪声对我们的大规模训练工作至关重要,因此我们开发了新的方法,专门用于使用标签监督进行图像识别实验,包括处理每个图像的多个标签(因为添加主题标签的人倾向于使用多个标签),通过主题标签同义词进行排序,以及平衡频繁使用主题标签和罕见标签的影响。为了使标签对图像识别训练有用,团队训练了一个大型标签预测模型。这种方法的迁移学习效果出色,这意味着该模型生成的图像分类广泛适用于其他 AI 系统。这项新工作建立在 Facebook 的前期研究基础上,包括基于用户评论、标签和视频的图像分类调查。这种对弱监督学习的新探索是在多个团队的合作下进行的,包括 Facebook 的应用机器学习部(AML)和 Facebook 人工智能研究部(FAIR)。

由于在一台机器上完成这样的训练需要一年多的时间,因此我们创建了一种向 336 个 GPU 分配任务的方法,将总训练时间缩短至几周。随着模型规模越来越大 ——其中最大的 ResNeXt 101-32x48d(https://github.com/facebookresearch/ResNeXt)参数超过 8.61 亿——这种分布式训练的方法变得越来越重要。此外,我们设计了一种去除重复的方法,以确保不会意外地在我们想要评估的图像上进行模型训练,这解决了困扰此领域类似研究的一大问题。

尽管我们预计图像识别的性能会有所提升,但结果出奇地好。在 ImageNet 图像识别基准测试中,我们的最佳模型通过 10 亿张带有 1500 个主题标签词汇图像,实现了 85.4%的准确率。这是迄今为止 ImageNet 基准测试的最高准确度,比之前的最新模型准确率提高了 2%。* 考虑到卷积网络架构的影响,此次性能提升更为显著:使用数十亿图像和标签进行深度学习可以达到 22.5%的改进。

在另一个主要的基准测试——COCO 目标检测挑战中,我们发现使用标签进行预训练可以将模型的平均准确率提高 2%以上。

这些是图像识别和物体检测的基础性的改进,代表了计算机视觉向前迈出了一步。但是我们的实验也揭示了大规模训练和嘈杂标签处理中潜在的机遇和具体的问题。

例如,尽管增加训练数据集的规模很重要,但选择与特定识别任务相匹配的一组标签可能更为重要。我们通过对 1 亿张图像进行训练,获得 1500 个与 ImageNet 数据集中的类相匹配的标签,而不是对相同图像数量的所有 17000 个主题标签进行训练。另一方面,对于具有更大视觉多样性的任务,使用 17000 个主题标签进行训练,模型的性能改进更加明显,这表明我们应该在未来的训练中增加主题标签的数量。

增加训练数据量通常对图像分类很有好处,但可能会引起新的问题,包括图像中物体本地化能力的明显下降。我们还观察到,最大的模型仍然没有充分利用 35 亿图像集的优势,这表明我们应该训练更大的模型。

这项研究得出的其中一个结论甚至比图像识别方面的进步具有更大的意义,即确定了用主题标签进行计算机视觉模型训练是完全行得通的。虽然我们使用了一些合并类似主题标签和减轻其他标签权重的基本技术,但不需要复杂的“清洁”程序来消除标签噪声。相反地,我们能够做到不对训练程序进行大幅修改的前提下,使用主题标签来训练我们的模型。本实验中规模是一个优势,因为在数十亿的图像上训练的网络对标签噪声的恢复能力显然更强。

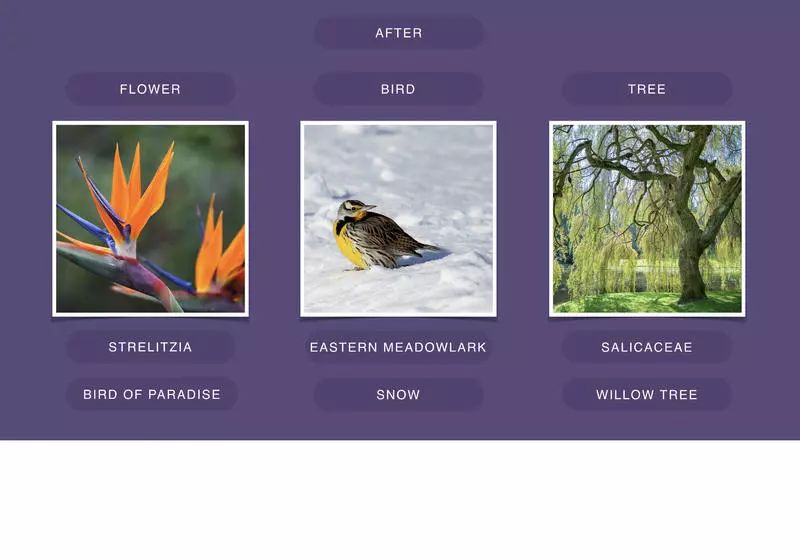

在不久的将来,我们可以设想其他使用主题标签作为计算机视觉标签的方式,包括使用 AI 来更好地理解视频片段或更改 Facebook Feeds 中图像的排序方式。主题标签不仅可以帮助系统识别图像属于哪种一般类别,还可以识别出更具体的子类别。例如,一个描述树上有一只鸟的音频标题虽然可能有用,但是可以精确到物种的标题(例如一只北美红雀在糖枫树上栖息)则可能对一位视障用户更加有意义。

标签可以帮助计算机视觉系统超越一般分类术语,识别图像中特定的子类别和附加元素

除了特定标签的使用,这项研究还可能帮助现有和新产品图像识别技术得以改进。例如,更准确的模型可能会改进我们在 Facebook 上呈现 Memories 的方式。另外,这项研究旨在与弱监督数据相关的长期应用,随着训练数据集越来越大,从长远来看,弱监督或无监督学习将变得越来越重要。因此,了解如何弥补噪音和标签较少的缺点对于构建和使用较大规模的训练模型至关重要。

这项研究在 Dhruv Mahajan、Ross Girshick、Vignesh Ramanathan、Manohar Paluri、Laurens van der Maaten 的Exploring the Limits of Weakly Supervised Pretraining中有更详细的描述

(https://research.fb.com/publications/exploring-the-limits-of-weakly-supervised-pretraining/)。

由于本实验在规模上史无前例,本文详述的观点将为一系列新的研究方向铺平道路,包括开发新一代可以从数十亿张图像中有效学习的,足够复杂的深度学习模型。

这项工作还表明,虽然我们有 ImageNet 等被广泛使用的基准测试方法,但我们仍需要开发新的、监督更少、规模更大的 benchmark,使我们能够更好地衡量当今图像识别系统的质量和局限性。

原文链接:

https://code.facebook.com/posts/1700437286678763/

以下是编辑精选的往期好文

往期好文:

苹果重新开源分布式数据库FoundationDB,已在内部使用三年!

如果你喜欢这篇文章,或希望看到更多类似优质报道,记得给我留言和点赞哦!