图片一缩放,AI就把熊猫“认”成长臂猿了,这么傻的AI该如何保护?

来自德国 Braunschweig 技术大学的研究人员通过大量实验已经证明,仔细修改数码照片的像素值可以使照片在缩小尺寸后变成与之前完全不同的图像,而这些对图像的修改操作在人工智能算法领域的影响值得被广泛关注。

图像缩放技术在人工智能研究领域有着十分重要的地位,但是也存在一些挑战。其主要的问题就是, 恶意攻击者可以利用这种图像缩放技术,对用于人脸识别、目标检测等计算机视觉方向的机器学习模型发起对抗性攻击。

其中,对抗性机器学习是一种对数据进行操作的技术,它能在不被人类察觉的情况下改变人工智能算法的行为,而创建对抗性的机器学习示例是一个反复试验的过程。创建对抗性示例包括对图像像素进行细微的调整,再通过 AI 算法重新运行该图像,以查看图像置信度的变化。通过适当调整后,可以自动化创建一个噪音映射(noise map)来降低一个类的置信度,而提高另一个类的置信度。

在今年 Usenix 安全研讨会上发表的一篇论文中,TU Braunschweig 的研究人员就针对机器学习系统的分级和防止对抗性图像缩放攻击进行了深入的回顾。他们的发现不断提醒我们,AI 算法许多隐藏的方面和威胁还未被发现,导致这些影响在我们的日常生活中正变得越来越突出。

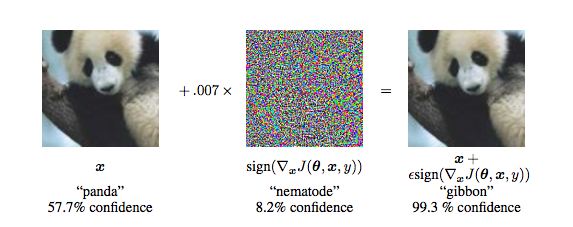

当在许多实例上训练时,机器学习模型创建不同类之间相似性程度的数学表达。例如,如果你训练一个机器学习算法来区分熊猫和长臂猿,它就会尝试创建一个统计模型来区分新图像中的像素是更像熊猫还是长臂猿。

实际上,这些人工智能算法学习区分不同物体的方式与人类视觉的工作方式不同。大多数对抗性攻击利用这种差异,在改变机器学习系统输出的同时,进行人类肉眼无法察觉的细微调整。

例如,当你让一个人描述他是如何从图片中发现熊猫的,他可能会寻找一些目标的身体特征,比如眼睛周围的黑色毛发,黑白相间的皮毛以及体型大小。他可能还会给出其他的背景,比如他希望看到熊猫在什么样的栖息地,会摆出什么样的动作姿势等等。

而对于人工神经网络来说,只要根据公式,通过计算机程序运行图像的像素值提供正确的答案,就确信所看到的图像确实是一只熊猫。换句话说,通过正确地调整图像中的像素值,你也可以让 AI 误以为它看到的不是熊猫。

其中的细节在于,研究人员在图像上添加了一层人眼几乎觉察不到的噪声。

研究人员在他们的论文中写道:“尽管大量研究都在研究针对学习算法的攻击,但目前为止,几乎没有人关注机器学习预处理中的漏洞。”但是,当经典的对抗性攻击利用人工智能算法内部工作的特性时,图像缩放攻击就集中在机器学习流水线的预处理阶段。

无论你是在训练一个机器学习模型,还是用该模型进行推理(分类、目标检测等),都需要对输入图像进行预处理以满足 AI 的输入要求。根据以上提及的所有需求,我们可以假定预处理过程通常需要将图像缩放到合适的大小。并且,就像我们通常在软件中遇到的情况一样,当黑客知道一个程序(或者至少是程序的一部分)工作过程的时候,他们会试图找到方法修改程序来谋取私利。而这就是图像缩放攻击发挥作用的地方。

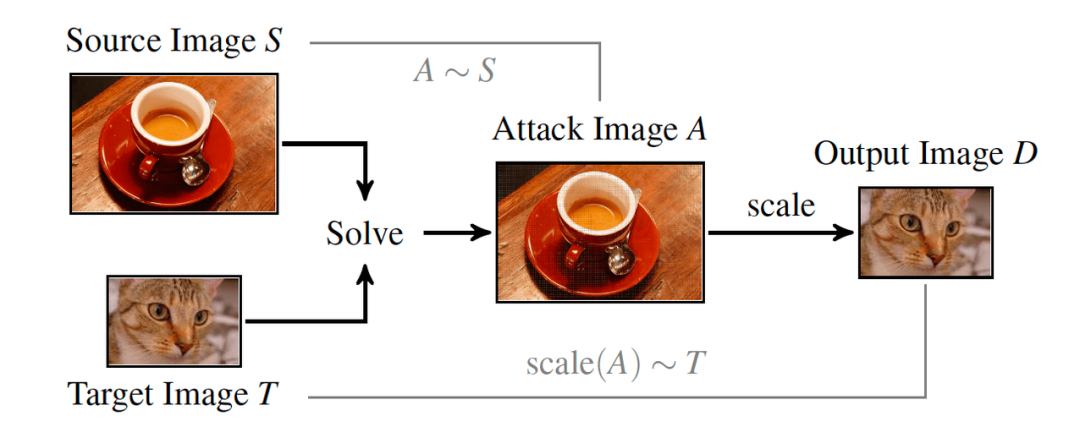

图像缩放攻击的关键思想是在预处理阶段通过调整图像像素大小来改变输入图像的外观。事实上,机器学习和深度学习大多都使用一些众所周知且有文档记载的缩放算法。这些算法中的大多数(比如最近邻插值和双线性插值)都和 Photoshop 等用于图像编辑的应用程序使用的算法一样,这使得攻击者更容易设计出同时适用于多种机器学习算法的漏洞。

当图像被缩小时,进行缩放后的图像的每个像素都是源图像中像素块值的组合,其中执行这种转换的数学函数称为“核函数”。然而,并不是源像素块中的所有像素在核函数中的贡献是相等的(如果相等会使得调整后的图像会变得太模糊)。因此,在大多数算法中,核函数将更大的权重赋给更接近源像素块中间的像素。

在对抗性预处理中,攻击者获取一幅图像,并在正确的位置对像素值进行适当调整。当图像经过缩放算法后,它会变成目标图像。最后,再用机器学习算法处理修改后的图像。基本上,人眼看到的是源图像,而机器学习模型看到的是目标图像。

当攻击一个机器学习模型时,攻击者必须知道所使用的大小调整算法的类型和核函数的核大小。由于大多数机器学习库中只有很少的缩放选项,因此研究人员通过实验发现攻击者只需尝试几次就能得到正确的参数设置。

在 TechTalks 的评论中,IBM Research 的首席科学家 Chen Pin-Yu 将图像缩放与隐写术(steganography)进行了比较,后者将消息(这里是缩小后的图像)嵌入源图像中,只能采用缩小后的算法进行解码。

写过几篇关于对抗性机器学习论文的 Chen 说:“我很好奇这种攻击是否也与图像缩放算法无关。但基于通用摄动的成功,我认为通用图像缩放攻击也是可行的。”

对于机器学习算法方向的图像缩放攻击主要有两种情况。其中一种攻击类型是创建在经过训练后的机器学习算法中产生错误预测的对抗性实例。但研究人员在他们的论文中指出,或许“数据中毒”攻击才是图像缩放的更大威胁。

而“数据中毒”是一种对抗性攻击,在当机器学习模型调整其参数到图像的成千上万像素这一训练阶段时发生。如果攻击者能够访问并篡改训练中使用的数据集,就能够让机器学习模型在对抗性示例上进行训练。

示例一:

假设有一家公司正在开发一种面部识别系统,以控制在处理敏感材料区域的访问权限。为了做到这一点,该公司的工程师们正在训练一个卷积神经网络来检测授权员工的脸部。

当团队正在收集训练数据集时,一个有意破坏的员工偷偷地将一些篡改过的图像隐藏在未经授权的员工的面部照片中。在训练了神经网络之后,工程师们为了确保系统能正确地检测到被授权的员工,对其进行测试。他们还会检查一些随机图像,以确保 AI 算法不会将访问权限错误地授予给非授权人员。

但这就存在一个问题,只有他们明确地检查对抗性攻击中被攻击者脸部的机器学习模型,他们才会发现被恶意篡改的数据。

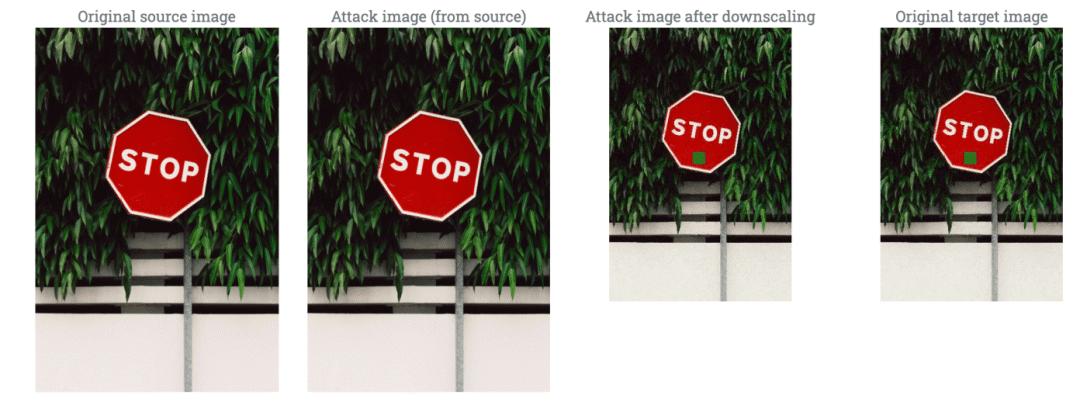

假设你正在训练一个神经网络来识别停车标志的图像,以便以后在自动驾驶汽车时使用。

恶意攻击者可以破坏训练数据,使其包含经过修补的停车标志图像,这些图像被称为“对抗性补丁”。经过训练后,神经网络把该补丁上的所有标志与目标联系起来。

这样会导致自动驾驶汽车把一些随机的标志当作停车标志,或者更糟的是,进行错误分类并绕过真正的停车标志。

保护机器学习模型

这使得图像缩放攻击“与模型无关”,意思就是它们对目标人工智能算法类型不敏感,而单一的攻击方案可以应用于整个范围的机器学习算法。相比之下,经典的对抗性例子是为每种机器学习模型设计的,如果目标模型发生轻微变化,攻击极有可能不再有效。

Chen 在论文中说道:“与白盒对抗性攻击相比,图像缩放攻击需要更少的信息(只需要知道目标系统使用了何种缩放算法),所以从攻击者的角度来看,它是一种更实用的攻击。”“然而,它仍然没有不需要目标机器学习模型信息的黑盒对抗性攻击实用。”其中,黑盒对抗性攻击是一种通过观察机器学习模型的输出值来产生对抗性扰动的高级技术。

Chen 接着在文章中承认,图像缩放攻击确实是一种生成对抗性实例的有效方法。但他补充道,缩放操作并不是都出现在每个机器学习系统中。他说:“图像缩放攻击仅限于基于图像且具有缩放操作的模型,但是在没有缩放操作和其他数据模式的图像模型中也可能存在对抗性实例。”对抗性机器学习也适用于音频和文本数据。

TU Braunschweig 的研究人员在文中写道:“由于机器学习模型的复杂性,针对学习算法的攻击仍然难以分析,但定义坚挺的缩放算法结构使得我们能更全面地分析缩放攻击并开发有效的防御技术。”在他们的论文中,研究人员提供了几种阻挠对抗性图像缩放攻击的方法,包括平滑核函数的权重缩放算法以及可以消除篡改像素值影响的图像重建过滤器。

“我们的工作为机器学习中预处理的安全性提供了新的见解,”研究人员写道。“我们相信,有必要进行深入的研究工作,从而确定和排除数据处理不同阶段的漏洞,同时加强以学习为基础的系统的安全性能。”让机器学习算法对对抗性攻击具有鲁棒性已成为近年来一个较为活跃的研究领域。对抗性实例除了用于攻击之外也被用于模型训练,以增强模型的健壮性。因此,为了进行对抗性模型训练,不同类型的对抗性攻击实施是有益的。

编译:冯雪璐

排版:赵辰霞

编审:王新凯

参考文献:

https://thenextweb.com/neural/2020/08/13/image-scaling-attacks-highlight-dangers-of-adversarial-machine-learning-syndication/

https://bdtechtalks.com/2020/07/15/machine-learning-adversarial-examples/