怼完Sophia怼深度学习!细数完大神Yann LeCun 这些年怼过的N件事,原来顶级高手是这样怼人的...

图片来源:PCmag.com

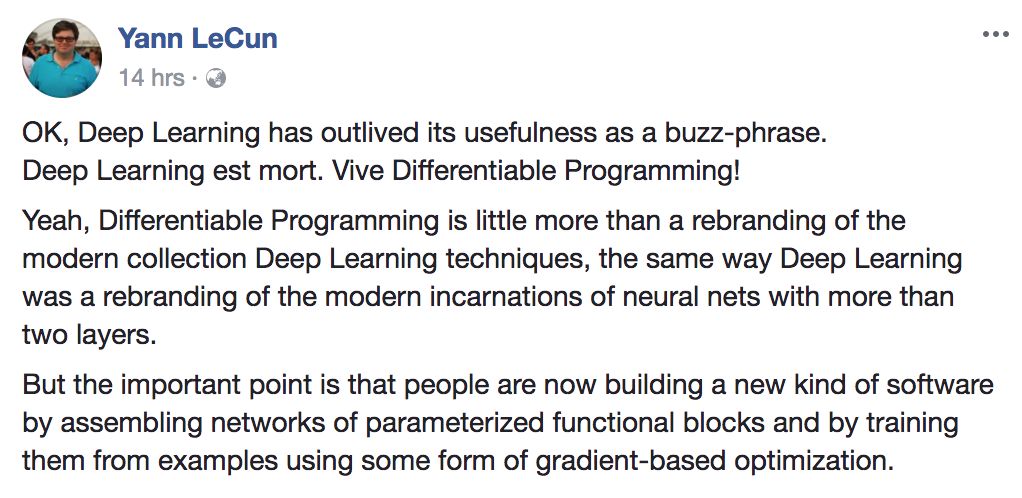

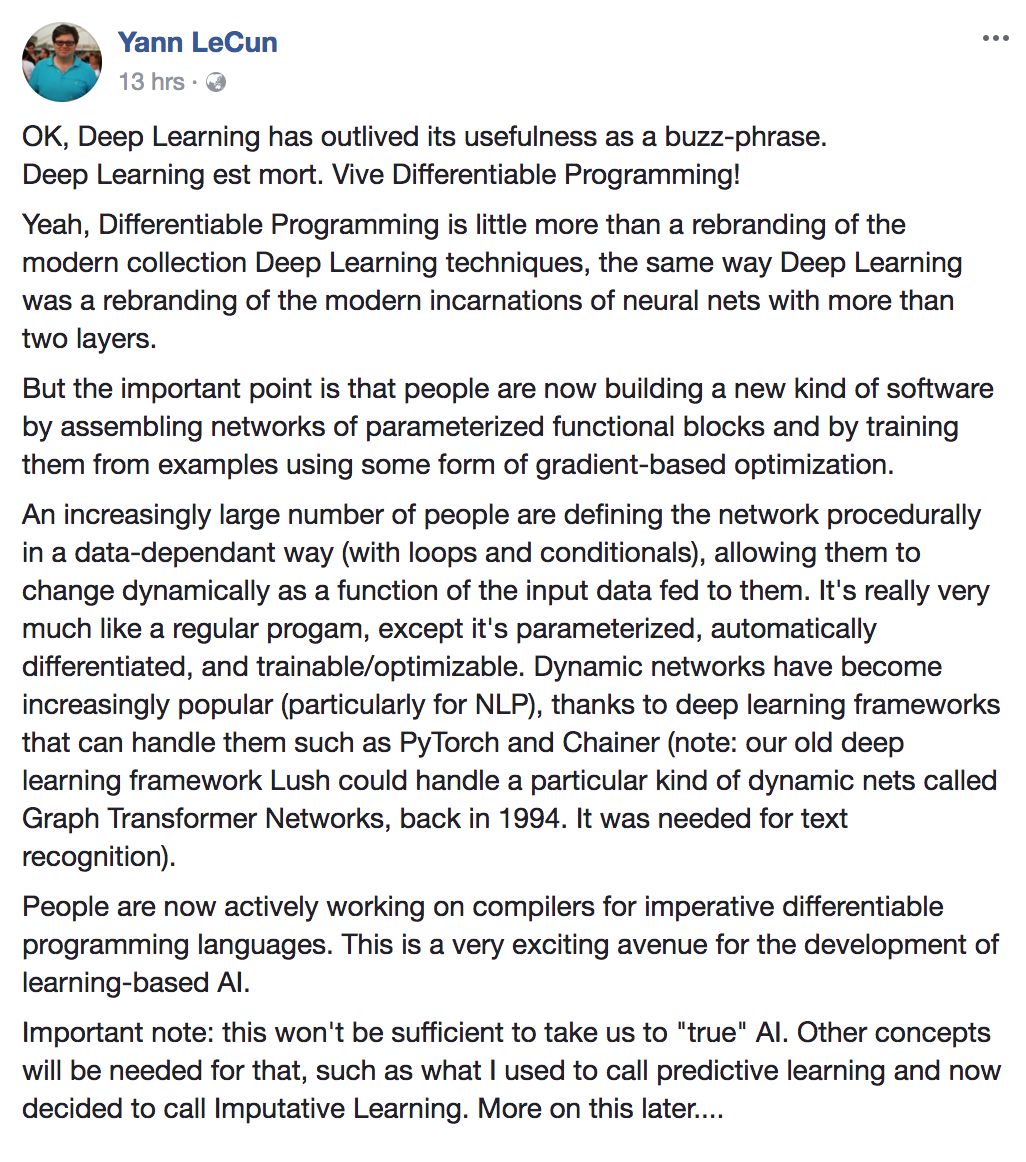

十多个小时前,深度学习大神Yann LeCun语出惊人,他宣布放弃“深度学习”这个词。因为媒体对这个词的炒作言过其实,混淆了大家真正的工作,而“可微分编程”才是对此更好的描述:

“将各种参数化的函数模块网络组装起来,做成新软件,同时以某种基于梯度的优化再将其训练出来”

这跟普通的编程工作也没多大差别,除了参数化的自动微分,以及对软件训练和优化……LeCun说他回头会给出一个更详细的说法。

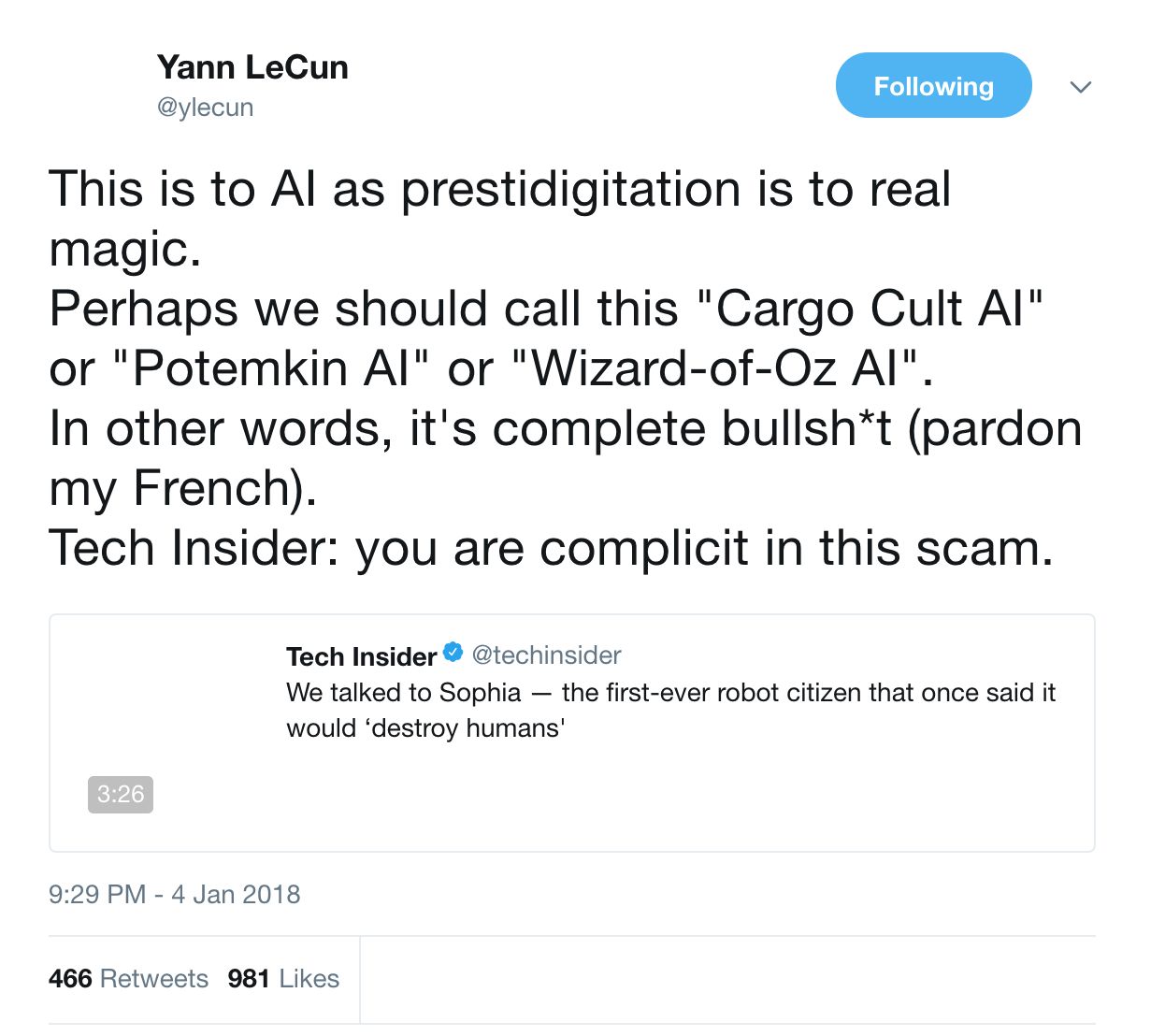

话分两头,这就是昨天LeCun用Twitter上“怒怼”过机器人Sophia之后的事。一向敢怒敢言的LeCun终于说出了广大AI圈人士的心声:

“(Sophia)相对于真正的AI,就像变戏法相对于真正的魔法。我们应该称它为“草包族AI”,或是“

“Tech Insider:你们媒体就是这场骗局的始作俑者!”

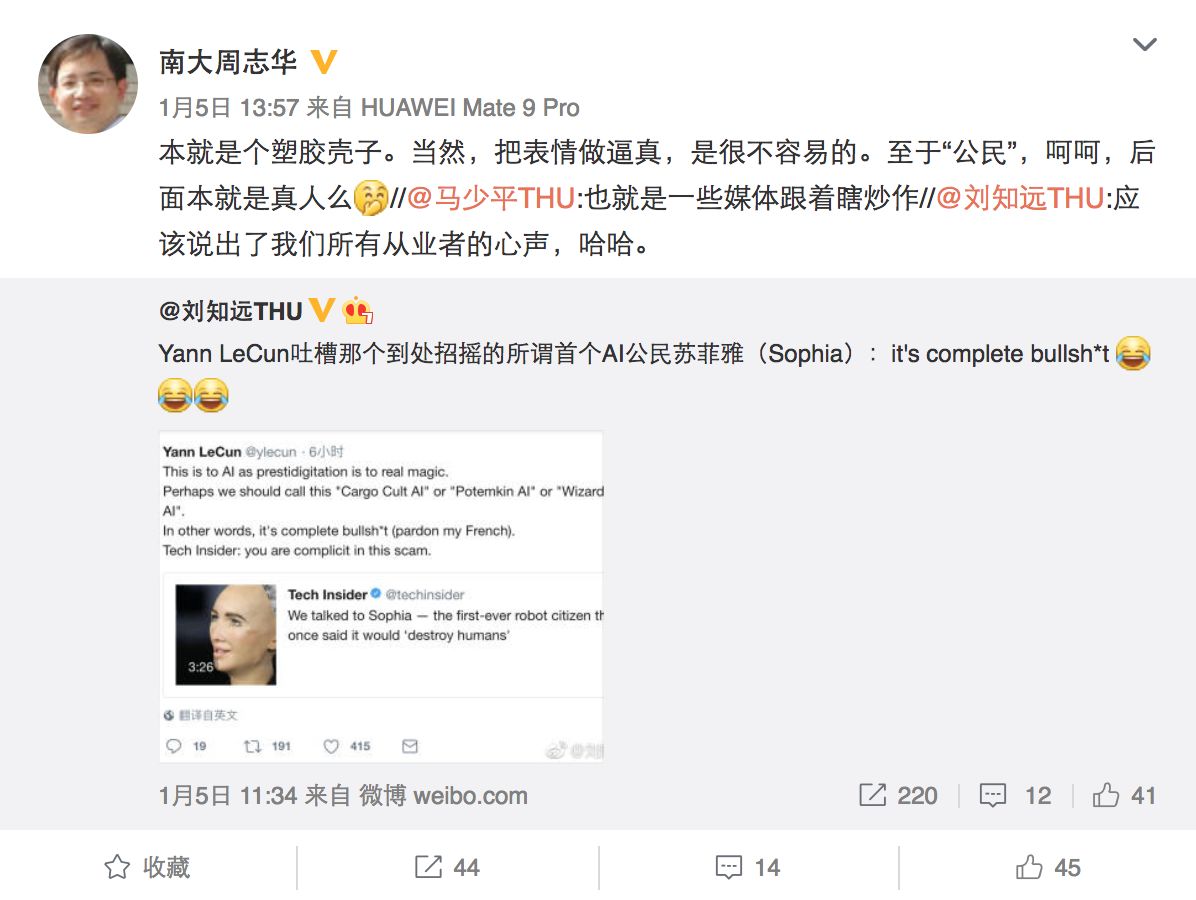

这条推特迅速在国内的AI圈转了起来。南大周志华教授,清华计算机系马少平教授等圈内人士迅速在微博上为LeCun的仗义执言拍手叫好:

Yann LeCun其人,Facebook AI研究院(FAIR)负责人,深度学习三架马车之一,卷积神经网络(CNN)之父,享受得了万人敬仰,也在无人问津的寒冬挣扎过。

他于1960年出生在巴黎,1987-1989年博士后期间拜在大神Geoffrey Hinton门下,1988年被Larry Jackel招入贝尔实验室,1989年提出在计算机视觉中使用卷积神经网络,其后此项技术被用于在自动取款机上读取支票,影响至今。1998年又提出基于梯度的学习。

或许是天性,又或许是经历过神经网络和深度学习备受质疑的八九十年代,LeCun像是一个好斗、倔强又满怀热情的小孩,“怼天怼地怼同行”。

网络上公开记录的LeCun第一次参与学术争论是在1995年,只不过那次他作为了第三方签字人。赌局的双方分别是支持向量机(SVM)之父Vladinmir Vapnik和上文提到的Jackel。主题是深度人工神经网络(deep artificial neural nets)的内在原理明朗化的时间节点,Jackel乐观地认为是2000年,而Vapnik认为至少到2005年。这场赌局的赌注是一顿大餐。

到了千禧年,深度人工神经网络的内在原理仍然迷雾重重,Jackel应该是请客了。不过到了2005年,LeCun早期提出的卷积神经网络已经在银行和ATM机上得到了广泛运用。虽然原理仍不明朗,但LeCun显然是为自己在贝尔实验室的部门主管Jackel挽回了些许面子。

2004年,Hinton创立了神经计算和自适应感知(NCAP)项目,汇聚各领域的人才来模拟人类大脑在视觉、听觉和书面的线索,并在短时间内取得早期的成果后,深度学习开始由边缘学科变成企业和各大学研究院争相研究的核心课题。而一直对卷积神经网络“不离不弃”的LeCun,也顺势成为了学术圈的焦点。

自从近年来加入了Facebook AI实验室后,LeCun俨然成为了深度学习领域的“超级网红”。每一次大的争论,都少不了他的参与。下面营长就来为大家细数,这几年,深度学习届的“飞天蝙蝠柯大侠”(就是金庸笔下那位“义救北丐、痰吐东邪、掌掴北侠、怒斥西狂、杖打西毒”郭靖大师傅)怼过的人或事。

LeCun vs OpenAI

去年三月,OpenAI发表最新论文,认为对抗样本(Adversarial Examples)是AI安全的隐忧,并实验了一系列并不成功的抵抗方法,例如:对抗训练(Adversarial training)、防御净化(Defensive distillation)和梯度隐藏(gradient masking)。随后,OpenAI认为学术界必须找出阻止对抗样本的方法。

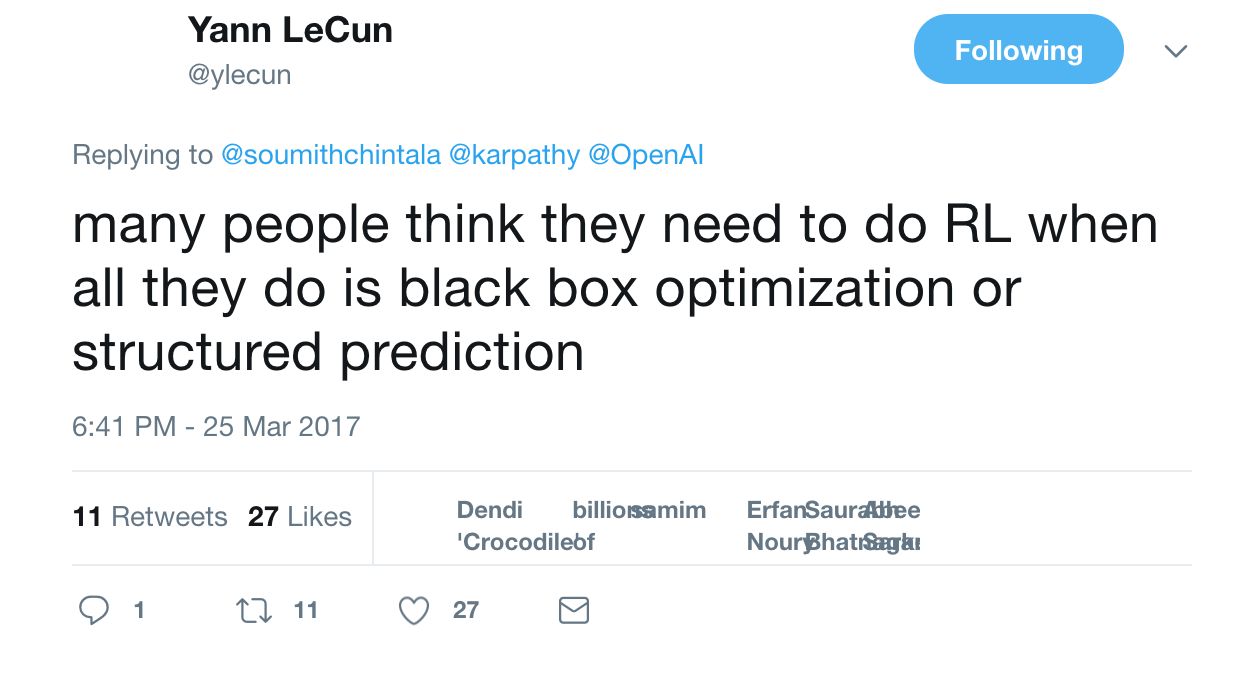

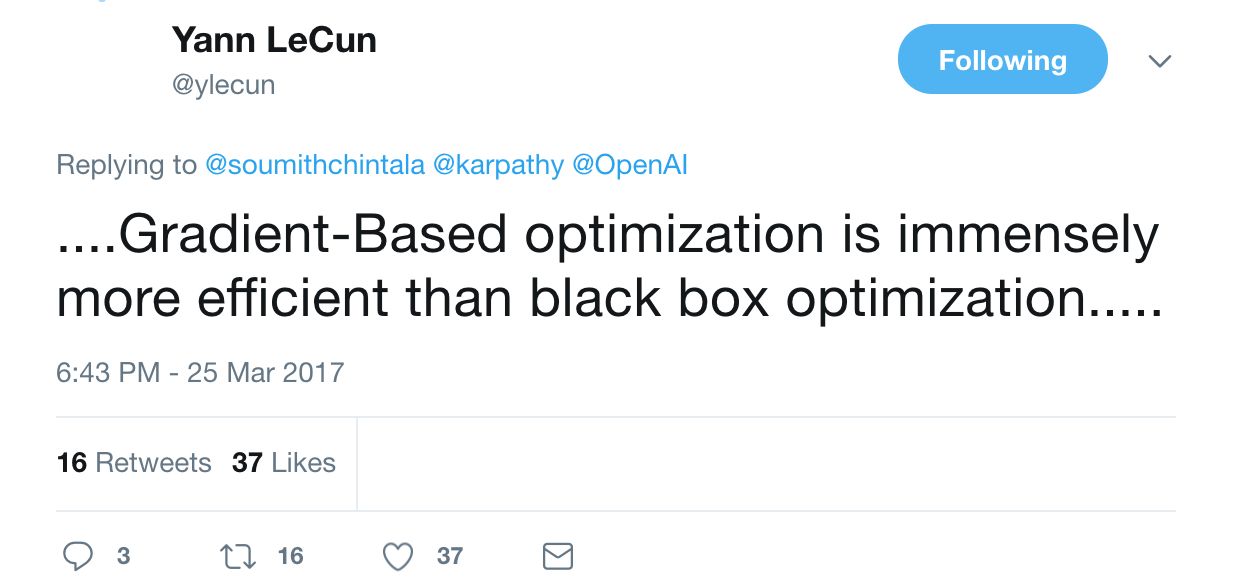

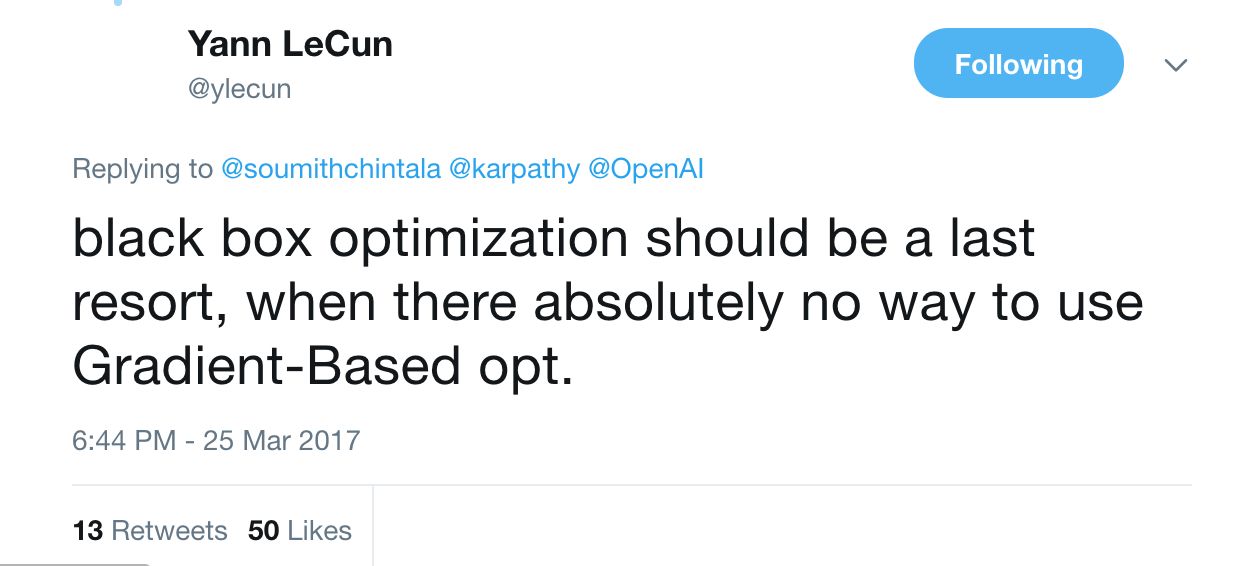

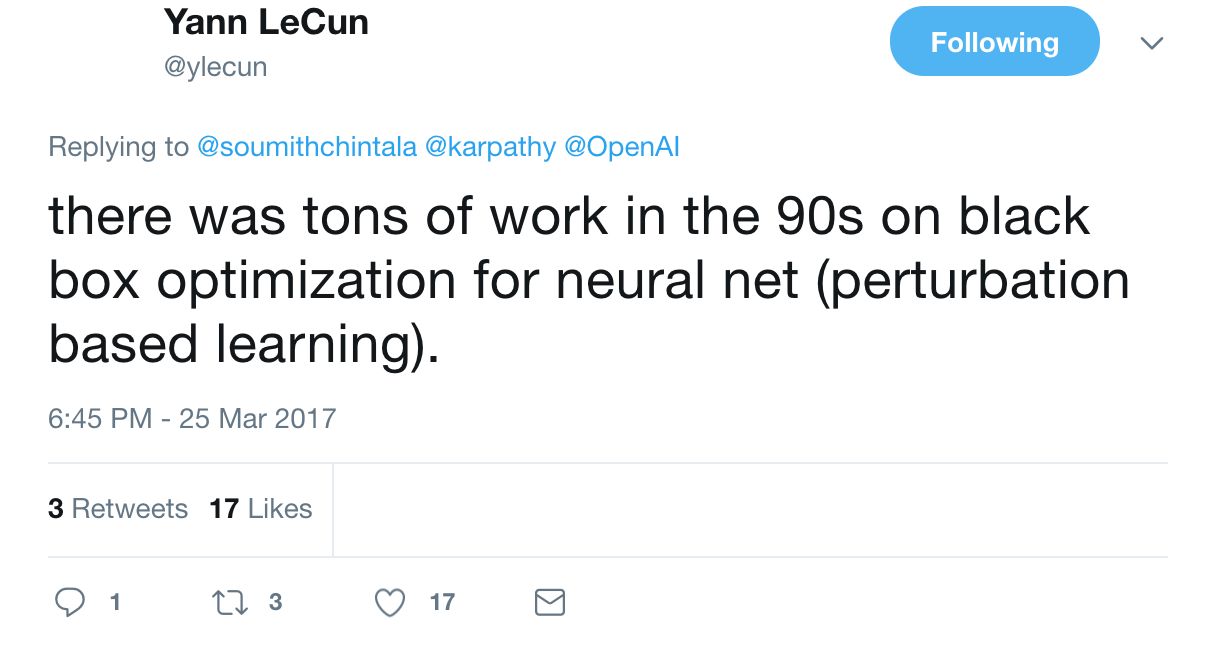

LeCun转发了这篇由“Gans之父”Ian Goodfellow领衔撰写的论文,并连发三条tweets回(tu)复(cao):对于了解深度学习和“黑箱优化“的人来说,你们的论文毫无意义,人家在90年代就做过了!

“很多人都觉得他们需要研究强化学习,但他们在研究中所做的却不过是黑箱优化或结构化预测罢了。”

“……基于梯度的优化远比黑箱优化要好用……”

“黑箱优化只能做你最后的手段,只有当基于梯度的优化完全没有效果时才可以考虑它。”

“关于神经网络黑箱优化的研究,人们在90年代就已经做过很多了。”

LeCun vs Goldberg

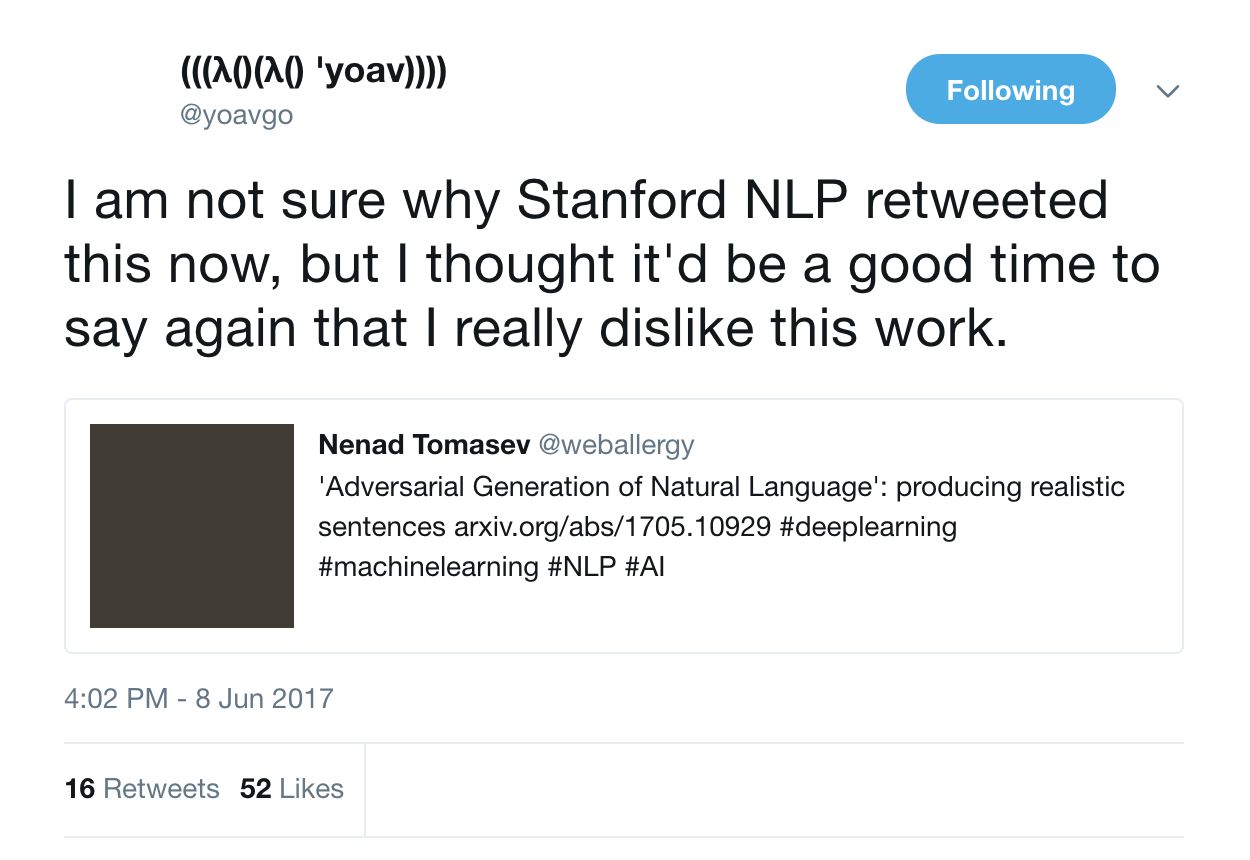

去年六月,Arxiv上一篇题为“自然语言对抗生成”(Adversarial Generation of Natural Language)的热文燃起了两位大神LeCun和Yoav Goldberg的大战。

Goldberg接连在Twitter和medium上言辞激烈地撰文称自己极其不喜欢这篇文章,并且以这篇文章为例,批判了Arxiv对稿件不加审核的制度,以及深度学习领域生成文本实验不靠谱的普遍现象。

“拜托你们这帮搞深度学习的人,别再抓着语言不放并声称自己已经解决语言的问题了。”

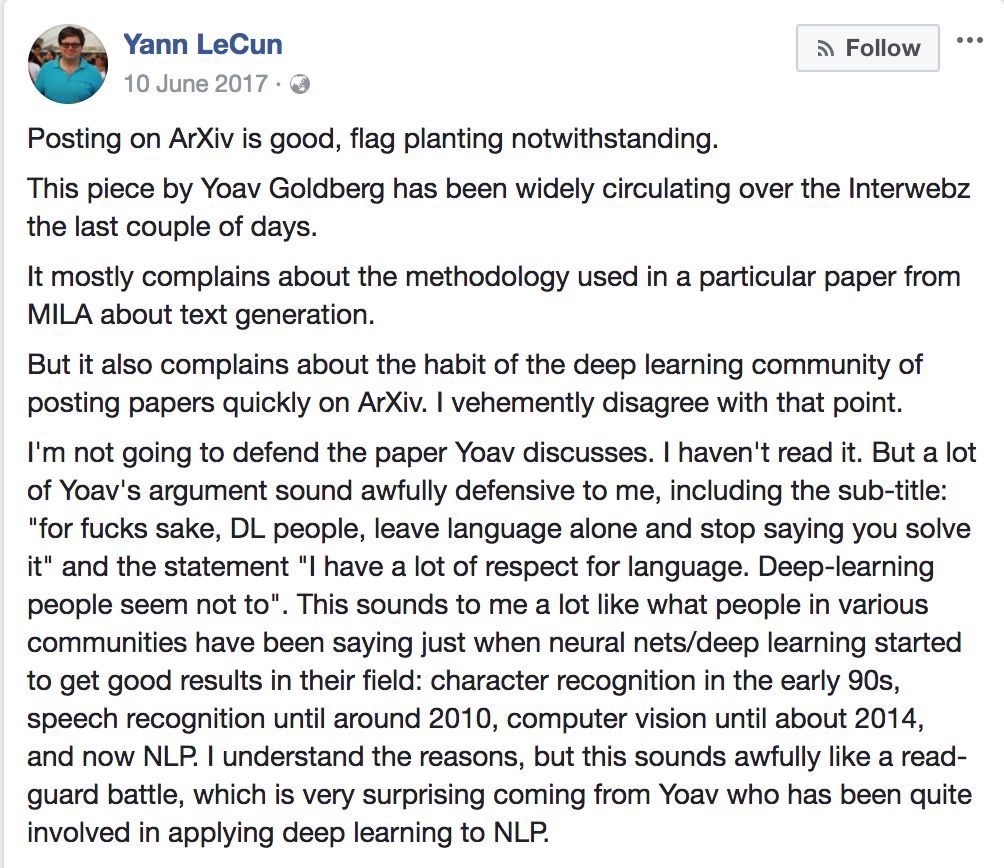

LeCun或许认为Goldberg的言论是“固步自封”,过于捍卫所谓的“自然语言研究社区”,于是立即在Facebook发文:很难想象,这些话居然是Goldberg说的,他也是会将深度学习运用到自然语言研究中的人!

随后,Goldberg在Medium再度撰文回应LeCun对他的质疑:

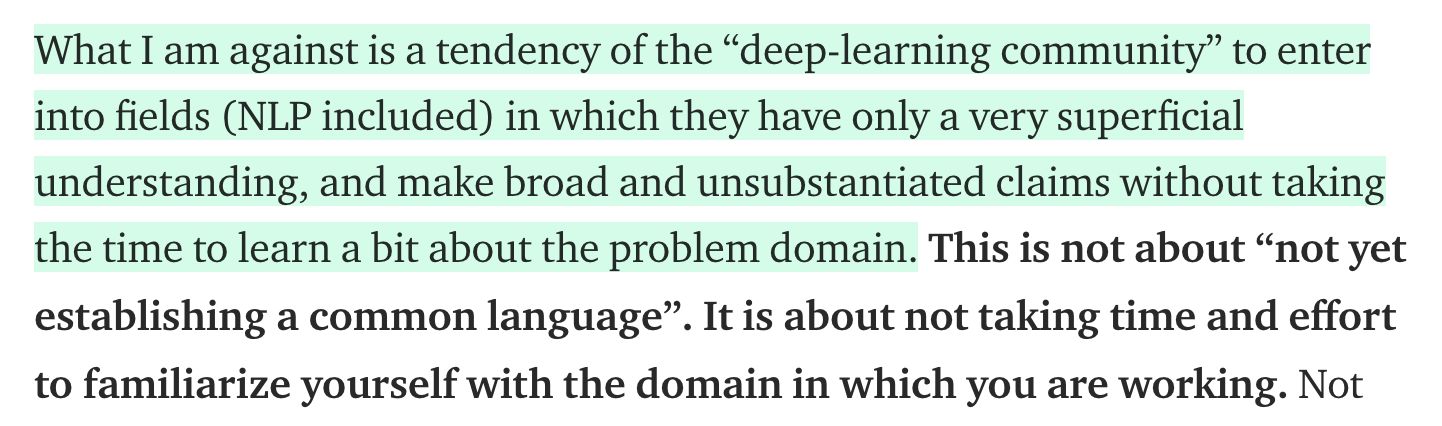

Goldberg觉得自己被冤了。他反对的是一些“深度学习社群”的人,在对某个领域的理解非常肤浅的情况下,就盲目进入该领域,并且发表一些不知所云的研究论文。他还说,他并不反对Arvix这个平台,但是像“自然语言对抗生成”这些草率的文章发表出去,是对相关领域巨大的伤害。

紧接着,Twitter上也有一些争论,不过并没有太大的水花,营长也就不细说了。

LeCun vs Marcus

Round 1

去年10月,LeCun和纽约大学的心理学家,创业公司Geometric Intelligence的创始人Gary Marcus在纽约大学展开了一场辩论,论题是:人工智能是否真的需要有类似人类的认知能力,才能达到人类普遍的智力水平?

LeCun说:“我们目前所拥有的AI技术,无论通过结构还是通过学习,都无法构建世界的表象,而这是我们观察到的动物和人类所拥有的能力。”

Marcus认为,人类先天就拥有对于认知对象、行为和现象而构建的表达方式。人工智能的研究者可以借鉴这些认知科学的知识,引入一些来辅助AI处理信息。LeCun不反对Marcus的想法,但他并不觉得人类大脑中存在“单一学习算法、原则或是程序”。

两人的辩论最终涉及到的是有关无监督学习是否需要认知表征的结构的问题。如果不需要,LeCun就将胜出。

这一场公开场合的辩论并没有网络上的激烈,但是LeCun和Marcus都对无监督学习提出了展望。LeCun希望无监督学习能达到人类认知事物的“感觉”。

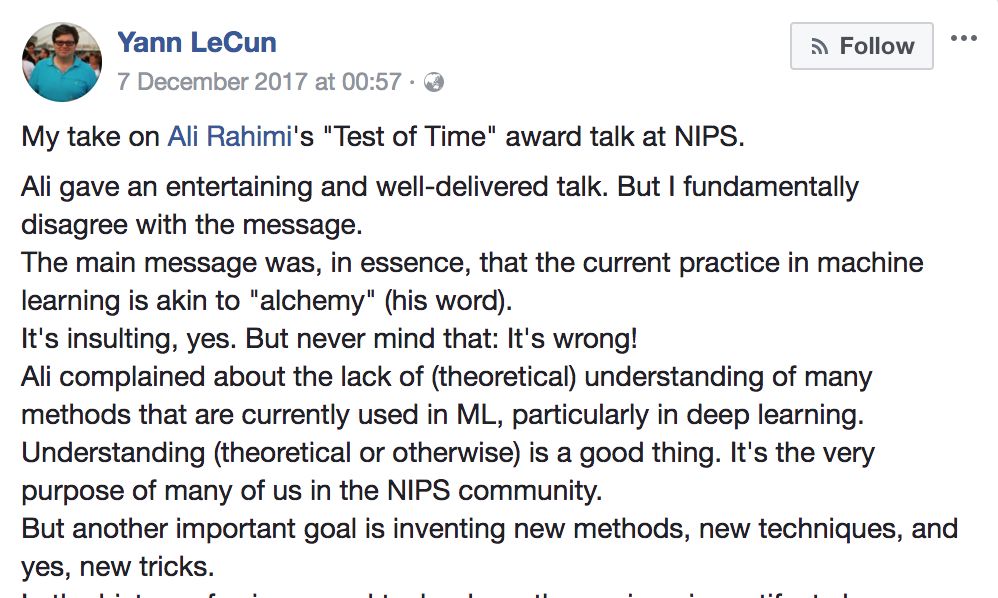

LeCun vs Ali

去年NIPS上最大的新闻莫过于LeCun和最具时间价值大奖论文的作者Ali Rahimi掐了。起因是,Ali在演讲中说机器学习是“炼金术”。

在Ali看来,当代机器学习的发展,主要是基于经验。这一点很像“炼金术”,也表明了同样的问题,那就是

比起其他大牛对“炼金术”保持赞同或是沉默的态度,LeCun的脾气上来了,在Facebook上实名回怼:

营长看来,LeCun对此发如此大的“火”,也是有其原因的。LeCun认为此情此景像极了上世纪80年代大家对神经网络有效性的质疑。而作为LeCun作为“卷积神经网络之父”,并且经历过神经网络的“寒冬”,当然不想重蹈覆辙。

六个小时后,Ali说,非常感谢LeCun富有建设性的回应。Ali 谈到自己对教学的要求就是

LeCun随后肯定了简单和通用的定理存在的价值。但同时也说到,在神经网络领域,定理可能会更复杂。

对于LeCun是不是反应过激了,营长不好说。但是,在营长看来,这场争论非常有价值。就如杜克大学的Yiran Chen博士所说的,这两人的对话涉及了目前深度学习领域的一大问题,那就是很多模型无法用理论来解释。LeCun坚持自己一贯的观点,理论解释的缺乏并不会影响深度学习模型去解决问题。而Ali保持人工智能领域的“警察”形象,认为理论方面必须加强。

这件事情还有一个后续。为了讨论可解释性在机器学习中的必要性,NIPS2017 举办了历史上第一个辩论。LeCun作为反方一辩,直接了当地说,我们每天都在使用各种社交网站和搜索引擎,可我们也没有去探寻它们背后的可解释性呀!

这论据,营长是大写的服啊!

LeCun vs Marcus

Round 2

同为纽约大学教授的LeCun和Gary Marcus前两天再次“杠”上了。

Marcus在推特上提出了对目前深度学习的十大疑问,包括:

深度学习依然需要非常多的数据

深度学习还很肤浅,并没有足够的迁移能力

深度学习还不能以自然方式来处理层级结构

迄今为止深度学习还无法进行开放式推理

深度学习还不够透明

深度学习还未与先验知识结合

深度学习还不能区分因果和相关关系

深度学习假定世界大体稳定,但实际上并不是这样

深度学习只是一种近似,答案并不完全可信

深度学习很难在工程中使用

第二天,LeCun并没有再次挑起“推特大战”,但是转发了前美国人工智能协会主席Thomas G. Dietterich逐一反驳Marcus的十条微博,以表示自己的态度。Dietterich表示,对于Marcus抨击当前深度学习”过于肤浅“的论调,他深感失望。

对于这十条微博,,营长前两天做过报道。可点击以下链接查看:

《Yann LeCun力挺前AAAI主席,批判深度学习的Marcus遭怒怼》

营长正纳闷,为啥一向敢怒敢言的LeCun,对于Marcus如此的“敌意”,不亲自上阵呢。果然,今天又看到LeCun在Facebook撰文,他略带嘲讽地说,“深度学习”这个词已经过时了,所以我们换一个词:可微分编程!

对于“可微机编程”这个词,LeCun并没有深入说太多,他说日后会继续谈这个话题。。。

这是不是意味着,深度学习要进入新纪元了?

LeCun vs Deep Learning

是的,你没看错。虽然贵为深度学习“三驾马车”,但是,和严谨的Hinton一样,LeCun也热衷于给深度学习“泼冷水”。LeCun会一针见血地指出目前深度学习领域的一些问题,诸如Hinton在1985年创立了一种波尔滋曼算法,但是实践却很难找到如此完美的机器;目前反向传播的效率也是个大问题;生成对抗网络(GANs)在不确定的情况下,无法做出预测等。

结语

看了这么多,你可能认为LeCun对于针对他或者深度学习的负面评价过于在意了。但是,营长认为,LeCun 真是依靠着这份较真,也就是所谓的“一根筋”的性格,才扛过了持续多年的神经网络“寒冬期”。神经网络之于LeCun,是一种超越知识的信仰,所以他要捍卫神经网络或是深度学习的荣耀。

和学术界的别的大牛一样,LeCun乐于参与争论,但是每一次争论都是“对事不对人”。可别忘了,虽然LeCun嘲笑了Ian Goodfellow领衔的论文,但是在Ian Goodfellow刚提出GAN的时候,LeCun非常激动地称之为“十年来机器学习领域最激动人心的点子”!

当马斯克等人发表了人工智能“末日论”的说法时,LeCun站出来说,目前以及接下去很长一段时间,人工智能都不可能威胁到人类,所以,禁止用“终结者”来称呼人工智能!

其实,许多的论战都以LeCun占据上风而告终。营长特别希望有一天,被LeCun怼过的他们,能组成“复仇者联盟”,用最新的研究成果“回怼”LeCun。这样,深度学习领域就能出现各个流派,百家争鸣的盛况。

热文精选

不用数学也能讲清贝叶斯理论的马尔可夫链蒙特卡洛方法?这篇文章做到了

盘点深度学习一年来在文本、语音和视觉等方向的进展,看强化学习如何无往而不利

干货 | AI 工程师必读,从实践的角度解析一名合格的AI工程师是怎样炼成的

AI校招程序员最高薪酬曝光!腾讯80万年薪领跑,还送北京户口