搜索CIFAR10只需1个半小时:华为诺亚&上交大ICLR 2020提出更快、更稳定、性能更好的可微分架构搜索

机器之心编辑部

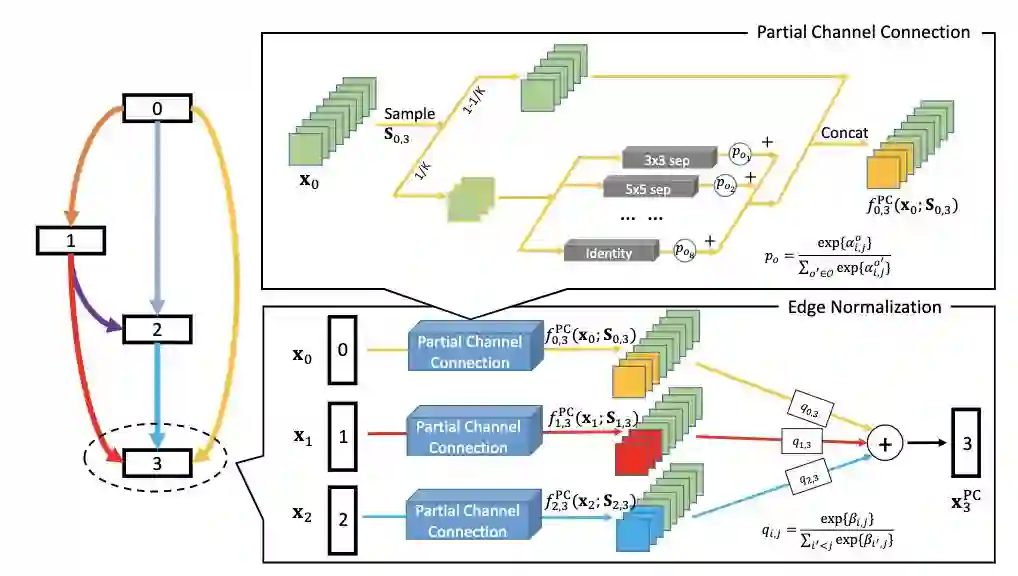

人工智能顶会 ICLR 2020 将于明年 4 月 26 日于埃塞俄比亚首都亚的斯亚贝巴举行,不久之前,大会官方公布论文接收结果:在最终提交的 2594 篇论文中,有 687 篇被接收,接收率为 26.5%。华为诺亚方舟及其合作实验室有多篇论文被 ICLR 2020 接收,本文介绍了其中一篇 Spotlight 文章。

登录查看更多

相关内容

Arxiv

4+阅读 · 2018年3月30日