更进一步!谷歌的 AI 自己就能玩多人游戏了

长按识别二维码,报名2018十大突破技术全球直播首发,原定大年初一的直播解读改期为2月21日16:00(大年初六)。

近日,据谷歌 DeepMind 团队透露,他们已经找到能够迅速训练深度学习网络的新方法——那就是将先进的算法和老派视频游戏给整合起来。

DeepMind 是 AlphaGo 的研发团队,他们相信机器能像人类一样学习。他们在ID Software公司的《雷神之锤》(Quake III)和运行57款雅达利游戏(Atari games)的街机模式学习环境(arcade learning environment,ALE)上搭建了DMLab-30训练套装,研发了一款科幻级别的训练系统,称之为Importance Weighted Actor-Learner Architectures(IMPALA)。

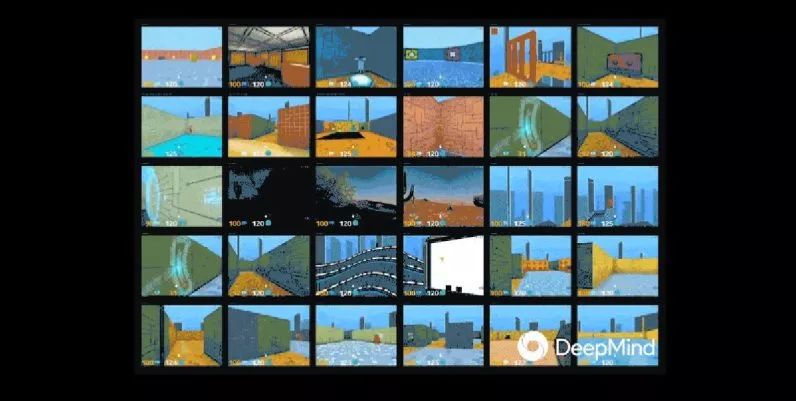

通过 IMPALA,AI 系统快速播放一系列电子游戏,并从一组“玩家”中提取训练信息并传递给一组“学习者”。

一般说来,深度学习网络的工作模式类似于在游戏引擎间穿梭的独立玩家的玩法。开发者会告诉电脑,控制器输入了哪些内容,而电脑则会像拿着手柄的人类一样玩游戏。

通过 IMPALA,系统不仅能比其他算法提高 10 倍效率,还能同时玩多个游戏。就像多名玩家(30名或以上)共用一个“博格”(borg)大脑,一起摸索《雷神之锤》的玩法,共享所有经验。

这是人类在DMLab-30测试环境中的表现:

这是机器使用IMPALA时的表现情况:

人工智能开发人员面临的最大挑战之一就是训练神经网络所需的时间和处理能力。传统编程要人匆匆敲出一连串代码,最终才变成程序。可是自主化机器(autonomous machines)不同,自主化机器需要规则,通过不断的尝试,最终发现处理现实世界的问题的方法。

由于我们并不能放任机器人执行任务时不受约束,模拟也便成为了其发展的首个重点。因此,深度强化学习(deep reinforcement learning)对上下文自主性(contextual autonomy)的任务至关重要。

比方说,无人驾驶汽车平时加速或减速可以自行判断,进行选择,却不能够拥有是否要开进某家便利店的选项。它要知道什么样的决策是它可以做的,什么不可以,以及在模拟环境中又应如何进行决策。

IMPALA 解决的另一个问题是可扩展性。调整算法和优化(tune things)以缩短训练时间是一回事,但是要在一天结束时成功训练人工智能又是另一回事,毕竟它靠的可不是时间记录。

要想让目前的神经网络达到足够高的成功率,从而对任何可能存在潜在危害或损害人类库存的自主化机器进行编译系统上的调整,他们需要处理训练环境里的数十亿帧(图片)。

根据研究者的说法,“只要有足够基于CPU的角色模型(actors),IMPALA就能达到 250000 帧/秒或 210 亿帧/天。”这让 DeepMind 团队的AI在执行这类任务时,可以达到我们所了解的最快速度。

而更令人震惊的可能是IMPALA 白皮书的说法,它表示:AI 的性能要比以往的 AI 系统和人类更胜一筹。

-End-

编辑:梁嘉祺

来源:

https://thenextweb.com/artificial-intelligence/2018/02/08/deepmind-taught-ai-how-to-multitask-using-video-games/