![]()

本文为约2673字,建议阅读5分钟

本文介绍

了蚂蚁集团联合信通院、清华大学发布了行业首个面向工业场景全数据类型的AI安全检测平台“蚁鉴”.

随着人工智能应用的大规模普及,AI安全变得越发重要,推广可信AI已经逐渐成为产学界的共识。

9月1日下午,在2022 世界人工智能大会的“可信AI论坛”上,

蚂蚁集团联合信通院、清华大学发布了行业首个面向工业场景全数据类型的AI安全检测平台“蚁鉴”

,并发表演讲,首次体系化梳理了蚂蚁可信AI的工业化应用落地过程。

在该论坛上,蚂蚁集团大安全机器智能部总监、蚂蚁技术委员会可信AI联合工作组组长王维强发表了题为《可信人工智能创新、共建、共生》的演讲。

他认为,在定义了可信AI的技术框架之后,当下最重要的任务是,

将可信AI推进到工业化应用时代

。只有在落地场景中成体系地去思考它、建设它,才能形成标准、开放的可信AI技术,助力整个生态的应用。而在落地工业化应用的过程中,

建设全链路的可信、业务和技术双线并进、打造开放平台,以及结合企业价值观与长期战略,是其中的关键。

其实可信AI并非新事物,只是以前AI不像现在这么热和成熟,随着AI应用普及,自动驾驶、医疗、物流等各种场景的应用出现,它变得越来越重要,而数据泄露、黑产攻击、数字弃民等问题也逐渐增加。到这个阶段,要让AI发挥更多作用,可信AI的普及和产业化就必须提上日程。

同时,国内和国际上陆续实施的《个人隐私保护法》、《数据安全法》、GDPR等法律法规,也让可信AI从选择题变成必答题。

2021年,同样是在世界人工智能大会上,信通院,以及蚂蚁、京东等企业和单位,对可信AI有了明确的体系化定义。蚂蚁集团在去年的WAIC上首次公布了技术架构体系,京东也发布了《可信人工智能白皮书》。

目前我们对可信AI在定义层面形成了共识,也就是可信AI的主要框架有四个,分别是

鲁棒性、可解释性、隐私保护和公平性

。这四个框架,是结合了业务的需求和合规的要求,再加上企业的责任感而得出的。

去年我们梳理了可信AI的架构体系,今年我们认为应该进一步推进,做可信AI工业化应用落地过程的体系化梳理。这样成体系地去思考它、建设它,才能把它做成标准的、开放的技术,从而助力整个生态对可信AI的应用,而不是让大家都重复摸索。

我认为,目前行业里比较领先的公司有责任做这个事情,而且生态搭建起来也会反哺技术本身的健康发展。从各个角度来看,把可信AI推进到工业化应用时代,都很有必要。

接下来我以蚂蚁为例子,讲一讲可信AI在落地工业级应用时的一些经验和思考。

可信AI是蚂蚁的天生属性,因为它和我们的业务,以及蚂蚁从创立以来强调普惠科技的价值观紧密相关。我们在2015年开始探索可信AI,主要应用于蚂蚁安全业务。在7年的研发与实践中,蚂蚁风控引擎里的支撑性AI技术不断发展,最终形成了现在的“IMAGE智能风控系统”。

从趋势来看,蚂蚁风控引擎里的AI技术从原来简单的模型变得愈发复杂,这带来的好处是效率越来越高,问题就是可解释性或者鲁棒性等方面的挑战变大了。在这种情况下,我们更要解决AI可靠可信的新要求。

下面我会从四个技术框架出发,介绍蚂蚁可信AI的

技术思路

。

首先是

鲁棒性

。从安全角度来讲,我们把鲁棒性分成几个不同的层面,像数据噪音、数据漂移和被黑产攻击的鲁棒,我们都要去注意,而且要求很高。

以数据的漂移举例。数据漂移带来的抖动,如果是在海量数据中看长尾部分,可能带来的影响相对有限。但在安全场景下,我们关注的是AI模型识别出的头部少量黑产数据,一个抖动影响到的用户相对来说就非常大。所以在安全业务的大规模工业级应用里边,我们对AI鲁棒性的要求非常高。在其他场景下,当上线的AI模型追求极致性能的时候,也会产生类似的鲁棒性要求。

业务场景的复杂,让我们要解决的鲁棒性问题也比较多,之前是散落在各场景中的。我们去年体系化梳理了在大规模多业务模式的工业级应用中可能面临的鲁棒性问题,将这些问题分类分级,尝试推出我们觉得适合的

鲁棒性检测评分体系

,并将我们多年对抗经验和防御算法进行了沉淀。在蚂蚁多个场景落地推广应用,覆盖金融、政务、电商等业务线。

再说

可解释性

。随着AI模型本身越来越复杂,从原来的简单模型变成了复杂的深度学习模型,对模型的可解释要求就会非常高。可解释性做得不好,会影响最终的应用效果,比如一些公司在登录风控场景用了模型效果更好的深度学习模型,如果没有很好的可解释性,那么可能会直接影响到用户的体验,反而影响到公司的业务。

在蚂蚁的场景中,我们不仅仅面临越来越复杂的AI算法技术对可解释的挑战,在过程中也发现,如果让模型将业务经验和知识更好地通过图谱表征等方式吸收,会让模型效果更好更鲁棒。最终我们希望能够在技术上将知识和模型融合做到极致,达到流畅的人机交互效果。

鲁棒性和可解释性,是工业级应用本身的

强要求

。但隐私保护和公平,则更多是一家企业的责任和义务。

一方面,我们要努力去做到

合规

。《数据安全法》、《个人信息保护法》的出现,提出了新的数据合规要求。另一方面,企业本身的伦理标准也要求保护用户的隐私和权益。比如,我们在做风控、营销等等交互的时候,要考虑到相对弱势群体的使用诉求,也要避免大家被大数据杀熟这类事件所困扰。

所以,在公平性方面,在充分考虑合规要求的同时,我们尝试从场景出发,去梳理业务里可能面临的“不公平”问题,并通过一系列的指标来量化,然后用技术手段来“归因”分析其中导致算法可能不公平的原因,最后技术上进一步对算法优化,提升AI算法的公平性。

比如,我们在搜索、营销、安全、信贷场景,针对性提出相应的公平性度量指标,通过360大盘监控来及时发现其中可能的问题,通过代理模型任务等技术将其中的原因找出来,最终通过delta Tuning和prompt等技术将原有的AI算法优化。

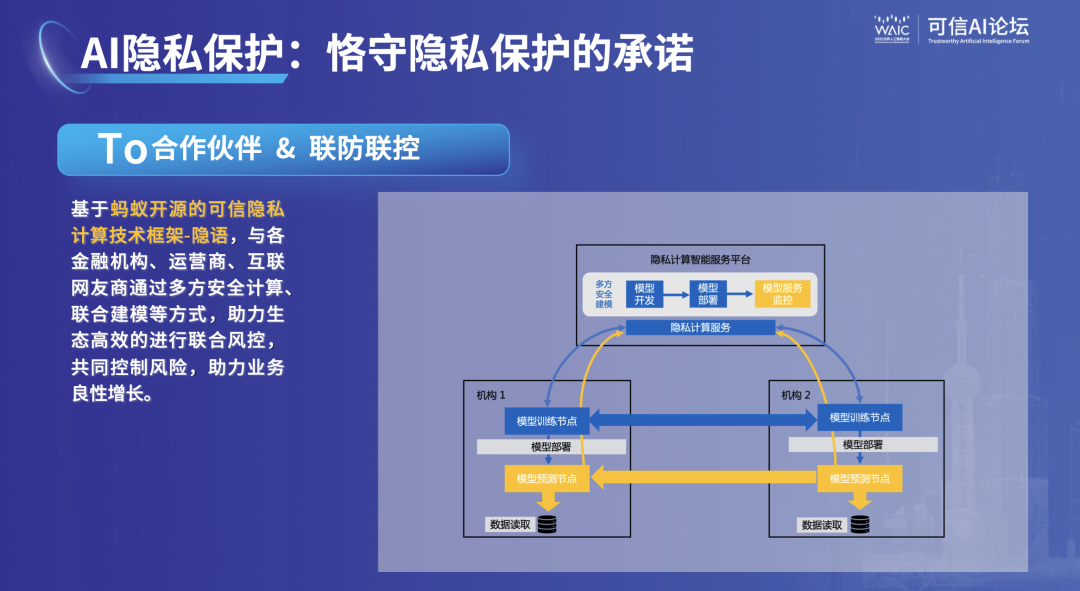

在隐私保护方面,我们升级了能够提高用户隐私保护的端边云体系,与手机厂商合作推出了赋能生态伙伴的AntDTX隐私沙盒,基于蚂蚁自研的隐私计算技术框架“隐语”与多机构做风险联防联控,通过不断创新,去践行互联网平台对用户隐私保护的责任担当。

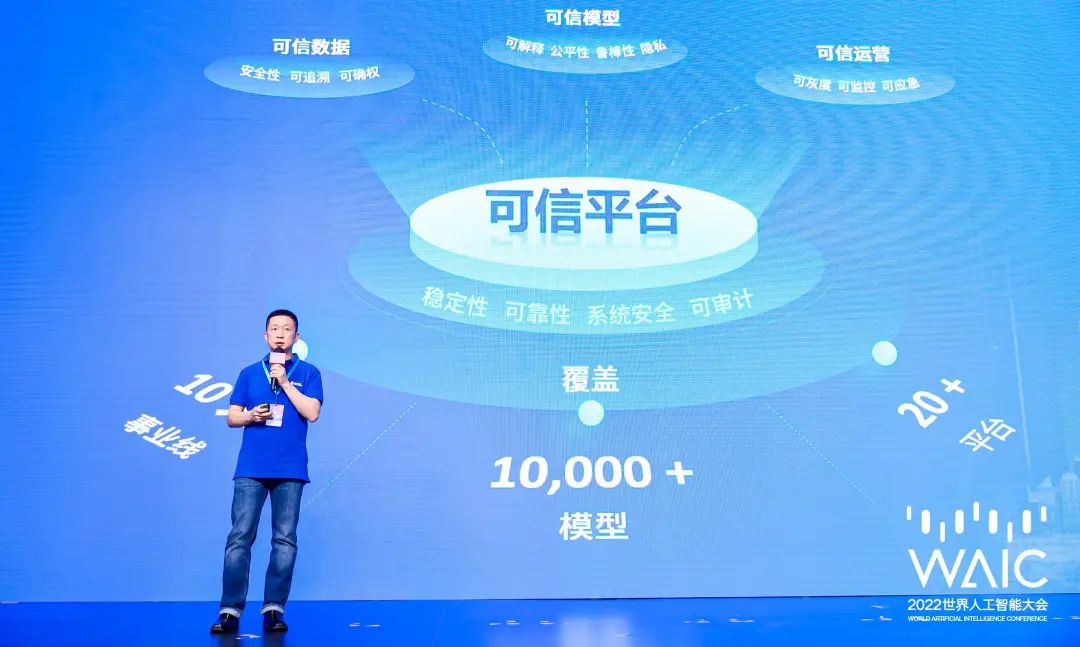

首先第一点,工业级应用里的可信AI要做到全链路&全生命周期的可信。所谓全链路&全生命周期,就是说真正的实践要有数据的可信、模型的可信、运营的可信和平台的可信,这些东西都有,才能真的实现可信AI。

那有没有

主次

呢?最近也有一些关于全链路不同环节的重要性讨论。确实,因为数据走在模型之前,没有数据就没有模型,从这个角度来讲,数据权重可以比模型更高一点;但对我来讲,是缺一不可的,数据再可信,模型做错了,也有问题,模型做完美了,运营发布出错,也是一样。

第二点是,工业界在落地应用可信AI时,跟学界的理论探索会有一些出入,最终还是需要

结合实际情况

。比如说一开始我们做鲁棒性里的博弈时,主要技术聚焦在GAN算法上,那时候GAN这个方法还比较前沿,大家都觉得它可以生成一些样本去提升攻防的一些鲁棒的算法。但实际落地的时候发现,对抗学习的算法实操性更强,上线之后效果更好。学术界讨论的时候,可能有非常多的假设,这些假设跟工业界实际上遇到的情况不一样。所以,工业界的现实有可能变成一种约束,也有可能变成一种机会。

第三点是,回过头来看,蚂蚁落地可信AI的过程,业务安全和技术探索两条线是同时进行的,这保障了可信AI在蚂蚁集团既可以落地,也能成技术体系,并且可以应用于蚂蚁风险安全之外的其他场景。

具体来讲,从业务需求看,把技术落地需要有指标去衡量和分析它,然后做出改进。对于这四个纬度都是一样,第一点就是先

从业务场景出发

,寻找一组或者一套比较适合业务的衡量标准指标,然后用这把尺子去衡量一个算法模型的几个可信维度,判断现状和理想状态有多大区别,再去找原因是什么,之后解决问题。

最后通过这一套机制的运营,保障上线应用的AI模型是可信、可靠、可控的。

同时技术也要有自己的思考和布局,和业务是相辅相成的。比如在隐私保护的需求变得特别强之前,蚂蚁很早就做了预判,开始去对隐私保护技术布局。经过这么多年的积累,打造了“隐语”平台,到今年对外发布,开放给生态。如果单纯跟随业务需求,是来不及实现的。

另一方面,类似公平性或者可解释性,监管、用户和企业三方之间对需求各有自己的想法,在实际应用场景里去提高某一指标的时候,到底该做到什么程度,我们的观点是,要尽量去满足最高的要求,把技术里边的东西抽出来,到不同的场景去用。因为业务在不停地变,但业务里用的技术有自身的发展过程,所以技术不用等着需求来时再去做,比如说我们想要用神经网络,神经网络的可解释性和鲁棒性就一定要提上日程。不是有一个明确的需求,我们才去做。

我们认为,落地过程中很重要的一点是,要坚持做正确的事。业务的需求可能是初始点,为了解决某项具体问题,需要不断进行技术创新和研发,精益求精、做到极致用户体验,因此对技术持续的投入,和企业的价值观,才是根本。

最后一点是,无论是解决业务问题的鲁棒性和可解释性,还是从合规以及企业责任感出发的隐私保护和公平性,这四个框架之间相辅相成,落地一个能在工业级应用场景中使用的可信AI体系,这几个要素必不可少.

整个生态里对于可信AI的一些标准,还没有完全达到共识,因为可信的概念是这两年才开始起来,很多工作才刚刚开始。蚂蚁也在积极提出和参与一些标准。

很多人对于可信A的理解还不太一样,这个我觉得并不影响,有点像刚才讲技术落地的过程,因为不同场景的需求不一样,要优化的参数也不同,这是可以理解的。

但从生态角度来讲,在大的标准层面先能够有一些共识,这样更有利于做一些开放的平台、开放的技术,才能够去比较好的拉通和复用,反哺应用。

另外,公平性的提升需要企业具备一定的

道德责任感,也需要法律的约束,以及生态圈一起建立标准来共同推动

。

开放平台对于生态建设也至关重要。比如今天蚂蚁发布的AI安全检测平台“蚁鉴”,它面向所有AI模型开发者,提供从模型对抗测试到防御加固的一站式测评解决方案,覆盖文本、图像、表格、序列等不同数据类型,相当于是蚂蚁把自身认为在工业界比较有用的鲁棒性技术,比如怎么做和怎么分级、怎么去检测和优化,做成一个技术开放给生态,让大家作为参考,也可以直接用。我们后续也会把隐私、公平、可解释放进平台里,在大家使用的过程当中,可以逐渐去对齐一些标准。

除了“蚁鉴”,隐私方面也有其他开放平台,比如“隐语”,比如腾讯的“fate”,微软也在开发,大家都在逐渐开放。通过这些技术,大家一起判断哪些技术是真的非常好用,对于彼此都会有互相借鉴的地方,最后形成共识。

除了监管的指导以及工业界的摸索,学术界的力量同样十分重要。过去一年里,我们跟多所C9和985高校合作,开发了国内的多个面向高校同学的可信AI理论与实践的课程。蚂蚁集团的技术专家作为业界教师,去为学生们讲授可信AI在工业界一线实践的课程,我认为这是非常有意义的打通产学研的尝试。一方面是将理论与实践更好的结合了起来,通过教学把可信AI技术和理念输出给社会各行各业做好准备。另一方面,加深了产学研的探索,极大的助力了技术创新的布局。

最后我想说,如今AI应用在生活的方方面面,可信AI是数字化经济中抵御风险的核心能力,可信AI生态的建设是当下产业界亟需共识、共建、共同面对的问题。比如蚂蚁今年可持续发展报告中,正式启动科技创新、绿色低碳、数字普惠、开放生态,四位一体的ESG可持续发展战略。可信AI生态的建设就是蚂蚁践行开放生态的重要举措之一。这也是作为行业领先的企业,能够借助平台的力量,去对可信AI的生态做的贡献。