NeurIPS 2022 | 中山大学HCP实验室:有效表示多样化衣物的3D神经表示模型

©作者 | 机器之心编辑部

来源 | 机器之心

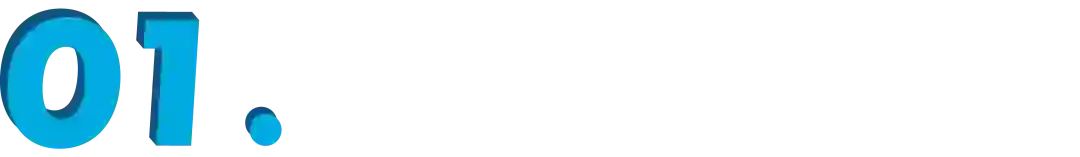

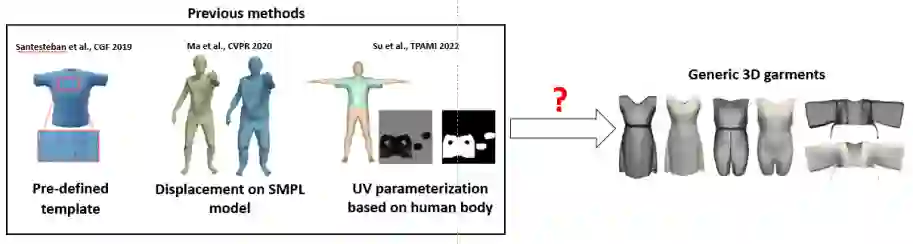

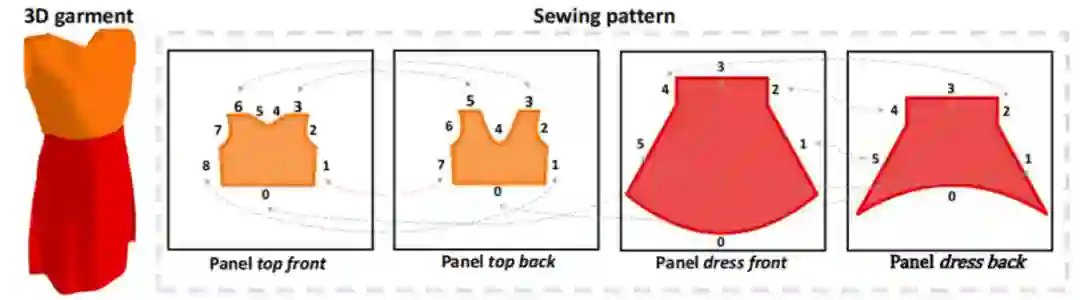

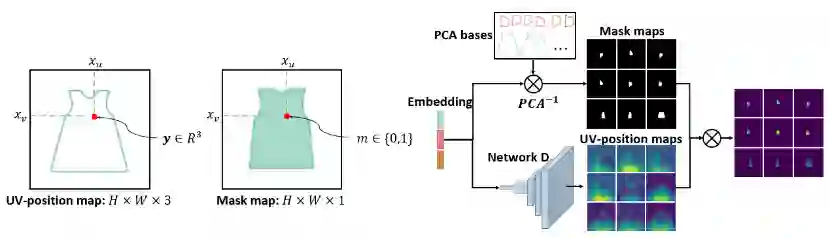

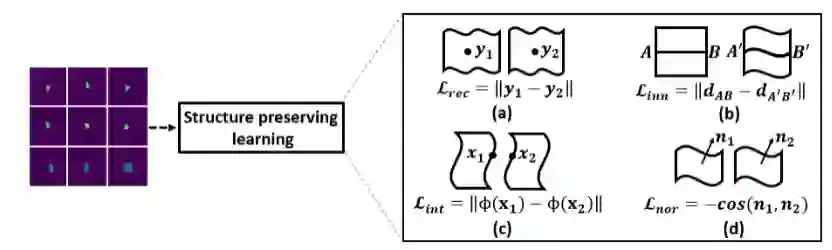

中山大学 HCP 实验室联合牛津大学 TVG 实验室共同发表论文《Structure-Preserving 3D Modeling with Neural Sewing Machines》,该论文已被 NeurIPS 2022 接收。该工作主要由陈曦鹏、王广润博士等人完成。

论文链接:

收录会议:

-

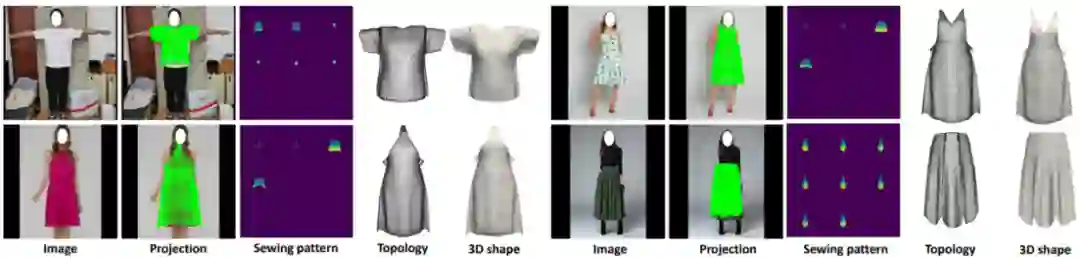

首先,可以表达各种不同类别和形状的衣物 -

其次,描述了 3D 衣物的内在结构 -

最后,提供了衣物的 UV 参数化

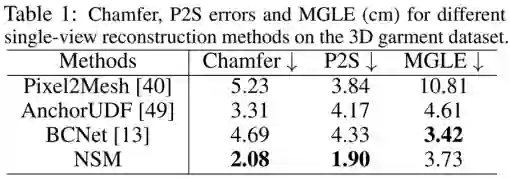

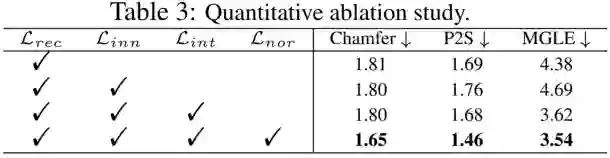

实验

中山大学人机物智能融合实验室 (HCP Lab) 由林倞教授于 2010 年创办,围绕人工智能前沿技术布局研究课题,获得中国图像图形学会科技一等奖、吴文俊自然科学奖、省级自然科学一等奖等荣誉;培养了梁小丹、王可泽等国家级青年人才。

更多阅读

#投 稿 通 道#

让你的文字被更多人看到

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学术热点剖析、科研心得或竞赛经验讲解等。我们的目的只有一个,让知识真正流动起来。

📝 稿件基本要求:

• 文章确系个人原创作品,未曾在公开渠道发表,如为其他平台已发表或待发表的文章,请明确标注

• 稿件建议以 markdown 格式撰写,文中配图以附件形式发送,要求图片清晰,无版权问题

• PaperWeekly 尊重原作者署名权,并将为每篇被采纳的原创首发稿件,提供业内具有竞争力稿酬,具体依据文章阅读量和文章质量阶梯制结算

📬 投稿通道:

• 投稿邮箱:hr@paperweekly.site

• 来稿请备注即时联系方式(微信),以便我们在稿件选用的第一时间联系作者

• 您也可以直接添加小编微信(pwbot02)快速投稿,备注:姓名-投稿

△长按添加PaperWeekly小编

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」