【重温经典】吴恩达机器学习课程学习笔记八:Logistic回归续

【导读】前一段时间,专知内容组推出了春节充电系列:李宏毅2017机器学习课程学习笔记,反响热烈,由此可见,大家对人工智能、机器学习的系列课程非常感兴趣,近期,专知内容组推出吴恩达老师的机器学习课程笔记系列,重温机器学习经典课程,希望大家会喜欢。

【重温经典】吴恩达机器学习课程学习笔记二:无监督学习(unsupervised learning)

【重温经典】吴恩达机器学习课程学习笔记三:监督学习模型以及代价函数的介绍

【重温经典】吴恩达机器学习课程学习笔记六:特征处理与多项式拟合

【重温经典】吴恩达机器学习课程学习笔记七:Logistic回归

吴恩达机器学习课程系列视频链接:

http://study.163.com/course/courseMain.htm?courseId=1004570029

吴恩达课程学习笔记八:Logistic回归续

1、代价函数形式的简化

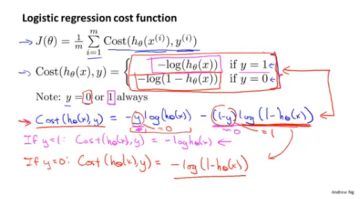

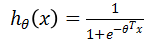

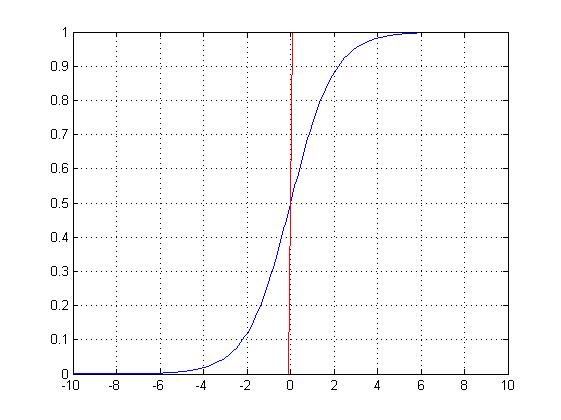

对于上一篇总结中所提的代价函数,它是一个分段函数的形式,现在将它改用一个函数表达(如下图蓝色书写的部分)。至于验证非常简单,将y=1与y=0分别带入求解,验证是否与分段函数表述的一致。

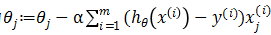

2、梯度下降

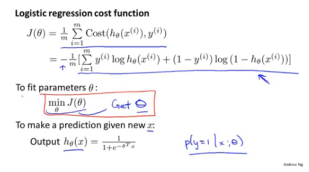

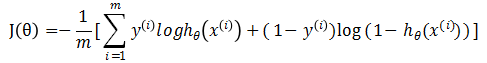

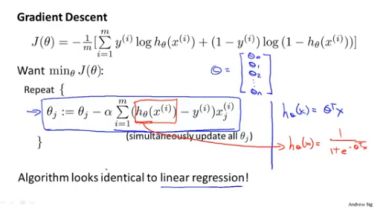

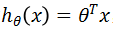

如下图所示,根据上述总结,得到了logistic回归的代价函数,现在的目的是如何求解当J(θ)取得函数值最小时对应的θ值

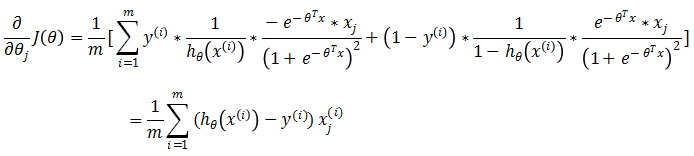

如下图所示,这里对θ的更新过程给出详细的推导:

则可知

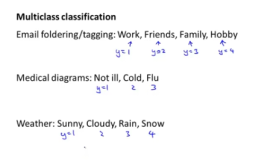

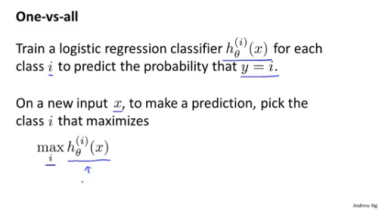

3、多类别分类:一对多

假设我们有如下所示的分类问题:

1、 将邮件分类为工作的、朋友的、家庭的、兴趣的

2、 病症分类为没有生病、感冒、流感

3、 天气情况分类为晴天、多云、下雨天、下雪天

我们可以看到上述问题都是多类问题,已经不再是简单的二分类问题。

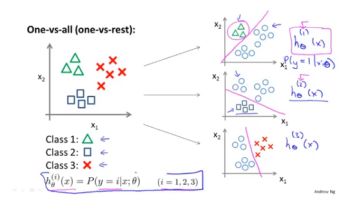

在前面的总结中,已经介绍了logistic回归算法去处理二分类问题,其实多分类问题可以看做是几个二分类问题。假设我们有如下图的数据集,即有三种类别,那么我们可以通过构造三个假设函数

在进行预测时,将输入x带入到三个假设函数中,计算出的表示数据属于三个类的概率。选出最大的h值所对应的类别,即为数据x最有可能归属的类别。

参考链接:

http://study.163.com/course/courseMain.htm?courseId=1004570029

请关注专知公众号(扫一扫最下面专知二维码,或者点击上方蓝色专知),

后台回复“NGML2018” 就可以获取 吴恩达机器学习课程下载链接~

-END-

专 · 知

人工智能领域主题知识资料查看获取:【专知荟萃】人工智能领域26个主题知识资料全集(入门/进阶/论文/综述/视频/专家等)

请PC登录www.zhuanzhi.ai或者点击阅读原文,注册登录专知,获取更多AI知识资料!

请扫一扫如下二维码关注我们的公众号,获取人工智能的专业知识!

请加专知小助手微信(Rancho_Fang),加入专知主题人工智能群交流!加入专知主题群(请备注主题类型:AI、NLP、CV、 KG等)交流~

投稿&广告&商务合作:fangquanyi@gmail.com

点击“阅读原文”,使用专知