Intel 10nm十代酷睿改造转战M.2:神经网络推理

Intel 10nm Ice Lake十代酷睿处理器已经上市,但它可不仅仅会用于轻薄笔记本,未来还会登陆服务器,而在两个月前以色列海法(Intel重要研发基地),Intel还展示了一款基于10nm Ice Lake打造的Nervana NNP-I(神经网络推理处理器),但采用了M.2样式。

Hot Chips 31芯片大会上,Intel首次公布了这款特殊产品的架构细节。

在无处不AI(AI Everywhere)的指导思想下,Intel正在研究各种各样的AI软硬件方案,包括CPU、GPU、FPGA、ASIC等等。

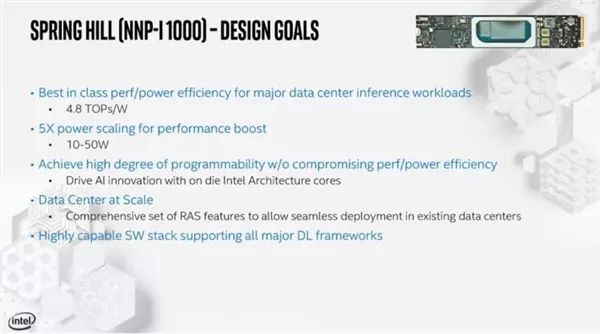

这款新的NNP-I代号为“Spring Hill”(温泉山丘),面向数据中心领域的轻度AI推理工作,能做成M.2扩展卡正是得益于10nm芯片的超小面积。

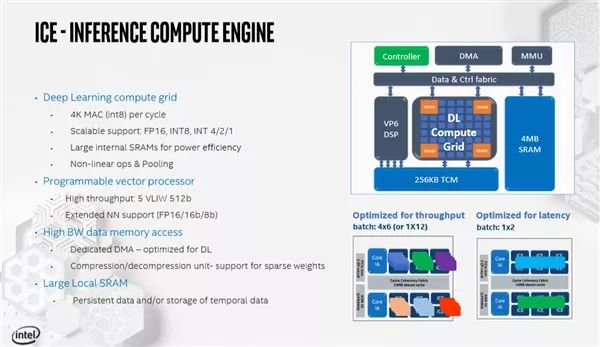

在原有10nm Ice Lake处理器的基础上,Intel拿掉了两个CPU计算核心、GPU核芯显卡,同时加入12个推理计算引擎(ICE),彼此基于硬件同步,同时每个ICE有自己的4MB SRAM缓存来减少数据转移,并且和两个CPU核心共享一致性互连、24MB三级缓存。

Intel还设计了一个深度学习计算网格(DL Compute Grid),作为张量引擎的它通过数据和控制总线与SRAM、VP6 DSP互连,支持FP16、INT8、INT4、INT2、INT1等类型操作,其中DSP还可以处理一些特殊的算法。

CPU核心仍然是标准的Sunny Cove架构,支持AVX-512、VNNI指令集,可加速卷积神经网络,而完全继承的FIVR电压调节器可动态调整功耗,优先满足最需要的硬件单元。

内置两个LPDDR4X内存控制器,整合封装一颗内存芯片与之配合,传输带宽4.2GT/s(68GB/s),并支持带内ECC,但容量未公布。

NNP-I与系统的通信通道走的是PCIe 3.0 x4或者PCIe 3.0 x8,带宽不是事儿,但没有用NVMe协议,只是标准的PCIe界面。

TDP功耗非常灵活,低可至10W,高可达50W,完全视性能需要而定,作为扩展卡也不受M.2 15W的限制。根据不同功耗配置,INT8整数能效在2-4.8TOP/s范围内。

Intel表示,10W TDP功耗下跑ResNet500,每分钟推理数可达3600,等于效率高达4.8TOP/s,还是相当高的。

软件方面,Intel会提供相应的开发工具,帮助负载将推理工作完全转移到加速器上,完成后再通知至强CPU进行下一步处理,从而使得至强CPU不再需要通过PCIe总线和其他加速器彼此通信、转移数据,大大节省计算资源和功耗。

Intel NNP-I目前已经试产,将在年底投入规模量产并出货,而且后续还有两代新品正在设计中……