CVPR 2018 | 商汤科技论文详解:FaceID-GAN:基于三方博弈和信息对称的可控人脸生成

下周CVPR 2018大会将开启,以下是商汤科技在深度生成对抗式模型方向,提出的基于三方博弈和信息对称的可控人脸生成算法。

论文:FaceID-GAN: Learning aSymmetry Three-Player GAN for Identity-Preserving Face Synthesis

作者:Yujun Shen, Ping Luo, Junjie Yan, Xiaogang Wang, Xiaoou Tang

论文链接:http://openaccess.thecvf.com/content_cvpr_2018/papers/Shen_FaceID-GAN_Learning_a_CVPR_2018_paper.pdf

FaceID-GAN生成效果展示:

简介

近年来,生成式对抗网络(GAN)的提出和发展使得生成式模型(generative model)有了飞速的进步。然而,如何对生成过程进行有效操控(如使用条件生成式对抗模型conditional GAN),仍有很大的探索空间。本研究以人脸生成为例,提出FaceID-GAN,它是一种可以保持身份信息不变,对人脸姿态和表情进行控制的生成式模型,大大提高了生成式对抗网络(GAN)的可操控性。区别于传统GAN所解决的双方博弈问题,FaceID-GAN的主要设计思想基于“三方博弈”(3-player game)和“信息对称”(information symmetry)。大量的实验结果表明,该方法可以很好地在身份、姿态、表情方面对人脸生成过程进行控制。同时,该模型的设计理念可以轻松地应用于其他有条件的生成式问题上。

生成式模型是机器学习的重要分支之一,其目标是从真实数据中学习数据服从的分布,然后根据学习到的分布进行采样,生成足够真实的数据。对抗生成网络(GAN)是目前最有效的生成式模型之一(如图1(左)中虚线部分所示),它包含两个部分:一是判别器Discriminator,用来区分真实数据Xr的分布和生成数据Xs的分布;二是生成器Generator,利用随机噪声Z作为输入生成数据Xs,其目的是学习到真实数据的分布,使得生成数据Xs足以迷惑判别器D。两者进行博弈,当达到平衡点的时候,判别器D已经无法区分真实数据分布与生成数据分布,可以认为生成数据已经足够真实。

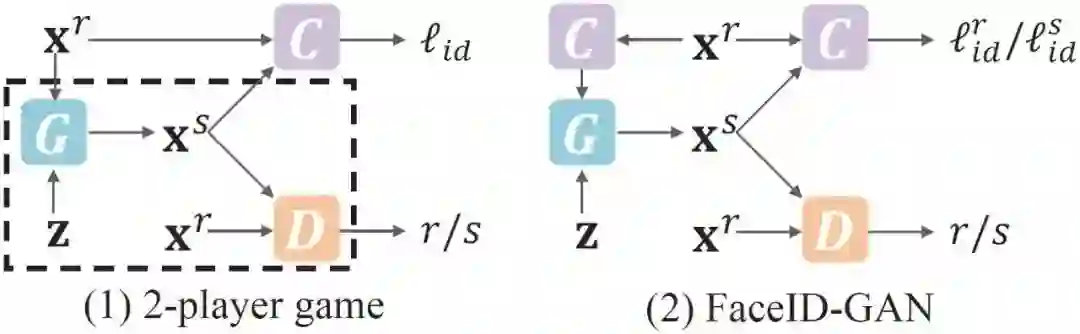

图1:

本文提出的FaceID-GAN和传统GAN的比较

当对生成过程增加限制条件时,比如控制生成人脸的身份信息和输入的人脸相同,如图1(左)所示,常见做法是增加一个图像分类器Classifier。分类器C的目标是对人脸的身份信息进行分类,这里既包括对真实图片Xr进行分类(确保C提取的是身份信息而不是其他信息),同时包括对生成图片Xs进行分类(起到监督控制Xs身份的作用)。此时生成器G不仅要满足生成图片Xs可以迷惑判别器D,同时还要满足生成图片Xs被分类器C分到与相应的输入图片Xr相同的类别。

然而,此类方法对于身份信息的保持程度并不高,本文作者认为原因有以下两点。第一,分类器C在这一框架中并没有参与到生成器G与判别器D的博弈当中,仅仅起到了为生成数据Xs提供身份监督的作用,约束条件不够强。第二,从图1(左)中可以看出,对于生成器G来说,身份信息的监督是由分类器C提供的;而身份信息的输入则直接来源于Xr。这不仅增加了生成器G的学习难度(学习数据分布的同时,还要学习提取身份信息),而且整个网络中存在对身份信息的两套编码(分别来自生成器G和分类器C),两者的不统一大大增加了网络的收敛难度。

基于三方博弈和信息对称的可控人脸图像生成

为此,本文所提出的FaceID-GAN进行了以下改进(如图1(右)所示)。第一,将原有的“双方博弈,一方监督”扩展为“三方博弈”。即分类器C在对真实图片Xr的身份信息进行分类的同时,还要对真实图片Xr和生成图片Xs的身份信息进行不同的分类。具体来说:假设真实图Xr中有N个身份,那么分类器C要进行2N分类。其中,将Xr的不同身份分到前N类,将相应生成的Xs的不同身份分到后N类(即真假不同分类)。与此同时,生成器G在身份信息方面与分类器C进行博弈。类比生成器G和判别器D之间的博弈,分类器C试图从身份信息方面将真实图Xr和生成图Xs区分开,而生成器G试图迷惑分类器C。这样设计的好处在于,在训练过程中,分类器C从真假图片的身份信息上施加约束条件,而这一约束条件随着生成器G生成图片身份相似度的提高而不断加强,反过来促使生成器G生成身份信息保持度更高的图片。

第二,提出了基于信息对称的模型框架。即生成器G不再直接以真实图片Xr作为输入,取而代之的是由分类器C从Xr中提取得到的身份信息。这样改进的好处在于,生成器G无须重新学习身份信息,整个网络中只存在身份信息的一套编码(来自分类器C)。同时,对生成器G来说,身份信息的输入和监督都由分类器C提供,统一了评价标准,使得网络更容易收敛。

第三,为了进一步控制生成人脸的姿态和表情,本方法利用3DMM模型对人脸进行建模,并加入到FaceID-GAN的训练框架中。3DMM是一种能够将二维人脸投射到三维空间的模型,其参数主要包括形状(shape)、表情(expression)和姿态(包括放缩、平移和旋转,本文主要考虑旋转)。同身份信息一样,姿态和表情是人脸的额外信息。如图2所示,本文作者在框架中增加参数提取器P对真实图片Xr进行此类信息的提取,同时利用参数提取器P对生成图片Xs进行姿态表情的监督。与分类器C所不同的是,Xs和Xr需要在身份信息上保持不变,而在姿态和表情方面可以控制(可变),因此参数提取器P并不与生成器G进行博弈,仅仅起到监督的作用,但依然使用“信息对称”的设计思想。

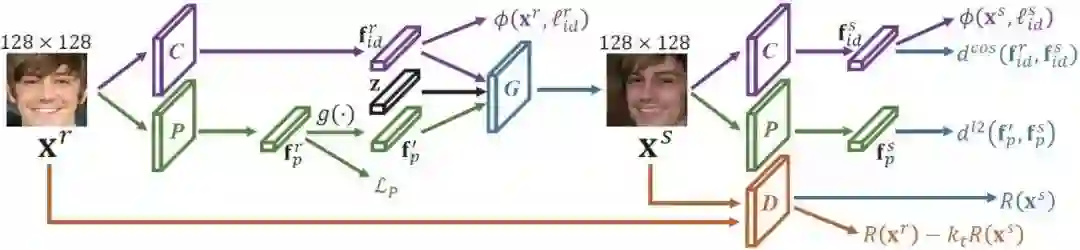

图2:

FaceID-GAN的训练框架

具体训练框架如图2所示,给定一张输入真实图像Xr,通过分类器C提取出身份信息,通过参数提取器P提取出姿态表情信息(即3DMM参数),然后利用函数g(·)对参数中的姿态和表情部分进行修改(由于3DMM参数中的形状部分与身份相关,因此不做修改),得到目标信息(即为控制生成相应的姿态表情所对应的参数)。生成器G以身份信息、目标姿态表情信息和噪声z为输入,输出生成图像Xs。生成图像Xs利用同样的分类器C和参数提取器P进行监督(前后两个C和两个P均共享参数),以保证身份的保持,以及姿态表情的可控。与此同时,生成器G和判别器D在图像真实性上进行对抗,生成器G和分类器C在身份信息上进行对抗,实现三方博弈。(注:图2中的ϕ(·,·),dcos(·,·),dl2(·,·),R(·)代表不同的损失函数)。

实验结果

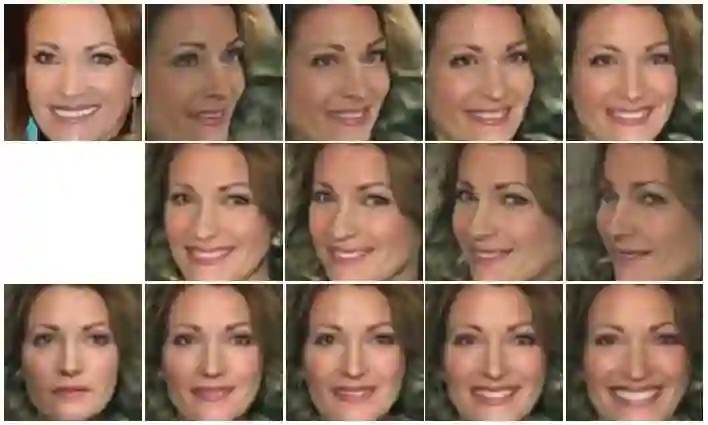

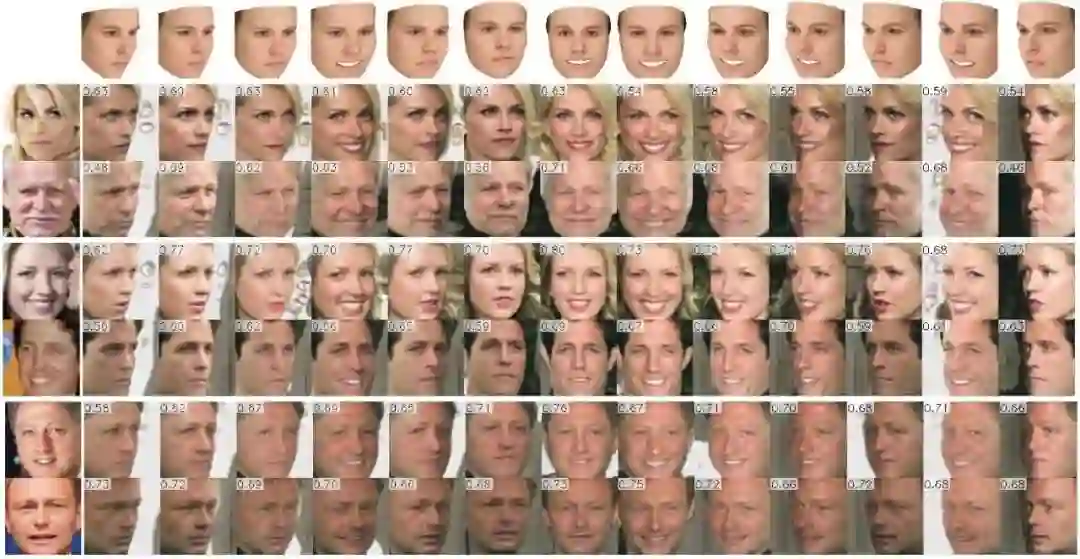

图3和图4展示了FaceID-GAN模型的人脸生成结果。由图3中可以看出,FaceID-GAN所实现的高质量人脸生成,在很好地保持输入图片的身份信息的同时,可以生成连续变化的姿态和表情。图4中的第一行展示了目标3DMM参数所对应的三维人脸模型,第一列为输入图片。从行列的交叉比较中可以看出,FaceID-GAN能够将身份信息和姿态表情信息剥离开来,鲁棒地实现身份的保持和姿态表情的可控。

图3:

FaceID-GAN生成结果,左上角为输入图片,

前两行为不同给定姿态条件下的生成图像,

第三行为不同给定表情条件下的生成图像

图4:

FaceID-GAN生成结果和3DMM模型的对照

结论

本文作者认为,此框架不仅适用于人脸生成,还可以用于设计解决其他有条件的生成模型。其遵循的原则为:真实图像和生成图像采用相同的评价标准,保持信息的前后对称。同时,信息中需要保持不变的部分(如身份信息、图像真实性)进行对抗博弈,需要控制改变的部分(如姿态、表情)不进行对抗。在FaceID-GAN中具体表现为,生成器G的信息输入和信息监督都是通过分类器C和参数提取器P得到的,体现了信息对称原则。同时,为了保证生成图像真实性与输入图像相同,生成器G与判别器D进行对抗;为了保证生成图像身份信息与输入图像相同,生成器G与分类器C进行对抗;为了控制改变生成图像的姿态和表情,生成器G与参数提取器P不进行对抗。沿着这一思路,三方博弈可以扩展至多方博弈,解决更加复杂的生成问题。