来自上海交通大学的卢策吾教授团队多年来致力于行为理解研究,最新成果已发表在《自然》上。

当行为主体在执行某个行为时,其大脑是否产生了对应的稳定脑神经模式映射?如果存在稳定映射,是否能运用机器学习方法发现未知行为神经回路?

为了回答这一系列行为理解的本质问题,近日一项发表在《自然》上的工作对行为理解机理进行了研究。该论文的两位共同通讯作者为上海交通大学的卢策吾教授与Salk研究院Kay M. Tye教授。

![]()

论文链接:https://www.nature.com/articles/s41586-022-04507-5

该成果基于计算机视觉技术定量阐释了机器视觉行为理解与脑神经的内在关联,并首次建立了其稳定映射模型。形成计算机视觉行为分析发现行为神经回路这一运用人工智能解决神经科学基础问题的新研究范式,具体为计算机智能算法通过大规模对小鼠社交和竞争行为视频的理解,发现了控制 “动物社会层级(Social Hierarchy)行为”的神经回路,面向回答哺乳动物是如何判断其他个体与自己在社会群体地位高低并做出行为决策的问题,其形成的新研究范式也进一步推动了人工智能与基础科学问题前沿交叉(AI for Science)领域的发展。

![]()

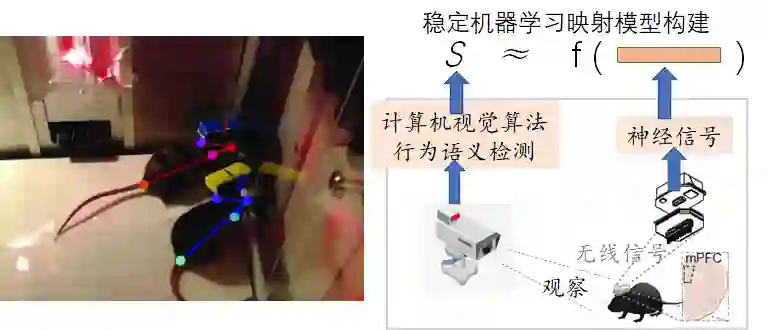

图1. 视觉行为检测-脑神经信号关联模型:(a)小鼠视觉行为理解(b)系统框架与模型学习。

视觉行为检测-脑神经信号关联模型:我们以小鼠群为实验对象,为每只小鼠佩戴无线电生理记录设备,以记录社交活动中的特定脑区内侧前额叶皮层 (mPFC)的序列脑神经信号。同时,通过多个摄像头跟踪定位每只小鼠,基于卢策吾教授团队研究开发的姿态估计(如alphapose)与行为分类研究成果提取行为语义标签,达到小鼠的姿态估计准确率高于人眼水平。基于提出系统自动采集的大量数据,隐马尔可夫模型训练从“小鼠mPFC脑区的神经活动信号”到“行为标签”的回归模型,发现训练后在测试集上仍然有稳定映射关系,揭示了行为视觉类型与其行为主体大脑中的脑神经信号模式存在稳定的映射关系。

模型应用:控制动物社会层级(Social Hierarchy)行为神经回路发现:基于视觉行为检测-脑神经信号关联模型,我们可以发现新的行为神经回路。“动物社会层级”行为神经控制机理(比如,低等级小鼠会让高等级小鼠优先进食,低等级小鼠会表现出服从行为)一直是学界重要问题,即哺乳动物是如何判断其他个体与自己的社会群体地位高低的?其背后的神经控制机制是怎么样的?由于动物社会层级行为是复杂行为概念,该问题一直为学界未所突破的难题。我们在大规模的小鼠群体竞争视频中,定位 “动物社会层级”行为基于上述系统和模型,并同时记录到动物社会层级行为的脑部活动状态,深度解析了动物社会层级行为在大脑中的形成机制,即发现内侧前额叶皮层-外侧下丘脑(mPFC-LH)回路具有控制动物社会层级行为的功能,并得到严格生物学实验的证实。该研究形成了基于机器视觉学习发现未知行为功能神经回路的新研究范式,也进一步推动了人工智能解决基础科学问题(AI for Science)的发展。

上述工作是卢策吾团队多年的行为理解方面积累的一部分。机器如何理解行为,需要全面地回答以下三个问题:

2. 神经认知角度:机器认知语义与神经认知的内在关联是什么?

3. 具身认知角度:如何将行为理解知识迁移到的机器人系统?

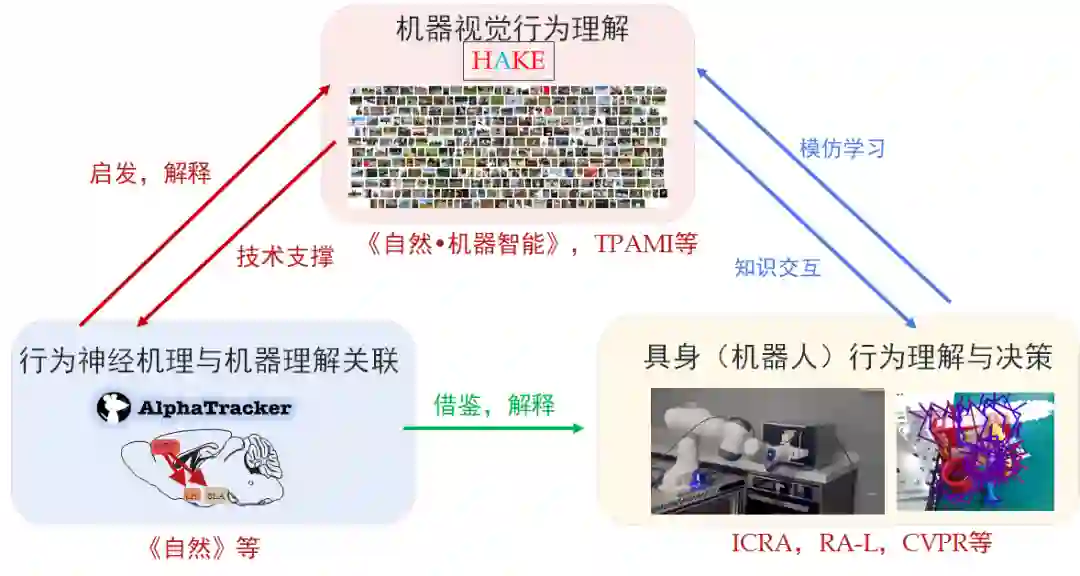

![]()

此次在《自然》上发表的工作正是想回答第二个问题,对于其他两个问题团队主要工作有:

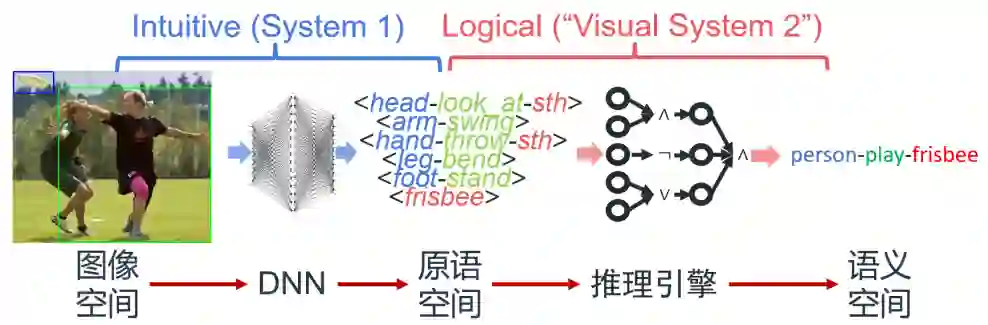

为探索可泛化、可解释、可扩展的行为识别方法,要克服行为模式和语义间的模糊联系、数据分布长尾等问题。区别于一般的直接深度学习“黑盒”模式,团队构建了知识引导与数据驱动的行为推理引擎HAKE(开源网站:http://hake-mvig.cn/home/):

![]()

HAKE将行为理解任务分为两阶段,首先将视觉模式映射到人体局部状态原语空间,用有限且接近完备的原子的原语表达多样的行为模式;随后将原语依据逻辑规则进行编程,以可推理行为语义。HAKE提供了大型的行为原语知识库以支持高效的原语分解,并借助组合泛化和可微神经符号推理完成行为理解,具有以下特点(发表TPAMI,CVPR等计算机视觉顶刊顶会十余篇):

(1)规则可学习:HAKE可根据少量人类行为-原语的先验知识进行逻辑规则的自动挖掘和验证,即对原语组合规则进行总结,并在实际数据上进行演绎验证,以发现有效且可泛化的规则,发现未知行为规则,如图4。

![]()

(2)人类性能upper bound:在87类复杂行为实例级别行为检测测试集(10,000张图像)上,具备完备原语检测的HAKE系统的性能甚至可接近人类的行为感知性能,验证了其巨大潜力。

![]()

图5. 让机器(HAKE)和人类抹去部分像素使得无法理解图中行为,图灵测试表明,HAEK的“抹去手法”和人类十分相似。

我们还提出了一种特殊“图灵测试”:若机器可以从图像中抹去关键像素,使得人类被试者也无法分辨该行为时,即认为其可以较好地理解该行为。分别让HAKE和人类去做这种抹去操作。并请另一批志愿者做图灵测试,问这个抹去操作是人类还是HAKE操作。人类分辨的正确率约为59.55%(随机猜50%),说明HAKE的“抹去手法”和人类十分相似,侧面印证了在行为“可解释性”的理解上与人类相近。

对于某个特定行为(如“洗”),人类大脑能抽象出泛化的行为动态概念,适用于不同的视觉对象(如衣服、茶具、鞋),并以此做出行为识别。神经科学领域研究发现,对于连续视觉信号输入,在人类的记忆形成过程中,时空动态信息与物体对象信息是通过两个相对独立的信息通路到达海马体以形成完整的记忆,这个带来行为对象可泛化的可能性。

![]()

图6. 解耦合地处理行为对象概念和行为动态概念,带来的泛化性。

基于脑科学启发,卢策吾团队通过模仿人类的认知行为对象与动态概念在各种脑区独立工作的机制,提出了适用于高维度信息的半耦合结构模型(SCS),实现自主发掘(awareness)行为视觉对象概念与行为动态概念,将两种概念分别记忆存储在相对独立的两部分神经元上。在深度耦合模型框架下设计信息独立误差反传(decouple back-propagation)机制,约束两类神经元只关注自己的概念,初步实现了行为理解对行为主体对象的泛化。所提出半耦合结构模型工作发表在《自然•机器智能》,并获得2020年世界人工智能大会优秀青年论文奖。

![]()

图7.可视化表征“视觉对象”与“行为动态概念”的神经元《自然•机器智能》

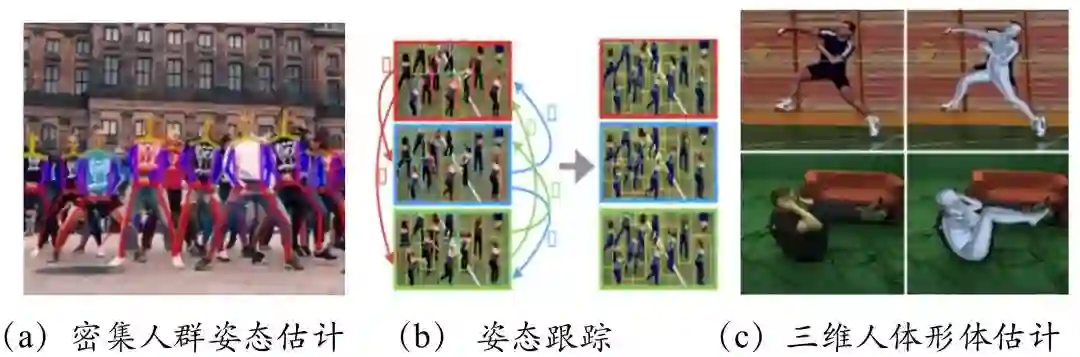

人体姿态估计是行为理解的重要基础,该问题是一个在结构约束下获取精准感知的问题,围绕结构约束下感知问题,提出图竞争匹配、姿态流全局优化、神经-解析混合的逆运动优化等算法,系统性地解决人体运动结构感中密集人群干扰大、姿态跟踪不稳定、三维人体常识性错误严重等难题,前后发表CVPR,ICCV等计算机视觉顶会论文20多篇;

![]()

相关研究成果积累形成开源系统AlphaPose(https://github.com/MVIG-SJTU/AlphaPose),在开源社区GitHub上获得5954 Star(Fork数为1656),GitHub排名前十万份之1.6。被传感器领域、机器人领域、医学领域、城市建设领域广泛使用。在姿态估计后,团队进一步形成开源视频行为理解开源框架Alphaction(https://github.com/MVIG-SJTU/AlphAction)。

探索结合第一人称角度理解人类行为本质,从单纯考虑“她/他在做什么”到联合考虑“我在做什么”。这种研究范式也正是 “具身智能”(Embodied AI)的研究思路。探索将该理解能力与学习得到的行为知识迁移到具身智能本体(人形机器人),使机器人初步具有“人类行为能力”,最后驱动机器人完成真实世界的部分任务,为通用服务机器人奠定基础。以上科学问题的解决将:(1)大大提高行为语义检测性能和提升语义理解范围;(2)有力地提高智能体(特别是人形机器人)对真实世界的理解能力,同时根据完成任务过程中真实世界的反馈检验机器对行为概念本质的理解程度,为通用智能机器人的实现打下重要基础。

近年来卢策吾团队在具身智能领域联合非夕科技构建通用物体抓取框架GraspNet(https://graspnet.net/anygrasp.html),实现了任意场景下刚体、可变形物体、透明物体等各种类型的未见物体的抓取,首次将PPH(picks per hour)指标超越人类水平,为之前性能最优的DexNet算法的三倍,相关论文发表一年内被引用70次。物体抓取是机器人操作的第一步,为该项目打下良好基础。

![]()

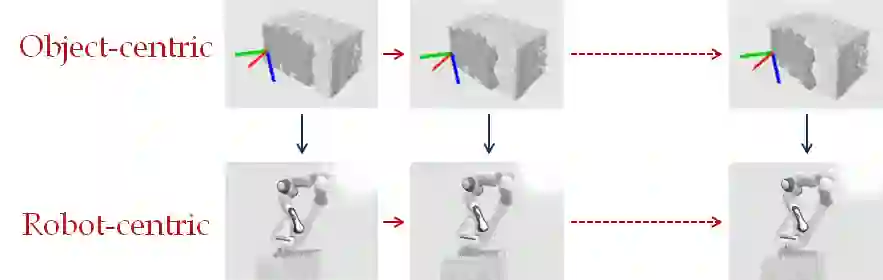

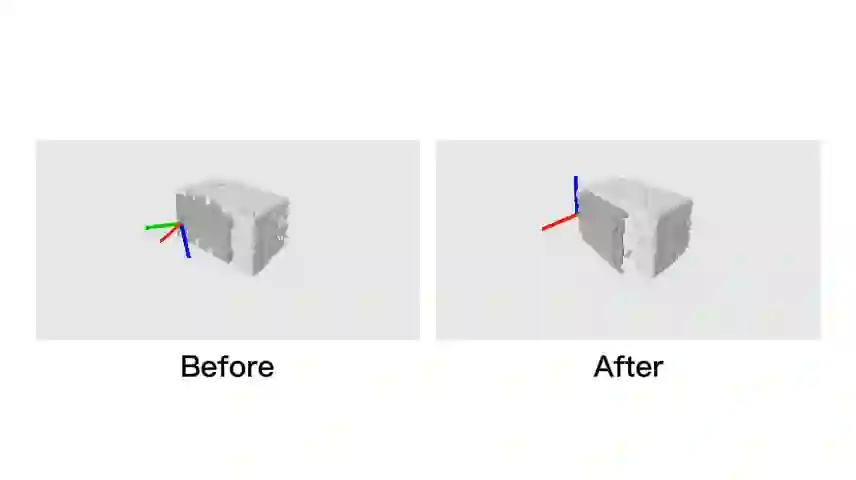

实现机器人行为执行能力与物体知识理解联合学习与迭代提高,通过机器人交互本质上降低物体模型感知估计误差,并基于物体知识的理解进一步提高机器人行为执行能力。比起之前纯视觉物体识别,交互带来新的信息源,带来感知性能本质提高。如图9与视频所示,

![]()

![]()

![]()

图10. 交互感知:机器人行为能力

(上图)与模型理解能力(下图)

联合学习 (边执行行为,边提高纠正感知)

相关工作是发表在ICRA 2022上的论文《SAGCI-System: Towards Sample-Efficient, Generalizable, Compositional, and Incremental Robot Learning》(SAGCI 系统:面向样本高效、可扩展、可组合和可增量的机器人学习框架)。

卢策吾,上海交通大学教授,博士生导师,研究方向为人工智能。2018年被《麻省理工科技评论》评选为中国35岁以下创新精英35人(MIT TR35),2019年获求是杰出青年学者。

IJCAI 2022 - Neural MMO 海量 AI 团队生存挑战赛

4月14日,由超参数科技发起,联合学界MIT、清华大学深圳国际研究生院以及知名数据科学挑战平台 AIcrowd 共同主办的「IJCAI 2022-Neural MMO 海量 AI 团队生存挑战赛」正式启动。

本届赛事以「寻找未来开放大世界的最强 AI 团队」为主题,通过在 Neural MMO 的大规模多智能体环境中探索、搜寻和战斗,获得比其他参赛者更高的成就。比赛还设置新的规则,评估智能体面对新地图和不同对手的策略鲁棒性,在 AI 团队中引入合作和角色分工,丰富了比赛内容,增强了趣味性。

比赛设立了

20000美元的奖金池

以及丰富的

学术荣誉奖 & 趣味奖

,比如“酸脚(Jio)奖”。对比赛感兴趣的小伙伴点击阅读原文赶紧报名吧!

![]()

© THE END

转载请联系本公众号获得授权

投稿或寻求报道:content@jiqizhixin.com