学界 | 中科院自动化所提出不规则卷积神经网络:可动态提升效率

选自arXiv

作者:马佳彬等

机器之心编译

参与:李泽南

近日,中国科学院自动化研究所马佳彬、王威、王亮等人发表的研究提出了一种新形式的卷积神经网络——不规则卷积神经网络。研究人员认为新的方法能够解决常规卷积效率低下的问题。

论文:不规则卷积神经网络(Irregular Convolutional Neural Networks)

摘要

卷积核是深度卷积神经网络(CNN)的基础和重要组成部分。在本论文中,我们为卷积核配置了形状属性来生成不规则深度卷积神经网络(ICNN)。与传统 CNN 使用规则(如 3×3 卷积)核不同,我们的方法可以训练出不规则的核形状,以更好地适应输入特征的几何变化。换句话说,除权重之外,形状是可以学习的参数。在使用标准反向传播算法的端到端训练期间,核心形状和权重被同时学习了。我们使用 ICNN 进行了语义分割任务的实验,验证了新模型的效果。

近年来,卷积神经网络(CNN)在学界和业界颇受欢迎,它已被成功应用到了多种特征提取任务中。尽管如此,卷积神经网络本身仍面临一些需要解决的问题。

首先,CNN 中的规则核心形状与不规则的特征模式并不匹配。在视觉任务中,虽然输入图像的尺寸通常是固定的,但图像内容的形状大多是不规则的——而后者才是模型需要分析的内容。在图像识别时,我们需要对图中事物的类别进行分类,而非对图片本身,这种情况在物体探测和多物体分割任务中更为明显,因为在这种任务中,神经网络需要把物体和其背景内容分开,而特征图案是不规则的。

由于卷积运算实际上是两个向量的点积,即特征模式和卷积核,这两个向量在理想状态下应具有相同属性,这样才能获得准确的响应。换句话说,因为输入特征模式是不规则的,卷积核也应该是不规则的,这样才能让模型更好地提取最有价值的信息。但传统神经网络的核形状通常是固定的,不能通过训练来直接学习。

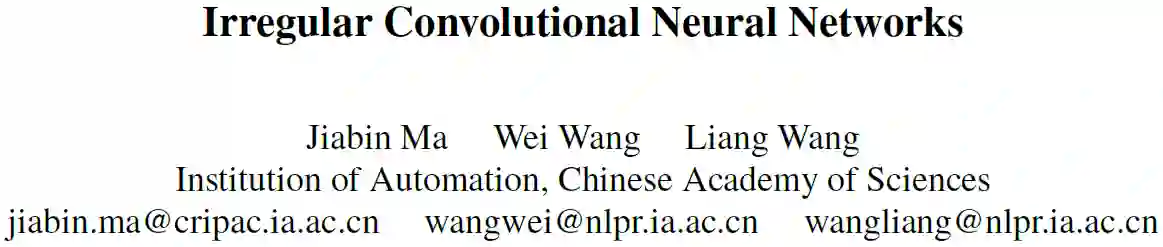

图 1. 规则与不规则卷积核的对比。(a)不规则输入超过了 3×3 核的范围。(b)K1 和 K2 是两个用于处理这种输入的 3×3 核。(c)从常规 3×3 核到适用于输入信息的非常规形态核的转换。

形状不匹配导致规则卷积核在对不规则特征模式进行建模时效率低下。具有规则形状的卷积核也可以模拟不规则特征模式,其基本思想是在规则形状内不同尺度的权重分布可以具有与不规则形状相似的效果。如上图所示,两个规则 3×3 核建模了不规则的输入。但这种方法效率消耗了 18 个像素来对 9 个像素建模,而如果图形更加离散,这种低效的情况还会加剧。

由于常规核心形状与不规则特征模式的不匹配,最直观和合理的解决方案是使用不规则和可训练的核形状。中科院的研究人员提出了一种新方法来实现从常规核形状到不规则核的转换。如图上所示,新的方法允许常规核跳转到新的位置来寻找更有价值的特征,即使这些特征有可能在原有的 3×3 框架范围之外。

图 2.(a)常规核固定在方形中;(b)不规则核的位置则会随着训练产生变化,损失函数梯度的反向传播会对其产生影响。(c)位置浮动的双线性插值。

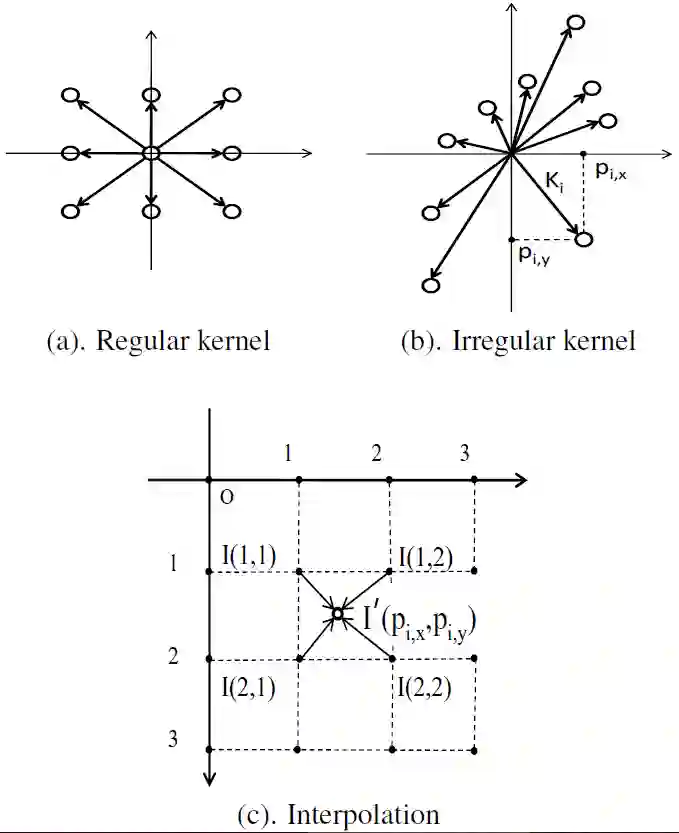

图 4. 来自不同层的不同核形态。(a)是最后一个卷基层 fc1_voc12 的三维可视化;(c)是它在高-宽二维上的投影,(b)和(d)是相应层的二维投影。在这些图中,具有相同颜色的店意味着它们核位置没有移动。

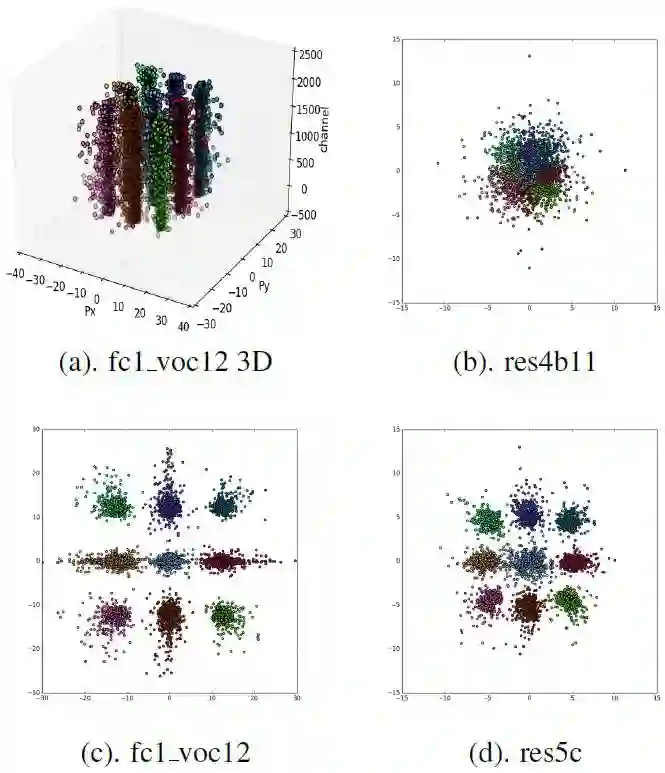

图 5. 第一行:进行语义分割的原始图像。第二行和第三行皆为红色十字标记物体的热区图,第二行是 deeplab 的 large- FOV 获得的,第三行是 ICNN 获得的。有价值的信息已被黄色框出。

研究人员表示,构建 ICNN 的目标是建立输入特征和卷积核之间的形态兼容。通过为卷积核添加形状属性,并使用双线性插值使其可以进行端到端的训练。这种改进可以平滑地集成到最新的卷积网络系统中,没有加入任何额外的子网络。这种方法或许可以大大提高卷积神经网络的性能,为多种应用带来性能上的提升。

本文为机器之心编译,转载请联系本公众号获得授权。

✄------------------------------------------------

加入机器之心(全职记者/实习生):hr@jiqizhixin.com

投稿或寻求报道:editor@jiqizhixin.com

广告&商务合作:bd@jiqizhixin.com

点击阅读原文,查看机器之心官网↓↓↓