博客 | Tensorflow系列专题(五):BP算法原理

本文原载于微信公众号:磐创AI(ID:xunixs),AI研习社经授权转载。欢迎关注磐创AI微信公众号及AI研习社博客专栏。

目录:

反向传播算法简介

前馈计算的过程

第一层隐藏层的计算

第二层隐藏层的计算

输出层的计算

反向传播的计算

计算偏导数

参考文献

一.反向传播算法

反向传播算法[1](Backpropagation Algorithm,简称BP算法)是深度学习的重要思想基础,对于初学者来说也是必须要掌握的基础知识,在这一小节里,我们会较为详细的介绍这一重点知识。

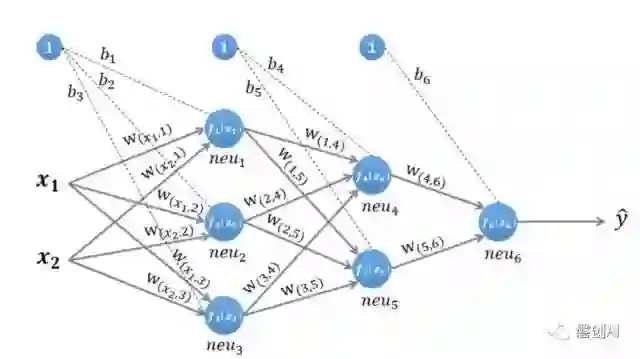

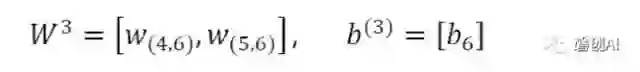

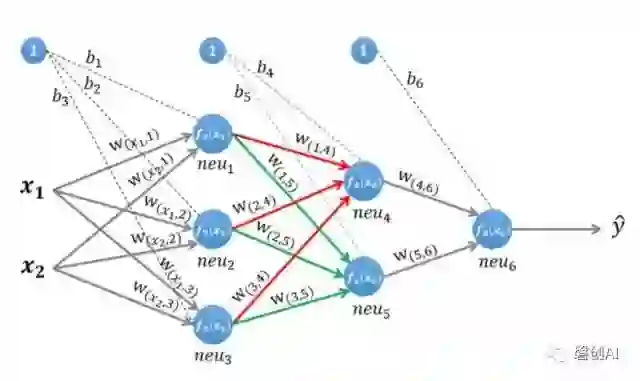

我们使用一个如图1所示的神经网络,该图所示是一个三层神经网络,两层隐藏层和一层输出层,输入层有两个神经元,接收输入样本(x1,x2),

图1 一个三层神经网络

二.前馈计算的过程

为了理解神经网络的运算过程,我们需要先搞清楚前馈计算,即数据沿着神经网络前向传播的计算过程,以图1所示的网络为例:

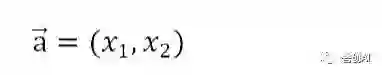

输入的样本为:

公式1

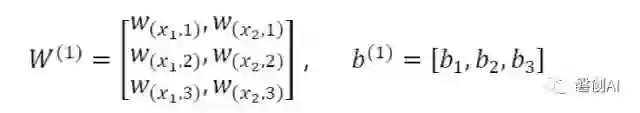

第一层网络的参数为:

公式2

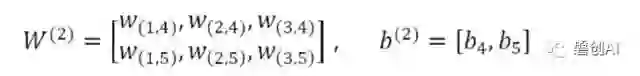

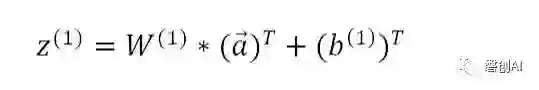

第二层网络的参数为:

公式3

第三层网络的参数为:

公式4

·第一层隐藏层的计算

图2 计算第一层隐藏层

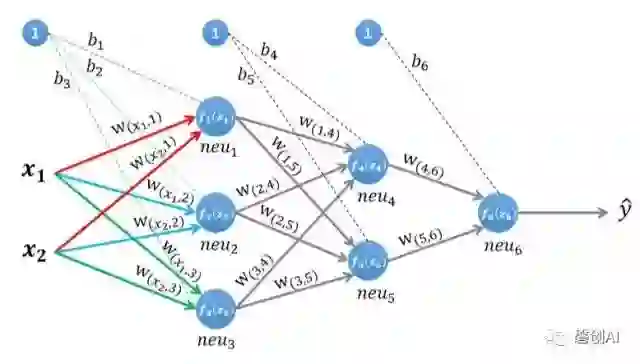

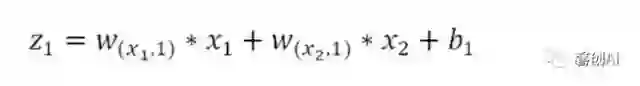

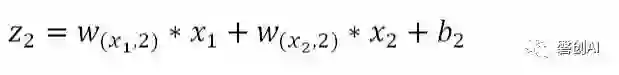

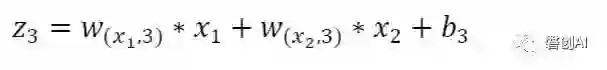

第一层隐藏层有三个神经元:neu1、neu2和neu3。该层的输入为:

公式5

以neu1神经元为例,则其输入为:

公式6

同理有:

公式7

公式8

假设我们选择函数f(x)作为该层的激活函数(图1中的激活函数都标了一个下标,一般情况下,同一层的激活函数都是一样的,不同层可以选择不同的激活函数),那么该层的输出为:

·第二层隐藏层的计算

图3 计算第二层隐藏层

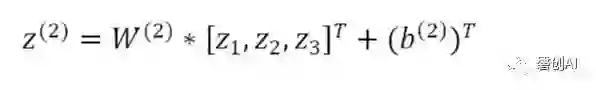

第二层隐藏层有两个神经元:neu4和neu5。该层的输入为:

公式9

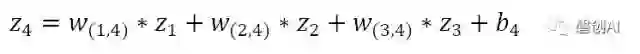

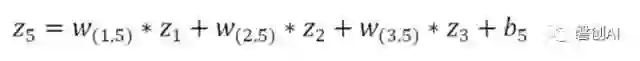

即第二层的输入是第一层的输出乘以第二层的权重,再加上第二层的偏置。因此得到neu4和neu5的输入分别为:

公式10

公式11

该层的输出分别为:

·输出层的计算

图4 计算输出层

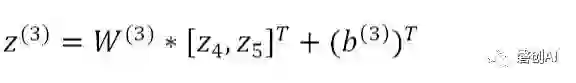

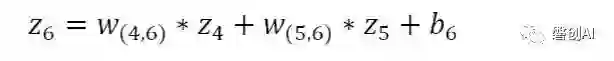

输出层只有一个神经元:neu6。该层的输入为:

公式12

即:

公式13

因为该网络要解决的是一个二分类问题,所以输出层的激活函数也可以使用一个Sigmoid型函数,神经网络最后的输出为:

三.反向传播的计算

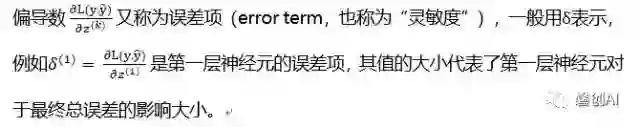

上一小节里我们已经了解了数据沿着神经网络前向传播的过程,这一节我们来介绍更重要的反向传播的计算过程。假设我们使用随机梯度下降的方式来学习神经网络的参数,损失函数定义为

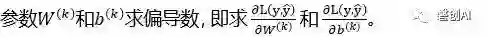

其中y是该样本的真实类标。使用梯度下降进行参数的学习,我们必须计算出损失函数关于神经网络中各层参数(权重w和偏置b)的偏导数。

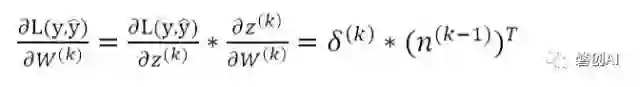

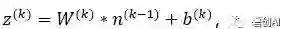

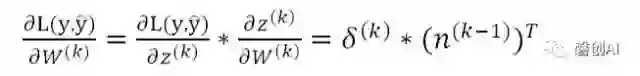

假设我们要对第k层隐藏层的

假设

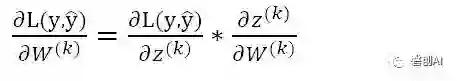

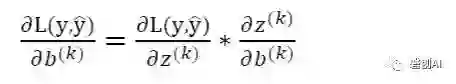

其中n^(k-1)为前一层神经元的输出,则根据链式法则有:

公式14

公式15

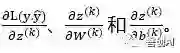

因此,我们只需要计算偏导数

·计算偏导数![1542164778679750.jpg]()

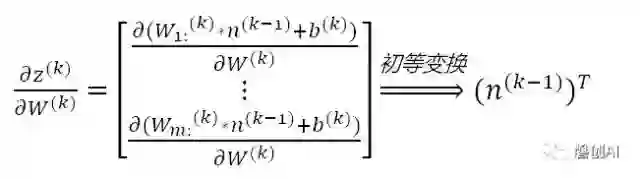

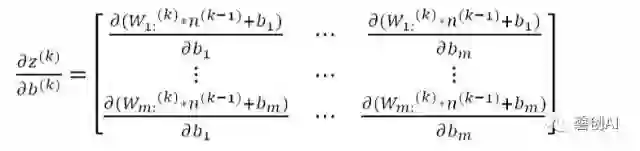

前面说过,第k层神经元的输入为:,因此可以得到:

公式16

我们以1.1节中的简单神经网络为例,假设我们要计算第一层隐藏层的神经元关于权重矩阵的导数,则有:

公式17

·计算偏导数![1542164872435685.jpg]()

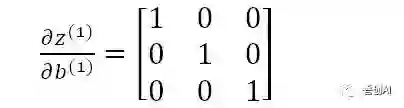

因为偏置b是一个常数项,因此偏导数的计算也很简单:

公式18

依然以第一层隐藏层的神经元为例,则有:

公式19

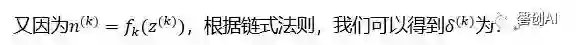

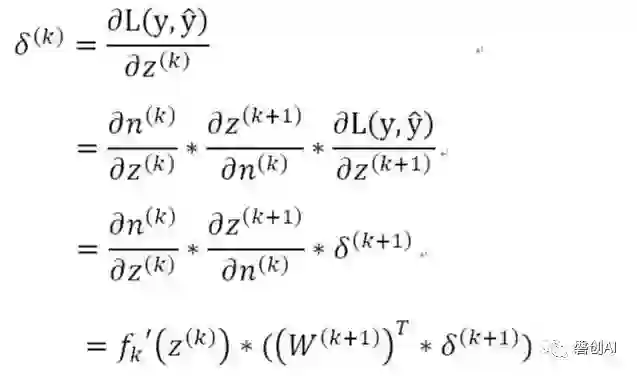

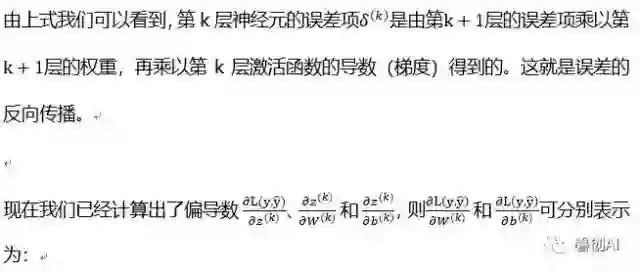

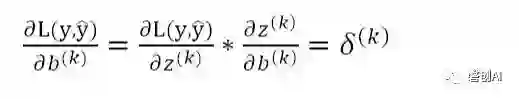

·计算偏导数![1542165086150628.jpg]()

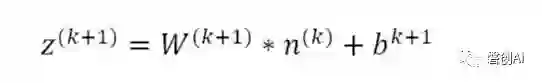

根据第一节的前向计算,我们知道第k+1层的输入与第k层的输出之间的关系为:

公式20

公式21

公式22

公式23

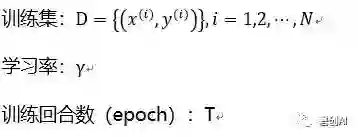

下面是基于随机梯度下降更新参数的反向传播算法:

输入:

以上是BP算法的介绍,下次文章中有一个BP算法计算的完整示例,希望加深理解的读者可以跟着示例计算一遍。

四.参考文献

[1]. Learing representations by back-propagatingerros.David E.Rumelhart,Geoffrey E.Hinton,Ronald J.Williams

更多相关文章,请查看:

博客 | Tensorflow系列专题(四):神经网络篇之前馈神经网络综述

欢迎扫码关注磐创AI微信公众号

独家中文版 CMU 秋季深度学习课程免费开学!

CMU 2018 秋季《深度学习导论》为官方开源最新版本,由卡耐基梅隆大学教授 Bhiksha Raj 授权 AI 研习社翻译。学员将在本课程中学习深度神经网络的基础知识,以及它们在众多 AI 任务中的应用。课程结束后,期望学生能对深度学习有足够的了解,并且能够在众多的实际任务中应用深度学习。

↗扫码即可免费学习↖

点击 阅读原文 查看本文更多内容↙