LSTM之父,被图灵奖遗忘的大神

新智元原创

作者:张乾、金磊、大明

【新智元导读】图灵奖为何不颁给LSTM之父Jürgen Schmidhuber?作为AI界特立独行的人,Schmidhuber与深度学习三巨头有过口水战,并现场对质GAN的提出者,可谓得罪了一圈人。

一个被遗忘的大神。

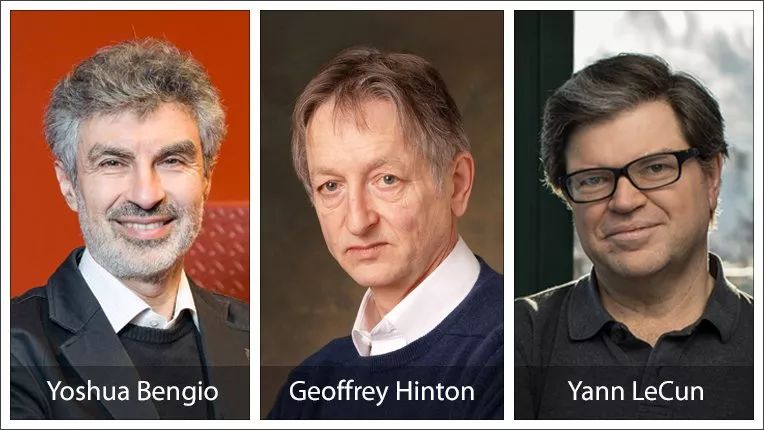

前几天,2018图灵奖获得者公布,深度学习三巨头:Yoshua Bengio、Geoffrey Hinton、Yann LeCun荣获桂冠。

HLB(Hinton、LeCun、Bengio)三人获图灵奖实至名归,消息一出,计算机界纷纷送上祝福。

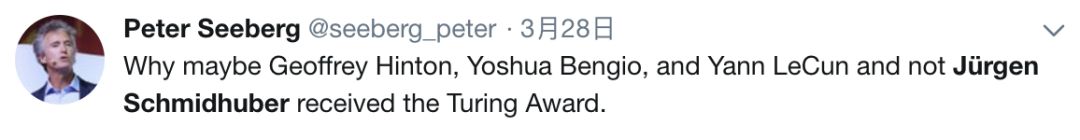

不过,在恭贺之余,也有不少的网友发出了质疑:图灵奖为什么没颁给LSTM之父Jürgen Schmidhuber?他也是深度学习领域的大家啊。

获得图灵奖的为什么是Yoshua Bengio、Geoffrey Hinton、Yann LeCun,而不是Jürgen Schmidhuber呢?

Yoshua Bengio、Geoffrey Hinton和Yann LeCun获得了图灵奖(计算机界的诺贝尔奖),让深度神经网络成为计算机中的重要环节。非常酷!但是Jürgen Schmidhuber呢?

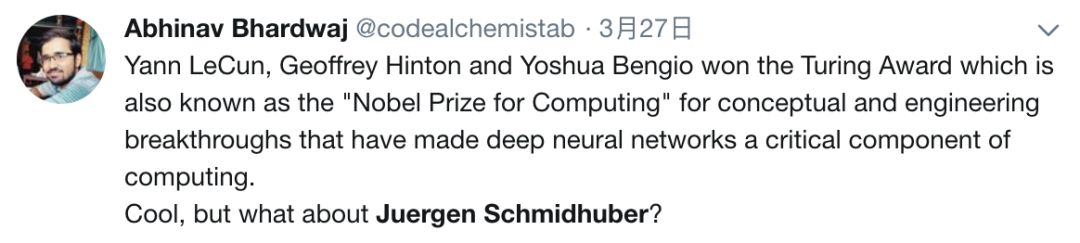

就连南京大学人工智能学院院长周志华教授也发微博称,LSTM是教科书级的贡献。

Jürgen Schmidhuber是瑞士Dalle Molle人工智能研究所的联合主任,他1997年提出的LSTM现在被广泛应用在谷歌翻译、苹果Siri、亚马逊Alex等应用中,可谓是深度学习领域最商业化的技术之一。

Jürgen Schmidhuber

除了LSTM之外,Jürgen Schmidhuber“引以为傲”的还有他在1992年提出的一种PM(Predictability Minimization)模型。

为什么“引以为傲要”打引号?

因为他坚持认为现在大火的GAN就是PM的变种,两者的区别就在于方向是反的,为此,Jürgen Schmidhuber还和GAN的提出者Ian Goodfellow有过线上线下激烈的交锋,业界至今记忆犹新。

至于对深度学习三巨头HLB,Jürgen Schmidhuber也打过几轮口水仗,认为HLB三人在自己的圈子里玩,对深度学习领域其他更早期先驱人物的贡献则只字不提,之后LeCun发文反击。

Jürgen Schmidhuber这个暴脾气没得奖,是因为得罪人了吗?

故事还得从五年前讲起。

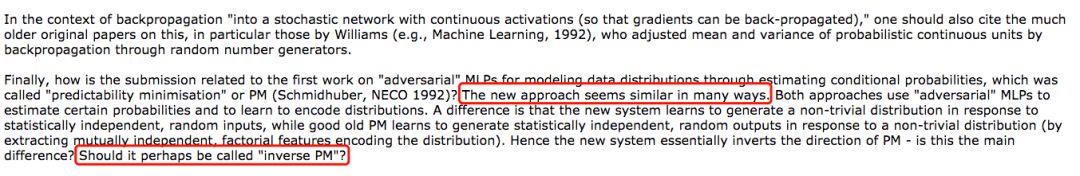

2014年,Ian Goodfellow第一篇GAN论文投到了NIPS大会,三位评审中,两位直接通过,一位直接毙掉。

这位拒稿的评审就是Jürgen Schmidhuber。

Jürgen Schmidhuber为什么给出Goodfellow这位年轻的后辈如此截然相反的评审意见?

原来,Jürgen Schmidhuber认为,GAN不能称为第一个对抗网络,他自己在1992年提出的PM模型才是。

在给Goodfellow的评审意见中,Jürgen Schmidhuber直接质疑Goodfellow:GAN和PM在许多方面看起来很相似。这两种方法都使用“对抗性”MLP来估计某些概率,并学习编码分布。不同之处在于,新系统学会根据统计独立的随机输入生成非平凡分布,而旧的PM学习生成统计独立的随机输出以响应非平凡分布(通过提取相互独立的因子特征编码分布)。

因此,GAN本质上改变了PM的方向——这是主要的区别吗?GAN应该被称为“反向PM”吗?

最后,无奈之下的Goodfellow只好在论文的最终版本里加入了GAN和PM不同之处的比较,这才有了第一篇GAN论文的诞生。

然而Jürgen Schmidhuber依旧不依不饶,私下里通过邮件跟Goodfellow几番争论。

最激烈的事情发生在2016年。

当时GAN已经在学术界名气日旺,2016年NIPS大会,Goodfellow在现场有个Tutorial,正当他讲到GAN与其他模型相比较时,被一个听众的提问打断了。

这个听众就是Jürgen Schmidhuber。

Jürgen Schmidhuber向Goodfellow提问

Jürgen Schmidhuber的问题很长,大概说了两分钟,主要内容是强调说自己在1992年就已经提出来PM,接着说了一大堆它的原理、实现过程等等,最后图穷匕见:你说说你的GAN和我的PM有没有相似之处?

Goodfellow也不示弱:你说的问题我们之前在邮件里已经交流过很多次了,我也早就公开回应过你了,不想在现在的场合浪费听众的耐心。(掌声)

Ian Goodfellow在2016年NIPS上回应Jürgen Schmidhuber

一位五十多岁的长者试图碾压三十出头的小伙子,但被小伙子反杀,场面一度十分尴尬。

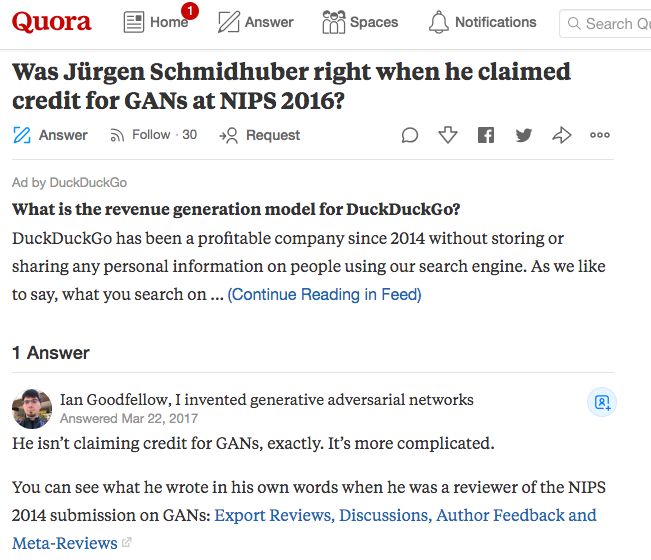

后来,Goodfellow在Quora上海透露,他联系了NIPS的主办方,询问Jürgen Schmidhuber是否有办法向他提出投诉,并由NIPS代表委员会判断Goodfellow的论文是否不公平。但主办方说并没有这样的流程。

除此之外,Jürgen Schmidhuber还提出和Goodfellow一起写合一篇描述PM和GAN之间相同点和不同点的论文,但前提是两人真正能达成一致。现在看起来,这是不太可能了。

Ian Goodfellow是Bengio的得意门生,而在怼Goodfellow之前,Jürgen Schmidhuber已经与Goodfellow的师傅Bengio以及HLB三人组合有过口水战。

2015年5月,Bengio、Hinton和LeCun三位大神联手在Nature上发了一篇review,题目直接就叫《Deep Learning》。此文从传统的机器学习技术讲起,总结了现代机器学习的主要架构和方法,描述了训练多层网络架构的反向传播算法,以及卷积神经网络的诞生,分布式表示和语言处理,以及递归神经网络及其应用等等。

这篇文章堪称是深度学习领域的经典之作,Google学术统计的统计显示,论文被引用数已接近14000次。

从这篇文章的行文风格和内容来看,相当一部分内容是三位作者赖以成名的划时代成就,大有为深度学习“回顾历史、展望未来”的意思,字里行间透露出“盖棺定论”的豪迈之意挡也挡不住。

不过Nature上这篇文章发表后不到一个月,他就在自己的博客上发文,对这篇论文进行了批评。

Schmidhuber在文中表示,这篇文章让他非常不爽,因为全文多次引用三位作者自己的研究成果,而对于其他先驱人物对深度学习更早的贡献则只字不提,比如:

三位作者俨然以AI先驱自居,在参考文献信息中对深度学习之父Alexey GrigorevichIvakhnenko根本提都没提,后者早在1965年就发表了第一篇面向深度网络的通用深度学习算法的论文。1971年的论文中就提出了8层深度神经网络。

文章提到了反向传播(BP),但引用的都是自己的论文,根本没有提到反向传播的发明者和早期开拓者的成果。实际上,最早的反向传播模型诞生于上世纪60-70年代。

关于前馈神经网络,Review说是CIFAR实验室的研究人员2006年努力导致FNN的再度复兴,这里又是在自夸,而且是一种误导。实际上,研究人员已经使用Ivakhnenko几十年了。

文章在提到无监督预训练FNN时还是在引用作者自己的研究,但却没提Schmidhuber本人早在1992-1993年就提出的无监督式预训练RNN,只不过那时候还不叫RNN,但原理和思想是一致的。

在说到非监督学习对深度学习复兴的深远影响时,仍然只引用了作者们自己的成果。

同样,在卷积神经网络一节,文章提到了“池化”,但却没有提及提出最大池化技术的先驱人物等等。

总之,在Schmidhuber这篇文章中认为,今年获得图灵奖的“深度学习三巨头”俨然成了贪他人之功,以为己利的鸡贼、借助江湖地位互相吹捧,压制老前辈的学阀。这一篇文章的操作也真是刚的很。

并且,Schmidhuber还发表过Hinton、LeCun等人出名,是因为背后有谷歌、Facebook这样的大公司在背后做宣传的言论。

后来,LeCun在一封email回复中写道:“Jürgen 对众人的认可过于痴迷,总是说自己没有得到应得的很多东西。几乎是惯性地,他总是在别人每次讲话结束时都要站起来,说刚刚提出的成果有他的功劳,大体上看,这种行为并不合理。”

由此看来,Schmidhuber和三巨头这梁子算是结下了。

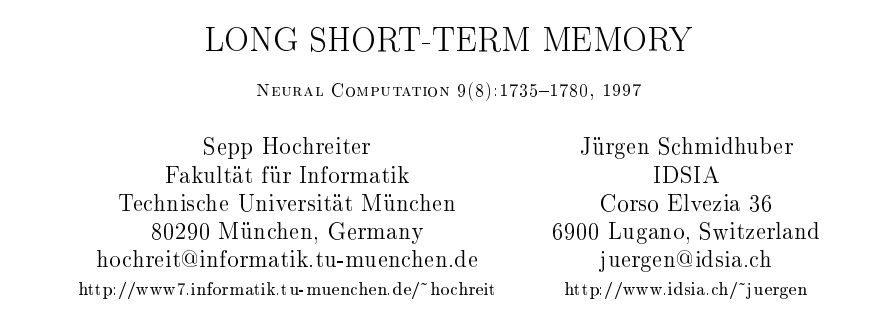

1997年,Jürgen Schmidhuber和Sepp Hochreiter发表了一篇关于一种递归神经网络的论文,就是大名鼎鼎的长短期记忆网络(LSTM)。

2015年,LSTM被用于谷歌智能手机软件中的语音识别新实现。谷歌也使用LSTM作为智能助手Allo和谷歌翻译。后来苹果在iPhone和Siri的“Quicktype”功能中使用了LSTM。Amazon的Alexa也使用了LSTM。在2017年,Facebook每天使用LSTM网络进行约45亿次自动翻译,LSTM可以说是商业化做广泛的AI技术之一。

除了LSTM,2011年Jürgen Schmidhuber还与他的博士后学生在GPU上实现CNN(卷积神经网络)的显著加速,现在这种方法已经成为计算机视觉领域的核心。

当今年的图灵奖公布之后,有不少人认为单纯从贡献上来讲,提出LSTM的Jürgen Schmidhuber也应该获奖。

祝贺三位,当之无愧。但贡献如此显著的Jürgen Schmidhuber被排除在外的还是非常意外和错误的。

京东集团副总裁、加拿大Simon Fraser大学计算科学学院教授、统计与精算系教授、加拿大一级研究讲座教授、ACM Fellow、IEEE Fellow、ACM SIGKDD Chair裴健教授告诉新智元:图灵奖揭晓后,经常有人有疑问,那个谁谁谁对这个方向这个领域也作出了突出贡献,甚至比其中某一位获奖者贡献还大,为什么没有一起获奖?然后就顺理成章的地有各种揣测。

“我个人的理解是,每一届图灵奖是授予一个个人或一个团队,而不是给一个领域相对独立的多位先驱。“The ACM A.M. Turing Award is an annual prize given by the Association for Computing Machinery (ACM) to an individual selected for contributions ‘of lasting and major technical importance to the computer field’.”

图灵奖历史上多次发生过在同一领域独立作出突出贡献的多位科学家和团队陆续获奖的佳话,如计算复杂性理论和数据库理论等都有多位获奖者。

所以,各位看官不要着急,也不要以看宫廷戏的心态看图灵奖。

OpenCV的创造者、AI科学家 Gary Bradski曾评价Schmidhuber:”他是做了很多开创性的工作,但他不是那个使这些成果流行起来的人。这就像最早发现美洲的是维京人,但千古留名的是哥伦布。”

Jürgen Schmidhuber和HLB各有各的成就,但大神们总有相似之处,那就是坚持。

Hinton在上大学时期坚信神经网络是未来,并为此坚持了三十年。

出生于1963年的Jürgen Schmidhuber,在他15岁时就坚信通用人工智能一定会实现,当时那个年代中国刚刚改革开放。

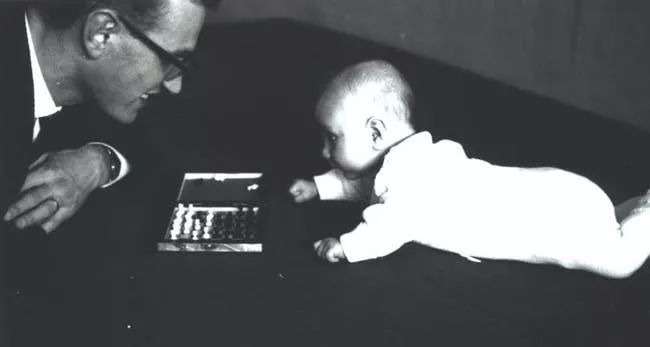

婴儿时期的Jürgen Schmidhuber,左边是他父亲

“作为一个少年,我意识到人们可以做的最重要的事情就是建立一种学会变得比人类聪明的东西。”

Jürgen Schmidhuber在年轻时候曾对他弟弟讲,人类可以一个原子一个原子地重建大脑,可以用铜线代替我们缓慢的神经元作为连接,想象力非常大胆。弟弟刚开始很反对哥哥这套人造大脑可以模仿人类情感和自由意志的观点。但最终,”我意识到他是对的。“

高中毕业后,Schmidhuber从1981年开始学习计算机科学和数学,并在西德军队服役15个月,服兵役时就展现出他特立独行的性格,他不喜欢被人颐指气使,特别是被要求做一些他认为没用的事情。

他的在线简历精心编制了他在学术界的历程,包括诸如“加州理工学院拒绝了他的博士后申请”等等,到现在,Schmidhuber的个人主页也是颇有特色。

Schmidhuber对通用人工智能的追求一直持续了40多年,他还梦想建立一个智能机器劳动的乌托邦,因此在1988年,他捐赠了数百万美元来创建瑞士的Dalle Molle人工智能研究所。它与当地大学的合作,加上政府源源不断的资助,帮助这座小镇变成了人工智能的天堂中心。

《硅谷钢铁侠》的作者在2018年5月写过一篇Jürgen Schmidhuber的特稿,题目是《这个人是AI圈想要忘记的教父》。

这篇文章提到,在大多数学术界之外,Schmidhuber仍然很不为人知。主要是因为学术圈里的同伴不喜欢他,不少同行评价他自私、狡猾,给人带来痛苦。

由于Schmidhuber频繁在学术期刊和会议上怼研究人员,打断他人演讲要求同行承认他们借用甚至窃取了他的想法,后来业内创造了一个动词”Schmidhubered“,谁被别人攻击了就可以用Schmidhubered。

Schmidhuber被边缘化的另一部分原因是因为他的研究所位于阿尔卑斯山,位置孤立,远离科技大公司。

2013年,Schmidhuber还在瑞士创办了一家创业公司Nnaisense,这家公司肩负着实现通用人工智能的使命,并影响到DeepMind。

Nnaisense公司主要成员

DeepMind联合创始人Shane Legg以及首批员工之一Daan Wierstra就是Schmidhuber的学生,他的一些其他博士也加入了DeepMind。

Jürgen Schmidhuber曾说,他从15岁起就决定,创造出比人类更聪明的机器人然后退休,并把这个观点一致保持到了现在。

他认为,拥有自我意识的(self-aware)或“有知觉的机器”(conscious machines)不久就将出现。这个观点更加剧了同行对他的不屑。而对这场辩论需要提出一个问题:人工智能是一个工程学科,还是一场创造新的超智能生物的“造神运动”?

Schmidhuber坚定地站在造神的立场,他认为这些技术的基本概念已经存在,而且人类的意识并不神奇,认为机器的意识将从更强大的计算机和算法中出现,而这些算法与他早已设计好的那些非常接近。

这种信念背后,是他坚定不移的认为:我们生活在《黑客帝国》形式的(Matrix-style)计算机模拟中。

“在我的成长的过程中,我一直追问自己,我能产生的最大的影响是什么?”Schmidhuber 博士回忆道,“这个问题后来变得清楚了,就是我要造出比我自己更聪明的东西,而这个东西又将造出更聪明的东西,如此等等,最终它将掌管并改变整个宇宙,使整个宇宙变得智能。”

今天,他已经不再困惑这样的机器是否会出现,他说,只要计算能力得到大飞跃,很快就会出现。

参考资料:

https://www.bloomberg.com/news/features/2018-05-15/google-amazon-and-facebook-owe-j-rgen-schmidhuber-a-fortune

https://www.quora.com/Was-J%C3%BCrgen-Schmidhuber-right-when-he-claimed-credit-for-GANs-at-NIPS-2016

https://www.inverse.com/article/25521-juergen-schmidhuber-ai-consciousness

【2019新智元 AI 技术峰会精彩回顾】

2019年的3月27日,新智元再汇AI之力,在北京泰富酒店举办AI开年盛典——2019新智元AI技术峰会。峰会以“智能云•芯世界“为主题,聚焦智能云和AI芯片的发展,重塑未来AI世界格局。

同时,新智元将在峰会现场权威发布若干AI白皮书,聚焦产业链的创新活跃,评述AI独角兽影响力,助力中国在世界级的AI竞争中实现超越。

现场精彩回顾:

爱奇艺(全天):

https://live.iqiyi.com/s/19rsj6q75j.html

头条科技(上午):

m.365yg.com/i6672243313506044680/

头条科技(下午):

m.365yg.com/i6672570058826550030/