来,唠个EMNLP会议的嗑

你们的会议百事通又来啦!

今天我们来唠唠将于11月16日至20日举办的EMNLP(Conference on Empirical Methods in Natural Language Processing)会议。

首先,啥也不说,扫码吧!添加“小脉”微信,留言“EMNLP2020加群”。与其他 EMNLP2020 参会者们交流,第一时间掌握 EMNLP2020 前沿动态。

想想都激动!有木有!

Aminer 将实时更新、追踪报道 EMNLP 2020的相关内容。敬请关注!

https://aminer.cn/conf/emnlp2020/papers

EMNLP乃何方神圣也?

EMNLP是由国际语言学会(ACL)下属的 SIGDAT 小组主办的自然语言处理领域的顶级国际会议,每年举办一次。

今年,EMNLP 共收到投稿3114篇,录用754篇,录用率为24.82%。

此外,因为高质量的论文超出了EMNLP会议本身所能容纳的范围,今年EMNLP新增了Findings这一子刊,其将接纳那些未被主会录用但是被程序委员会评价为值得出版的文章,此次会议共接收Findings论文520篇。

EMNLP的过去五年?

小编通过对AMiner平台中EMNLP 2015-2019这五年来收录论文数据的挖掘,从词云可以看出,EMNLP的关键词主要集中在 Neural Machine Translation、Word Embeddings、Entity Recognition、Machine Translation等方向。

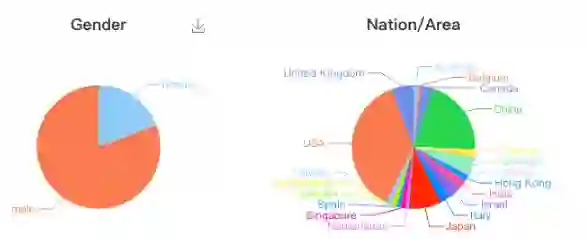

小编又通过对2015-2019这五年来接收论文中所有学者信息的提取,分析了这些学者的性别比例、国籍分布与语言分布情况。

可以看出,EMNLP的投稿学者以男性为主,占比80.84%。

从学者分布情况来看,来自美国和中国的学者一骑绝尘,分别占比36.94%和20.47%。

在过去五年中,EMNLP又有哪些高引论文呢?

TOP 1: Effective Approaches to Attention-based Neural Machine Translation

作者:Thang Luong, Hieu Pham, Christopher D. Manning

被引用:3968

此篇论文聚焦于神经机器翻译任务使用的注意力机制,提出了两种注意力方法:一为全局的注意力机制(global attention),其将attention作用于全部输入序列;二为局部的注意力机制(local attention),其每个时间步将attention作用于输入序列的不同子集。。两种方法相结合可以从不同角度完成源语言特征向量的映射。

TOP 2: A Neural Attention Model for Abstractive Sentence Summarization

作者:Alexander M. Rush, Sumit Chopra, Jason Weston

被引用:1602

此篇论文对生成式自动摘要的实现靠的是一个完全数据驱动的、将神经语言模型与编码器相结合的生成式摘要系统,主要使用Attention+LM构建摘要提取模型。

TOP 3: SQuAD: 100, 000+ Questions for Machine Comprehension of Text

作者:Pranav Rajpurkar, Jian Zhang, Konstantin Lopyrev, Percy Liang

被引用:1569

SQuAD是一个用于机器阅读理解任务的数据集,有超过100,000个根据Wikipedia上提出的问题,问题的答案根据提出问题的相关文章来截取。

TOP 4: A large annotated corpus for learning natural language inference

作者:Samuel R. Bowman, Gabor Angeli, Christopher Potts, Christopher D. Manning

被引用:1323

TOP 5: Document Modeling with Gated Recurrent Neural Network for Sentiment Classification

作者:Duyu Tang, Bing Qin, Ting Liu

被引用:990

TOP 6: Supervised Learning of Universal Sentence Representations from Natural Language Inference Data

作者:Alexis Conneau, Douwe Kiela, Holger Schwenk, Loïc Barrault, Antoine Bordes

被引用:919

TOP 7: Multimodal Compact Bilinear Pooling for Visual Question Answering and Visual Grounding

作者:Akira Fukui, Dong Huk Park, Daylen Yang, Anna Rohrbach, Trevor Darrell, Marcus Rohrbach

被引用:733

TOP 8: Deep Reinforcement Learning for Dialogue Generation

作者:Jiwei Li, Will Monroe, Alan Ritter, Michel Galley, Jianfeng Gao, Dan Jurafsky

被引用:688

TOP 9: A Decomposable Attention Model for Natural Language Inference

作者:Ankur P. Parikh, Oscar Täckström, Dipanjan Das 0001, Jakob Uszkoreit

被引用:681

TOP 10: Attention-based LSTM for Aspect-level Sentiment Classification

作者:Yequan Wang, Minlie Huang, Xiaoyan Zhu, Li Zhao

被引用:673

在过去五年中,EMNLP又有哪些高引作者呢?

来,一起膜拜大神!

排名 |

姓名 |

文章数 |

引用量 |

1 |

Thang Luong |

6 |

8233 |

2 |

Christopher D. Manning |

10 |

6076 |

3 |

Percy Liang |

10 |

2813 |

4 |

Alexander M. Rush |

14 |

2686 |

5 |

Jason Weston |

9 |

2169 |

6 |

Dan Jurafsky |

11 |

1932 |

7 |

Pranav Rajpurkar |

1 |

1853 |

8 |

Jian Zhang |

1 |

1853 |

9 |

Jiwei Li |

6 |

1654 |

10 |

Sumit Chopra |

1 |

1602 |

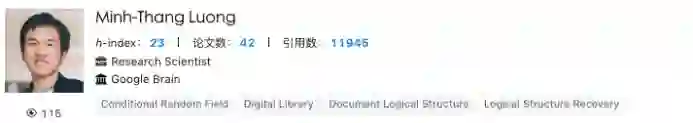

引用量排名第一的Minh-Thang Luong于2016年在斯坦福大学获得计算机博士学位,现于Google Brain担任Research Scientist。

斯坦福大学计算机与语言学教授Christopher Manning引用量排名第二。他是将深度学习应用于自然语言处理领域的领军者,其研究专注于利用机器学习方法处理计算语言学问题,以使计算机能够智能处理、理解并生成人类语言。

引用量排名第三的Percy Liang 现为斯坦福大学计算机系副教授、斯坦福人工智能实验室成员,主要研究方向为自然语言处理(对话系统,语义分析等方向)及机器学习理论。

想更多关于高引学者的信息,请移步EMNLP 会议主页:

https://www.aminer.cn/conference/5eeb1307b5261c744f15bda0?conf=emnlp2020