【资源教程】PyTorch Transformers 教程

【导读】Transformers是神经机器翻译中使用的一种神经网络,它主要涉及将输入序列转换为输出序列的任务。这些任务包括语音识别和文本转换语音。

Transformer中抛弃了传统的CNN和RNN,整个网络结构完全是由Attention机制组成。采用Attention机制的原因是考虑到RNN(或者LSTM,GRU等)的计算限制为是串行的,即RNN相关算法只能从左向右依次计算或者从右向左依次计算,这种机制带来了两个问题:①时间片t的计算依赖t−1时刻的计算结果,这样限制了模型的并行能力。②串行计算的过程中信息会丢失,尽管LSTM等门机制的结构一定程度上缓解了长期依赖的问题,但是对于特别长期的依赖现象,LSTM依旧无能为力。

Transformer的提出解决了上面两个问题,首先它使用了Attention机制,将序列中的任意两个位置之间的距离是缩小为一个常量;然后它使用的不是类似RNN的顺序结构,具有更好的并行性,符合现有的GPU框架。

Introduction

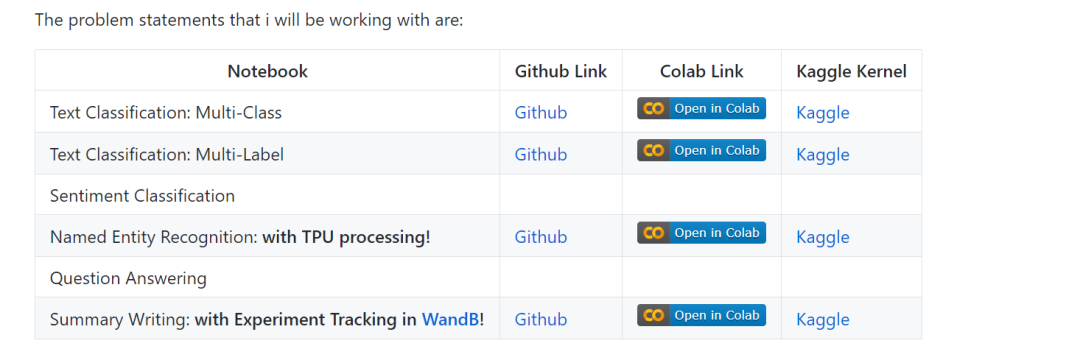

Motivation

Directory Structure

Further Watching/Reading

作者:Abhishek Kumar Mishra

地址连接:

https://github.com/abhimishra91/transformers-tutorials

登录查看更多

相关内容

Arxiv

16+阅读 · 2017年11月20日