春节充电系列:李宏毅2017机器学习课程学习笔记30之集成学习 (Ensemble Learning)

【导读】我们在上一节的内容中已经为大家介绍了台大李宏毅老师的机器学习课程的Recurrent Neural Network。这一节将主要针对讨论Ensemble进行讨论。本文内容主要针对机器学习中Ensemble的bagging、boosting以及stacking进行详细介绍,话不多说,让我们一起学习这些内容吧。

春节充电系列:李宏毅2017机器学习课程学习笔记21之结构化学习(Structured learning)介绍篇

春节充电系列:李宏毅2017机器学习课程学习笔记22之结构化学习(Structured learning)线性模型

春节充电系列:李宏毅2017机器学习课程学习笔记23之结构化学习-Structured SVM(part 1)

春节充电系列:李宏毅2017机器学习课程学习笔记24之结构化学习-Structured SVM(part 2)

春节充电系列:李宏毅2017机器学习课程学习笔记25之结构化学习-序列标注 Sequence Labeling(part 1)

春节充电系列:李宏毅2017机器学习课程学习笔记26之结构化学习-序列标注 Sequence Labeling(part 2)

春节充电系列:李宏毅2017机器学习课程学习笔记27之循环神经网络 Recurrent Neural Network

春节充电系列:李宏毅2017机器学习课程学习笔记28之循环神经网络 Recurrent Neural Network Part2

春节充电系列:李宏毅2017机器学习课程学习笔记29之循环神经网络 Recurrent Neural Network Part3

课件网址:

http://speech.ee.ntu.edu.tw/~tlkagk/courses_ML17_2.html

http://speech.ee.ntu.edu.tw/~tlkagk/courses_ML17.html

视频网址:

https://www.bilibili.com/video/av15889450/index_1.html

李宏毅机器学习笔记30 集成学习(Ensemble Learning)

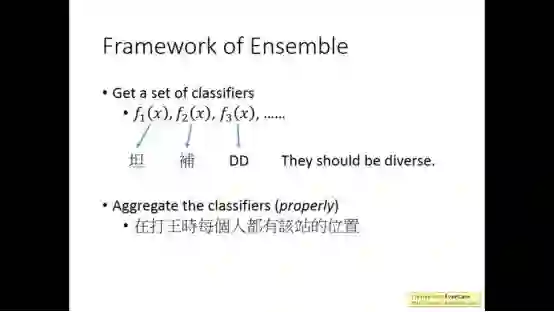

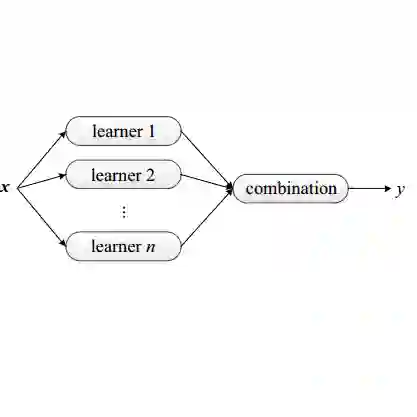

Ensemble的方法是团队合作,简单的来说就是好几个模型一起上的方法

Ensemble通常是最后实在不能提高实验结果然后采用,实验效果会提升一个档次。

相当于群殴的方法

1.bagging

下面讲述ensemble中bagging的内容

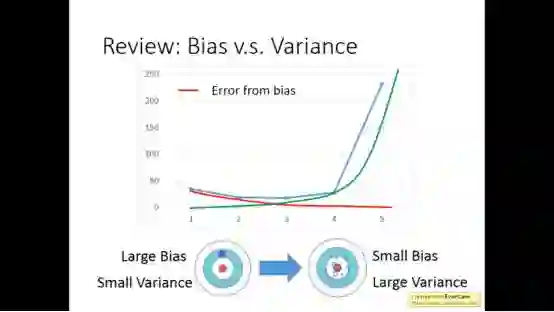

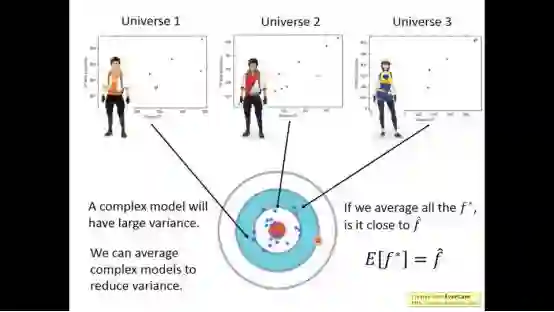

以前我们早已经介绍过小的模型得出的结果一般方差比较小,但偏差比较大。而大的模型得出的结果方差比较大,偏差比较小。

一个复杂的模型是均值很正确,方差很大,但将很多复杂模型平均,结果就是很接近真实的值

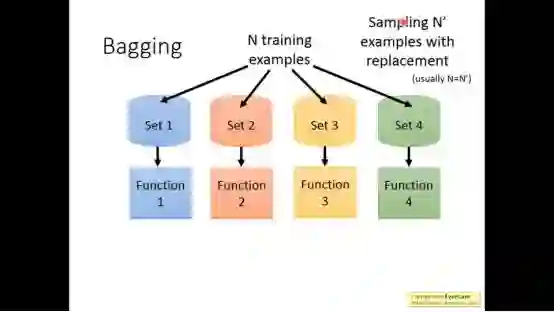

Bagging 制造出不同的dataset进行训练,得到多个不同的模型

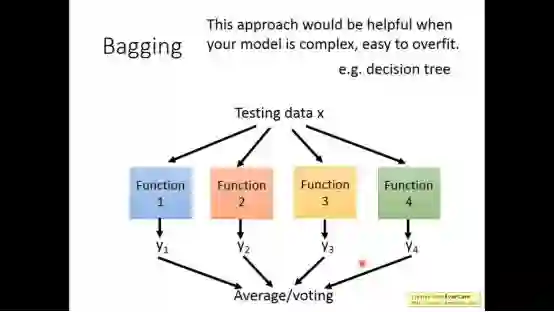

当你的model很复杂的时候,你担心它overfitting,这时候就用bagging

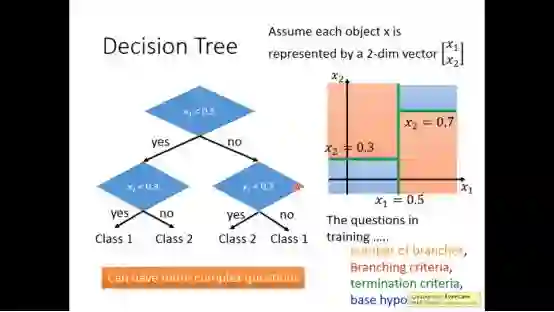

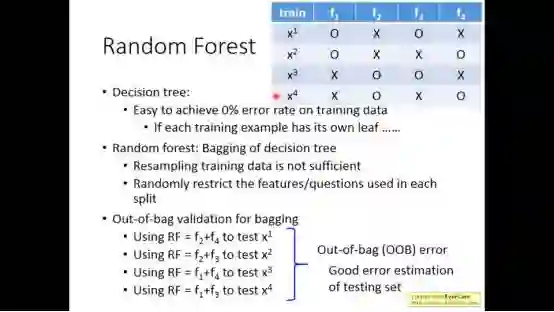

Decision tree就容易overfitting,Random forest就是decision tree做bagging的版本

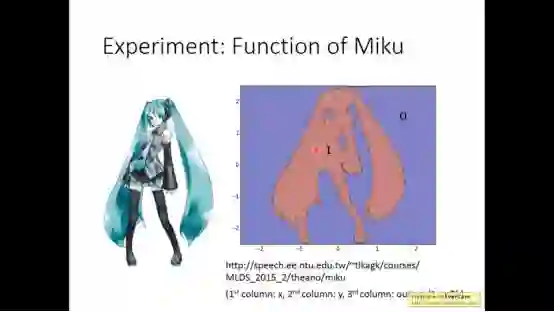

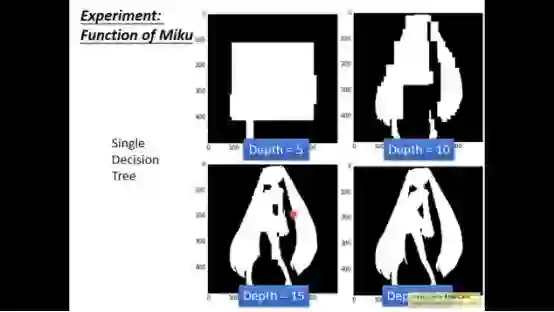

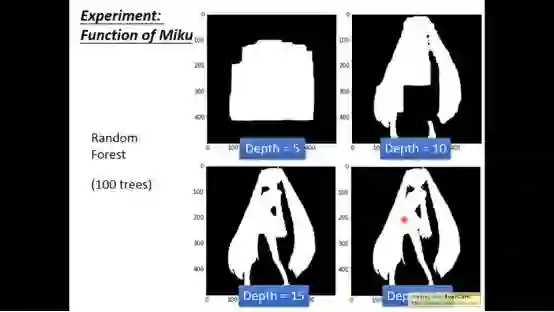

假如我们想要得到一个Miku(初音未来)的模型

树越深,模型越接近

Random forest是在每一次做decision tree的时候,随机决定哪一些feature或者question是不能用的

随着深度越来越深,效果越来越好

2.boosting

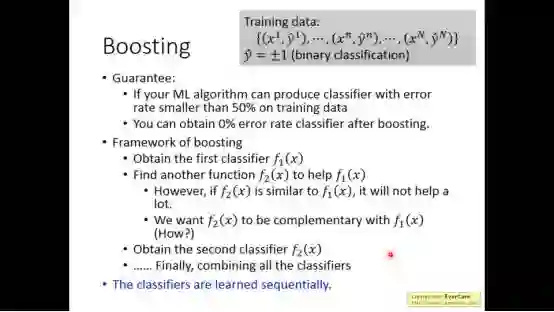

还有一个方法叫做boosting

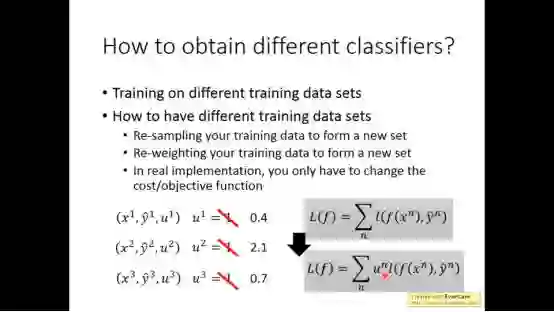

Boosting是在不同的训练集上进行训练,事实上,我们通过改变损失函数来实现这个效果

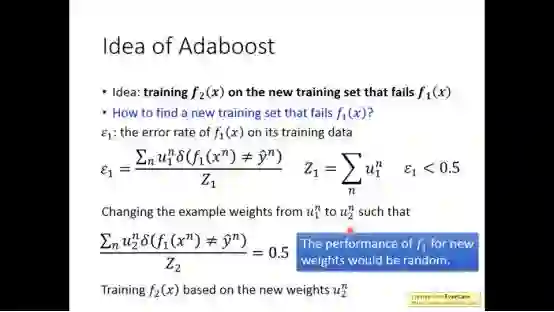

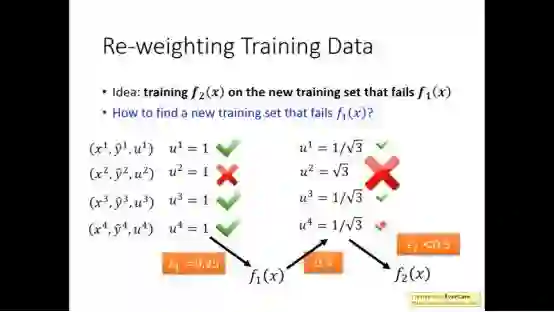

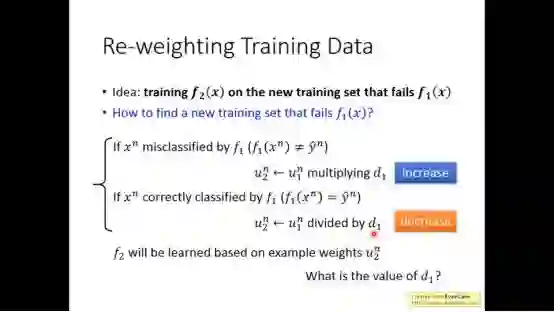

adaboost的思想是f2在能够使得f1失败的训练集上进行训练

大致效果流程去下图所示

调整权重,使得错误的权重大

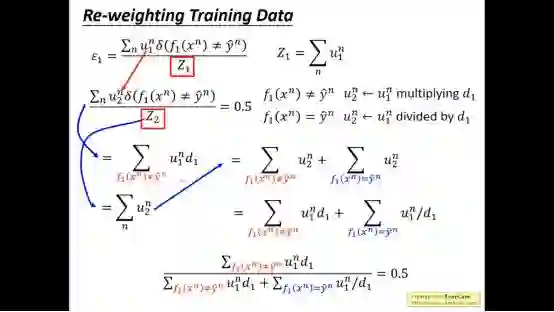

根据以上的算法思想进行计算

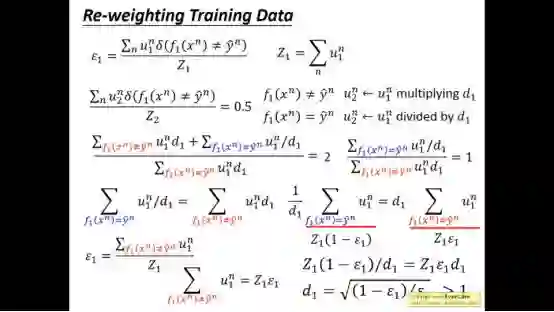

继续化简我们会得到d的值

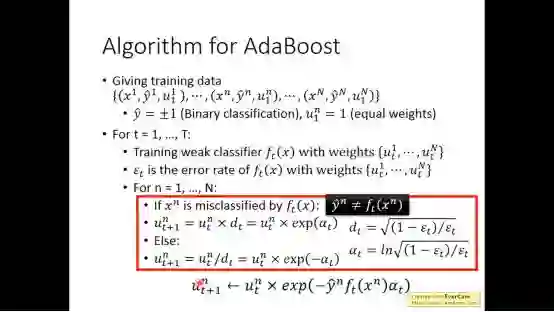

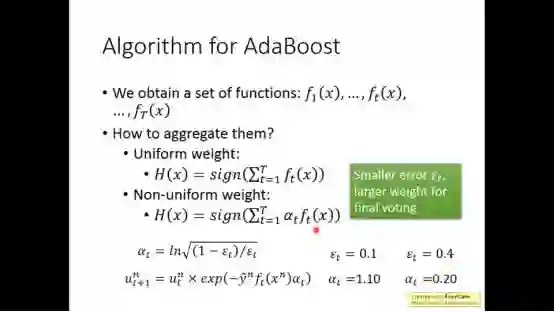

最后整体算法如下图所示

最终我们得到一系列函数,我们需要整合他们

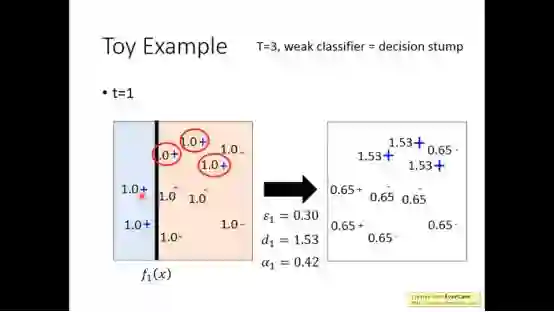

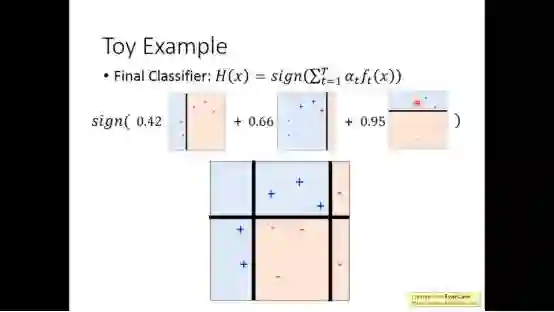

下面是一个具体例子

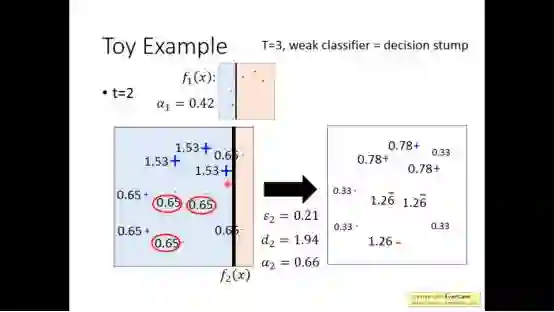

我们依据之前得到的算法进行更新

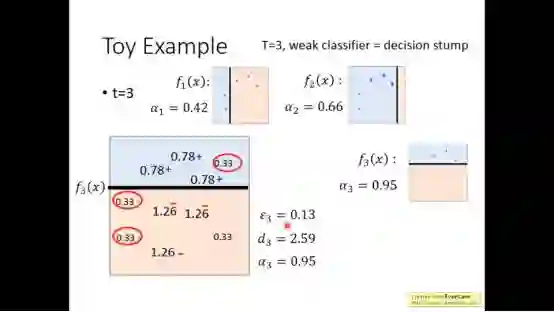

t=3时得到

然后将三个函数整合在一起得到最终结果

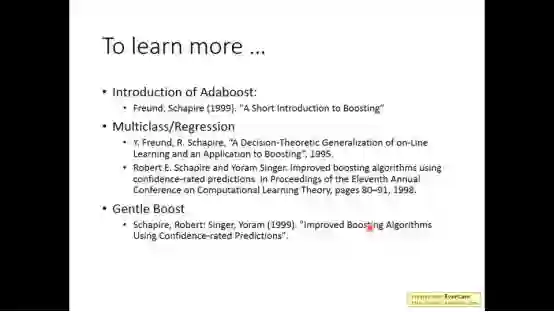

想了解更多可以查阅一下资料

3.stacking

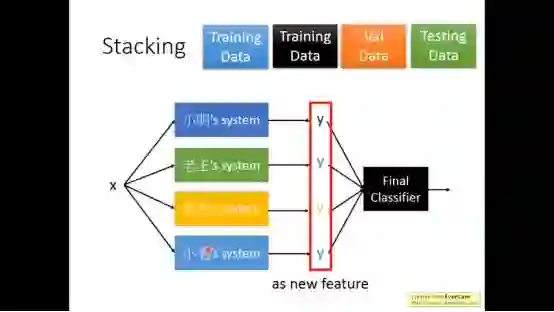

还有一种方法叫做Stacking

简单来说就是把每个model的output当成一个feature,这些model有好有坏,所以整合在一起的时候需要设置权重。

请关注专知公众号(扫一扫最下面专知二维码,或者点击上方蓝色专知),

后台回复“LHY2017” 就可以获取 2017年李宏毅中文机器学习课程下载链接~

-END-

专 · 知

人工智能领域主题知识资料查看获取:【专知荟萃】人工智能领域26个主题知识资料全集(入门/进阶/论文/综述/视频/专家等)

同时欢迎各位用户进行专知投稿,详情请点击:

【诚邀】专知诚挚邀请各位专业者加入AI创作者计划!了解使用专知!

请PC登录www.zhuanzhi.ai或者点击阅读原文,注册登录专知,获取更多AI知识资料!

请扫一扫如下二维码关注我们的公众号,获取人工智能的专业知识!

请加专知小助手微信(Rancho_Fang),加入专知主题人工智能群交流!加入专知主题群(请备注主题类型:AI、NLP、CV、 KG等)交流~

点击“阅读原文”,使用专知!