本文精选 6 篇 浙江大学 AFZT 知识引擎实验室 发表在 ACL 2022、WWW 2022、 WSDM 2022、AAAI 2022 等顶会的知识图谱相关工作,带你快速了解知识图谱领域最新研究进展。欢迎关注实验室公众号「浙大KG」。

# 01.

Deep Reinforcement Learning for Entity Alignment

收录会议:

论文链接:

https://openreview.net/pdf?id=CRBzhRdkycU

代码链接:

https://github.com/guolingbing/RLEA

实体对齐(Entity Alignment)是知识图谱表示学习研究中关键任务之一,其基本目标在于发现两个知识图谱间指向同一现实对象的实体对,以便将不同知识图谱链接起来,更好地支持下游应用。

目前,基于知识图谱嵌入(Knowledge Graph Embedding)的方法,如 MTransE、JAPE,受到了广泛关注,它们提供了一种端到端的、具有强鲁棒性的实体对齐手段。尽管这些方法在性能和效率上相较以往有了显著提升,但它们很少考虑如何根据训练得到的实体嵌入(Entity Embedding)高效地搜寻和评估匹配的实体对,往往只是强行把相似度最高的候选实体直接作为输入实体的匹配,而不考虑该候选实体也许已经找到了更优的匹配。

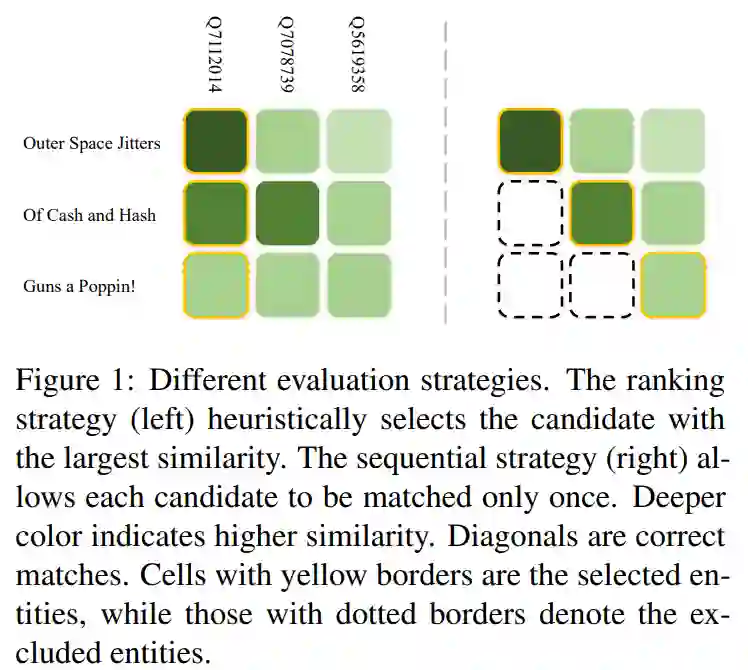

下图中的例子说明了这一现象,对角线对应的为正确匹配,颜色越深则表示两个实体相似度越高。目前主流方法贪心地选择相似度最高的匹配对,如左图所示,将会错误地只选择第一列作为匹配结果。而如果将匹配过程视为一个序列,如右图所示,已经匹配的候选实体不能再被后续输入实体匹配,就能避免落入高相似度陷阱。

1.2 基于强化学习的知识图谱实体对齐

上述序列决策方式尽管能够正确地排除一些候选实体,但也存在着累积错误的风险。因此,本文提出了一种基于强化学习的方法来克服这一缺陷,其并不直接使用实体嵌入的相似度作为判断依据,而是直接把嵌入作为输入,训练一个策略网络(Policy Network)使其能够寻找到尽可能多的实体对,以实现最大回报(Reward)。同时,本文还采用了一种课程学习(Curriculum Learning)的策略,在训练过程中逐步增加难度,避免因任务复杂性而导致学习失败。

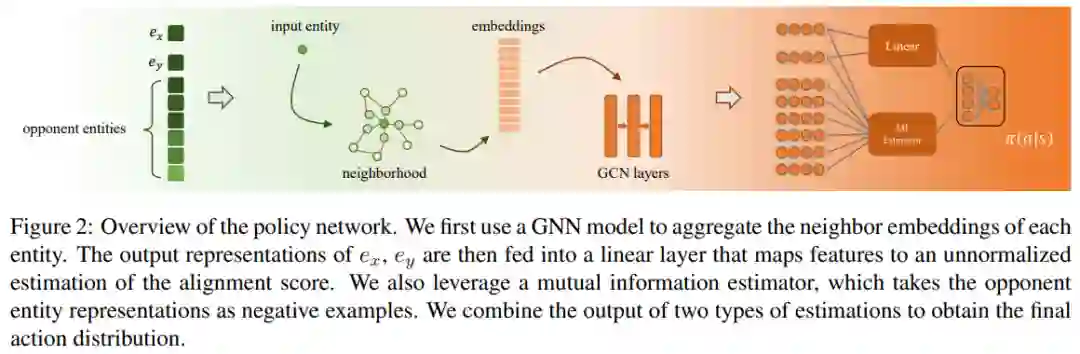

下图展示了策略网络的基本构成,对于输入实体和候选实体,我们选择了额外k个与输入实体接近的实体(即 opponent entities)作为context信息,可以用于拒绝当前匹配。对于每个实体,我们使用GNN模型同时编码其邻居向量以得到中间表示。除了线性层以外,最终的输出层还考虑了实体对间的互信息,综合两个评估器得到最终的输出标签,即匹配或不匹配。

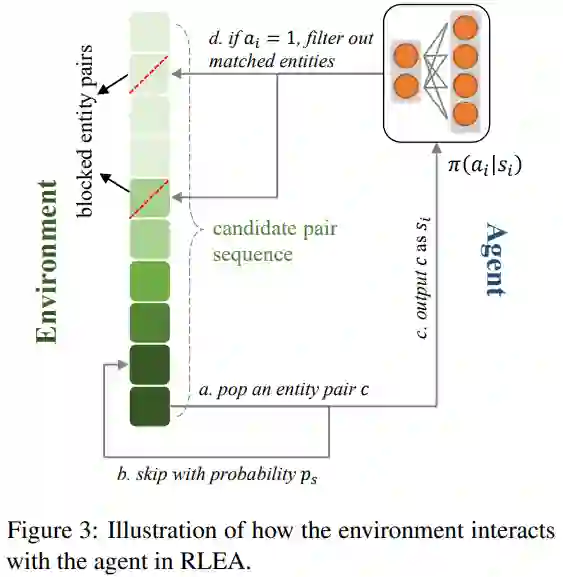

下图中展示了学习过程中,策略网络是如何与环境(Environment)互动的。在环境中维持了一个匹配对序列,其排序方法为实体对间的相似度,以保证在测试阶段该序列仍可用。如前文所述,相似度高的实体对未必真正匹配,因此在训练过程中本文通过对比实际标签与相似度信息来判断一个匹配对的难易程度,根据当前训练轮数,一些较高难度的匹配对将有更大的概率直接逃过训练。在一个情节(Episode)中,环境所给出的实体对将被策略网络一一判断,被认为匹配的实体对将会直接排除环境序列中的所有涉及这些实体的匹配对,这一过程一直持续到序列终止或所有实体均被匹配。

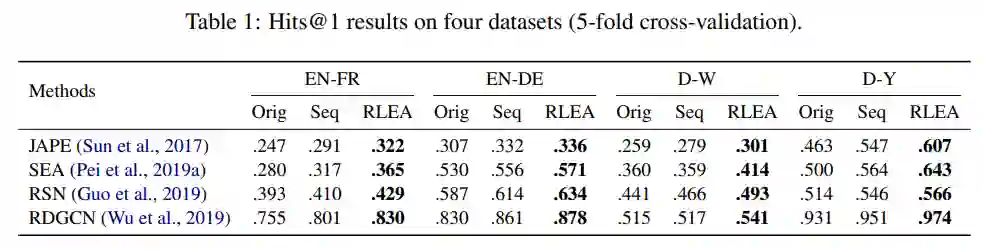

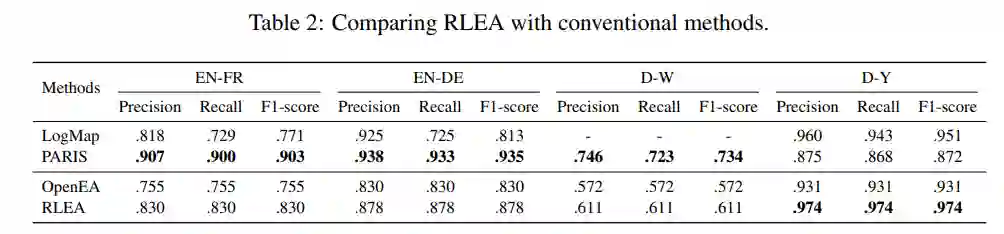

本文选取了数个性能领先且具有不同特点的实体对齐模型作为对比,并在 OpenEA 数据集上进行了实验。结果如下表所示:本文所述方法 RLEA 在全部四种数据集上均相较原有方法有明显提升。Seq 为仅仅采用序列决策而不涉及强化学习的对比方法,可以看出,其仍在绝大多数情况下也优于目前所采用的贪心策略。

同时,本文还与传统实体对齐方法进行了对比。在此之前,尽管基于知识图谱嵌入的方法具有许多优点,但在绝对性能上与基于字符匹配等技术的传统方法有着较大差距。本文所提出的基于强化学习的方法不但缩小了这一差距,并且在一些数据集上(如D-Y)显著优于传统方法。

# 02.

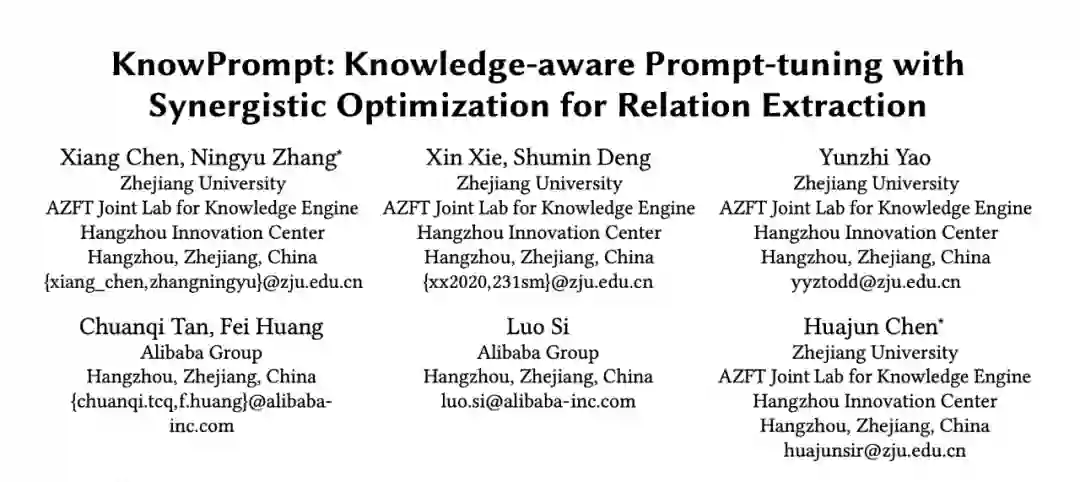

KnowPrompt: Knowledge-aware Prompt-tuning with Synergistic Optimization for Relation Extraction

收录会议:

论文链接:

https://arxiv.org/abs/2104.07650

代码链接:

https://github.com/zjunlp/KnowPrompt

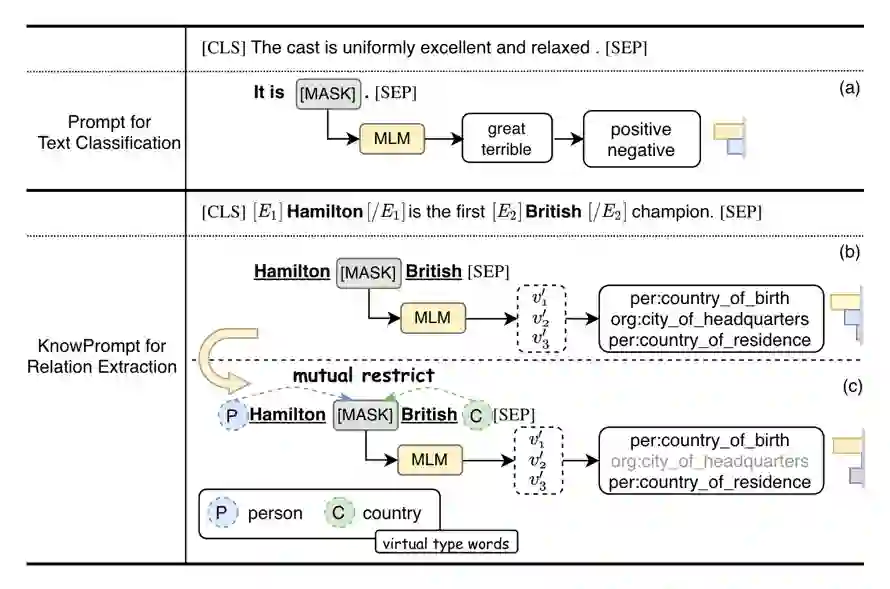

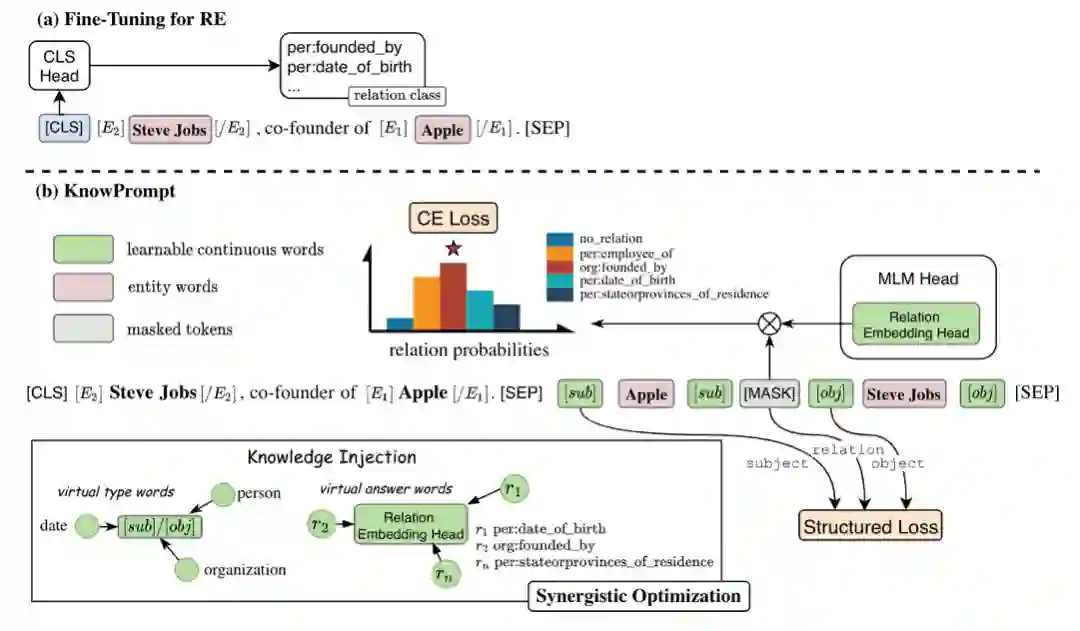

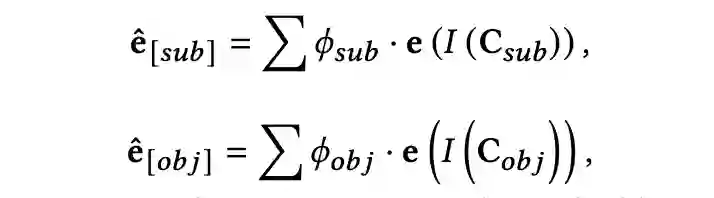

提示学习在具体的任务中面临诸多挑战。以关系抽取(RE)为例,如下图所示:一方面,为关系抽取构建合适的提示模板需要专业的领域知识,且模板需要大量的验证集进行验证,成本高昂;另一方面当关系抽取的标签的个数发生变化时,标签词搜索过程的计算复杂度非常高(通常与类别个数呈指数关联),因此较难在语言模型词汇表中针对特定的关系标签获得合适的标签词。我们观察到,关系标签之间存在丰富的语义知识,即关系三元组之间存在结构约束。例如,如果一对实体包含“person”和“country”的类型,则 [MASK] 在关系“org:city_of_headquarters”上的预测概率会相对较低。此外,关系也约束它的实体的类型。

受此启发,我们将实体关系约束知识植入提示学习过程,并提出了 KnowPrompt 方法。我们通过可学习的虚拟答案词和虚拟类型词构建知识注入的提示,并通过实体关系约束植入外部结构化知识,以降低模板构建成本并提升任务对领域任务的感知。

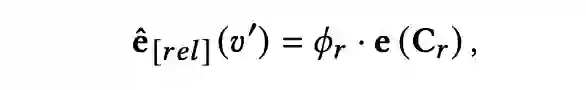

2.3 实验

为了验证 KnowPrompt 的效果,我们在五个常见的关系抽取数据集上评测(具体的数据已在 Github 开源发布),并在全监督和少样本两个设定下进行了实验。如下表所示,KnowPrompt 在全监督场景和低资源少样本场景都取得了最优的性能。具体的实验结果和分析可以参见论文。

#03.

“知识提示”学习之选择性知识植入

Ontology-enhanced Prompt-tuning for Few-shot Learning

收录会议:

论文链接:

https://arxiv.org/pdf/2201.11332.pdf

近年来,不少知识植入预训练语言模型的方法被提出,然而并非所有的外部知识都有利于模型性能的提升,不少外部知识会带来噪音并损害模型性能。针对提示学习,如何在植入外部知识过程中选择任务需要的合规、合适、合理的外部知识,并解决知识噪音和知识异构性仍面临一定的挑战。比如,在模板构建中,是否所有的外部提示语料和外部领域词典都有利于知识提示的性能提升?如何高效地选择合适的任务相关的知识并优化学习知识表示?

在本文中,我们针对上述挑战,提出了基于本体增强的知识提示方法,并通过知识线性化和选择性植入来降低知识噪音和异构性带来的影响。

具体的说,我们利用任务相关的外部本体知识,将本体知识线性化成文本来作为一种特殊的提示,提出了本体增强知识提示方法 OntoPrompt。一种直觉是,预训练语言模型可以从大数据中获取大量的统计信息;而外部知识,如知识图谱和本体库,是人类智慧结晶。如下图所示,本体增强的知识提示学习,可以充分利用大数据先验和人类的智慧结晶。接下来我们介绍方法的细节。

我们的方法是一个通用的框架。如图所示,我们遵循之前的提示学习思路,使用特定的任务提示模板来构建任务输入和生成。提示模板构建如下公式所示:

模型可以得到候选类的概率分布为:

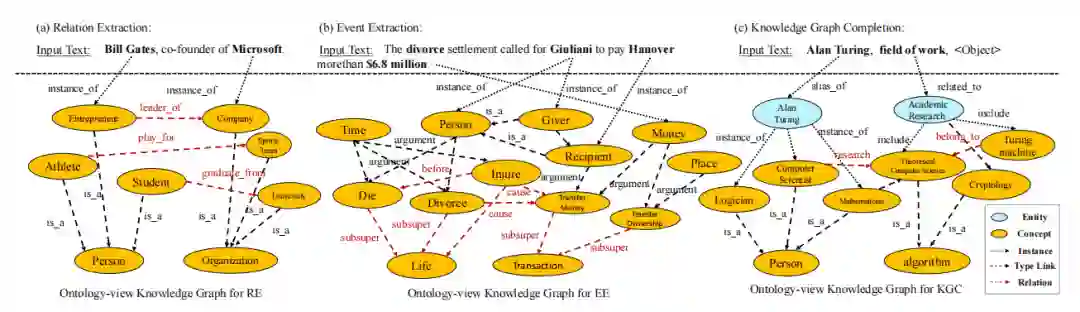

我们的方法将外部的知识以文本形式植入提示学习框架中,以实现模型对任务和领域的感知具体的输入如下图所示:

3.2.1 知识线性转换

在本文中,外部的本体知识表示为 O={C,E,D},其中 C 是一组概念,E 是本体论之间的边,D 是每个本体知识的文本描(本体框架包含一段文本描述,它们是概念的词汇信息,也可以使用属性信息,记作 rdfs:comment)。我们在关系抽取和事件抽取中利用与实体相关的类型本体,在知识图补全中利用 Domain(即头部实体类型)和 Range(即尾部实体类型)约束。对于下游不同任务,我们对每个任务利用不同的本体源进行本体线性化转换。我们首先从外部知识图谱中提取每个实例的本体,然后将这些本体转换为文本形式作为辅助提示,并拼接到原始的提示末尾。

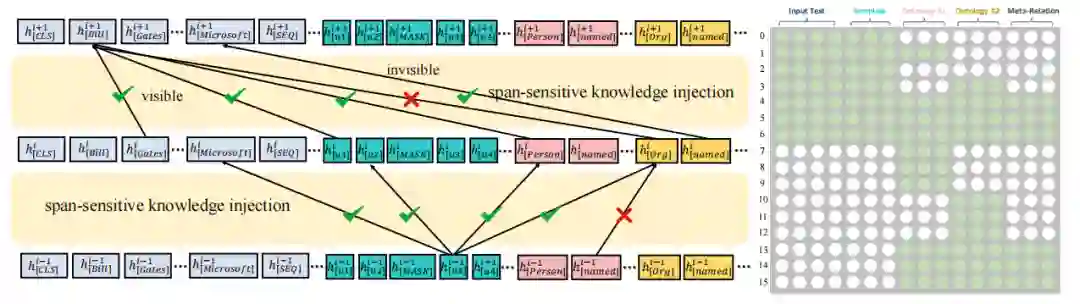

由于不加选择的知识植入可能会给原始文本引入一些噪声,并导致性能下降。为了解决这一问题,受到 K-BERT 启发,我们提出了跨片段选择性知识植入方法。如下图所示。我们使用一个可见矩阵来限制知识注入对输入文本的影响。在语言模型体系结构中,我们在 softmax 层之前添加了具有自注意权重的注意掩码矩阵。

由于从本体库植入的知识应与输入文本序列相关联。因此,我们使用联合优化方法来学习外部的本体序列表示和输入文本序列的表示。首先,我们使用实体词嵌入来初始化和优化本体词令牌,同时固定语言模型中的其他参数。然后,我们对模型的所有参数进行优化。

我们在关系抽取、事件抽取、知识图谱链接预测三个任务上验证了模型的性能。在多个数据集包含 TACRED-Revisit、SemEval-2010Task8、Wiki80、DialogRE、ACE2005、UMLS、WN18RR、FB15K-237,我们的方法在少样本设定下均取得了较好的效果。囿于篇幅原因,具体的实验结果可查阅正式论文。

#04.

基于知识图谱蒸馏的低成本推理

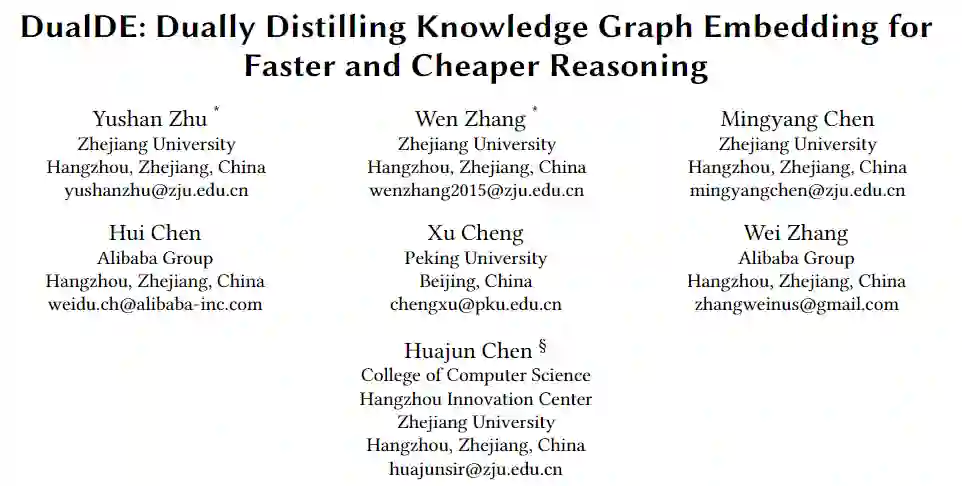

DualDE: Dually Distilling Knowledge Graph Embedding for Faster and Cheaper Reasoning

收录会议:

论文链接:

https://arxiv.org/pdf/2009.05912.pdf

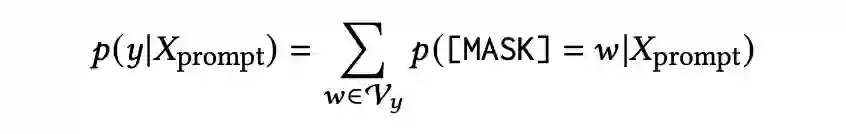

知识图谱(Knowledge Graph)由以表示事实的三元组形式(头实体,关系,尾实体)组成,可简写为 (h,r,t)。知识图谱已被证明可用于各种 AI 任务,如语义搜索,信息提取和问答等。然而众所周知,知识图谱还远非完备,这进而也促进了许多关于知识图谱完备性的研究。其中比较常见且广泛使用的方法是知识图谱嵌入(KGE Knowledge Graph Embedding),如 TransE、ComplEx 和 RotatE 等。同时,为了获得更好的性能,通常首选训练具有更高维度的 KGE。

但是模型大小(参数的数量)以及推理时间的成本通常随 embedding 维度的增加而快速增加,如图 1 所示:随着 embedding 维度的增大,性能增益越来越小,而模型大小和推理成本却仍几乎保持线性增长。此外,高维 KGE 在许多现实场景中是不切实际的,尤其是对于计算资源有限或者是在推理时间有限的应用中,低维的 KGE 是必不可少的。然而,直接训练一个小尺寸 KGE 通常表现不佳,我们进一步提出一个新的研究问题:是否有可能从预训练的高维 KGE 中获得低维 KGE,在更快成本更低的情况下取得良好的效果。

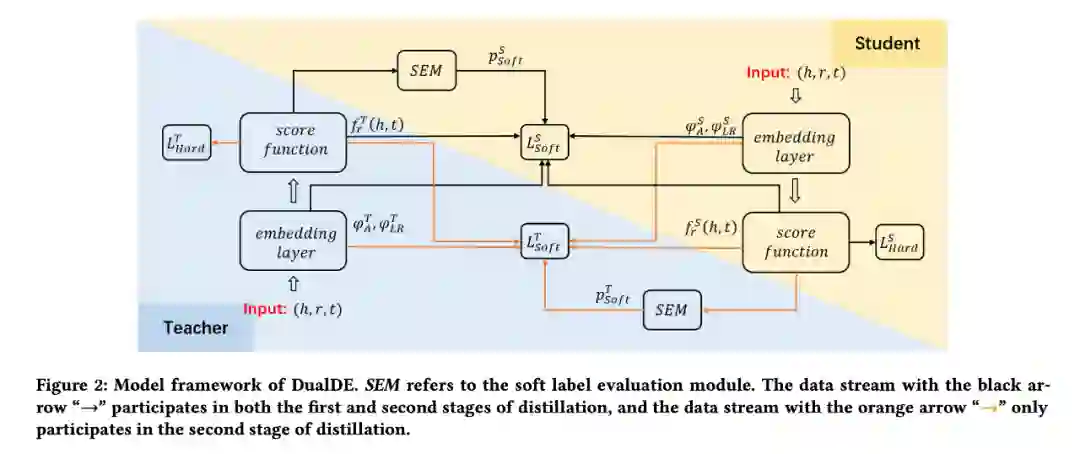

知识蒸馏是一种广泛使用的技术,用于从大模型(教师模型)中学习知识以构建较小的模型(学生模型)。学生从真实标签和老师模型中的软标签这二者中学习。在本项工作中,我们提出了一种名为 DualDE 的新型 KGE 蒸馏方法,该方法能够将高维 KGE 蒸馏提取出较小的嵌入尺寸,而精度损失很小或没有损失。在DualDE中,我们考虑了老师和学生之间的双重影响:1)教师对学生的影响;2)学生对教师的影响。

在老师对学生的影响方面,众所周知,老师模型输出的软标签会对学生产生影响。虽然在之前的许多蒸馏工作中,所有样本都具有相同的硬标签和软标签权重,但它们并没有从老师模型那里区分不同样本的软标签的质量的能力。

事实上,KGE 方法对不同三元组的掌握程度是不同的。对于一些难以被 KGE 方法掌握三元组,他们通常难以获得可靠的分数。让学生按照不可靠的分数模仿老师,会给学生模型带来负面影响。为了获得更好的蒸馏效果,我们建议学生应该能够评估老师提供的软标签的质量并且有选择地向他们学习,而非一视同仁地学习。我们在 DualDE 中引入了软标签评估机制来评估老师提供地软标签质量,并自适应地为不同地三元组分配不同的软标签和硬标签权重,这将保留高质量软标签的积极作用并避免低质量软标签的负面影响。

在学生对老师的影响方面,以前的工作研究得并不充分。已有工作证明了蒸馏的整体表现还取决于学生对老师得接受程度。我们希望根据学生目前的学习情况不断调整老师,让老师更能被学生接受,提高最终的提炼效果。因此,我们在 DualDE 中提出了一种两阶段的蒸馏方法,通过根据学生的输出调整教师来提高学生对教师的接受度。其基本思想是,尽管预训练的老师已经很强了,但对于现在的学生来说,可能不是最适合的。还有相关工作指出,与学生具有相似输出分布的教师更有利于学生的学习。因此,除了教师始终保持静止的标准蒸馏阶段外,我们还设计了第二阶段蒸馏,其中教师解冻并尝试反向向学生学习,以使其更容易被学生接受。

我们使用几个典型的 KGE 方法和标准 KG 数据集评估 DualDE。结果证明了我们方法的有效性。本文的贡献有三方面:

1. 我们提出了一种新颖的框架,能从高维 KGE 中提取低维 KGE,并取得良好的性能;

2. 我们在蒸馏过程中考虑了教师和学生之间的双重影响,并提出了软标签评估机制来区分不同三元组的软标签的质量和两阶段蒸馏以提高学生对老师的适应性;

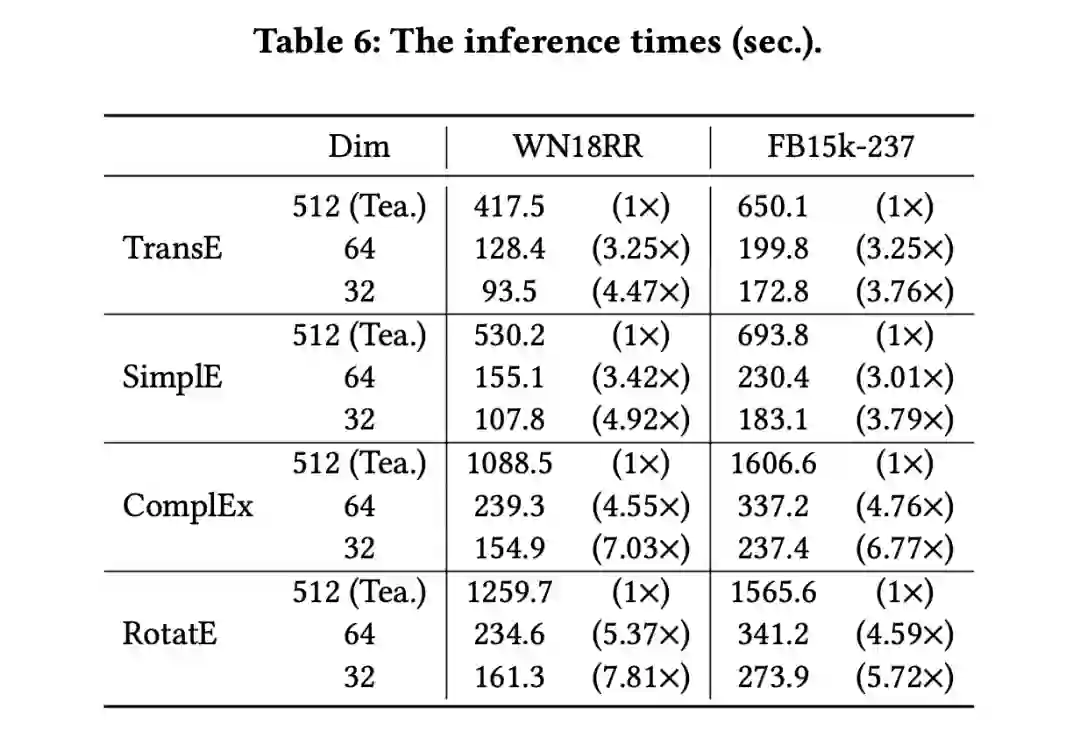

3. 我们通过实验证明,我们的方案可以在很少的性能损失基础上,将高维 KGE 的嵌入参数减少 7-15 倍,并将推理速度提高约 2-6 倍。

4.2 方法

蒸馏目标

准备一个预训练好的高维 KGE 模型(教师),并随机初始化一个低维 KGE 模型(学生)。在 DualDE 中,训练学生模型的硬标签损失是KGE方法的原始损失,通常是二元交叉熵损失。此外,我们让学生从目标三元组的整体可信度和嵌入结构这两个方面模仿教师。

首先,对一个三元组 (h, r, t),教师和学生模型可以通过评分函数为其分配一个分数:1)学生模仿教师对三元组的整体可信度可以通过拟合两个模型输出的三元组分数完成;2)学生模仿教师的嵌入结构可以通过拟合两个模型中三元组头实体 embedding 和尾实体 embedding 的长度比和角度来反映。最后我们将教师和学生的三元组分数差异和嵌入结构差异之和作为软标签优化目标。

软标签评估机制可评估教师提供的软标签的质量,并自适应地为不同的三元组分配不同的软标签和硬标签权重,从而保留高质量软标签的积极作用,避免低质量软标签的负面影响。

理论上,KGE 模型会给正三元组更高的分数,给负三元组更低的分数,但对于一些 KGE 模型难以掌握的三元组则相反。具体来说,如果教师给一个负(正)三元组打高(低)分,这意味着教师倾向于将其判断为正(负)三元组,那么教师输出的这个三元组的软标签是不可靠的,甚至会误导学生。对于这个三元组,我们需要削弱软标签的权重,鼓励学生更多地从硬标签中学习。

上一部分介绍了如何让学生从 KGE 教师那里提取知识,其中学生用硬标签训练,软标签由固定教师生成。为了获得更好的学生,我们提出了一种两阶段蒸馏方法,通过解冻教师并让其在蒸馏的第二阶段向学生学习来提高学生对教师的接受度。

第一阶段。第一阶段类似于传统的知识蒸馏方法,其中教师在培训学生时保持不变。第二阶段。在第二阶段调整教师的同时,对于那些学生没有掌握好的三元组,我们也希望减少学生的输出对教师的负面影响,让教师更多从硬标签中学习,从而以保持教师的高准确性。因此,我们也将软标签评估机制应用于教师的调整。通过评估学生给每个三元组的分数,教师的硬标签和软标签的权重被自适应分配。在此阶段,教师和学生一起优化。

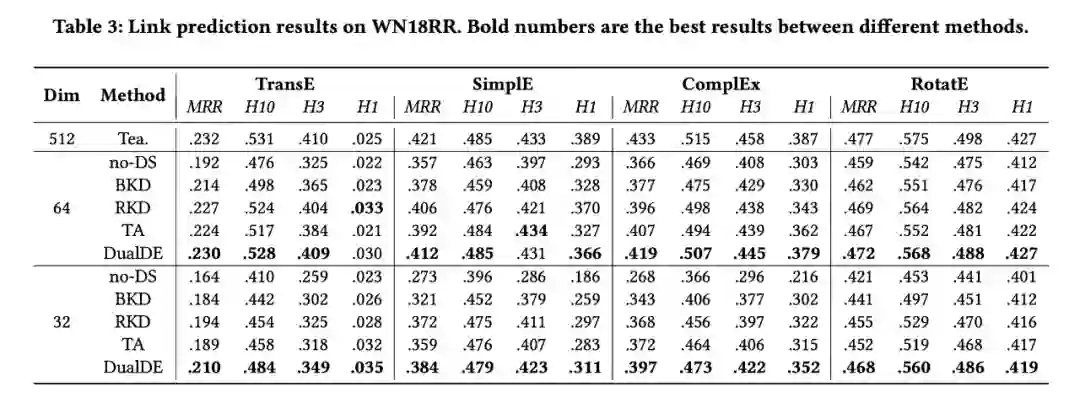

4.3 实验结果

DualDE 在常用地数据集 WN18RR 和 FB15K237 上进行了实验,与几个当前先进的蒸馏方法相比,DualDE 体现了优越的性能。下面是部分实验结果。

1. DualDE 提取的低维 KGE 比直接训练的相同大小的 KGE 性能好得多,仅比原始高维 KGE 差一点或相同性能。

2. DualDE 提取的低维 KGEs 推理速度明显快于原始高维 KGEs。

#05.

针对事件论元抽取学会高效地提问

Learning to Ask for Data-Efficient Event Argument Extraction

收录会议:

论文链接:

https://arxiv.org/abs/2110.00479

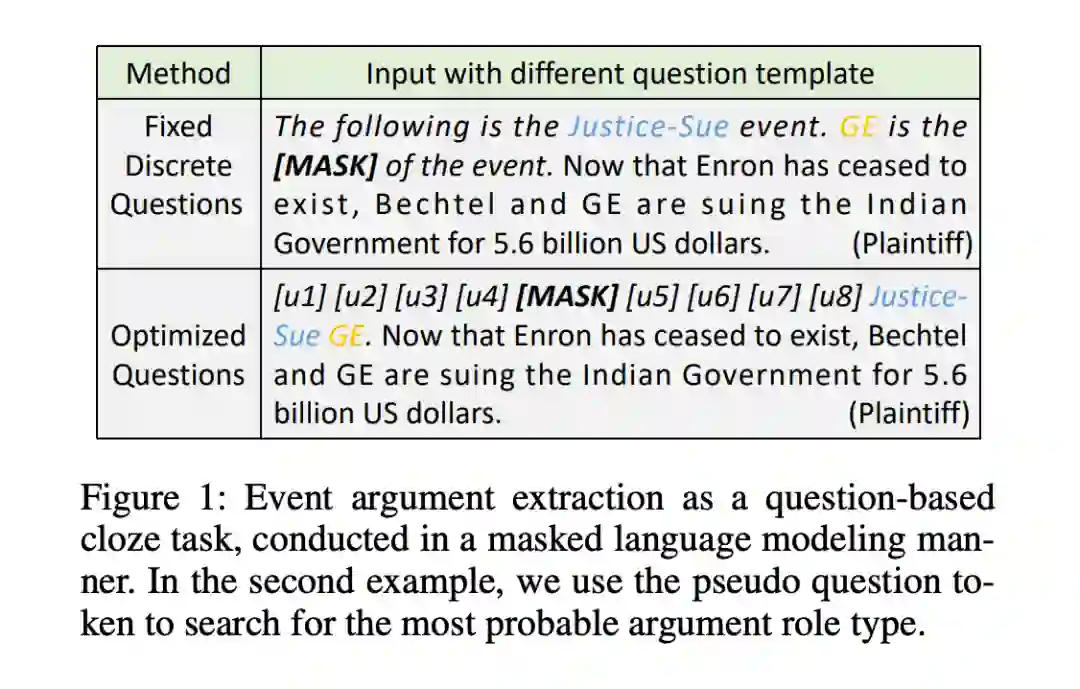

事件参数抽取 (EAE) 是信息抽取时发现特定事件角色参数的重要任务。在本研究中,我们将 EAE 转换为一个基于问题的完形填空任务,并对固定离散标记模板性能进行实证分析。由于生成人工注释的问题模板通常是耗时且耗费劳动,我们进一步提出了一种名为“Learning to Ask”的新方法,该方法可以在无需人工注释的情况下学习 EAE 的优化问题模板。我们使用 ACE-2005 数据集进行实验,结果表明我们基于优化提问的方法在 few-shot 和全监督设定中都取得了最先进的性能。

事件参数提取 (EAE) 是信息提取中的一项重要而具有挑战性的任务,它的目的是发现事件中每个参数的特定角色类型。例如,考虑到“ declared bankruptcy”一词在“ My uncle declared bankruptcy in 2003 and his case closed in June 2004”中引发了宣布破产事件,EAE 旨在确定“ My uncle”在这句话中的事件角色参数,它的角色参数是“Org”。以前的 EAE 方法严重依赖于使用大量的训练数据,导致在少量数据可用的场景中难以使用传统方法。

受启发于最近的工作,事件提取 (EE) 作为一种机器阅读理解问题 (MRC) 被重新引入,在这个范式中,问题模板被用于将输入句子映射到一个合适的序列。然而对于 EAE,这些方法仍然需要优化一个额外的参数矩阵来进行分类,当可用的数据量有限时,这尤其具有挑战性。因此为了弥补微调和预训练之间的差距,我们做了一个尝试,将 EAE 转换为一个基于问题模板的完形填空任务。我们选择使用陈述性句子作为问题模板,因为它们可以提高跨上下文的语义一致性,提高预测性能。

由于不同的提问策略会对事件提取方法的性能产生不同的影响,我们提出了一种新颖的 Learning to Ask (L2A) 方法,通过反向传播优化问题模板,可以在连续嵌入空间中自动搜索最佳的伪问题令牌。如图 1 所示,我们将一个问题与输入的句子连接起来,并利用 [MASK] 来指示后续预测的事件类型。从而事件参数提取作为一种基于问题模板的完形填空任务,以掩码语言建模的方式进行。在第二个优化模板的例子中,我们使用伪问题令牌来搜索最可能的事件参数角色类型。

我们的 L2A 框架依赖于问题模板,该模板将一个输入句子映射到一个标准 transformer 输入序列:[CLS]question[SEP]sentence[SEP]。对于问题的模板构建,我们引入了两种不同的策略:

1. L2A (base):输入文本的人工问题模板,它用 [mask] 替换参数角色的令牌,并在问题模板中添加必要的提示信息,如事件类型和参数跨度标记。

2. L2A (pseudo):由于人工提示问题模板是劳动密集型的,并且可能导致EAE性能次优,因此我们进一步引入了问题模板的自动构造方法。具体来说,我们使用几个未使用的标记 [u1]-[u8] 来形成一个伪问题模板,并固定语言模型的其他权重来学习优化的问题模板。 由于参数角色标签包含语义信息,所以我们可以将 EAE 中的标签映射简化为单射函数。例如,我们可以定义投射到”Transaction.Transfer-Money”的函数为:

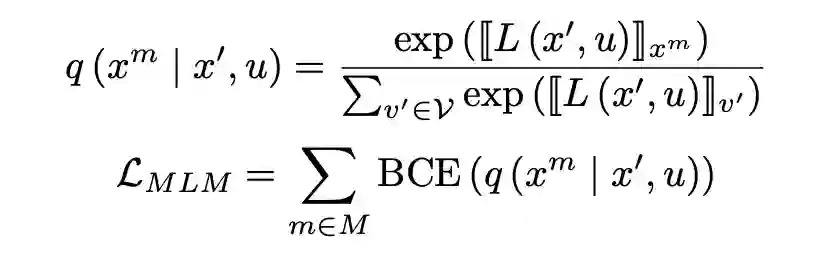

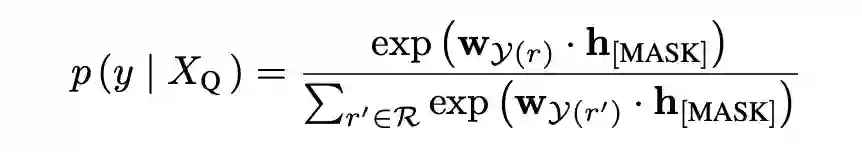

我们将事件角色的单个标记的词汇表分布规范化,并将预测概率定义为:

其中

为对应于 [MASK] 位置的隐藏向量。接着,我们使用交叉熵损失将事件角色预测定义为:

其中

为 EAE 损失,

为交叉熵损失函数。为了使输入文本更接近自然语言,我们利用了一个辅助优化对象。我们随机掩蔽句子中的其他标记,并进行掩蔽语言模型预测如下:

其中 u 表示问题格式输入序列,

为随机掩码的原始标记 x,x’ 表示掩码处理后的输入句子,

为二进制交叉熵损失函数。最后,我们优化以下对象:

#06.

融入基因本体知识的蛋白质预训练

OntoProtein: Protein Pretraining With Gene Ontology Embedding

收录会议:

论文链接:

https://arxiv.org/pdf/2201.11147.pdf

代码链接:

https://github.com/zjunlp/OntoProtein

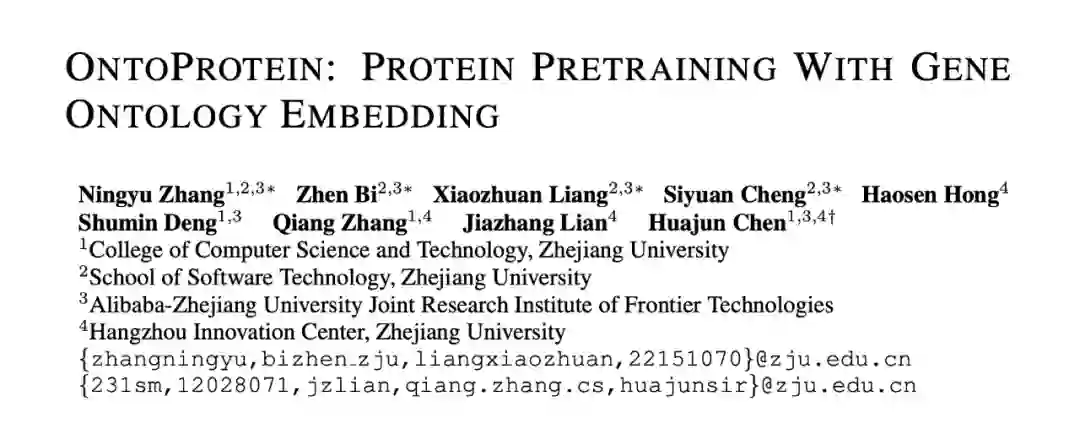

近年来,预训练模型以强大的算法效果,席卷了自然语言处理为代表的各大 AI 榜单与测试数据集。与自然语言类似,蛋白质的一级结构具有序列特性,这为将语言预训练模型引入蛋白质表示提供了有利条件。然而,蛋白质本质上不同于自然语言文本,其包含了大量预训练目标较难习得的生物学知识。事实上,人类科学家已经积累了海量的关于蛋白质结构功能的生物学知识。那么如何利用这些知识促进蛋白质预训练呢?本文将介绍被 ICLR 2022 录用的新工作: OntoProtein,其提出一种新颖的融入知识图谱的蛋白质预训练方法。

蛋白质是控制生物和生命本身的基本大分子,对蛋白质的研究有助于理解人类健康和发展疾病疗法。蛋白质包含一级结构,二级结构和三级结构,其中一级结构与语言具有相似的序列特性。受到自然语言处理预训练模型的启发,诸多蛋白质预训练模型和工具被提出,包括 MSA Transformer、ProtTrans、悟道 · 文溯、百度的 PaddleHelix 等。

大规模无监督蛋白质预训练甚至可以从训练语料中习得一定程度的蛋白质结构和功能。然而,蛋白质本质上不同于自然语言文本,其包含了诸多生物学特有的知识,较难直接通过预训练目标习得,且会受到数据分布影响低频长尾的蛋白质表示。为了解决这些问题,我们利用人类科学家积累的关于蛋白质结构功能的海量生物知识,首次提出融合知识图谱的蛋白质预训练方法。下面首先介绍知识图谱构建的方法。

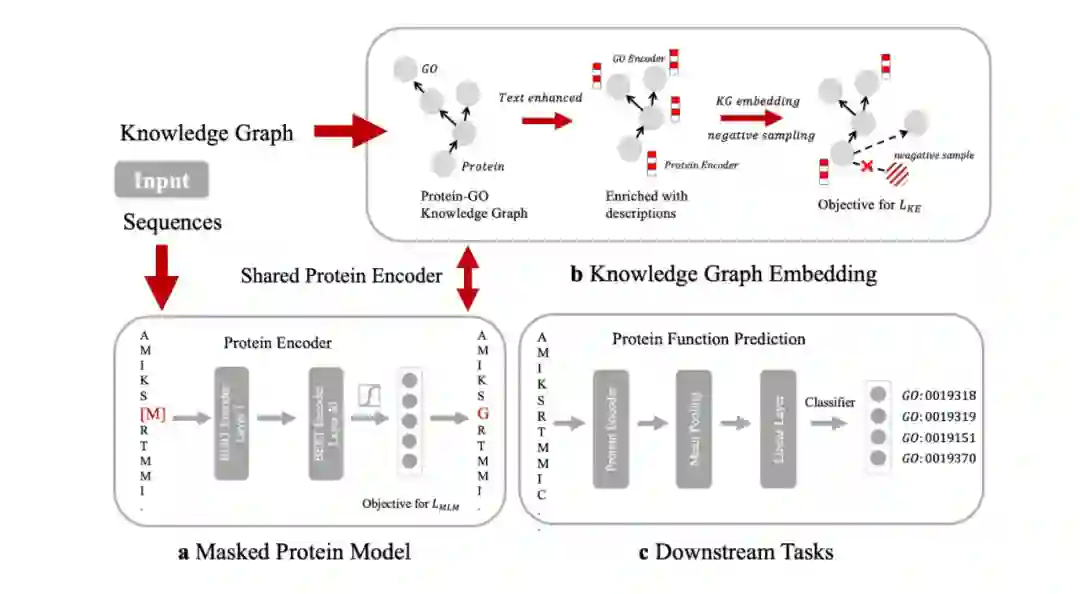

我们通过访问公开的基因本体知识图谱“Gene Ontology(简称 Go)”,并将其和来自 Swiss-Prot 数据库的蛋白质序列对齐,来构建用于预训练的知识图谱 ProteinKG25,该知识图谱包含 4,990,097 个三元组,其中 4,879,951 个蛋白质-Go 的三元组,110,146 个 Go-Go 三元组,并已全部开放供社区使用。如下图所示,基于“结构决定功能”的思想,如果在蛋白质预训练过程中显式地告诉模型什么样的结构具备什么样的功能,显然能够促进如蛋白质功能预测、蛋白质交互预测等任务的效果。

6.4 融入基因知识图谱的蛋白质预训练

基于构建好的知识图谱,我们设计了一个特殊的蛋白质预训练模型 OntoProtein。注意到在预训练输入中包含两种不同的序列:蛋白质序列和描述蛋白质功能、生物过程等的文本描述信息。因此,我们采取两路不同的编码器。对蛋白质序列我们采用已有的蛋白质预训练模型 ProtBert 进行编码,对文本序列我们采用 BERT 进行编码。

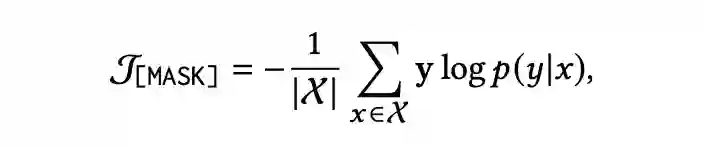

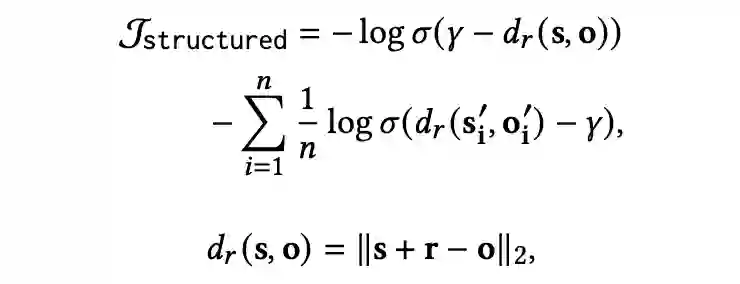

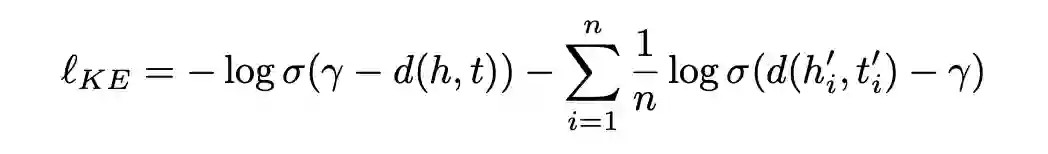

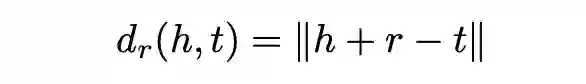

为了更好地进行预训练和融合三元组知识信息,我们采用了两个优化目标。首先是传统的掩码语言模型目标,我们通过随机 Mask 序列中的一个 Token 并预测该 Token。其次是三元组知识增强目标,我们通过类似知识图谱嵌入学习的方式来植入生物学三元组知识,如下公式所示:

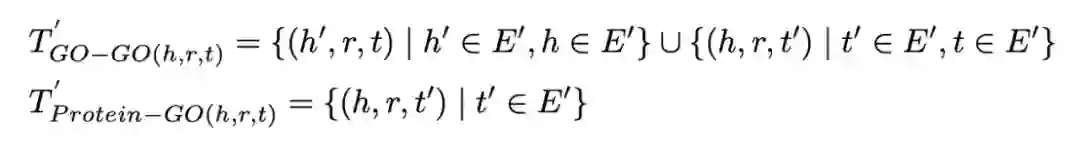

注意到这里的事实知识分为两类不同的三元组,分别是 Go-Go 和蛋白质-Go,因此我们提出一种知识增强的负采样方法,以获得更有代表性的负样本提升预训练效果,采样方式如下 :

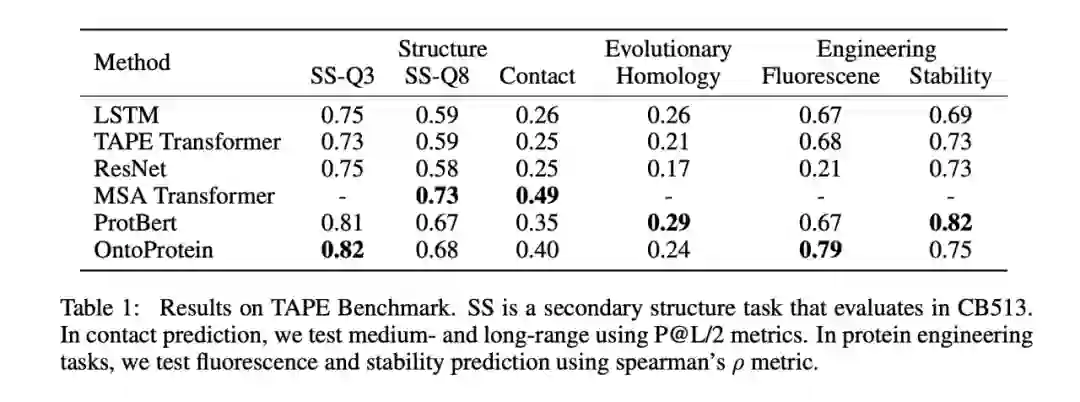

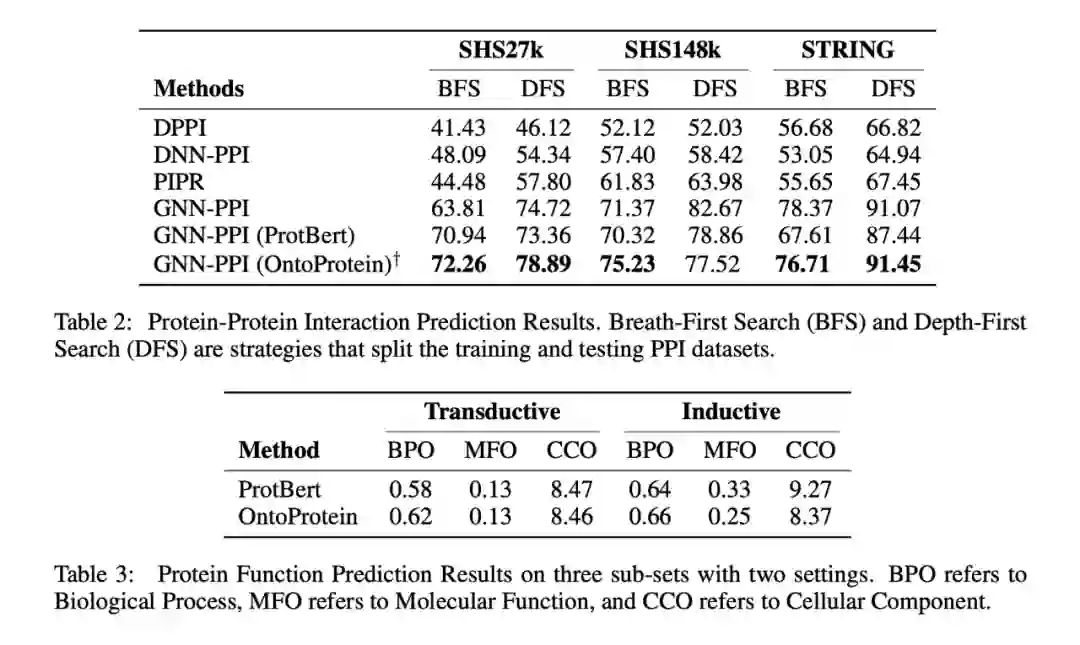

我们在蛋白质测试基准 TAPE,以及蛋白质蛋白质交互、蛋白质功能预测(我们参考 CAFA 竞赛构建了一个新的蛋白质功能预测数据集)上进行了实验。如下表所示,可以发现融合知识图谱的蛋白质预训练方法在一定程度上取得了较好或可比的性能。特别地,我们的方法没有使用同源序列比对(MSA),因此较难超越基于 MSA Transformer 的方法。详细的实验结果请参见论文,我们会在近期将预训练模型整理并发布到 Huggingface 上供社区使用。

6.6 小结与展望

当下蓬勃兴起的 AI for Science 正在促使以数据驱动的开普勒范式和以第一性原理驱动的牛顿范式的深度融合。基于“数据与知识双轮驱动”的学术思想,我们在本文中首次提出了融合知识图谱的蛋白质预训练方法 OntoProtein,并在多个下游任务中验证了模型的效果。在未来,我们将维护好 OntoProtein 以供更多学者使用,并计划探索融合同源序列比对的知识图谱增强预训练方法以实现更优性能。

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读 ,也可以是学术热点剖析 、科研心得 或竞赛经验讲解 等。我们的目的只有一个,让知识真正流动起来。

📝 稿件基本要求:

• 文章确系个人原创作品 ,未曾在公开渠道发表,如为其他平台已发表或待发表的文章,请明确标注

• 稿件建议以 markdown 格式撰写,文中配图以附件形式发送,要求图片清晰,无版权问题

• PaperWeekly 尊重原作者署名权,并将为每篇被采纳的原创首发稿件,提供业内具有竞争力稿酬 ,具体依据文章阅读量和文章质量阶梯制结算

📬 投稿通道:

• 投稿邮箱: hr@paperweekly.site

• 来稿请备注即时联系方式(微信),以便我们在稿件选用的第一时间联系作者

• 您也可以直接添加小编微信(pwbot02 )快速投稿,备注:姓名-投稿

△长按添加PaperWeekly小编

🔍

现在,在「知乎」 也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」 订阅我们的专栏吧